style: html to md syntax

This commit is contained in:

@@ -14,7 +14,7 @@

|

||||

|

||||

<font color=green>大白话 -> 提取后的逻辑链条</font> -> <font color=red>科研写作 -> 英文翻译</font>

|

||||

|

||||

<strong>干了什么:</strong>

|

||||

**干了什么:**

|

||||

|

||||

1. 如果没有想清楚要做的是什么,要写什么,可以先用大白话,在草稿上写,有利于理清思路,抽丝剥茧

|

||||

|

||||

@@ -45,7 +45,7 @@

|

||||

|

||||

之所以要用大白话是因为基础的不足,如果有一定功底的人,可能先天写出来文字自带规范性,所以仅供大家参考)

|

||||

|

||||

<strong>表达规范性:</strong>

|

||||

**表达规范性:**

|

||||

|

||||

此处的方法论为一句话,则是从模仿到超越的浑然天成。

|

||||

|

||||

|

||||

@@ -2,11 +2,11 @@

|

||||

|

||||

author:廖总

|

||||

|

||||

<em>Last revised 2023/04/18</em>

|

||||

*Last revised 2023/04/18*

|

||||

|

||||

先声夺人:AI 时代最大的陷阱,就是盲目考察 AI 能为我们做什么,而不去考虑我们能为 AI 提供什么

|

||||

|

||||

## <em>免责声明</em>

|

||||

## *免责声明*

|

||||

|

||||

本文纯文本量达 16k(我也不知道字数统计的 28k 是怎么来的),在这 游离散乱的主线 和 支离破碎的文字 中挣扎,可能浪费您生命中宝贵的十数分钟。

|

||||

|

||||

@@ -616,7 +616,7 @@ AutoGPT 主要特性如下:

|

||||

|

||||

作为正题的回归,我们需要重新考虑什么是一个 AI,一个能帮助我们的 AI 应当处于什么样的现实形态?

|

||||

|

||||

<em>我们需要的 </em><em>AI</em><em> 仅仅是大语言模型吗?如果是,它能帮我们做什么呢?如果不是,那 AI 的实质是什么呢?</em>

|

||||

*我们需要的 **AI** 仅仅是大语言模型吗?如果是,它能帮我们做什么呢?如果不是,那 AI 的实质是什么呢?*

|

||||

|

||||

我首先武断地认为,我们需要的 AI,并不是一个语言模型实体,而是一个复杂智能系统

|

||||

|

||||

@@ -803,7 +803,7 @@ Generative Agents 的知觉设计:关联性难题

|

||||

|

||||

仅就这方面而言,作为一个方向性的倡议,对知觉系统的开发可能分为以下步骤

|

||||

|

||||

#### <em>数据处理/管理</em>

|

||||

#### *数据处理/管理*

|

||||

|

||||

- 对 办公文件/数据 构建通用读取接口

|

||||

- 以同类信息为单位,设计通用的字段(由人设计和管理,AI 能力尚不至此)

|

||||

@@ -827,7 +827,7 @@ Generative Agents 的知觉设计:关联性难题

|

||||

- 如储存进 mongoDB

|

||||

- (设计孪生数据的自动更新机制)

|

||||

|

||||

#### <em>知觉系统驱动</em>

|

||||

#### *知觉系统驱动*

|

||||

|

||||

- 基于上述索引数据库,以视图为单位进行访问,并设计 视图 2 Prompt 的转化格式

|

||||

|

||||

|

||||

@@ -2,7 +2,7 @@

|

||||

|

||||

author:Marlene

|

||||

|

||||

<em>Last revised 2023/07/26</em>

|

||||

*Last revised 2023/07/26*

|

||||

|

||||

## 引言

|

||||

|

||||

|

||||

@@ -10,7 +10,7 @@

|

||||

|

||||

### CV(计算机视觉)

|

||||

|

||||

计算机视觉旨在<strong>用计算机模拟人类处理图片信息的能力</strong>,就比如这里有一张图片——手写数字 9

|

||||

计算机视觉旨在**用计算机模拟人类处理图片信息的能力**,就比如这里有一张图片——手写数字 9

|

||||

|

||||

|

||||

|

||||

@@ -18,7 +18,7 @@

|

||||

|

||||

相信你通过上面简单的介绍应该能够了解到计算机视觉是在干嘛了,接下来我会举几个相对复杂的例子来让大家了解一下目前的 cv 是在做怎样的研究:

|

||||

|

||||

::: warning 🐱 <strong>图像分割</strong>是在图片中对物体分类,并且把它们所对应的位置标示出来。下图就是把人的五官,面部皮肤和头发分割出来,效 (小) 果 (丑) 图如下:

|

||||

::: warning 🐱 **图像分割**是在图片中对物体分类,并且把它们所对应的位置标示出来。下图就是把人的五官,面部皮肤和头发分割出来,效 (小) 果 (丑) 图如下:

|

||||

:::

|

||||

|

||||

<table>

|

||||

@@ -29,15 +29,15 @@

|

||||

</tr>

|

||||

</table>

|

||||

|

||||

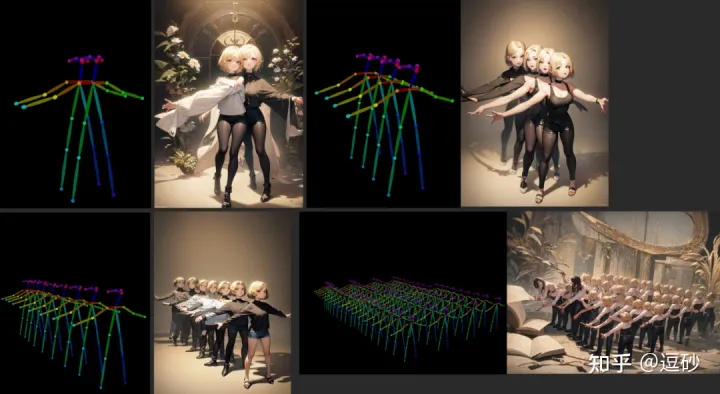

::: warning 🐱 <strong>图像生成</strong>相信大家一定不陌生,NovalAI 在 2022 年火的一塌糊涂,我觉得不需要我过多赘述,对它 (Diffusion model) 的改进工作也是层出不穷,这里就放一张由可控姿势网络 (ControlNet) 生成的图片吧:

|

||||

::: warning 🐱 **图像生成**相信大家一定不陌生,NovalAI 在 2022 年火的一塌糊涂,我觉得不需要我过多赘述,对它 (Diffusion model) 的改进工作也是层出不穷,这里就放一张由可控姿势网络 (ControlNet) 生成的图片吧:

|

||||

:::

|

||||

|

||||

|

||||

|

||||

::: warning 🐱 <strong>三维重建</strong>也是很多研究者关注的方向,指的是传入对同一物体不同视角的照片,来生成 3D 建模的任务。这方面比图像处理更加前沿并且难度更大。具体见[4.6.5.4 神经辐射场 (NeRF)](4.6.5.4%E7%A5%9E%E7%BB%8F%E8%BE%90%E5%B0%84%E5%9C%BA(NeRF).md) 章节。

|

||||

::: warning 🐱 **三维重建**也是很多研究者关注的方向,指的是传入对同一物体不同视角的照片,来生成 3D 建模的任务。这方面比图像处理更加前沿并且难度更大。具体见[4.6.5.4 神经辐射场 (NeRF)](4.6.5.4%E7%A5%9E%E7%BB%8F%E8%BE%90%E5%B0%84%E5%9C%BA(NeRF).md) 章节。

|

||||

:::

|

||||

|

||||

如果对计算机视觉有兴趣,可以通过以下路线进行学习:深度学习快速入门—> 经典网络。本块内容的主要撰写者之一<strong>SRT 社团</strong>多数成员主要从事 CV 方向研究,欢迎与我们交流。

|

||||

如果对计算机视觉有兴趣,可以通过以下路线进行学习:深度学习快速入门—> 经典网络。本块内容的主要撰写者之一**SRT 社团**多数成员主要从事 CV 方向研究,欢迎与我们交流。

|

||||

|

||||

### NLP(自然语言处理)

|

||||

|

||||

@@ -56,9 +56,9 @@

|

||||

|

||||

而多模态就是让计算机能够将不同模态的信息相对应,一种常用的方法就是让计算机把图片的内容和文本的内容理解为相同的语义(在这个领域一般用一个较长的向量来表示语义)。

|

||||

|

||||

也就是说我<strong>传入一张狗子的照片经过模型得到的向量</strong>与<strong>DOG 这个单词经过模型得到的向量</strong>相近。

|

||||

也就是说我**传入一张狗子的照片经过模型得到的向量**与**DOG 这个单词经过模型得到的向量**相近。

|

||||

|

||||

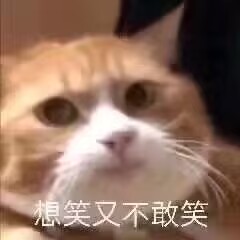

具体的任务比如说<strong>图片问答</strong>,传入一张图片,问 AI 这张图片里面有几只猫猫,它们是什么颜色,它告诉我有一只猫猫,是橙色的:

|

||||

具体的任务比如说**图片问答**,传入一张图片,问 AI 这张图片里面有几只猫猫,它们是什么颜色,它告诉我有一只猫猫,是橙色的:

|

||||

|

||||

|

||||

|

||||

|

||||

@@ -175,7 +175,7 @@ def estimate_house_sales_price(num_of_bedrooms, sqft, neighborhood):

|

||||

|

||||

|

||||

|

||||

<em>θ 表示当前的权重值。J(θ) 表示「当前权重的代价」。</em>

|

||||

*θ 表示当前的权重值。J(θ) 表示「当前权重的代价」。*

|

||||

|

||||

这个等式表示,在当前权重值下,我们估价程序的偏离程度。

|

||||

|

||||

@@ -203,7 +203,7 @@ def estimate_house_sales_price(num_of_bedrooms, sqft, neighborhood):

|

||||

|

||||

不过幸运的是,有很多办法来处理这种情况。有许多机器学习算法可以处理非线性数据。除此之外,灵活使用线性回归也能拟合更复杂的线条。在所有的情况下,寻找最优权重这一基本思路依然适用。

|

||||

|

||||

<strong>如果你还是无法理解,你可以将 cost 类比为你出错误的程度,而数学科学家找到各种方法来降低这种程度,当程度降到最低时,我们就可以知道我们要求的数值了</strong>

|

||||

**如果你还是无法理解,你可以将 cost 类比为你出错误的程度,而数学科学家找到各种方法来降低这种程度,当程度降到最低时,我们就可以知道我们要求的数值了**

|

||||

|

||||

另外,我忽略了过拟合(overfitting)的概念。得到一组能完美预测原始数据集中房价的权重组很简单,但用这组权重组来预测原始数据集之外的任何新房屋其实都不怎么准确。这也是有许多解决办法的(如[正则化](https://link.zhihu.com/?target=http%3A//en.wikipedia.org/wiki/Regularization_%2528mathematics%2529%23Regularization_in_statistics_and_machine_learning)以及使用[交叉验证](https://link.zhihu.com/?target=http%3A//en.wikipedia.org/wiki/Cross-validation_%2528statistics%2529)的数据集)。学习如何应对这一问题,是学习如何成功应用机器学习技术的重点之一。

|

||||

|

||||

@@ -226,7 +226,7 @@ def estimate_house_sales_price(num_of_bedrooms, sqft, neighborhood):

|

||||

|

||||

|

||||

|

||||

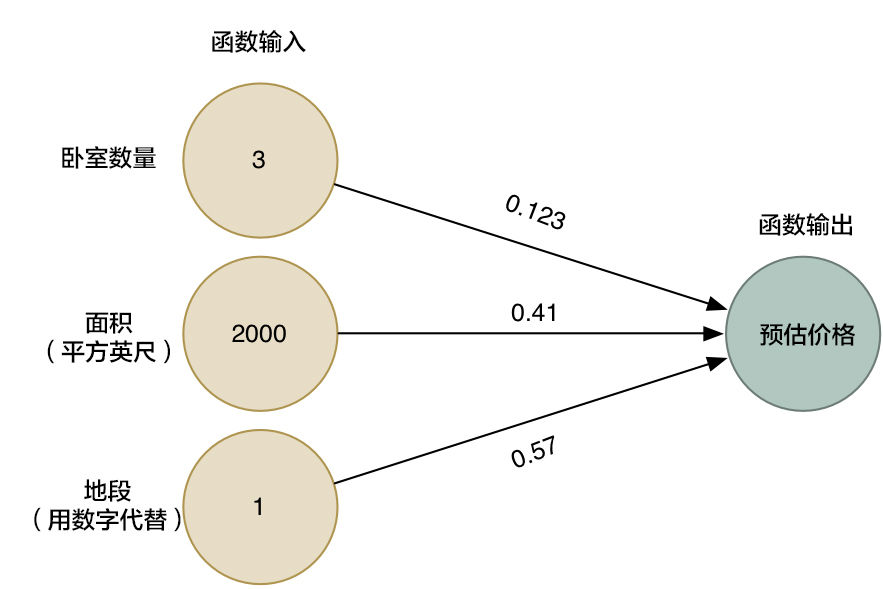

<em>箭头头表示了函数中的权重。</em>

|

||||

*箭头头表示了函数中的权重。*

|

||||

|

||||

然而,这个算法仅仅能用于处理一些简单的问题,就是那些输入和输出有着线性关系的问题。但如果真实价格和决定因素的关系并不是如此简单,那我们该怎么办?比如说,地段对于大户型和小户型的房屋有很大影响,然而对中等户型的房屋并没有太大影响。那我们该怎么在我们的模型中收集这种复杂的信息呢?

|

||||

|

||||

@@ -392,13 +392,13 @@ model.add(Activation('relu'))# 激活函数,你可以理解为加上这个东

|

||||

|

||||

### 卷积是如何工作的

|

||||

|

||||

之前我们提到过,我们可以把一整张图片当做一串数字输入到神经网络里面。不同的是,这次我们会利用<strong>平移不变性</strong>的概念来把这件事做得更智能。

|

||||

之前我们提到过,我们可以把一整张图片当做一串数字输入到神经网络里面。不同的是,这次我们会利用**平移不变性**的概念来把这件事做得更智能。

|

||||

|

||||

当然也有最新研究说卷积不具备平移不变性,但是我这里使用这个概念是为了大伙更好的理解,举个例子:你将 8 无论放在左上角还是左下角都改变不了他是 8 的事实

|

||||

|

||||

|

||||

|

||||

我们将一张图像分成这么多个小块,然后输入神经网络中的是一个小块。<em>每次判断一张小图块。</em>

|

||||

我们将一张图像分成这么多个小块,然后输入神经网络中的是一个小块。*每次判断一张小图块。*

|

||||

|

||||

然而,有一个非常重要的不同:对于每个小图块,我们会使用同样的神经网络权重。换一句话来说,我们平等对待每一个小图块。如果哪个小图块有任何异常出现,我们就认为这个图块是「异常」

|

||||

|

||||

|

||||

@@ -84,7 +84,7 @@

|

||||

- 最优解 (Optimal Solution)

|

||||

|

||||

- 在所有解决方案中路径成本最低的解决方案。

|

||||

- 在搜索过程中,数据通常存储在<strong>节点 (Node)</strong> 中,节点是一种包含以下数据的数据结构:

|

||||

- 在搜索过程中,数据通常存储在**节点 (Node)** 中,节点是一种包含以下数据的数据结构:

|

||||

|

||||

- 状态——state

|

||||

- 其父节点,通过该父节点生成当前节点——parent node

|

||||

@@ -312,6 +312,6 @@ def remove(self):

|

||||

|

||||

- 深度限制的极大极小算法 (Depth-Limited Minimax)

|

||||

|

||||

- 总共有$255168$个可能的井字棋游戏,以及有$10^{29000}$个可能的国际象棋中游戏。到目前为止,最小最大算法需要生成从某个点到<strong>终端条件</strong>的所有假设游戏状态。虽然计算所有的井字棋游戏状态对现代计算机来说并不是一个挑战,但目前用来计算国际象棋是不可能的。

|

||||

- 总共有$255168$个可能的井字棋游戏,以及有$10^{29000}$个可能的国际象棋中游戏。到目前为止,最小最大算法需要生成从某个点到**终端条件**的所有假设游戏状态。虽然计算所有的井字棋游戏状态对现代计算机来说并不是一个挑战,但目前用来计算国际象棋是不可能的。

|

||||

|

||||

- 深度限制的 Minimax 算法在停止之前只考虑预先定义的移动次数,而从未达到终端状态。然而,这不允许获得每个动作的精确值,因为假设的游戏还没有结束。为了解决这个问题,深度限制 Minimax 依赖于一个评估函数,该函数从给定状态估计游戏的预期效用,或者换句话说,为状态赋值。例如,在国际象棋游戏中,效用函数会将棋盘的当前配置作为输入,尝试评估其预期效用(基于每个玩家拥有的棋子及其在棋盘上的位置),然后返回一个正值或负值,表示棋盘对一个玩家对另一个玩家的有利程度。这些值可以用来决定正确的操作,并且评估函数越好,依赖它的 Minimax 算法就越好。

|

||||

|

||||

@@ -2,7 +2,7 @@

|

||||

|

||||

人类根据现有的知识进行推理并得出结论。表示知识并从中得出结论的概念也被用于人工智能中,在本章中我们将探讨如何实现这种行为。

|

||||

|

||||

::: warning <font size=5><strong>说好的 AI 呢?怎么感觉越来越偏了?</strong></font>

|

||||

::: warning <font size=5>**说好的 AI 呢?怎么感觉越来越偏了?**</font>

|

||||

|

||||

如果有这样的疑问的同学,可能存在一定的误区,认为人工智能就是局限在深度学习的算法或者说机器学习的部分算法上,其实这是对这个领域一个巨大的误解。

|

||||

|

||||

@@ -42,7 +42,7 @@

|

||||

- 命题符号通常是用于表示命题的字母$P、Q、R$

|

||||

- 逻辑连接词 (Logical Connectives)

|

||||

- 逻辑连接词是连接命题符号的逻辑符号,以便以更复杂的方式对世界进行推理。

|

||||

- <strong>Not</strong><strong> </strong><strong>(</strong>$\lnot$<strong>)</strong> 逻辑非:命题真值的反转。例如,如果 $P$:“正在下雨”,那么 $¬P$:“没有下雨”。

|

||||

- **Not**** ****(**$\lnot$**)** 逻辑非:命题真值的反转。例如,如果 $P$:“正在下雨”,那么 $¬P$:“没有下雨”。

|

||||

- 真值表用于将所有可能的真值赋值与命题进行比较。该工具将帮助我们更好地理解与不同逻辑连接词相关联的命题的真值。例如,下面是我们的第一个真值表:

|

||||

|

||||

| $P$ | $\lnot P$ |

|

||||

@@ -50,7 +50,7 @@

|

||||

| false(0) | true(1) |

|

||||

| true(1) | false(0) |

|

||||

|

||||

- <strong>And(</strong>$\land$<strong>)</strong> 逻辑乘 (合取): 连接两个不同的命题。当这两个命题$P$和$Q$用$∧$连接时,得到的命题$P∧Q$只有在$P$和$Q$都为真的情况下才为真。

|

||||

- **And(**$\land$**)** 逻辑乘 (合取): 连接两个不同的命题。当这两个命题$P$和$Q$用$∧$连接时,得到的命题$P∧Q$只有在$P$和$Q$都为真的情况下才为真。

|

||||

|

||||

| $P$ | $Q$ | $P\land Q$ |

|

||||

| --- | --- | ---------- |

|

||||

@@ -59,7 +59,7 @@

|

||||

| 1 | 0 | 0 |

|

||||

| 1 | 1 | 1 |

|

||||

|

||||

- <strong>Or(</strong>$\lor$<strong>)</strong> 逻辑和 (析取): 只要它的任何一个参数为真,它就为真。这意味着要使 $P ∨ Q$为真,$P$ 或 $Q$ 中至少有一个必须为真。

|

||||

- **Or(**$\lor$**)** 逻辑和 (析取): 只要它的任何一个参数为真,它就为真。这意味着要使 $P ∨ Q$为真,$P$ 或 $Q$ 中至少有一个必须为真。

|

||||

|

||||

| $P$ | $Q$ | $P\lor Q$ |

|

||||

| --- | --- | --------- |

|

||||

@@ -70,7 +70,7 @@

|

||||

|

||||

- 值得一提的是,Or 有两种类型:同或 Or 和异或 Or。在异或中,如果$P\lor Q$为真,则$P∧Q$为假。也就是说,一个异或要求它只有一个论点为真,而不要求两者都为真。如果$P、Q$或$P∧Q$中的任何一个为真,则包含或为真。在 Or($\lor$) 的情况下,意图是一个包含的 Or。

|

||||

|

||||

- <strong>Implication (→)</strong> 逻辑蕴含:表示“如果$P$,则$Q$的结构。例如,如果$P$:“正在下雨”,$Q$:“我在室内”,则$P→ Q$的意思是“如果下雨,那么我在室内。”在$P$的情况下,意味着$Q$,$P$被称为前件,$Q$ 被称为后件。

|

||||

- **Implication (→)** 逻辑蕴含:表示“如果$P$,则$Q$的结构。例如,如果$P$:“正在下雨”,$Q$:“我在室内”,则$P→ Q$的意思是“如果下雨,那么我在室内。”在$P$的情况下,意味着$Q$,$P$被称为前件,$Q$ 被称为后件。

|

||||

|

||||

- 当前件为真时,在后件为真的情况下,整个蕴含逻辑为真(这是有道理的:如果下雨,我在室内,那么“如果下雨,那么我在室内”这句话是真的)。当前件为真时,如果后件为假,则蕴含逻辑为假(如果下雨时我在外面,那么“如果下雨,那么我在室内”这句话是假的)。然而,当前件为假时,无论后件如何,蕴含逻辑总是真的。这有时可能是一个令人困惑的概念。从逻辑上讲,我们不能从蕴含中学到任何东西$(P→ Q)$如果前件 ($P$) 为假。看一下我们的例子,如果没有下雨,这个蕴含逻辑并没有说我是否在室内的问题。我可能是一个室内型的人,即使不下雨也不在外面走,或者我可能是一个室外型的人,不下雨的时候一直在外面。当前件是假的,我们说蕴含逻辑是真的。

|

||||

|

||||

@@ -81,7 +81,7 @@

|

||||

| 1 | 0 | 0 |

|

||||

| 1 | 1 | 1 |

|

||||

|

||||

- <strong>Biconditional (</strong>$\leftrightarrow$<strong>)</strong> :是一个双向的蕴含。你可以把它读成“如果且仅当”$P↔ Q$等同$P→ Q$和$Q→ P$合在一起。例如,如果$P$:“正在下雨”,$Q$:“我在室内”,那么$P↔ Q$的意思是“如果下雨,那么我在室内”,“如果我在室内,那么就在下雨。”这意味着我们可以推断出比简单蕴含更多的东西。如果$P$为假,那么$Q$ 也为假;如果不下雨,我们知道我也不在室内。

|

||||

- **Biconditional (**$\leftrightarrow$**)** :是一个双向的蕴含。你可以把它读成“如果且仅当”$P↔ Q$等同$P→ Q$和$Q→ P$合在一起。例如,如果$P$:“正在下雨”,$Q$:“我在室内”,那么$P↔ Q$的意思是“如果下雨,那么我在室内”,“如果我在室内,那么就在下雨。”这意味着我们可以推断出比简单蕴含更多的东西。如果$P$为假,那么$Q$ 也为假;如果不下雨,我们知道我也不在室内。

|

||||

|

||||

| $P$ | $Q$ | $P\leftrightarrow Q$ |

|

||||

| --- | --- | -------------------- |

|

||||

|

||||

@@ -342,11 +342,11 @@ print(Counter(data))

|

||||

|

||||

- 到目前为止,我们已经研究了概率问题,给出了我们观察到的一些信息。在这种范式中,时间的维度没有以任何方式表示。然而,许多任务确实依赖于时间维度,例如预测。为了表示时间变量,我们将创建一个新的变量$X$,并根据感兴趣的事件对其进行更改,使$X_t$ 是当前事件,$X_{t+1}$ 是下一个事件,依此类推。为了能够预测未来的事件,我们将使用马尔可夫模型。

|

||||

|

||||

### 马尔科夫假设 (<strong>The Markov Assumption</strong>)

|

||||

### 马尔科夫假设 (**The Markov Assumption**)

|

||||

|

||||

- 马尔科夫假设是一个假设,即当前状态只取决于有限的固定数量的先前状态。想想预测天气的任务。在理论上,我们可以使用过去一年的所有数据来预测明天的天气。然而,这是不可行的,一方面是因为这需要计算能力,另一方面是因为可能没有关于基于 365 天前天气的明天天气的条件概率的信息。使用马尔科夫假设,我们限制了我们以前的状态(例如,在预测明天的天气时,我们要考虑多少个以前的日子),从而使这个任务变得可控。这意味着我们可能会得到感兴趣的概率的一个更粗略的近似值,但这往往足以满足我们的需要。此外,我们可以根据最后一个事件的信息来使用马尔可夫模型(例如,根据今天的天气来预测明天的天气)。

|

||||

|

||||

### 马尔科夫链 (<strong>Markov Chain</strong>)

|

||||

### 马尔科夫链 (**Markov Chain**)

|

||||

|

||||

- 马尔科夫链是一个随机变量的序列,每个变量的分布都遵循马尔科夫假设。也就是说,链中的每个事件的发生都是基于之前事件的概率。

|

||||

- 为了构建马尔可夫链,我们需要一个过渡模型,该模型将根据当前事件的可能值来指定下一个事件的概率分布。

|

||||

@@ -401,9 +401,9 @@ print(model.sample(50))

|

||||

|

||||

- 基于隐马尔科夫模型,可以实现多种任务:

|

||||

|

||||

- 筛选 Filtering: 给定从开始到现在的观察结果,计算出<strong>当前</strong>状态的概率分布。例如,给从从特定时间开始到今天人们带伞的信息,我们产生一个今天是否下雨的概率分布。

|

||||

- 预测 Prediction: 给定从开始到现在的观察,计算<strong>未来</strong>状态的概率分布。

|

||||

- 平滑化 Smoothing: 给定从开始到现在的观察,计算<strong>过去</strong>状态的概率分布。例如,鉴于今天人们带了雨伞,计算昨天下雨的概率。

|

||||

- 筛选 Filtering: 给定从开始到现在的观察结果,计算出**当前**状态的概率分布。例如,给从从特定时间开始到今天人们带伞的信息,我们产生一个今天是否下雨的概率分布。

|

||||

- 预测 Prediction: 给定从开始到现在的观察,计算**未来**状态的概率分布。

|

||||

- 平滑化 Smoothing: 给定从开始到现在的观察,计算**过去**状态的概率分布。例如,鉴于今天人们带了雨伞,计算昨天下雨的概率。

|

||||

- 最可能的解释 Most likely explanation: 鉴于从开始到现在的观察,计算最可能的事件顺序。

|

||||

- 最可能的解释任务可用于语音识别等过程,根据多个波形,人工智能推断出给这些波形带来的最有可能的单词或音节的序列。接下来是一个隐马尔科夫模型的 Python 实现,我们将用于最可能的解释任务:

|

||||

|

||||

|

||||

@@ -1,6 +1,6 @@

|

||||

# 你可能会需要的术语介绍

|

||||

|

||||

众所周知,一个领域的黑话对新人来说是比较不友好的,为此我从知乎上找了一篇黑话大赏(bushi)做了点改良放在这里。如果遇到看不懂的词了可以来这找找。<strong>在系统学习之前可以先无视这篇文章,遇到问题再来找找</strong><u>。</u>

|

||||

众所周知,一个领域的黑话对新人来说是比较不友好的,为此我从知乎上找了一篇黑话大赏(bushi)做了点改良放在这里。如果遇到看不懂的词了可以来这找找。**在系统学习之前可以先无视这篇文章,遇到问题再来找找**<u>。</u>

|

||||

|

||||

> 作者:Young<br/>链接:[https://www.zhihu.com/question/469612040/answer/2008770105](https://www.zhihu.com/question/469612040/answer/2008770105)<br/>来源:知乎

|

||||

|

||||

@@ -38,7 +38,7 @@

|

||||

- 体素:我把世界变成 MC 了,世界是一堆方块,他们在不同视角下有各自的颜色和透明度

|

||||

- 点云:我每采样一次得到一个点,由这些点去表示我要的物体,不太直观,来张图

|

||||

|

||||

这是我用照片重建的独角兽<strong>稀疏</strong>点云,红色的不用管,是照相机视角(图不够多,巨糊)

|

||||

这是我用照片重建的独角兽**稀疏**点云,红色的不用管,是照相机视角(图不够多,巨糊)

|

||||

|

||||

|

||||

|

||||

|

||||

@@ -1,6 +1,6 @@

|

||||

# 深度学习快速入门

|

||||

|

||||

## <strong>刘二大人(Pytorch)</strong>

|

||||

## **刘二大人(Pytorch)**

|

||||

|

||||

## 速成课:人工智能

|

||||

[【速成课:人工智能】Ai - [21 集全/中英双语] - Artificial Intelligence_哔哩哔哩_bilibili](https://www.bilibili.com/video/BV1P7411r7Dw)

|

||||

@@ -62,7 +62,7 @@ Crash course 的课程,可以基本了解pytorch的内容,但是当然有很

|

||||

|

||||

## torch 我还不会呢!

|

||||

|

||||

学会一个<strong>庞大并且高度封装</strong>的包并不是一蹴而就的,我们建议从实践开始,比如说自己搭建一个神经网络来实现 MNIST 的分类。在使用这些函数和类的过程中你能更快地掌握它们的方法。

|

||||

学会一个**庞大并且高度封装**的包并不是一蹴而就的,我们建议从实践开始,比如说自己搭建一个神经网络来实现 MNIST 的分类。在使用这些函数和类的过程中你能更快地掌握它们的方法。

|

||||

|

||||

# 关于梯度下降算法:

|

||||

|

||||

@@ -103,12 +103,12 @@ Crash course 的课程,可以基本了解pytorch的内容,但是当然有很

|

||||

|

||||

# 接下来干什么?

|

||||

|

||||

- <strong>我想学 CV !!!!!!</strong>

|

||||

- **我想学 CV !!!!!!**

|

||||

|

||||

你可以在 CV 模块中找到[4.6.5.3CV中的经典网络](4.6.5.3CV%E4%B8%AD%E7%9A%84%E7%BB%8F%E5%85%B8%E7%BD%91%E7%BB%9C.md) ,这里是一些最最经典的论文,我们推荐你阅读它们的原文并且复现它们的代码,这可以同时锻炼你的<strong>coding 能力和论文阅读能力</strong>,在阅读前,请参见[如何读论文](../1.%E6%9D%AD%E7%94%B5%E7%94%9F%E5%AD%98%E6%8C%87%E5%8D%97/1.10%E5%A6%82%E4%BD%95%E8%AF%BB%E8%AE%BA%E6%96%87.md) 。本模块的撰写者<strong>SRT 社团</strong>主要从事 CV 方向的研究,遇到问题欢迎与我们交流。(你都完成这些了不至于找不到我们的联系方式吧~)<strong>如果你读完了经典网络模块,你可以在它的最后找到接下来的学习路线~</strong>

|

||||

你可以在 CV 模块中找到[4.6.5.3CV中的经典网络](4.6.5.3CV%E4%B8%AD%E7%9A%84%E7%BB%8F%E5%85%B8%E7%BD%91%E7%BB%9C.md) ,这里是一些最最经典的论文,我们推荐你阅读它们的原文并且复现它们的代码,这可以同时锻炼你的**coding 能力和论文阅读能力**,在阅读前,请参见[如何读论文](../1.%E6%9D%AD%E7%94%B5%E7%94%9F%E5%AD%98%E6%8C%87%E5%8D%97/1.10%E5%A6%82%E4%BD%95%E8%AF%BB%E8%AE%BA%E6%96%87.md) 。本模块的撰写者**SRT 社团**主要从事 CV 方向的研究,遇到问题欢迎与我们交流。(你都完成这些了不至于找不到我们的联系方式吧~)**如果你读完了经典网络模块,你可以在它的最后找到接下来的学习路线~**

|

||||

|

||||

- <strong>我想做</strong><strong>NLP</strong><strong> !!!!!!</strong>

|

||||

- **我想做****NLP**** !!!!!!**

|

||||

|

||||

NLP 研究方向庞大且复杂,若直接从 GPT 系列开始不免有些过于困难。我们建议你从了解 NLP 的任务开始,在有足够的基础后开始学习 RNN,LSTM 基准方法后向 [4.6.7Transformer](4.6.7Transformer.md) 进发 ,这个方法广泛运用在几乎所有深度学习领域,尤其是 NLP 的前沿研究已经无法离开 Transformer 了 hhhh。这个模块中我们也加入了一些 Transformer 的改进工作,包括 NLP,CV,和多模态

|

||||

|

||||

- <strong>如果你想做多模态,对比学习等</strong>,请同时了解 CV 和 NLP 模块。这将是你后续知识的基础。多模态我们没有完善的讲义推出,对比学习可以参见[4.6.8对比学习](4.6.8%E5%AF%B9%E6%AF%94%E5%AD%A6%E4%B9%A0.md) 。这是撰写者之一的论文阅读笔记,不保证准确性与理解是否准确,可以作为论文阅读路线图来参考~

|

||||

- **如果你想做多模态,对比学习等**,请同时了解 CV 和 NLP 模块。这将是你后续知识的基础。多模态我们没有完善的讲义推出,对比学习可以参见[4.6.8对比学习](4.6.8%E5%AF%B9%E6%AF%94%E5%AD%A6%E4%B9%A0.md) 。这是撰写者之一的论文阅读笔记,不保证准确性与理解是否准确,可以作为论文阅读路线图来参考~

|

||||

|

||||

@@ -4,11 +4,11 @@

|

||||

|

||||

|

||||

|

||||

#### (a)Image classification <strong>图像分类</strong>

|

||||

#### (a)Image classification **图像分类**

|

||||

|

||||

- 识别这个图片整体所属的类别,解决的是"what"问题,给这个图片打上相应的标签,在 a 图内标签是 `bottle,cup,cube`,其他类型的图片也都有它们自己的标签,然后把这些打上标签的图片带进网络结构里作为训练集训练。

|

||||

|

||||

#### (b)Object localization <strong>目标检测</strong>(对象定位)

|

||||

#### (b)Object localization **目标检测**(对象定位)

|

||||

|

||||

- 识别图片中各个物体所在的位置,解决的是"where"问题,此处还细分两个问题:

|

||||

|

||||

@@ -20,12 +20,12 @@

|

||||

|

||||

|

||||

|

||||

#### (c)Semantic segmentation <strong>语义分割</strong>

|

||||

#### (c)Semantic segmentation **语义分割**

|

||||

|

||||

- 语义分割需要进一步判断图像中哪些像素属于哪个目标(进阶目标检测)。

|

||||

- 看图右下角两个 `cube` 是连在一块的 并没有分出哪一部分是哪一个的 `cube`

|

||||

|

||||

#### (d)Instance segmentation <strong>实例分割</strong>

|

||||

#### (d)Instance segmentation **实例分割**

|

||||

|

||||

- 实例分割需要区分出哪些像素属于第一个物体、哪些像素属于第二个物体,即目标检测 + 语义分割。

|

||||

- 看图右下角两个 `cube` 是分开的

|

||||

|

||||

@@ -107,7 +107,7 @@ One batch tensor data: [tensor([[ 0.9451, -0.4923, -1.8178],

|

||||

- shuffle:bool 类型,在每个 epoch 开始的时候,是否对数据进行重新打乱;

|

||||

- num_workers:int 类型,加载数据的进程数,0 意味着所有的数据都会被加载进主进程,默认为 0。

|

||||

|

||||

<strong>思考题</strong>

|

||||

**思考题**

|

||||

|

||||

按照上述代码,One batch tensor data 的输出是否正确,若不正确,为什么?

|

||||

|

||||

|

||||

@@ -58,7 +58,7 @@ print(type(img2))

|

||||

'''

|

||||

```

|

||||

|

||||

首先用读取图片,查看一下图片的类型为 PIL.JpegImagePlugin.JpegImageFile,这里需要注意,<strong>PIL.JpegImagePlugin.JpegImageFile 类是 PIL.Image.Image 类的子类</strong>。然后,用 transforms.ToTensor() 将 PIL.Image 转换为 Tensor。最后,再将 Tensor 转换回 PIL.Image。

|

||||

首先用读取图片,查看一下图片的类型为 PIL.JpegImagePlugin.JpegImageFile,这里需要注意,**PIL.JpegImagePlugin.JpegImageFile 类是 PIL.Image.Image 类的子类**。然后,用 transforms.ToTensor() 将 PIL.Image 转换为 Tensor。最后,再将 Tensor 转换回 PIL.Image。

|

||||

|

||||

## 对 PIL.Image 和 Tensor 进行变换

|

||||

|

||||

@@ -202,7 +202,7 @@ display(img2)

|

||||

|

||||

标准化是指每一个数据点减去所在通道的平均值,再除以所在通道的标准差,数学的计算公式:output=(input−mean)/std

|

||||

|

||||

而对图像进行标准化,就是对图像的每个通道利用均值和标准差进行正则化。这样做的目的,是<strong>为了保证数据集中所有的图像分布都相似,这样在训练的时候更容易收敛,既加快了训练速度,也提高了训练效果</strong>。

|

||||

而对图像进行标准化,就是对图像的每个通道利用均值和标准差进行正则化。这样做的目的,是**为了保证数据集中所有的图像分布都相似,这样在训练的时候更容易收敛,既加快了训练速度,也提高了训练效果**。

|

||||

|

||||

让我来解释一下:首先,标准化是一个常规做法,可以理解为无脑进行标准化后再训练的效果,大概率要好于不进行标准化。

|

||||

|

||||

|

||||

@@ -10,17 +10,17 @@ AlexNet 有 6 千万个参数和 650,000 个神经元。

|

||||

|

||||

[论文](http://www.cs.toronto.edu/~fritz/absps/imagenet.pdf)

|

||||

|

||||

### <strong>网络框架图</strong>

|

||||

### **网络框架图**

|

||||

|

||||

|

||||

|

||||

### <strong>使用 ReLU 激活函数代替 tanh</strong>

|

||||

### **使用 ReLU 激活函数代替 tanh**

|

||||

|

||||

在当时,标准的神经元激活函数是 tanh()函数,这种饱和的非线性函数在梯度下降的时候要比非饱和的非线性函数慢得多,因此,在 AlexNet 中使用 ReLU 函数作为激活函数。

|

||||

|

||||

|

||||

|

||||

### <strong>采用 Dropout 防止过拟合</strong>

|

||||

### **采用 Dropout 防止过拟合**

|

||||

|

||||

dropout 方法会遍历网络的每一层,并设置消除神经网络中节点的概率。假设网络中的每一层,每个节点都以抛硬币的方式设置概率,每个节点得以保留和消除的概率都是 0.5,设置完节点概率,我们会消除一些节点,然后删除掉从该节点进出的连线,最后得到一个节点更少,规模更小的网络(如下图所示),然后再用反向传播方法进行训练。

|

||||

|

||||

@@ -32,7 +32,7 @@ dropout 方法会遍历网络的每一层,并设置消除神经网络中节点

|

||||

|

||||

###

|

||||

|

||||

### <strong>视频讲解</strong>

|

||||

### **视频讲解**

|

||||

|

||||

# 思考

|

||||

|

||||

@@ -40,7 +40,7 @@ dropout 方法会遍历网络的每一层,并设置消除神经网络中节点

|

||||

|

||||

AlexNet 中有着卷积和 MLP 两种不同的网络结构,那两者之间有着何种区别和联系呢?(可以从两者的权值矩阵去思考)

|

||||

|

||||

### <strong>思考 2</strong>

|

||||

### **思考 2**

|

||||

|

||||

卷积中有一个叫感受野的概念,是什么意思呢?不同的感受野对网络有什么影响?

|

||||

|

||||

|

||||

@@ -2,7 +2,7 @@

|

||||

|

||||

图像分割领域的开山之作。

|

||||

|

||||

首次将<strong>End-to-End</strong>的思想应用在了 CV 领域。

|

||||

首次将**End-to-End**的思想应用在了 CV 领域。

|

||||

|

||||

[知乎](https://zhuanlan.zhihu.com/p/30195134)

|

||||

|

||||

@@ -18,7 +18,7 @@

|

||||

|

||||

FCN 对图像进行像素级的分类,从而解决了语义级别的图像分割问题。与经典的 CNN 在卷积层之后使用全连接层得到固定长度的特征向量进行分类不同,FCN 可以接受任意尺寸的输入图像,采用反卷积层对最后一个卷积层的 feature map 进行上采样, 使它恢复到输入图像相同的尺寸,从而可以对每个像素都产生了一个预测, 同时保留了原始输入图像中的空间信息, 最后在上采样的特征图上进行逐像素分类。

|

||||

|

||||

<strong>简单的来说,FCN 与 CNN 的区域在把于 CNN 最后的全连接层换成卷积层,输出的是一张已经 Label 好的图片。</strong>

|

||||

**简单的来说,FCN 与 CNN 的区域在把于 CNN 最后的全连接层换成卷积层,输出的是一张已经 Label 好的图片。**

|

||||

|

||||

### 反卷积

|

||||

|

||||

|

||||

@@ -8,13 +8,13 @@ NeRF 想做这样一件事,不需要中间三维重建的过程,仅根据位

|

||||

|

||||

|

||||

|

||||

你可以看到,这 100 张图片是对一个乐高推土机的多角度拍摄结果。我们需要的是一个可<strong>以获取这个推土机在任意角度下拍摄的图片</strong>的模型。如图所示:

|

||||

你可以看到,这 100 张图片是对一个乐高推土机的多角度拍摄结果。我们需要的是一个可**以获取这个推土机在任意角度下拍摄的图片**的模型。如图所示:

|

||||

|

||||

|

||||

|

||||

现在来看 NeRF 网络:

|

||||

|

||||

在 NeRF 中,我们把空间<strong>认为是一个个的小方块叠成的空间</strong>(可以理解为 MC)每一个方块有以下属性:

|

||||

在 NeRF 中,我们把空间**认为是一个个的小方块叠成的空间**(可以理解为 MC)每一个方块有以下属性:

|

||||

|

||||

- 3 个位置坐标(x,y,z)

|

||||

- 透明度$\sigma$

|

||||

@@ -24,27 +24,27 @@ NeRF 想做这样一件事,不需要中间三维重建的过程,仅根据位

|

||||

|

||||

## 得到模型

|

||||

|

||||

我们需要的是每个视角下的图片,可以理解为从一个视角发射<strong>光线</strong>,<u>一根光线对应一个像素点</u>。这些光线穿透路径上的所有方块,把这些方块上的属性信息以某种方式累计,就能得到这个像素的颜色。这是 一个已有的公式,只要我们获得每个小方块的颜色信息和不透明度,我们就能知道这个角度下的视图。(这个我们后面介绍)

|

||||

我们需要的是每个视角下的图片,可以理解为从一个视角发射**光线**,<u>一根光线对应一个像素点</u>。这些光线穿透路径上的所有方块,把这些方块上的属性信息以某种方式累计,就能得到这个像素的颜色。这是 一个已有的公式,只要我们获得每个小方块的颜色信息和不透明度,我们就能知道这个角度下的视图。(这个我们后面介绍)

|

||||

|

||||

现在的难点在于:我们不知道<strong>每个小方块的颜色信息</strong>(因为颜色会随着观察角度变化)。众所周知,算法解决不了的问题就扔给神经网络试试啦~

|

||||

现在的难点在于:我们不知道**每个小方块的颜色信息**(因为颜色会随着观察角度变化)。众所周知,算法解决不了的问题就扔给神经网络试试啦~

|

||||

|

||||

<strong>为了获取根据角度变化而变化的颜色信息,我们选择了神经网络。</strong>

|

||||

**为了获取根据角度变化而变化的颜色信息,我们选择了神经网络。**

|

||||

|

||||

<strong>这个网络的输入是:</strong>

|

||||

**这个网络的输入是:**

|

||||

|

||||

- 小方块的位置坐标(x,y,z)

|

||||

- 观察角度(以二维坐标表示两个偏转角)

|

||||

|

||||

<strong>这个网络的输出是:</strong>

|

||||

**这个网络的输出是:**

|

||||

|

||||

- 对应的小方块的 RGB 信息

|

||||

- 不透明度

|

||||

|

||||

|

||||

|

||||

在这里,作者选择了最简单的 MLP,因此,<strong>这是一个输入为 5 维,输出为 4 维向量</strong>($R,G,B,\sigma$)的简单网络,值得注意的是,不透明度与观察角度无关,这里在网络中进行了特殊处理,让这个值与后两维无关。

|

||||

在这里,作者选择了最简单的 MLP,因此,**这是一个输入为 5 维,输出为 4 维向量**($R,G,B,\sigma$)的简单网络,值得注意的是,不透明度与观察角度无关,这里在网络中进行了特殊处理,让这个值与后两维无关。

|

||||

|

||||

<strong>现在我们能够输入坐标和视角信息得到小方块的颜色和不透明度,我们就可以对光线穿过的小方块进行计算了。</strong>

|

||||

**现在我们能够输入坐标和视角信息得到小方块的颜色和不透明度,我们就可以对光线穿过的小方块进行计算了。**

|

||||

|

||||

## 进行渲染

|

||||

|

||||

@@ -54,9 +54,9 @@ NeRF 想做这样一件事,不需要中间三维重建的过程,仅根据位

|

||||

|

||||

这个公式对光线上的所有小方块的颜色进行加权求和,权重是关于不透明度$\sigma$的一个函数$T(\sigma)$,不透明度在[0,1]之间,越不透明这个值越大。也就是越不透明,占的颜色比重越高,比如空气的$\sigma$就接近于 0,乐高本身就接近 1。而求和的结果就是这个光线对应像素的颜色。

|

||||

|

||||

这里展开说一下$T(\sigma)$,我们把不透明度理解为光线在这个小方块被阻止的概率,越不透明,越容易阻挡光线,而光线一旦被阻挡,就不用计算后面的小方块颜色了。因此,我们的$T(\sigma)$就表示<strong>光线能够行进到这个小方块的概率</strong>,也就是这点之前所有小方块的$(1-\sigma)$的乘积。

|

||||

这里展开说一下$T(\sigma)$,我们把不透明度理解为光线在这个小方块被阻止的概率,越不透明,越容易阻挡光线,而光线一旦被阻挡,就不用计算后面的小方块颜色了。因此,我们的$T(\sigma)$就表示**光线能够行进到这个小方块的概率**,也就是这点之前所有小方块的$(1-\sigma)$的乘积。

|

||||

|

||||

这段要仔细看和推导,第一遍不容易直接懂。顺带一提,我们的<strong>小方块</strong>学名叫<strong>体素</strong>,<del>为了显得我们更专业一点以后就叫它体素罢</del>

|

||||

这段要仔细看和推导,第一遍不容易直接懂。顺带一提,我们的**小方块**学名叫**体素**,<del>为了显得我们更专业一点以后就叫它体素罢</del>

|

||||

|

||||

|

||||

|

||||

@@ -84,7 +84,7 @@ NeRF 想做这样一件事,不需要中间三维重建的过程,仅根据位

|

||||

|

||||

我们使用了两个网络:粗网络和精细网络。

|

||||

|

||||

粗网络就是上述采样方法用的普通网络,而<strong>粗网络输出的不透明度值会被作为一个概率分布函数</strong>,精细网络根据这个概率分布在光线上进行采样,不透明度越大的点,它的邻域被采样的概率越大,也就实现了我们要求的在实体上多采样,空气中少采样。最后精细网络输出作为结果,因此粗网络可以只求不透明度,无视颜色信息。

|

||||

粗网络就是上述采样方法用的普通网络,而**粗网络输出的不透明度值会被作为一个概率分布函数**,精细网络根据这个概率分布在光线上进行采样,不透明度越大的点,它的邻域被采样的概率越大,也就实现了我们要求的在实体上多采样,空气中少采样。最后精细网络输出作为结果,因此粗网络可以只求不透明度,无视颜色信息。

|

||||

|

||||

|

||||

|

||||

|

||||

@@ -10,19 +10,19 @@

|

||||

|

||||

### 1.Pixel-nerf

|

||||

|

||||

<strong>Pixel-nerf</strong><strong> </strong>对输入图像使用卷积进行特征提取再执行 nerf,若有多个输入,对每个视角都执行 CNN,在计算光线时,取每一个已有视角下该坐标的特征,经过 mlp 后算平均。可以在少量视角下重建视图,需要进行预训练才能使用,有一定自动补全能力(有限)

|

||||

**Pixel-nerf**** **对输入图像使用卷积进行特征提取再执行 nerf,若有多个输入,对每个视角都执行 CNN,在计算光线时,取每一个已有视角下该坐标的特征,经过 mlp 后算平均。可以在少量视角下重建视图,需要进行预训练才能使用,有一定自动补全能力(有限)

|

||||

|

||||

|

||||

|

||||

### 2.IBRnet

|

||||

|

||||

<strong>IBRnet</strong><strong> </strong>是 pixel-nerf 的改进版,取消了 CNN,并且在 mlp 后接入了 transformer 结构处理体密度(不透明度),对这条光线上所有的采样点进行一个 transformer。同时,在获取某个体素的颜色和密度时,作者用了本视角相邻的两个视角,获取对应体素在这两张图片中的像素,以图片像素颜色,视角,图片特征作为 mlp 的输入。

|

||||

**IBRnet**** **是 pixel-nerf 的改进版,取消了 CNN,并且在 mlp 后接入了 transformer 结构处理体密度(不透明度),对这条光线上所有的采样点进行一个 transformer。同时,在获取某个体素的颜色和密度时,作者用了本视角相邻的两个视角,获取对应体素在这两张图片中的像素,以图片像素颜色,视角,图片特征作为 mlp 的输入。

|

||||

|

||||

|

||||

|

||||

### 3.MVSnerf

|

||||

|

||||

<strong>MVSnerf</strong><strong> </strong>它用 MVS 的方法构建代价体然后在后面接了一个 nerf,MVS 是使用<strong>多视角立体匹配</strong>构建一个代价体,用 3D 卷积网络进行优化,这里对代价体进行 nerf 采样,可以得到可泛化网络。它需要 15min 的微调才能在新数据上使用。<strong>多视角立体匹配是一种传统算法,通过光线,几何等信息计算图像中小块的相似度,得出两个相机视角之间的位置关系。这个算法也被广泛使用在得到我们自己采样的数据的相机变换矩阵上(我就是这么干的)</strong>

|

||||

**MVSnerf**** **它用 MVS 的方法构建代价体然后在后面接了一个 nerf,MVS 是使用**多视角立体匹配**构建一个代价体,用 3D 卷积网络进行优化,这里对代价体进行 nerf 采样,可以得到可泛化网络。它需要 15min 的微调才能在新数据上使用。**多视角立体匹配是一种传统算法,通过光线,几何等信息计算图像中小块的相似度,得出两个相机视角之间的位置关系。这个算法也被广泛使用在得到我们自己采样的数据的相机变换矩阵上(我就是这么干的)**

|

||||

|

||||

|

||||

|

||||

@@ -45,13 +45,13 @@

|

||||

|

||||

## 2)可以 zero-shot 或者 fine-tune 类

|

||||

|

||||

<strong>MVSnerf</strong><strong>,上面已经说了。</strong>

|

||||

**MVSnerf****,上面已经说了。**

|

||||

|

||||

# 2.速度提升

|

||||

|

||||

### 1.instan-ngp

|

||||

|

||||

使用了<strong>哈希表</strong>结构的<strong>instant-ngp</strong>,渲染完美只需要几分钟(采样正常的情况下)这块的速度已经到极致了。

|

||||

使用了**哈希表**结构的**instant-ngp**,渲染完美只需要几分钟(采样正常的情况下)这块的速度已经到极致了。

|

||||

|

||||

展开说说:其实这也是神经网络发展的一个方向,以前的深层网络倾向于把所有东西用网络参数表示,这样推理速度就会慢,这里使用哈希表的快速查找能力存储一些数据信息,instant-ngp 就是把要表达的模型数据特征按照不同的精细度存在哈希表中,使用时通过哈希表调用或插值调用。

|

||||

|

||||

@@ -61,15 +61,15 @@

|

||||

|

||||

### 1.Human-nerf

|

||||

|

||||

<strong>Human-nerf</strong><strong> </strong>生成可编辑的人体运动视频建模,输入是一段人随便动动的视频。输出的动作可以编辑修改,并且对衣物折叠等有一定优化。使用的模型并非全隐式的,并且对头发和衣物单独使用变换模型。使用了逆线性蒙皮模型提取人物骨骼(可学习的模型),上面那个蓝色的就是姿态矫正模块,这个模块赋予骨骼之间运动关系的权重(因为使用的是插值处理同一运动时不同骨骼的平移旋转矩阵,一块骨骼动会牵动其他骨骼)图中的 Ω 就是权重的集合,它通过 mlp 学习得到。然后得到显式表达的人物骨骼以及传入视频中得到的对应骨骼的 mesh,skeletal motion 就是做游戏人物动作用的编辑器这种,后面残差链接了一个 non-rigid-motion(非刚性动作),这个是专门处理衣物和毛发的,主要通过学习得到,然后粗暴的加起来就能得到模型,再经过传统的 nerf 渲染出图像。

|

||||

**Human-nerf**** **生成可编辑的人体运动视频建模,输入是一段人随便动动的视频。输出的动作可以编辑修改,并且对衣物折叠等有一定优化。使用的模型并非全隐式的,并且对头发和衣物单独使用变换模型。使用了逆线性蒙皮模型提取人物骨骼(可学习的模型),上面那个蓝色的就是姿态矫正模块,这个模块赋予骨骼之间运动关系的权重(因为使用的是插值处理同一运动时不同骨骼的平移旋转矩阵,一块骨骼动会牵动其他骨骼)图中的 Ω 就是权重的集合,它通过 mlp 学习得到。然后得到显式表达的人物骨骼以及传入视频中得到的对应骨骼的 mesh,skeletal motion 就是做游戏人物动作用的编辑器这种,后面残差链接了一个 non-rigid-motion(非刚性动作),这个是专门处理衣物和毛发的,主要通过学习得到,然后粗暴的加起来就能得到模型,再经过传统的 nerf 渲染出图像。

|

||||

|

||||

|

||||

|

||||

### 2.Neural Body

|

||||

|

||||

<strong>Neural Body</strong> 通过下面这种<strong>单视角视频</strong>或稀<strong>疏视角照片</strong>来生成人体建模。

|

||||

**Neural Body** 通过下面这种**单视角视频**或稀**疏视角照片**来生成人体建模。

|

||||

|

||||

因为生成的是人体建模,作者使用了他们以前的工作 EasyMocap 得到<strong>SMPL 模型(就是人体的结构)然后在 SMPL 表面生成一些 latent code(包含颜色,不透明度和位置),也就是下左中的那些点。</strong>

|

||||

因为生成的是人体建模,作者使用了他们以前的工作 EasyMocap 得到**SMPL 模型(就是人体的结构)然后在 SMPL 表面生成一些 latent code(包含颜色,不透明度和位置),也就是下左中的那些点。**

|

||||

|

||||

[EasyMocap 的代码](https://link.zhihu.com/?target=https%3A//github.com/zju3dv/EasyMocap)

|

||||

|

||||

@@ -85,25 +85,25 @@ EasyMocap 是通过多视角视频生成骨架以及 SMPL 模型的一个工作

|

||||

|

||||

个人感觉这个模型不能很好处理光影效果,还有待改进。

|

||||

|

||||

是个预训练模型,<strong>训练的模块就是这个 3D 卷积神经网络</strong>。

|

||||

是个预训练模型,**训练的模块就是这个 3D 卷积神经网络**。

|

||||

|

||||

|

||||

|

||||

### 3.wild-nerf

|

||||

|

||||

<strong>wild-nerf</strong> 思路很简单,就是加入了新的输入参数来调整白天黑夜等等一些简单的变化,并且把行人车辆之类的在采样过程中<strong>不固定的物品</strong>作为<strong>随机项</strong>,在渲染时按照概率加入。

|

||||

**wild-nerf** 思路很简单,就是加入了新的输入参数来调整白天黑夜等等一些简单的变化,并且把行人车辆之类的在采样过程中**不固定的物品**作为**随机项**,在渲染时按照概率加入。

|

||||

|

||||

### 4.D-nerf

|

||||

|

||||

<strong>D-nerf</strong> 是一种动态编辑的 nerf,输入为:x,y,z,相机位置,相机角度,<strong>时间 t。</strong>

|

||||

**D-nerf** 是一种动态编辑的 nerf,输入为:x,y,z,相机位置,相机角度,**时间 t。**

|

||||

|

||||

把整个网络分为两块,一块是正常的 nerf 渲染,另一块是下面这个,输入时间与现在的位置坐标,输出<strong>这个位置坐标中的物体现在的位置</strong>与 t=0 时的<strong>位置的差</strong>。再用 t=0 时物体的点信息进行渲染。

|

||||

把整个网络分为两块,一块是正常的 nerf 渲染,另一块是下面这个,输入时间与现在的位置坐标,输出**这个位置坐标中的物体现在的位置**与 t=0 时的**位置的差**。再用 t=0 时物体的点信息进行渲染。

|

||||

|

||||

在此网络的单个输出上貌似是不监督的,因为没办法进行人为标注。这点我不是很确定,以后如果发现了会来修改的。

|

||||

|

||||

|

||||

|

||||

渲染经过形变的物体时,光线其实是在 t=0 时刻进行渲染的,因为推土机的铲子放下去了,所以<strong>光线是弯曲的</strong>。

|

||||

渲染经过形变的物体时,光线其实是在 t=0 时刻进行渲染的,因为推土机的铲子放下去了,所以**光线是弯曲的**。

|

||||

|

||||

|

||||

|

||||

@@ -115,13 +115,13 @@ EasyMocap 是通过多视角视频生成骨架以及 SMPL 模型的一个工作

|

||||

|

||||

### 1.clip-nerf

|

||||

|

||||

<strong>clip-nerf</strong><strong> 太贵了玩不起,没仔细研究,应该是文本跟 3D 建模关联,跟 clip 一样。</strong>

|

||||

**clip-nerf**** 太贵了玩不起,没仔细研究,应该是文本跟 3D 建模关联,跟 clip 一样。**

|

||||

|

||||

# 6.生成类(指加入新物体或者额外生成新场景)

|

||||

|

||||

### 1.GRAF

|

||||

|

||||

<strong>GRAF</strong><strong> </strong>把 GAN 与 nerf 结合,增加了两个输入,分别是<strong>外观/形状编码 z</strong>和<strong>2D 采样编码 v</strong>,z 用来改变渲染出来东西的特征,比如把生成的车变色或者变牌子,suv 变老爷车之类的。v(s,u)用来改变下图 2 中训练时选择光线的标准。这里训练时不是拿 G 生成的整张图扔进 D 网络,而是根据 v 的参数选择一些光线组成的 batch 扔进 D 进行辨别

|

||||

**GRAF**** **把 GAN 与 nerf 结合,增加了两个输入,分别是**外观/形状编码 z**和**2D 采样编码 v**,z 用来改变渲染出来东西的特征,比如把生成的车变色或者变牌子,suv 变老爷车之类的。v(s,u)用来改变下图 2 中训练时选择光线的标准。这里训练时不是拿 G 生成的整张图扔进 D 网络,而是根据 v 的参数选择一些光线组成的 batch 扔进 D 进行辨别

|

||||

|

||||

|

||||

|

||||

@@ -129,7 +129,7 @@ EasyMocap 是通过多视角视频生成骨架以及 SMPL 模型的一个工作

|

||||

|

||||

### 2.GIRAFFE

|

||||

|

||||

<strong>GIRAFFE</strong> 是 GRAF 的改进工作,可以把图片中的物品,背景一个个解耦出来单独进行改变或者移动和旋转,也可以增加新的物品或者减少物品,下图中蓝色是不可训练的模块,橙色可训练。以我的理解好像要设置你要解耦多少个(N)物品再训练,网络根据类似 k 近邻法的方法在特征空间上对物品进行分割解耦,然后分为 N 个渲染 mlp 进行训练,训练前加入外观/形状编码 z。最后还是要扔进 D 训练。

|

||||

**GIRAFFE** 是 GRAF 的改进工作,可以把图片中的物品,背景一个个解耦出来单独进行改变或者移动和旋转,也可以增加新的物品或者减少物品,下图中蓝色是不可训练的模块,橙色可训练。以我的理解好像要设置你要解耦多少个(N)物品再训练,网络根据类似 k 近邻法的方法在特征空间上对物品进行分割解耦,然后分为 N 个渲染 mlp 进行训练,训练前加入外观/形状编码 z。最后还是要扔进 D 训练。

|

||||

|

||||

|

||||

|

||||

@@ -137,7 +137,7 @@ EasyMocap 是通过多视角视频生成骨架以及 SMPL 模型的一个工作

|

||||

|

||||

### 3.OSF

|

||||

|

||||

<strong>OSF</strong>Object-Centric Neural Scene Rendering,可以给移动的物体生成合理的阴影和光照效果。加入了新的坐标信息:光源位置,与相机坐标等一起输入。对每个小物件构建一个单独的小 nerf,计算这个小 nerf 的体素时要先经过光源照射处理(训练出来的)然后在每个小物件之间也要计算反射这样的光线影响,最后进行正常的渲染。<del>这篇文章没人写 review,有点冷门,这些都是我自己读完感觉的,不一定对。</del>

|

||||

**OSF**Object-Centric Neural Scene Rendering,可以给移动的物体生成合理的阴影和光照效果。加入了新的坐标信息:光源位置,与相机坐标等一起输入。对每个小物件构建一个单独的小 nerf,计算这个小 nerf 的体素时要先经过光源照射处理(训练出来的)然后在每个小物件之间也要计算反射这样的光线影响,最后进行正常的渲染。<del>这篇文章没人写 review,有点冷门,这些都是我自己读完感觉的,不一定对。</del>

|

||||

|

||||

|

||||

|

||||

@@ -147,9 +147,9 @@ EasyMocap 是通过多视角视频生成骨架以及 SMPL 模型的一个工作

|

||||

|

||||

作者用了几个我比较陌生的技术,比如超网络 hypernet,还有超网络与 gan 结合的 INR-Gan。

|

||||

|

||||

<strong>hypernet</strong>:把随机初始化和直接梯度回传更新的网络参数用另一个神经网络来更新,就是我们要同时训练两个网络,一个是本体,一个是调整参数用的超网络。

|

||||

**hypernet**:把随机初始化和直接梯度回传更新的网络参数用另一个神经网络来更新,就是我们要同时训练两个网络,一个是本体,一个是调整参数用的超网络。

|

||||

|

||||

<strong>INR-Gan</strong>:把超网络技术与 Gan 结合,并且用了 INR 技术,这个技术类似 nerf,不过是处理图片用到的,是构建一个坐标(x,y)->RGB 的网络,可以让图片达到更高分辨率,也就是把离散的像素变成连续的。

|

||||

**INR-Gan**:把超网络技术与 Gan 结合,并且用了 INR 技术,这个技术类似 nerf,不过是处理图片用到的,是构建一个坐标(x,y)->RGB 的网络,可以让图片达到更高分辨率,也就是把离散的像素变成连续的。

|

||||

|

||||

左边是常规卷积网络生成图像,右边是用 INR 生成图像。

|

||||

|

||||

@@ -161,12 +161,12 @@ EasyMocap 是通过多视角视频生成骨架以及 SMPL 模型的一个工作

|

||||

|

||||

2.因为使用神经网路去表示图片,占用内存更大。

|

||||

|

||||

因此,作者设计了<strong>FMM</strong>去应对这两个问题,这也是 Hyper-nerf-gan 借鉴的主要部分。

|

||||

因此,作者设计了**FMM**去应对这两个问题,这也是 Hyper-nerf-gan 借鉴的主要部分。

|

||||

|

||||

FMM 主要是把要学习的矩阵转化为两个低秩矩阵,去先生成他们俩再相乘,减少网络计算量。

|

||||

|

||||

|

||||

|

||||

现在开始讲 Hyper-nerf-gan 本身,它看上去其实就是 nerf 接在 gan 上。不过有一些变化,比如输入不再包含视角信息,我<strong>很怀疑它不能很好表达反光效果</strong>。而且抛弃了粗网络细网络的设计,只使用粗网络减少计算量。这里的 generator 完全就是 INR-Gan 的形状,生成权重,然后再经过 nerf 的 mlp 层生成,没啥别的了,就这样吧。

|

||||

现在开始讲 Hyper-nerf-gan 本身,它看上去其实就是 nerf 接在 gan 上。不过有一些变化,比如输入不再包含视角信息,我**很怀疑它不能很好表达反光效果**。而且抛弃了粗网络细网络的设计,只使用粗网络减少计算量。这里的 generator 完全就是 INR-Gan 的形状,生成权重,然后再经过 nerf 的 mlp 层生成,没啥别的了,就这样吧。

|

||||

|

||||

|

||||

|

||||

@@ -5,7 +5,7 @@

|

||||

|

||||

|

||||

这里主要是记录一下它的原理:

|

||||

首先是一个经典关键点匹配技术:<strong>SIFT</strong>

|

||||

首先是一个经典关键点匹配技术:**SIFT**

|

||||

|

||||

# SIFT 特征点匹配

|

||||

|

||||

@@ -17,7 +17,7 @@

|

||||

|

||||

下面是原理方法:

|

||||

|

||||

首先是<strong>高斯金字塔</strong>,它是把原图先放大两倍,然后使用高斯滤波(高斯卷积)对图像进行模糊化数次,取出倒数第三层缩小一半继续进行这个过程,也就是说它是由一组一组的小金字塔组成的。

|

||||

首先是**高斯金字塔**,它是把原图先放大两倍,然后使用高斯滤波(高斯卷积)对图像进行模糊化数次,取出倒数第三层缩小一半继续进行这个过程,也就是说它是由一组一组的小金字塔组成的。

|

||||

|

||||

|

||||

|

||||

|

||||

@@ -2,25 +2,25 @@

|

||||

|

||||

下面给出了 NLP 的四大常见的应用。由于预训练的模型是在连续的文本序列上训练的,所以需要进行一些修改才能将其应用于不同的这些 NLP 任务。

|

||||

|

||||

<strong>分类 (text classification):</strong> 给一句话或者一段文本,判断一个标签。

|

||||

**分类 (text classification):** 给一句话或者一段文本,判断一个标签。

|

||||

|

||||

|

||||

|

||||

图 2:分类 (text classification)

|

||||

|

||||

<strong>蕴含 (textual entailment):</strong> 给一段话,和一个假设,看看前面这段话有没有蕴含后面的假设。

|

||||

**蕴含 (textual entailment):** 给一段话,和一个假设,看看前面这段话有没有蕴含后面的假设。

|

||||

|

||||

|

||||

|

||||

图 3:蕴含 (textual entailment)

|

||||

|

||||

<strong>相似 (Similarity):</strong> 判断两段文字是否相似。

|

||||

**相似 (Similarity):** 判断两段文字是否相似。

|

||||

|

||||

|

||||

|

||||

图 4:相似 (Similarity)

|

||||

|

||||

<strong>多选题 (Multiple Choice):</strong> 给个问题,从 N 个答案中选出正确答案。

|

||||

**多选题 (Multiple Choice):** 给个问题,从 N 个答案中选出正确答案。

|

||||

|

||||

|

||||

|

||||

|

||||

@@ -1,13 +1,13 @@

|

||||

# 推荐系统概念解释 and 一个好的推荐系统

|

||||

|

||||

- <strong>用户满意度</strong>

|

||||

- **用户满意度**

|

||||

|

||||

- 用户满意度是推荐系统测评的重要指标,但是实际上,用户满意度数据获得的方式十分有限,因为这是一种用户的主观情感。

|

||||

- 设计合适的方式对于用户的满意度进行回收分析,是改进推荐系统的一个很好的方式。这样的的方式包括但不限于,设计合适的调查问卷,在物品的购买结束后附上一份满意度调查。

|

||||

- 满意度在一些程度上可以细分为更加具体的信息。例如点击率,用户停留时间,转化率,完播率,或者是哔站视频点赞,三连的比例。

|

||||

- <strong>预测准确度</strong>

|

||||

- **预测准确度**

|

||||

|

||||

- <strong>召回率(Recall)</strong>

|

||||

- **召回率(Recall)**

|

||||

|

||||

$$

|

||||

Recall =\frac{\sum_{u\in U}{\vert R(u)\cap T(u) \vert}}{\sum_{u\in U \vert T(u)\vert}}

|

||||

@@ -19,7 +19,7 @@

|

||||

- 召回率的意义?可以参考机器学习中留下的定义进行理解

|

||||

|

||||

|

||||

- <strong>精确率</strong>

|

||||

- **精确率**

|

||||

|

||||

$$

|

||||

Precision =\frac{\sum_{u\in U}{\vert R(u)\cap T(u)\vert}}{\sum_{u\in U}{\vert R(u) \vert}}

|

||||

@@ -31,7 +31,7 @@

|

||||

- 精确率的意义?

|

||||

|

||||

|

||||

- <strong>覆盖率</strong>

|

||||

- **覆盖率**

|

||||

|

||||

- 描述了一个系统对于物品长尾的发掘能力。

|

||||

- 覆盖率的一个定义可以是:

|

||||

@@ -42,7 +42,7 @@

|

||||

- 覆盖率的意义:覆盖率越高,以为这系统中被推荐给用户的物品,占所有物品的比例越大,对于一个好的推荐系统,不仅需要有较高的用户满意度,还需要有较高的覆盖率。

|

||||

- 当然对于覆盖率的定义,不止以上的这一种,甚至说,在实际使用上,上述简单的覆盖率不足以支撑大规模复杂系统的覆盖率计算,所以如何对于覆盖率进行修正和更新?信息熵与基尼系数!

|

||||

- 推荐了解,马太效应,一个强者更强,弱者更弱的效应,在推荐系统中也同样存在。

|

||||

- <strong>多样性</strong>

|

||||

- **多样性**

|

||||

|

||||

- 假设,$s(i,j)$ 定义了物品 i 和 j 之间的相似度,给用户 $u$ 的推荐列表 $R(u)$的多样性定义:

|

||||

$$

|

||||

@@ -52,12 +52,12 @@

|

||||

$$

|

||||

Diversity = \frac{1}{\vert U\vert}\sum_{u\in U}{Diversity(R(u))}

|

||||

$$

|

||||

- <strong>信任度</strong>

|

||||

- **信任度**

|

||||

|

||||

- 用户对于该系统的信任程度

|

||||

- <strong>实时性</strong>

|

||||

- **实时性**

|

||||

|

||||

- 系统对于数据更新的时效性

|

||||

- <strong>健壮性</strong>

|

||||

- **健壮性**

|

||||

|

||||

- 系统对于外来攻击的防护性

|

||||

|

||||

@@ -12,12 +12,12 @@

|

||||

|

||||

- 时间信息对于用户的的影响可以主要分为以下几项:

|

||||

|

||||

- <strong>用户的兴趣是变化的</strong>

|

||||

- **用户的兴趣是变化的**

|

||||

对于一个用户,其幼年时期和青年时期喜欢的动画片是不一样的;晴天和雨天想要的物品是不一样的;一个人开始工作前和开始工作后的需求也是不同的。

|

||||

所以应该关注用户的近期行为,确定他的兴趣,最后给予用户推荐。

|

||||

- <strong>物品具有生命周期</strong>

|

||||

- **物品具有生命周期**

|

||||

流行物品会随着热度持续火爆一段时间,但最终会无人问津;生活必需品无论在什么时候都有稳定的需求量。

|

||||

- <strong>季节效应</strong>

|

||||

- **季节效应**

|

||||

正如概述中列出的冬衣与夏衣的区别,应该在合适的季节给用户推荐合适的物品。

|

||||

|

||||

### 系统时间特性分析

|

||||

@@ -25,10 +25,10 @@

|

||||

- 当系统由之前的静态系统变成随时间变化的时变系统后,需要关注特性也会发生变化,则需要重新观测一些数据,以推断系统的关于时间变化的特性。

|

||||

下面是一些可以用来观测的数据:

|

||||

|

||||

- <strong>确定系统的用户增长数</strong>,以判断系统的增长情况或是衰退情况。

|

||||

- <strong>物品的平均在线天数</strong>,即将满足用户物品互动次数的物品标记为在线,测算物品的平均在线天数以标量物品的生命周期。

|

||||

- 系统的时效性,判断<strong>相隔一段时间的物品流行度向量的相似度</strong>,若是相隔一段时间的相似度仍然较大,说明经过一段时间后,该物品还是被大众喜欢,则说明这件物品具有持久流行性。而对于系统来说,若是系统中大量物品的相似度变化都不大,则说明这个系统是一个推荐热度较持久物品的系统,说明系统的时效性较弱。

|

||||

- 系统对于用户的黏着性,统计<strong>用户的平均活跃天数</strong>,或者计算<strong>相隔一段时间的用户活跃度</strong>,以此判断系统对于用户的留存力或者说黏着性。

|

||||

- **确定系统的用户增长数**,以判断系统的增长情况或是衰退情况。

|

||||

- **物品的平均在线天数**,即将满足用户物品互动次数的物品标记为在线,测算物品的平均在线天数以标量物品的生命周期。

|

||||

- 系统的时效性,判断**相隔一段时间的物品流行度向量的相似度**,若是相隔一段时间的相似度仍然较大,说明经过一段时间后,该物品还是被大众喜欢,则说明这件物品具有持久流行性。而对于系统来说,若是系统中大量物品的相似度变化都不大,则说明这个系统是一个推荐热度较持久物品的系统,说明系统的时效性较弱。

|

||||

- 系统对于用户的黏着性,统计**用户的平均活跃天数**,或者计算**相隔一段时间的用户活跃度**,以此判断系统对于用户的留存力或者说黏着性。

|

||||

|

||||

### 推荐系统的实时性

|

||||

|

||||

@@ -45,9 +45,9 @@

|

||||

|

||||

综上,时间多样性会提高用户的满意度,所以如何在确保精度的条件下提高系统的时间多样性呢?

|

||||

|

||||

- <strong>需要用户在有新行为时,更新推荐列表</strong>

|

||||

- **需要用户在有新行为时,更新推荐列表**

|

||||

传统的离线更新的推荐系统无法满足需求,所以需要使用实时推荐系统。

|

||||

- <strong>需要用户在没有新行为的时候,经常变化推荐列表</strong>

|

||||

- **需要用户在没有新行为的时候,经常变化推荐列表**

|

||||

通常采取以下三种方法:

|

||||

|

||||

- 生成推荐列表时加入一定的随机性。

|

||||

@@ -58,7 +58,7 @@

|

||||

|

||||

### 时间上下文推荐算法

|

||||

|

||||

- <strong>最近最热门</strong>

|

||||

- **最近最热门**

|

||||

一种最朴素的思想, 在系统引入了时间信息之后,最简单的非个性化推荐算法就是给用户推荐最近最热门的物品。

|

||||

|

||||

给定时间 T,物品 i 在最近的流行度可定义为:

|

||||

@@ -67,10 +67,10 @@

|

||||

n_i(T)= \sum_{(u,i,t) \in Train ,t<T} \frac{1}{1+\alpha(T-t)}

|

||||

$$

|

||||

|

||||

- <strong>时间上下文相关的 itemCF 算法</strong>

|

||||

- **时间上下文相关的 itemCF 算法**

|

||||

itemCF 算法所依赖的核心部分,在引入时间信息后可以进行进一步更新

|

||||

|

||||

- <strong>物品相似度</strong> 利用用户行为,计算物品间的相似度,用户在相隔很短的时间内喜欢的物品通常具有更高的相似度,所以可以在相似度计算公式中引入时间信息,使得相似度计算更加准确。

|

||||

- **物品相似度** 利用用户行为,计算物品间的相似度,用户在相隔很短的时间内喜欢的物品通常具有更高的相似度,所以可以在相似度计算公式中引入时间信息,使得相似度计算更加准确。

|

||||

原本的相似度公式为:

|

||||

|

||||

$$

|

||||

@@ -91,7 +91,7 @@

|

||||

|

||||

其中$\alpha$ 是时间衰减参数,它的取值与系统的对于自身定义有关系。收到用户兴趣变化的额外影响。

|

||||

|

||||

- <strong>在线推荐</strong> 用户近期行为相比用户很久之前的行为,更能体现用户目前的兴趣,所以在进行预测时,应当加重用户近期行为的权重,但不应该偏离用户长期行为的行为基调。

|

||||

- **在线推荐** 用户近期行为相比用户很久之前的行为,更能体现用户目前的兴趣,所以在进行预测时,应当加重用户近期行为的权重,但不应该偏离用户长期行为的行为基调。

|

||||

原本的用户u对于物品i的兴趣$p(u,i)$ 可通过如下公式计算:

|

||||

|

||||

$$p(u,i)=\sum_{j\in N(u)}{sim(i,j)}$$

|

||||

@@ -106,11 +106,11 @@

|

||||

|

||||

在上面的更新后公式中,$t_0$ 表示当前时间,该公式表明,当 $t_{uj}$ 与 $t_0$ 越靠近,和物品j相似的物品就会在用户u的推荐列表中获得更高的排名。其中的$\beta$和上文的 $\alpha$ 是一样的,需要根据系统的情况选择合适的值。

|

||||

|

||||

- <strong>时间上下文相关的userCF算法</strong>

|

||||

- **时间上下文相关的userCF算法**

|

||||

|

||||

与itemCF算法类似,userCF在引入时间信息后也可以进行更新

|

||||

|

||||

- <strong>用户兴趣相似度</strong> 用户相似度在引入时间信息后,会将用户相同的逆时序选择相似度降低。简单来说,就是A一月BF1长时间在线,二月BF5长时间在线,而B一月BF5长时间在线,二月BF1长时间在线;C行为信息与A相同。如果不引入时间信息,那么AB的相似度与AC的相似度是一样的,而实际上,AC的相似度会大于AB的相似度。

|

||||

- **用户兴趣相似度** 用户相似度在引入时间信息后,会将用户相同的逆时序选择相似度降低。简单来说,就是A一月BF1长时间在线,二月BF5长时间在线,而B一月BF5长时间在线,二月BF1长时间在线;C行为信息与A相同。如果不引入时间信息,那么AB的相似度与AC的相似度是一样的,而实际上,AC的相似度会大于AB的相似度。

|

||||

|

||||

userCF的用户uv间相似度的基本公式为:

|

||||

|

||||

@@ -130,7 +130,7 @@

|

||||

|

||||

同样增加了一个时间衰减因子,用户uv对于i的作用时间差距越大,那么两人的相似度会相应降低。

|

||||

|

||||

- <strong>相似兴趣用户的最近行为</strong> 对于用户u来说,存在最近行为与用户u相似的用户v,那么用户v的最近行为,将会比用户u很久之前的行为更具有参考价值。

|

||||

- **相似兴趣用户的最近行为** 对于用户u来说,存在最近行为与用户u相似的用户v,那么用户v的最近行为,将会比用户u很久之前的行为更具有参考价值。

|

||||

|

||||

userCF中用户u对于物品i兴趣的基础公式为:

|

||||

|

||||

@@ -146,7 +146,7 @@

|

||||

p(u,i)=\sum_{v\in S(u,k)}{w_{ui}r_{vi}} \frac{1}{1+\alpha(\vert t_0-t_{vi}\vert)}

|

||||

$$

|

||||

|

||||

- <strong>时间段图模型</strong>

|

||||

- **时间段图模型**

|

||||

同样是一个基于图的推荐系统模型,引入时间信息,建立一个二分图时间段图模型:

|

||||

|

||||

$$

|

||||

@@ -169,11 +169,11 @@

|

||||

在构建了引入时间信息的图结构后,最简单的思想就是利用PersonalRank算法给用进行个性化推荐。但由于其复杂度较高,所以引入路径融合算法。

|

||||

一般来说,图上两个点的相关度强有以下的特征:

|

||||

|

||||

- <strong>两个顶点间有很多路径</strong>

|

||||

- **两个顶点间有很多路径**

|

||||

|

||||

- <strong>两个顶点间路径比较短</strong>

|

||||

- **两个顶点间路径比较短**

|

||||

|

||||

- <strong>两点间不经过出度大的点</strong> ,即不经过与很多其他点相连的节点,在推荐系统思维中等效于不与过热门物品关系紧密。

|

||||

- **两点间不经过出度大的点** ,即不经过与很多其他点相连的节点,在推荐系统思维中等效于不与过热门物品关系紧密。

|

||||

|

||||

#### 路径融合算法

|

||||

|

||||

@@ -199,15 +199,15 @@

|

||||

|

||||

### 地点信息效应

|

||||

|

||||

- <strong>基于用户当前位置的推荐</strong>:对于用户当前位置,为其推荐距离更近的餐馆,娱乐场所或消费场所。

|

||||

- **基于用户当前位置的推荐**:对于用户当前位置,为其推荐距离更近的餐馆,娱乐场所或消费场所。

|

||||

|

||||

- <strong>基于用户活跃位置的推荐</strong>:对于用户长期活跃的区域,降低该区域内物品的权重,提高范围外物品的权重,以提高系统的新鲜度。

|

||||

- **基于用户活跃位置的推荐**:对于用户长期活跃的区域,降低该区域内物品的权重,提高范围外物品的权重,以提高系统的新鲜度。

|

||||

|

||||

### 基于位置的推荐算法

|

||||

|

||||

- 明尼苏达大学的LARS推荐系统(Location Aware Recommender System,位置感知推荐系统)。

|

||||

|

||||

- <strong>对于数据的预处理</strong>

|

||||

- **对于数据的预处理**

|

||||

|

||||

|

||||

将物品分为两类:(1)有空间属性的物品,餐馆,商店,旅游景点。(2)没有空间属性的物品,图书电影等。

|

||||

@@ -223,9 +223,9 @@

|

||||

(用户,用户位置,物品,物品位置,评分):记录了某个位置的用户,对于某个地点的物品的评分。

|

||||

|

||||

|

||||

- <strong>研究前两组数据</strong>:发现两种特征:(1)兴趣本地化,不同位置的用户存在较大的兴趣差异,不同国家和不同地区的差异。(2)活动本地化,一个用户往往在附近的地区活动。

|

||||

- **研究前两组数据**:发现两种特征:(1)兴趣本地化,不同位置的用户存在较大的兴趣差异,不同国家和不同地区的差异。(2)活动本地化,一个用户往往在附近的地区活动。

|

||||

|

||||

- <strong>对于不同数据的处理</strong>

|

||||

- **对于不同数据的处理**

|

||||

|

||||

- 第一种数据:LARS的基本思想是,采用树状结构来进行数据集划分。

|

||||

|

||||

@@ -236,7 +236,7 @@

|

||||

(3)LARS通过该节点的行为数据,利用基本推荐算法进行为用户进行推荐。

|

||||

|

||||

但是,对于上述过程,若是树的深度较大,则划分到每个节点的用户数据将较少,难以训练出一个令人满意的模型。所以有改进方法如下:

|

||||

从根节点出发,利用每个中间节点的数据训练出一个模型,而最终的推荐结果,是这一些列推荐模型所产出的推荐结果的加权结果。这个模型也被称为“<strong>金字塔模型</strong>”,其中<strong>深度</strong>是影响这个模型性能的重要参数,选取合适的深度对于该算法十分重要。

|

||||

从根节点出发,利用每个中间节点的数据训练出一个模型,而最终的推荐结果,是这一些列推荐模型所产出的推荐结果的加权结果。这个模型也被称为“**金字塔模型**”,其中**深度**是影响这个模型性能的重要参数,选取合适的深度对于该算法十分重要。

|

||||

|

||||

- 第二种数据:对于物品i在用户u推荐列表中的权重公式进行修正

|

||||

(1)首先忽略物品的位置信息,利用itemCF算法计算用户u对物品i的兴趣。

|

||||

|

||||

@@ -4,7 +4,7 @@

|

||||

|

||||

VIT前Transformer模型被大量应用在NLP自然语言处理当中,而在CV领域,Transformer的注意力机制attention也被广泛应用,比如Se模块,CBAM模块等等注意力模块,这些注意力模块能够帮助提升网络性能。

|

||||

|

||||

而<strong>VIT的工作展示了不需要依赖CNN的结构,也可以在图像分类任务上达到很好的效果</strong>。

|

||||

而**VIT的工作展示了不需要依赖CNN的结构,也可以在图像分类任务上达到很好的效果**。

|

||||

|

||||

同时VIT也影响了近2年的CV领域,改变了自2012年AlexNet提出以来卷积神经网络在CV领域的绝对统治地位。

|

||||

|

||||

@@ -24,7 +24,7 @@

|

||||

|

||||

结构上,VIT 采取的是原始 Transformer 模型,方便开箱即用,即在 encoder-decoder 结构上与 NLP 的 Transform 模型并无差别。

|

||||

|

||||

主要做出的贡献在于<strong>数据处理和分类头</strong>

|

||||

主要做出的贡献在于**数据处理和分类头**

|

||||

|

||||

### Patch embedding

|

||||

|

||||

@@ -38,7 +38,7 @@

|

||||

|

||||

> 今天天气不错,我要去看电影

|

||||

|

||||

其中<strong>我</strong>则编码为[0.5,0.6,0.6]

|

||||

其中**我**则编码为[0.5,0.6,0.6]

|

||||

|

||||

而具体来说 Word embedding 分为以下两步

|

||||

|

||||

|

||||

@@ -6,9 +6,9 @@

|

||||

|

||||

# 前言

|

||||

|

||||

BERT 是一种基于 transformer 架构的自然语言处理模型,它把在 cv 领域广为应用的<strong>预训练(pre-trainning)</strong>和<strong>微调(fine-tune)</strong>的结构成功引入了 NLP 领域。

|

||||

BERT 是一种基于 transformer 架构的自然语言处理模型,它把在 cv 领域广为应用的**预训练(pre-trainning)**和**微调(fine-tune)**的结构成功引入了 NLP 领域。

|

||||

|

||||

简单来说,BERT 就是一种<strong>认识几乎所有词的</strong>,<strong>训练好</strong>的网络,当你要做一些下游任务时,可以在 BERT 预训练模型的基础上进行一些微调,以进行你的任务。也就是 backbone 模型,输出的是文本特征。

|

||||

简单来说,BERT 就是一种**认识几乎所有词的**,**训练好**的网络,当你要做一些下游任务时,可以在 BERT 预训练模型的基础上进行一些微调,以进行你的任务。也就是 backbone 模型,输出的是文本特征。

|

||||

|

||||

举个例子,我要做一个文本情感分析任务,也就是把文本对情感进行分类,那我只需要在 BERT 的基础上加一个 mlp 作为分类头,在我的小规模数据上进行继续训练即可(也就是微调)。

|

||||

|

||||

@@ -24,9 +24,9 @@ mlp 的重点和创新并非它的模型结构,而是它的训练方式,前

|

||||

|

||||

在文本被输入模型之前,我们要对它进行一些处理:

|

||||

|

||||

1. <strong>词向量</strong>(wordpiece embedding):单词本身的向量表示。每个词(或者进行时过去时后缀之类的)会被记录为一个向量。它们被储存在一个字典里,这一步其实就是在字典中查找这个词对应的向量。

|

||||

2. <strong>位置向量</strong>(position embedding):将单词的位置信息编码成特征向量。构建 position embedding 有两种方法:BERT 是初始化一个 position embedding,<strong>然后通过训练将其学出来</strong>;而 Transformer 是通过<strong>制定规则</strong>来构建一个 position embedding。

|

||||

3. <strong>句子向量</strong>(segment embedding):用于区分两个句子的向量表示。这个在问答等非对称句子中是用于区别的。(这个主要是因为可能会用到对句子的分析中)

|

||||

1. **词向量**(wordpiece embedding):单词本身的向量表示。每个词(或者进行时过去时后缀之类的)会被记录为一个向量。它们被储存在一个字典里,这一步其实就是在字典中查找这个词对应的向量。

|

||||

2. **位置向量**(position embedding):将单词的位置信息编码成特征向量。构建 position embedding 有两种方法:BERT 是初始化一个 position embedding,**然后通过训练将其学出来**;而 Transformer 是通过**制定规则**来构建一个 position embedding。

|

||||

3. **句子向量**(segment embedding):用于区分两个句子的向量表示。这个在问答等非对称句子中是用于区别的。(这个主要是因为可能会用到对句子的分析中)

|

||||

|

||||

BERT 模型的输入就是上面三者的和,如图所示:

|

||||

|

||||

@@ -34,7 +34,7 @@ BERT 模型的输入就是上面三者的和,如图所示:

|

||||

|

||||

## 模型结构

|

||||

|

||||

简单来说,BERT 是 transformer<strong>编码器</strong>的叠加,<strong>也就是下图左边部分</strong>。这算一个 block。

|

||||

简单来说,BERT 是 transformer**编码器**的叠加,**也就是下图左边部分**。这算一个 block。

|

||||

|

||||

|

||||

|

||||

@@ -50,7 +50,7 @@ BERT 训练方式跟 cv 里的很多 backbone 模型一样,是先用几个具

|

||||

|

||||

跟以往的 nlp 模型不同,BERT 的掩码并非 transformer 那样,给前面不给后面,而是在句子中随机把单词替换为 mask,让模型去猜,也就是完形填空。下面给个例子:

|

||||

|

||||

<strong>划掉的单词是被 mask 的</strong>

|

||||

**划掉的单词是被 mask 的**

|

||||

|

||||

正常的掩码:I am a <del>little cat</del>

|

||||

|

||||

|

||||

@@ -14,7 +14,7 @@ cv 领域,其实预训练模型早已推广,一般是在 imagenet 上进行

|

||||

|

||||

那么问题来了,既然我们要学习 BERT 的随机掩码,那么我们应该对什么做 mask 呢?

|

||||

|

||||

因为图片不像文本,有单词这一基础单位。图片的基础单位像素在被单独拿出来的时候包含的语义信息是完全不如单词的。因为像素的语义信息与<strong>上下左右的连续关系</strong>很密切。于是作者采用了像 VIT 那样把图片分成好几个 patch,对 patch 做随机掩码。

|

||||

因为图片不像文本,有单词这一基础单位。图片的基础单位像素在被单独拿出来的时候包含的语义信息是完全不如单词的。因为像素的语义信息与**上下左右的连续关系**很密切。于是作者采用了像 VIT 那样把图片分成好几个 patch,对 patch 做随机掩码。

|

||||

|

||||

# 模型结构与训练方式

|

||||

|

||||

|

||||

@@ -16,7 +16,7 @@

|

||||

|

||||

对比学习,故名思意,是对比着来学习。而我们拿来对比的东西就是在模型眼里的语义,也就是我们叫做特征的向量。

|

||||

|

||||

在具体讲对比之前,我们先看看传统的<strong>监督学习</strong>是怎么学特征的:

|

||||

在具体讲对比之前,我们先看看传统的**监督学习**是怎么学特征的:

|

||||

|

||||

数据 + 模型=> 特征,特征对人工标注进行学习,也就是说我们要把模型抽取的特征尽可能的靠近人工标注

|

||||

|

||||

@@ -26,15 +26,15 @@

|

||||

|

||||

|

||||

|

||||

我们通过<strong>正样本</strong>(跟拿到的特征<strong>应当相近</strong>的另一个特征)与<strong>负样本</strong>(反之)的对比,使得

|

||||

我们通过**正样本**(跟拿到的特征**应当相近**的另一个特征)与**负样本**(反之)的对比,使得

|

||||

|

||||

越相近的物体,它们的特征就在超球面上越靠近,越不像的物体离的越远,去学习图片更本质的特征

|

||||

|

||||

那么具体的对比学习方法我在后面结合一些论文一起讲吧~

|

||||

|

||||

这部分内容更像一个综述,讲述对比学习这几年的发展路程,所以我会尽可能的描述作者在论文里讲的<strong>故事</strong>,来方便大家弄清为什么要这么做。

|

||||

这部分内容更像一个综述,讲述对比学习这几年的发展路程,所以我会尽可能的描述作者在论文里讲的**故事**,来方便大家弄清为什么要这么做。

|

||||

|

||||

<strong>可能会有很多我的主观理解在此</strong>,并且<strong>不会</strong>深入细节。可以算是一个总结和分享,我会在这里带着读者过一遍近期对比学习的工作来给大家一个对比学习方向的直观感性理解。

|

||||

**可能会有很多我的主观理解在此**,并且**不会**深入细节。可以算是一个总结和分享,我会在这里带着读者过一遍近期对比学习的工作来给大家一个对比学习方向的直观感性理解。

|

||||

|

||||

同时因为笔者水平,视野,精力有限,不可能包含所有的算法,也不可能保证完全正确。因此仅作为笔记分享使用。若有错误,请多多指正。

|

||||

|

||||

|

||||

@@ -14,7 +14,7 @@

|

||||

|

||||

既然有了上面这个发现,那么作者想我能不能把分类任务推到极致呢?

|

||||

|

||||

于是他们<strong>把每一个图片当作一个类别</strong>,去跟其他的图片做对比,具体模型如下

|

||||

于是他们**把每一个图片当作一个类别**,去跟其他的图片做对比,具体模型如下

|

||||

|

||||

|

||||

|

||||

@@ -24,9 +24,9 @@

|

||||

|

||||

2.后面接了一个 Non-param Softmax(非参数 softmax),其实就是一个不被训练的,把所有特征投射到超球面上的一个分类头(把所有特征模长变为 1)。

|

||||

|

||||

3.后面的<strong>Memory Bank</strong>是这篇文章的<strong>重点</strong>,它是一个<strong>动态字典</strong>。我们把每一个图片抽取出来的特征存入 memory bank,每次计算时抽取其中部分作为一个 batch 进行对比学习,把更新后的模型得到的特征替换 memory bank 里原先的特征。

|

||||

3.后面的**Memory Bank**是这篇文章的**重点**,它是一个**动态字典**。我们把每一个图片抽取出来的特征存入 memory bank,每次计算时抽取其中部分作为一个 batch 进行对比学习,把更新后的模型得到的特征替换 memory bank 里原先的特征。

|

||||

|

||||

4.具体损失函数用的是一个叫 NCEloss 的损失,它把多分类问题分为<strong>若干个二分类问题</strong>,<strong>是</strong>与<strong>不是</strong>,每个 batch 中只有一个的 ground truth 是’yes‘,其余都是’no‘

|

||||

4.具体损失函数用的是一个叫 NCEloss 的损失,它把多分类问题分为**若干个二分类问题**,**是**与**不是**,每个 batch 中只有一个的 ground truth 是’yes‘,其余都是’no‘

|

||||

|

||||

在训练的时候,相当于是有一组以前的编码器抽取的特征 A,B,C,D...,一组当前编码器抽取的特征 a,b,c,d...,对它们进行对比学习。对 a 来说,A 是正样本,其他都是负样本,同理类推。

|

||||

|

||||

@@ -38,9 +38,9 @@

|

||||

|

||||

用动量更新的方法去更新 memory bank 中的特征

|

||||

|

||||

也就是让特征的变化<strong>不那么剧烈</strong>

|

||||

也就是让特征的变化**不那么剧烈**

|

||||

|

||||

原因:如果一直保持更新,<strong>特征总体的变化就会比较大</strong>,而我们在大数据集上训练的时候,等第二次调用一个特征时,它跟现在的特征分布已经大相径庭,那就不好训练了,也就是<strong>特征缺乏一致性</strong>。因此我们引入动量更新来确保特征进行平稳的改变,而非突变。

|

||||

原因:如果一直保持更新,**特征总体的变化就会比较大**,而我们在大数据集上训练的时候,等第二次调用一个特征时,它跟现在的特征分布已经大相径庭,那就不好训练了,也就是**特征缺乏一致性**。因此我们引入动量更新来确保特征进行平稳的改变,而非突变。

|

||||

|

||||

#### 关于动量的小拓展

|

||||

|

||||

@@ -60,4 +60,4 @@ m 表示动量,k 是新的特征,q 是上一个特征,只要设置小的

|

||||

|

||||

总体来说,Inst Disc 把对比学习成功引入了 CV 领域,核心思想是构建动态字典进行对比学习

|

||||

|

||||

<strong>PS:若无特殊说明,最后保留下来去做下游任务的模型只有编码器,其他都删除了。</strong>

|

||||

**PS:若无特殊说明,最后保留下来去做下游任务的模型只有编码器,其他都删除了。**

|

||||

|

||||

@@ -6,9 +6,9 @@

|

||||

|

||||

|

||||

|

||||

这是处理音频的一个例子,<strong>给模型 t 时刻以前的信息,让它抽取特征并对后文进行预测,真正的后文作为正样本,负样本当然是随便选取就好啦。</strong>

|

||||

这是处理音频的一个例子,**给模型 t 时刻以前的信息,让它抽取特征并对后文进行预测,真正的后文作为正样本,负样本当然是随便选取就好啦。**

|

||||

|

||||

不同于之前说的个体判别,这个是<strong>生成式模型</strong>,这个模型不止可以处理音频,还可以处理图片(每一个块换成一个词)或者处理图片(以 patch 为单位)。

|

||||

不同于之前说的个体判别,这个是**生成式模型**,这个模型不止可以处理音频,还可以处理图片(每一个块换成一个词)或者处理图片(以 patch 为单位)。

|

||||

|

||||

是不是有点眼熟?这跟我前面写的 BERT 和 MAE 其实异曲同工,不过这两位是随机 mask,而非时序性的 mask。

|

||||

|

||||

|

||||

@@ -14,9 +14,9 @@ MoCo 是 Inst Disc 的改进工作,那我们自然要先看一下 Inst Disc

|

||||

|

||||

## 3.NCEloss 负样本分类不合理的问题

|

||||

|

||||

NCE 把<strong>所有负样本都视作一样的</strong>,但实际上负样本<strong>并不能被完全归为一类</strong>

|

||||

NCE 把**所有负样本都视作一样的**,但实际上负样本**并不能被完全归为一类**

|

||||

|

||||

举个例子:我现在的正样本是<strong>猫猫</strong>,然后有两个负样本是<strong>狗勾</strong>和<strong>汽车</strong>,那<strong>猫猫</strong>肯定跟<strong>狗勾</strong>更相近,跟<strong>汽车</strong>更不相似,也就是说<strong>狗</strong>的得分虽然低于<strong>猫</strong>,但是一定要高于<strong>汽车</strong>,<strong>而不是像 NCE 那样把狗和车打成一类</strong>,这样不利于模型学习。

|

||||

举个例子:我现在的正样本是**猫猫**,然后有两个负样本是**狗勾**和**汽车**,那**猫猫**肯定跟**狗勾**更相近,跟**汽车**更不相似,也就是说**狗**的得分虽然低于**猫**,但是一定要高于**汽车**,**而不是像 NCE 那样把狗和车打成一类**,这样不利于模型学习。

|

||||

|

||||

并且它也不是很灵活,下文细讲

|

||||

|

||||

@@ -34,7 +34,7 @@ NCE 把<strong>所有负样本都视作一样的</strong>,但实际上负样

|

||||

|

||||

## 2.针对动量更新不能完全解决特征一致性差的问题

|

||||

|

||||

作者提出了一个新的<strong>动量编码器</strong>来替代动量更新。

|

||||

作者提出了一个新的**动量编码器**来替代动量更新。

|

||||

|

||||

动量编码器是独立于原编码器的一个编码器,它的参数是根据原编码器动量更新的,k 和 q 就是指代全部参数了

|

||||

|

||||

@@ -52,9 +52,9 @@ NCE 把<strong>所有负样本都视作一样的</strong>,但实际上负样

|

||||

|

||||

q·k 其实就是各个特征(因为那时候用的都是 transformer 了,这里就是 trnasformer 里的 k 和 q)

|

||||

|

||||

这里分母级数上的<strong>k 是代表负样本的个数,也就是 k=batchsize-1(总样本-正样本)</strong>。其实就是<strong>对一个 batch 做 k+1 分类</strong>,并且引入了一个<strong>超参数 T</strong>。它的名字叫做<strong>温度参数</strong>,控制的是 softmax 后得分分布的平滑程度(直观理解,不是很严谨)

|

||||

这里分母级数上的**k 是代表负样本的个数,也就是 k=batchsize-1(总样本-正样本)**。其实就是**对一个 batch 做 k+1 分类**,并且引入了一个**超参数 T**。它的名字叫做**温度参数**,控制的是 softmax 后得分分布的平滑程度(直观理解,不是很严谨)

|

||||

|

||||

T 越大,损失函数就越对所有负样本<strong>一视同仁</strong>,退化为二分类的 NCEloss;T 越小,损失函数就<strong>越关注一些难分类的特征</strong>,但有时候会出现两张其实都是猫猫的图片,你硬要让模型说猫猫跟猫猫不一样,这也不太好,这个参数要根据数据集情况适中调整。

|

||||

T 越大,损失函数就越对所有负样本**一视同仁**,退化为二分类的 NCEloss;T 越小,损失函数就**越关注一些难分类的特征**,但有时候会出现两张其实都是猫猫的图片,你硬要让模型说猫猫跟猫猫不一样,这也不太好,这个参数要根据数据集情况适中调整。

|

||||

|

||||

|

||||

|

||||

|

||||

@@ -8,9 +8,9 @@ x 是输入的图片,它经过两种不同的数据增强得到 xi 和 xj 两

|

||||

|

||||

|

||||

|

||||

左右的<strong>f 都是编码器</strong>,并且是<strong>完全一致共享权重</strong>的,可以说是同一个。

|

||||

左右的**f 都是编码器**,并且是**完全一致共享权重**的,可以说是同一个。

|

||||

|

||||

而 g 是一层 mlp 结构,只在训练中使用,<strong>应用到下游任务时用的仅仅是 f</strong>(与前面几篇一样都是 RES50),很神奇的是,就仅仅多了这么一层 mlp,它在 imagenet 上的正确率直接加了十个点。

|

||||

而 g 是一层 mlp 结构,只在训练中使用,**应用到下游任务时用的仅仅是 f**(与前面几篇一样都是 RES50),很神奇的是,就仅仅多了这么一层 mlp,它在 imagenet 上的正确率直接加了十个点。

|

||||

|

||||

关于这点也很奇怪,作者做了很多实验但是也没有很合理的解释。

|

||||

|

||||

|

||||

@@ -2,7 +2,7 @@

|

||||

|

||||

# 前言

|

||||

|

||||

与前面的一些工作不同,SwAV<strong>不再进行个体判别任务</strong>,而是提出了新的任务————<strong>聚类</strong>

|

||||

与前面的一些工作不同,SwAV**不再进行个体判别任务**,而是提出了新的任务————**聚类**

|

||||

|

||||

并在训练的模型结构上也做了相应改动,而非只调整训练方法。

|

||||

|

||||

@@ -26,17 +26,17 @@

|

||||

|

||||

## 聚类中心?

|

||||

|

||||

首先我们有个新的东西<strong>prototypes</strong>,它是<strong>聚类中心的集合</strong>,也就是许多作为聚类中心的向量构成的矩阵。

|

||||

首先我们有个新的东西**prototypes**,它是**聚类中心的集合**,也就是许多作为聚类中心的向量构成的矩阵。

|

||||

|

||||

这些聚类中心是我设定在超球面上的,离散的一些点,我希望让不同的特征向它们靠拢以进行区分(也就是所谓聚类)。

|

||||

|

||||

更直白地讲,我在地上撒了一把面包屑,地上本来散乱的蚂蚁会向面包屑聚集,形成一个个<strong>小团体</strong>。蚂蚁就是<strong>不同图像的特征</strong>,面包屑就是<strong>我设定的聚类中心</strong>

|

||||

更直白地讲,我在地上撒了一把面包屑,地上本来散乱的蚂蚁会向面包屑聚集,形成一个个**小团体**。蚂蚁就是**不同图像的特征**,面包屑就是**我设定的聚类中心**

|

||||

|

||||

## 聚类中心我知道了,然后呢?

|

||||

|

||||

先说我拿他干了什么,再一步步讲为什么要这么做吧。

|

||||

|

||||

首先我们手里有抽取出来的特征<strong>z1</strong>,<strong>z2</strong>,以及一个我随机初始化的<strong>聚类中心矩阵 c</strong>。我分别求这个<strong>矩阵</strong>和<strong>z1</strong>,<strong>z2</strong>的内积,并<strong>进行一些变换</strong>得到 Q1,Q2。当 z1,z2 都是正样本时,我希望<strong>Q1 与 z2 相近</strong>,<strong>Q2 与 z1 相近</strong>。如果有一个是负样本则尽可能远离。也就是拿 Q 当 ground-truth 做训练。最后这步前面已经讲过 NCEloss 等损失函数了,用它们就可以达成这个任务。

|

||||

首先我们手里有抽取出来的特征**z1**,**z2**,以及一个我随机初始化的**聚类中心矩阵 c**。我分别求这个**矩阵**和**z1**,**z2**的内积,并**进行一些变换**得到 Q1,Q2。当 z1,z2 都是正样本时,我希望**Q1 与 z2 相近**,**Q2 与 z1 相近**。如果有一个是负样本则尽可能远离。也就是拿 Q 当 ground-truth 做训练。最后这步前面已经讲过 NCEloss 等损失函数了,用它们就可以达成这个任务。

|

||||

|

||||

而我们的优化要采用 [K-means](https://zhuanlan.zhihu.com/p/78798251)(不懂可以看这里)的类似做法,先对聚类中心进行优化,再对特征进行优化。

|

||||

|

||||

@@ -46,13 +46,13 @@ so,why?相信你现在肯定是一脸懵,不过别急,希望我能为你

|

||||

|

||||

## 首先是第一步,为什么要求内积?

|

||||

|

||||

如果你有好好了解线性代数的几何性质,应当了解<strong>两个向量的内积就是一个向量在另一个向量上的投影</strong>,而一个向量与一个矩阵的内积,<strong>就是把这个向量投影到这个矩阵代表的基空间中</strong>。

|

||||

如果你有好好了解线性代数的几何性质,应当了解**两个向量的内积就是一个向量在另一个向量上的投影**,而一个向量与一个矩阵的内积,**就是把这个向量投影到这个矩阵代表的基空间中**。

|

||||

|

||||

我做的第一步就是把<strong>抽出来的特征 z 用聚类中心的向量表示,这样更加方便对比聚类成功与否</strong>。

|

||||

我做的第一步就是把**抽出来的特征 z 用聚类中心的向量表示,这样更加方便对比聚类成功与否**。

|

||||

|

||||

## 然后是第二步,我说的变换是什么呢?

|

||||

|

||||

我们现在求内积是为了把特征投影到聚类中心空间,为了避免模型训练坍塌(就是网络把特征全部聚到同一个点,<del>开摆~</del>)我要保证每个聚类中心被<strong>"使用"</strong>的次数,所以我们请出了<strong>Sinkhorn-Knopp 算法。</strong>这个算法比较硬核,我在这里不展开了,大家知道它是干啥的就行,具体的推导可以看我后面贴的视频,那里面有讲。

|

||||

我们现在求内积是为了把特征投影到聚类中心空间,为了避免模型训练坍塌(就是网络把特征全部聚到同一个点,<del>开摆~</del>)我要保证每个聚类中心被**"使用"**的次数,所以我们请出了**Sinkhorn-Knopp 算法。**这个算法比较硬核,我在这里不展开了,大家知道它是干啥的就行,具体的推导可以看我后面贴的视频,那里面有讲。

|

||||

|

||||

## 第三步应该不用怎么讲了吧?

|

||||

|

||||

@@ -64,7 +64,7 @@ so,why?相信你现在肯定是一脸懵,不过别急,希望我能为你

|

||||

|

||||

# 总结

|

||||

|

||||

主要贡献是上面我说的三步聚类算法以及后面的小 trick,<strong>Sinkhorn-Knopp 算法难度较高,大家有兴趣的话自行观看后面这个视频理解哈~</strong>

|

||||

主要贡献是上面我说的三步聚类算法以及后面的小 trick,**Sinkhorn-Knopp 算法难度较高,大家有兴趣的话自行观看后面这个视频理解哈~**

|

||||

|

||||

# 相关资料

|

||||

|

||||

|

||||

@@ -2,25 +2,25 @@

|

||||

|

||||

# 前言

|

||||

|

||||

这篇论文的主要特点是<strong>它的训练不需要负样本</strong>,并且能保证<strong>模型不坍塌</strong>。

|

||||

这篇论文的主要特点是**它的训练不需要负样本**,并且能保证**模型不坍塌**。

|

||||

|

||||

当一个普通的对比学习模型没有负样本时,它的损失函数就<strong>只有正样本之间的差距</strong>,这样模型只会学到一个<strong>捷径解</strong>————你给我什么输入我都输出同一个值,这样 loss 就永远=0 了(<del>开摆</del>)

|

||||

当一个普通的对比学习模型没有负样本时,它的损失函数就**只有正样本之间的差距**,这样模型只会学到一个**捷径解**————你给我什么输入我都输出同一个值,这样 loss 就永远=0 了(~~开摆~~)

|

||||

|

||||

而<strong>BYOL</strong>就解决了这一问题,使得训练不再需要负样本。

|

||||

而**BYOL**就解决了这一问题,使得训练不再需要负样本。

|

||||

|

||||

# 模型结构

|

||||

|

||||

前半部分很普通,跟 SimCLR 是基本一致的,一个图片经过两种不同的数据增强,进入两个编码器,得到两个不同的特征。

|

||||

|

||||

值得一提的是,这里下面的这个粉色的编码器用的是<strong>动量编码器</strong>的更新方式。也就是说它是紫色那个编码器的动量编码器。

|

||||

值得一提的是,这里下面的这个粉色的编码器用的是**动量编码器**的更新方式。也就是说它是紫色那个编码器的动量编码器。

|

||||

|

||||

而提取特征之后,经过两个 `SimCLR` 中提出的额外的 mlp 层 z,在此之后,它们给紫色的那支加了一个新的模块,<strong>predictor</strong>。

|

||||

而提取特征之后,经过两个 `SimCLR` 中提出的额外的 mlp 层 z,在此之后,它们给紫色的那支加了一个新的模块,**predictor**。

|

||||

|

||||

<strong>predictor</strong>的模型结构就是跟 z 一样的<strong>mlp 层</strong>。它的任务是<strong>通过紫色的特征去预测粉色的特征</strong>。也就是说它的代理任务换成了<strong>生成式</strong>。

|

||||

**predictor**的模型结构就是跟 z 一样的**mlp 层**。它的任务是**通过紫色的特征去预测粉色的特征**。也就是说它的代理任务换成了**生成式**。

|

||||

|

||||

|

||||

|

||||

而具体的损失只有预测特征和真实特征的损失,用的是<strong>MSEloss</strong>。

|

||||

而具体的损失只有预测特征和真实特征的损失,用的是**MSEloss**。

|

||||

|

||||

下面的粉色分支最后一步是不进行梯度回传的。它的更新完全依赖紫色的那个编码器。

|

||||

|

||||

@@ -42,29 +42,29 @@ BN 根据批次的均值和方差进行归一化

|

||||

|

||||

推理时,均值、方差是基于所有批次的期望计算所得。

|

||||

|

||||

因此,博客作者认为,虽然我们只用了正样本进行训练,但是这个正样本包含了<strong>本批次所有样本的信息</strong>(均值,方差),所以<strong>实际上并不是真正的无负样本。</strong>

|

||||

因此,博客作者认为,虽然我们只用了正样本进行训练,但是这个正样本包含了**本批次所有样本的信息**(均值,方差),所以**实际上并不是真正的无负样本。**

|

||||

|

||||

而这个 batch 的均值,即平均图片,可以看作 `SawAV` 里的聚类中心,是所有历史样本的聚类中心。(<del>很玄学</del>)

|

||||

|

||||

### 作者看到这个博客就急了

|

||||

|

||||

如果真是这样的话,<strong>BYOL 就还是没有逃脱出对比学习的范畴</strong>,它还是找了一个东西去做对比,其创新性就大大降低了。所以作者赶紧做实验,看看能不能找到 BYOL 模型不坍塌的另外一种解释。最终又写了一篇论文进行回应。

|

||||

如果真是这样的话,**BYOL 就还是没有逃脱出对比学习的范畴**,它还是找了一个东西去做对比,其创新性就大大降低了。所以作者赶紧做实验,看看能不能找到 BYOL 模型不坍塌的另外一种解释。最终又写了一篇论文进行回应。

|

||||

|

||||

这篇论文叫 BYOL works even without batch statistics,即在没有 BN 的时候 BYOL 照样能工作,详细的消融实验结果如下表所示 :

|

||||

|

||||

|

||||

|

||||

<strong>BN 非常关键</strong>:只要是 `projector`(SimCLR 提出的 mlp)中没有 BN 的地方,SimCLR 性稍微下降;但是 BYOL 全都模型坍塌了。

|

||||

**BN 非常关键**:只要是 `projector`(SimCLR 提出的 mlp)中没有 BN 的地方,SimCLR 性稍微下降;但是 BYOL 全都模型坍塌了。

|

||||

|

||||

<strong>有 BN 也会坍塌</strong>:作者找到了特例(红色框),即使当 `projector` 有 BN 的时候,BYOL 还是训练失败了 。如果 BN 真的很关键,它真的提供了隐式负样本的对比学习的话,训练就不应该失败

|

||||

**有 BN 也会坍塌**:作者找到了特例(红色框),即使当 `projector` 有 BN 的时候,BYOL 还是训练失败了 。如果 BN 真的很关键,它真的提供了隐式负样本的对比学习的话,训练就不应该失败

|

||||

|

||||

<strong>完全没有 BN,SimCLR 也坍塌</strong>(最后三列的结果。要注意 SimCLR 只有一层 projector)。这表明完全不用归一化,SimCLR 这种使用负样本进行对比学习的方式也无法训练。

|

||||

**完全没有 BN,SimCLR 也坍塌**(最后三列的结果。要注意 SimCLR 只有一层 projector)。这表明完全不用归一化,SimCLR 这种使用负样本进行对比学习的方式也无法训练。

|

||||

|

||||

最终结论:BN 跟它原来的设计初衷一样,主要作用就是提高模型训练时的稳定性,从而不会导致模型坍塌 。作者进一步延伸,如果一开始就能让模型初始化的比较好,后面的训练即使离开了 BN 也没有问题。

|

||||

|

||||

作者为此又设计了一个实验,使用 `group norm`+`weight standardization` (前者也是一种归一化方式,后者是一种卷积权重标准化方式,但都没有对 batch 中的数据进行融合),BYOL 的 top-准确率可以达到 74.1%,和原来精度可以认为是一样了(74.3%)。

|

||||

|

||||

<strong>至今其实这个问题也没有一个很合理能服众的解释。</strong>

|

||||

**至今其实这个问题也没有一个很合理能服众的解释。**

|

||||

|

||||

# 总结

|

||||

|

||||

|

||||

@@ -30,13 +30,13 @@ BYOL 之后,大家都发现对比学习是靠许许多多的小 trick 和技

|

||||

|

||||

原论文中提出的解释并不是最完美的。而且这个问题的解释涉及了动力学等知识,我也没有足够的知识储备去讲解这个问题,这里只能讲一些与解答相关的信息,如果有兴趣可以看下面链接中的解释:

|

||||

|

||||

这里要涉及到一个机器学习的经典算法,<strong>EM 算法</strong>,它也是<strong>k-means</strong>的核心思想之一。

|

||||

这里要涉及到一个机器学习的经典算法,**EM 算法**,它也是**k-means**的核心思想之一。

|

||||

|

||||

因为本文的主旨原因,我不会在这里细讲这个算法,但是大家了解这是个什么东西即可。

|

||||

|

||||

<strong>EM 算法</strong>用于优化带有未知参数的模型,`k-means` 的聚类中心就可以看作一个未知参数,我们要同时优化模型本体和聚类中心。所以我们先对其中一个目标 A 做<strong>随机初始化</strong>,然后<strong>先优化</strong>另一个目标 B,再反过来用另一个目标 B 优化后<strong>的结果优化被随机初始化的目标 A</strong>,这就是一次迭代,只要不断循环这个迭代,EM 算法往往能找到最优解。

|

||||

**EM 算法**用于优化带有未知参数的模型,`k-means` 的聚类中心就可以看作一个未知参数,我们要同时优化模型本体和聚类中心。所以我们先对其中一个目标 A 做**随机初始化**,然后**先优化**另一个目标 B,再反过来用另一个目标 B 优化后**的结果优化被随机初始化的目标 A**,这就是一次迭代,只要不断循环这个迭代,EM 算法往往能找到最优解。

|

||||

|

||||

这里可以把<strong>经过 predictor 预测头的特征</strong>作为 `k-means` 里的特征,而另一个作为<strong>目标的特征</strong>作为<strong>聚类中心</strong>,经过预测头的特征直接反向传播进行优化,作为目标的特征则是通过上面说的对称的操作经过预测头进行优化。

|

||||

这里可以把**经过 predictor 预测头的特征**作为 `k-means` 里的特征,而另一个作为**目标的特征**作为**聚类中心**,经过预测头的特征直接反向传播进行优化,作为目标的特征则是通过上面说的对称的操作经过预测头进行优化。

|

||||

|

||||

最最直白地解读结论的话,可以说是,这种先后优化的 EM 算法,使得模型“来不及“去把权重全部更新为 0。(模型坍塌)具体的推导需要动力学的知识,这里不做展开。

|

||||

|

||||

|

||||

@@ -20,7 +20,7 @@ MoCo v3,它缝合了 MoCo 和 SimSiam,以及新的骨干网络 VIT。

|

||||

|

||||

|

||||

|

||||

在使用 VIT 训练的时候,batchsize 不算太大时训练很平滑,但是一旦 batchsize 变大,训练的图像就会出现如上图这样的<strong>波动</strong>。于是作者去查看了每一层的梯度,发现问题出在<strong>VIT 的第一层线性变换</strong>上。也就是下图中的粉色那个层,<strong>把图片打成 patch 后展平做的线性变换</strong>。

|

||||

在使用 VIT 训练的时候,batchsize 不算太大时训练很平滑,但是一旦 batchsize 变大,训练的图像就会出现如上图这样的**波动**。于是作者去查看了每一层的梯度,发现问题出在**VIT 的第一层线性变换**上。也就是下图中的粉色那个层,**把图片打成 patch 后展平做的线性变换**。

|

||||

|

||||

|

||||

|

||||

|

||||

@@ -8,7 +8,7 @@

|

||||

|

||||

在周志华的机器学习一书半监督学习章节中,有对基本的图学习策略进行基本的描述,详见我为了应付课程考试整理的[图半监督学习](http://blog.cyasylum.top/index.php/2020/07/05/%E5%9B%BE%E5%8D%8A%E7%9B%91%E7%9D%A3%E5%AD%A6%E4%B9%A0/)。其基本思路是这样的,通过”样本距离度量“刻画获取样本之间的联系,将样本嵌入到“图”,即样本即其关系的集合中。后通过图将半监督学习中有标记样本的标签对未标记样本进行传递,从而获取未标记样本的属性,进行学习。

|

||||

|

||||

如此,便定下来图网络的基本思路,即通过<em>信息在图上的传递</em>,迭代学习知识。有了这样的基础,我们便可以开始对图网络进行讨论了。

|

||||

如此,便定下来图网络的基本思路,即通过*信息在图上的传递*,迭代学习知识。有了这样的基础,我们便可以开始对图网络进行讨论了。

|

||||

|

||||

接下来,我们从最基础的部分来讲讲,信息是如何在图上进行传播的。

|

||||

|

||||

@@ -55,7 +55,7 @@ $$

|

||||

|

||||

现在,我们可以尝试用$\mathbf{L}$对图进行表示了。

|

||||

|

||||

另外还有个<em>随机游走归一化拉普拉斯矩阵</em>

|

||||

另外还有个*随机游走归一化拉普拉斯矩阵*

|

||||

$$

|

||||

\mathbf{L}^{sym}=\mathbf{D}^{-1}\mathbf{L}=\mathbf{I}-\mathbf{D}^{-1}\mathbf{A}

|

||||

$$

|

||||

|

||||

@@ -212,7 +212,7 @@ The End~~~~~~~~~~

|

||||

|

||||

## 补充内容:下个定义

|

||||

|

||||

数据分析是独立于开发和算法岗的另一个方向,它主要是通过<strong>应用</strong>机器学习和深度学习的<strong>已有算法</strong>来分析现实问题的一个方向

|

||||

数据分析是独立于开发和算法岗的另一个方向,它主要是通过**应用**机器学习和深度学习的**已有算法**来分析现实问题的一个方向

|

||||

|

||||

我们常说:数据是客观的,但是解读数据的人是主观的。

|

||||

|

||||

|

||||

@@ -11,17 +11,17 @@ Email: yqykrhf@163.com

|

||||

|

||||

## 术语的介绍

|

||||

|

||||

<strong>Benchmark:</strong>评测的基准。通常会是一些公开的数据集。

|

||||

**Benchmark:**评测的基准。通常会是一些公开的数据集。

|

||||

|

||||

<strong>Baseline:</strong> 基准,一般指的是一个现有的工作。

|

||||

**Baseline:** 基准,一般指的是一个现有的工作。

|

||||

|

||||