2.2 KiB

2.2 KiB

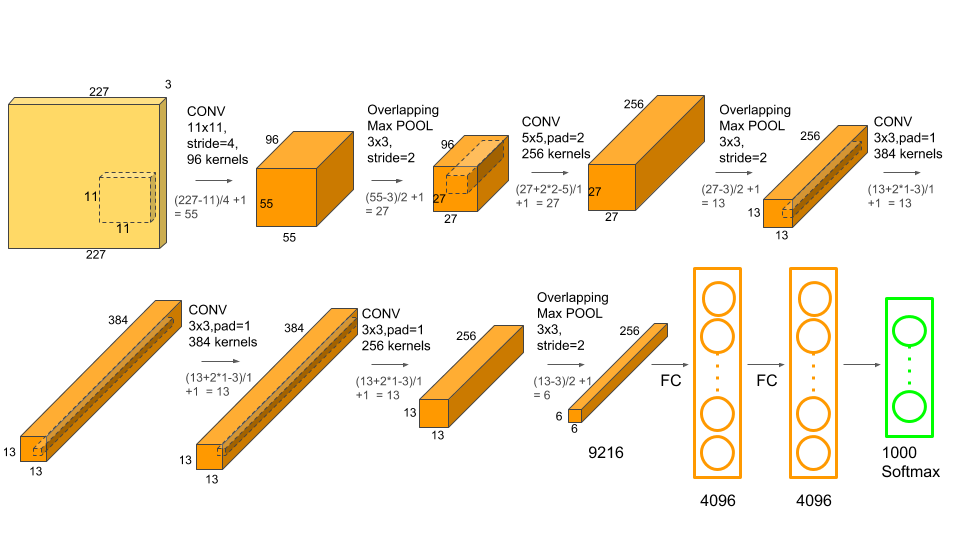

AlexNet

所谓“深度”学习的开山之作。

AlexNet 有 6 千万个参数和 650,000 个神经元。

虽然一些理念和方式已经略有过时,但仍然是入门非常有必要读的一篇论文

网络框架图

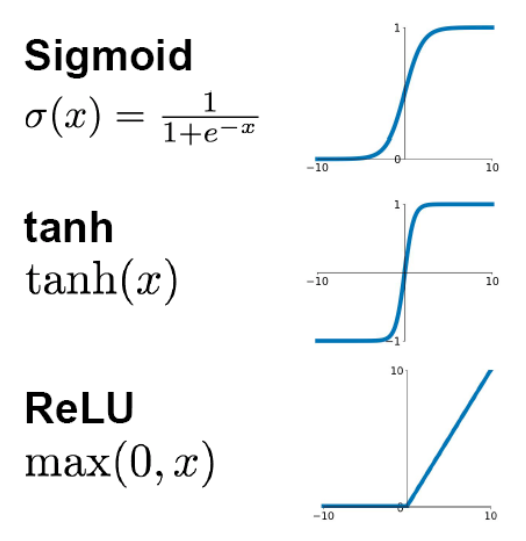

使用 ReLU 激活函数代替 tanh

在当时,标准的神经元激活函数是 tanh()函数,这种饱和的非线性函数在梯度下降的时候要比非饱和的非线性函数慢得多,因此,在 AlexNet 中使用 ReLU 函数作为激活函数。

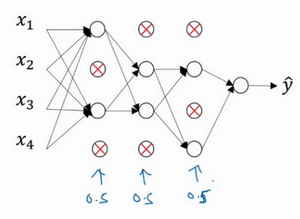

采用 Dropout 防止过拟合

dropout 方法会遍历网络的每一层,并设置消除神经网络中节点的概率。假设网络中的每一层,每个节点都以抛硬币的方式设置概率,每个节点得以保留和消除的概率都是 0.5,设置完节点概率,我们会消除一些节点,然后删除掉从该节点进出的连线,最后得到一个节点更少,规模更小的网络(如下图所示),然后再用反向传播方法进行训练。

视频讲解

思考

思考 1

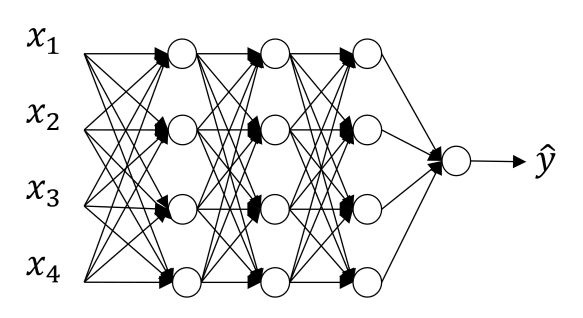

AlexNet 中有着卷积和 MLP 两种不同的网络结构,那两者之间有着何种区别和联系呢?(可以从两者的权值矩阵去思考)

思考 2

卷积中有一个叫感受野的概念,是什么意思呢?不同的感受野对网络有什么影响?

思考 3

CNN 的平移不变性是什么意思?

思考 4

分成两块来训练是一个历史遗留问题,后面接线性层也是历史问题,可以思考一下为什么并且你会在下一章中得到一定的答案。

思考 5

这里面提出了 relu 激活函数,你在这章知道 relu 是怎么样的函数,那么它是怎么样实现线性与非线性的转化呢

思考 6

前面学习中你已经掌握了卷积,那卷积是怎样实现特征提取的呢。