diff --git a/.vitepress/config.js b/.vitepress/config.js

index 140610e..7572a1b 100644

--- a/.vitepress/config.js

+++ b/.vitepress/config.js

@@ -394,7 +394,7 @@ export default defineConfig({

{ text: '4.6.6.2.3序列化推荐', link: '/4.人工智能/4.6.6.2.3序列化推荐' },

]

},

- { text: '4.6.6.3知识图谱', link: '/4.人工智能/4.6.6.3知识图谱' }

+ { text: '4.6.6.3知识图谱', link: '/4.人工智能/4.6.6.3知识图谱' },

]

},

{

@@ -441,6 +441,114 @@ export default defineConfig({

{ text: '4.10科研论文写作', link: '/4.人工智能/4.10科研论文写作' },

{ text: '4.11从 AI 到 智能系统 —— 从 LLMs 到 Agents', link: '/4.人工智能/4.11从 AI 到 智能系统 —— 从 LLMs 到 Agents' },

{ text: '4.12本章节内容的局限性', link: '/4.人工智能/4.12本章节内容的局限性' },

+ {

+ text: 'FunRec',

+ collapsed: true,

+ items: [

+ { text: 'FunRec概述', link: '/4.人工智能/FunRec概述' },

+ {

+ text: '推荐系统概述',

+ collapsed: true,

+ items: [

+ { text: '推荐系统的意义', link: '/4.人工智能/ch01/ch1.1.md' },

+ { text: '推荐系统架构', link: '/4.人工智能/ch01/ch1.2.md' },

+ { text: '推荐系统技术栈', link: '/4.人工智能/ch01/ch1.3.md' },

+ ]

+ },

+ {

+ text: '推荐系统算法基础',

+ collapsed: true,

+ items: [

+ {

+ text: '经典召回模型',

+ collapsed: true,

+ items: [

+ {

+ text: '基于协同过滤的召回', collapsed: true, items: [

+ { text: 'UserCF', link: '/4.人工智能/ch02/ch2.1/ch2.1.1/usercf.md' },

+ { text: 'ItemCF', link: '/4.人工智能/ch02/ch2.1/ch2.1.1/itemcf.md' },

+ { text: 'Swing', link: '/4.人工智能/ch02/ch2.1/ch2.1.1/Swing.md' },

+ { text: '矩阵分解', link: '/4.人工智能/ch02/ch2.1/ch2.1.1/mf.md' },

+ ]

+ },

+ { text: 'FM召回', link: '/4.人工智能/ch02/ch2.1/ch2.1.2/FM.md' },

+ {

+ text: 'item2vec召回系列', collapsed: true, items: [

+ { text: 'word2vec原理', link: '/4.人工智能/ch02/ch2.1/ch2.1.2/word2vec.md' },

+ { text: 'item2vec召回', link: '/4.人工智能/ch02/ch2.1/ch2.1.2/item2vec.md' },

+ { text: 'Airbnb召回', link: '/4.人工智能/ch02/ch2.1/ch2.1.2/Airbnb.md' },

+ ]

+ },

+ { text: 'YoutubeDNN召回', link: '/4.人工智能/ch02/ch2.1/ch2.1.2/YoutubeDNN.md' },

+ {

+ text: '双塔召回', collapsed: true, items: [

+ { text: '经典双塔', link: '/4.人工智能/ch02/ch2.1/ch2.1.2/DSSM.md' },

+ { text: 'Youtube双塔', link: '/4.人工智能/ch02/ch2.1/ch2.1.2/YoutubeTwoTower.md' },

+ ]

+ },

+ {

+ text: '图召回', collapsed: true, items: [

+ { text: 'EGES', link: '/4.人工智能/ch02/ch2.1/ch2.1.3/EGES.md' },

+ { text: 'PinSAGE', link: '/4.人工智能/ch02/ch2.1/ch2.1.3/PinSage.md' },

+ ]

+ },

+ {

+ text: '序列召回', collapsed: true, items: [

+ { text: 'MIND', link: '/4.人工智能/ch02/ch2.1/ch2.1.4/MIND.md' },

+ { text: 'SDM', link: '/4.人工智能/ch02/ch2.1/ch2.1.4/SDM.md' },

+ ]

+ },

+ {

+ text: '树模型召回', collapsed: true, items: [

+ { text: 'TDM', link: '/4.人工智能/ch02/ch2.1/ch2.1.5/TDM.md' },

+ ]

+ }

+ ]

+ },

+ {

+ text: '经典排序模型',

+ collapsed: true,

+ items: [

+ { text: 'GBDT+LR', link: '/4.人工智能/ch02/ch2.2/ch2.2.1.md' },

+ {

+ text: '特征交叉', collapsed: true, items: [

+ { text: 'FM', link: '/4.人工智能/ch02/ch2.2/ch2.2.2/FM.md' },

+ { text: 'PNN', link: '/4.人工智能/ch02/ch2.2/ch2.2.2/PNN.md' },

+ { text: 'DCN', link: '/4.人工智能/ch02/ch2.2/ch2.2.2/DCN.md' },

+ { text: 'AutoInt', link: '/4.人工智能/ch02/ch2.2/ch2.2.2/AutoInt.md' },

+ { text: 'FiBiNET', link: '/4.人工智能/ch02/ch2.2/ch2.2.2/FiBiNet.md' },

+ ]

+ },

+ {

+ text: 'WideNDeep系列', collapsed: true, items: [

+ { text: 'Wide&Deep', link: '/4.人工智能/ch02/ch2.2/ch2.2.3/WideNDeep.md' },

+ { text: 'NFM', link: '/4.人工智能/ch02/ch2.2/ch2.2.3/NFM.md' },

+ { text: 'AFM', link: '/4.人工智能/ch02/ch2.2/ch2.2.3/AFM.md' },

+ { text: 'DeepFM', link: '/4.人工智能/ch02/ch2.2/ch2.2.3/DeepFM.md' },

+ { text: 'xDeepFM', link: '/4.人工智能/ch02/ch2.2/ch2.2.3/xDeepFM.md' },

+ ]

+ },

+ {

+ text: '序列模型', collapsed: true, items: [

+ { text: 'DIN', link: '/4.人工智能/ch02/ch2.2/ch2.2.4/DIN.md' },

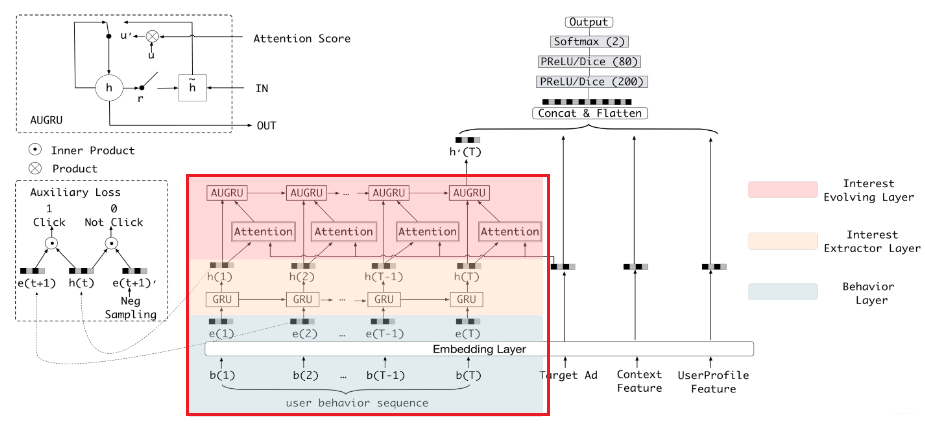

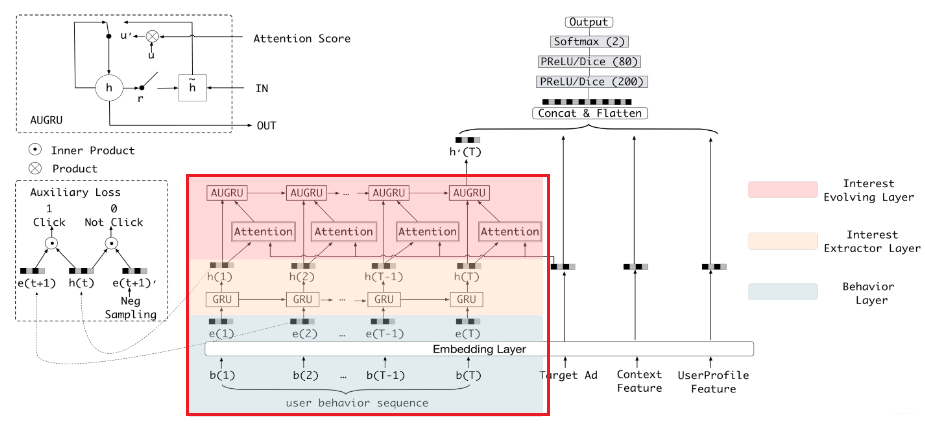

+ { text: 'DIEN', link: '/4.人工智能/ch02/ch2.2/ch2.2.4/DIEN.md' },

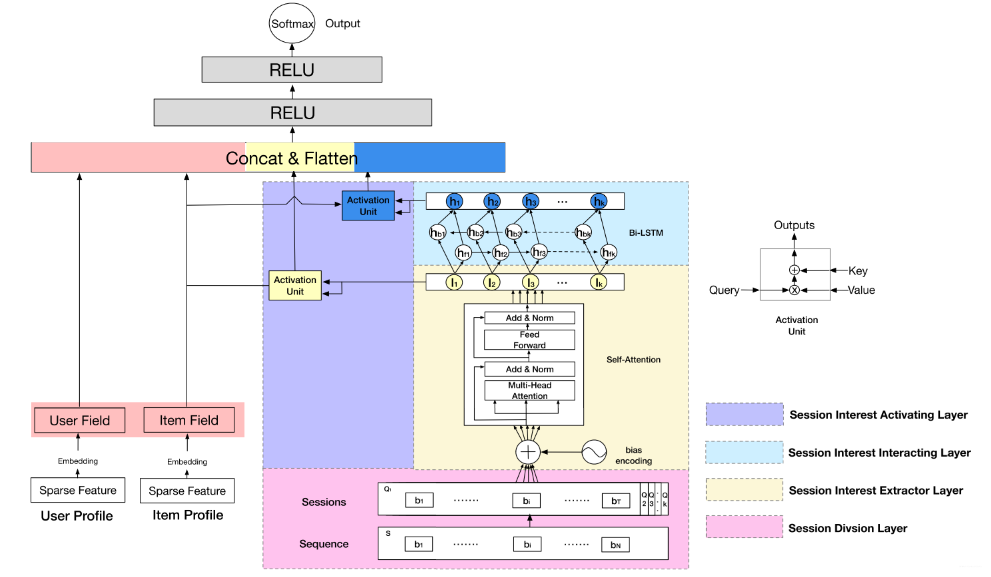

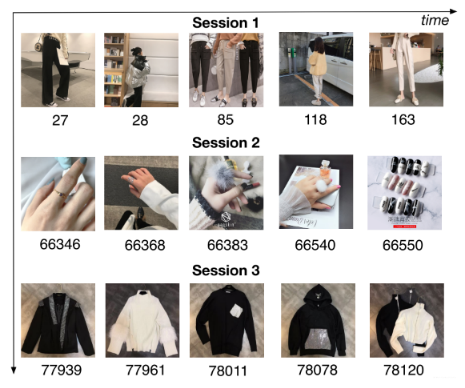

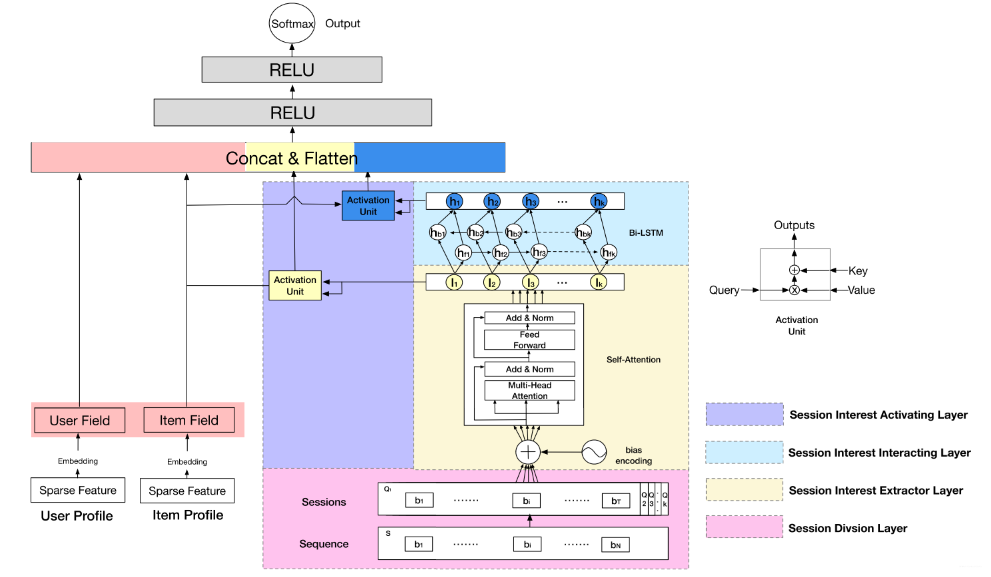

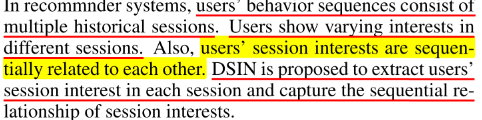

+ { text: 'DSIN', link: '/4.人工智能/ch02/ch2.2/ch2.2.4/DSIN.md' },

+ ]

+ },

+ {

+ text: '多任务学习', collapsed: true, items: [

+ { text: '多任务学习概述', link: '/4.人工智能/ch02/ch2.2/ch2.2.5/2.2.5.0.md' },

+ { text: 'ESMM', link: '/4.人工智能/ch02/ch2.2/ch2.2.5/ESMM.md' },

+ { text: 'MMOE', link: '/4.人工智能/ch02/ch2.2/ch2.2.5/MMOE.md' },

+ { text: 'PLE', link: '/4.人工智能/ch02/ch2.2/ch2.2.5/PLE.md' },

+ ]

+ }

+ ]

+ }

+ ]

+ }

+ ]

+ }

]

},

{

diff --git a/4.人工智能/FunRec概述.md b/4.人工智能/FunRec概述.md

new file mode 100644

index 0000000..52819b2

--- /dev/null

+++ b/4.人工智能/FunRec概述.md

@@ -0,0 +1,16 @@

+# FunRec概述

+

+本教程主要是针对具有机器学习基础并想找推荐算法岗位的同学。教程内容由推荐系统概述、推荐算法基础、推荐系统实战和推荐系统面经四个部分组成。本教程对于入门推荐算法的同学来说,可以从推荐算法的基础到实战再到面试,形成一个闭环。每个部分的详细内容如下:

+

+- **推荐系统概述。** 这部分内容会从推荐系统的意义及应用,到架构及相关的技术栈做一个概述性的总结,目的是为了让初学者更加了解推荐系统。

+- **推荐系统算法基础。** 这部分会介绍推荐系统中对于算法工程师来说基础并且重要的相关算法,如经典的召回、排序算法。随着项目的迭代,后续还会不断的总结其他的关键算法和技术,如重排、冷启动等。

+- **推荐系统实战。** 这部分内容包含推荐系统竞赛实战和新闻推荐系统的实践。其中推荐系统竞赛实战是结合阿里天池上的新闻推荐入门赛做的相关内容。新闻推荐系统实践是实现一个具有前后端交互及整个推荐链路的项目,该项目是一个新闻推荐系统的demo没有实际的商业化价值。

+- **推荐系统算法面经。** 这里会将推荐算法工程师面试过程中常考的一些基础知识、热门技术等面经进行整理,方便同学在有了一定推荐算法基础之后去面试,因为对于初学者来说只有在公司实习学到的东西才是最有价值的。

+

+**特别说明**:项目内容是由一群热爱分享的同学一起花时间整理而成,**大家的水平都非常有限,内容难免存在一些错误和问题,如果学习者发现问题,也欢迎及时反馈,避免让后学者踩坑!** 如果对该项目有改进或者优化的建议,还希望通过下面的二维码找到项目负责人或者在交流社区中提出,我们会参考大家的意见进一步对该项目进行修改和调整!如果想对该项目做一些贡献,也可以通过上述同样的方法找到我们!

+

+为了方便学习和交流,**我们建立了FunRec学习社区(微信群+知识星球)**,微信群方便大家平时日常交流和讨论,知识星球方便沉淀内容。由于我们的内容面向的人群主要是学生,所以**知识星球永久免费**,感兴趣的可以加入星球讨论(加入星球的同学先看置定的必读帖)!**FunRec学习社区内部会不定期分享(FunRec社区中爱分享的同学)技术总结、个人管理等内容,[跟技术相关的分享内容都放在了B站](https://space.bilibili.com/431850986/channel/collectiondetail?sid=339597)上面**。由于微信群的二维码只有7天内有效,所以直接加下面这个微信,备注:**Fun-Rec**,会被拉到Fun-Rec交流群,如果觉得微信群比较吵建议直接加知识星球!。

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+3. 根据皮尔逊相关系数, 可以找到与物品5最相似的2个物品是 item1 和 item4, 下面基于上面的公式计算最终得分:

+

+$$

+P_{Alice, 物品5}=\bar{R}_{物品5}+\frac{\sum_{k=1}^{2}\left(w_{物品5,物品 k}\left(R_{Alice, 物品k}-\bar{R}_{物品k}\right)\right)}{\sum_{k=1}^{2} w_{物品k, 物品5}} \\

+=\frac{13}{4}+\frac{0.97*(5-3.2)+0.58*(4-3.4)}{0.97+0.58}=4.6

+$$

+

+## ItemCF编程实现

+

+1. 构建物品-用户的评分矩阵

+

+ ```python

+ import numpy as np

+ import pandas as pd

+

+

+ def loadData():

+ items = {'A': {'Alice': 5.0, 'user1': 3.0, 'user2': 4.0, 'user3': 3.0, 'user4': 1.0},

+ 'B': {'Alice': 3.0, 'user1': 1.0, 'user2': 3.0, 'user3': 3.0, 'user4': 5.0},

+ 'C': {'Alice': 4.0, 'user1': 2.0, 'user2': 4.0, 'user3': 1.0, 'user4': 5.0},

+ 'D': {'Alice': 4.0, 'user1': 3.0, 'user2': 3.0, 'user3': 5.0, 'user4': 2.0},

+ 'E': {'user1': 3.0, 'user2': 5.0, 'user3': 4.0, 'user4': 1.0}

+ }

+ return items

+ ```

+

+2. 计算物品间的相似度矩阵

+

+ ```python

+ item_data = loadData()

+

+ similarity_matrix = pd.DataFrame(

+ np.identity(len(item_data)),

+ index=item_data.keys(),

+ columns=item_data.keys(),

+ )

+

+ # 遍历每条物品-用户评分数据

+ for i1, users1 in item_data.items():

+ for i2, users2 in item_data.items():

+ if i1 == i2:

+ continue

+ vec1, vec2 = [], []

+ for user, rating1 in users1.items():

+ rating2 = users2.get(user, -1)

+ if rating2 == -1:

+ continue

+ vec1.append(rating1)

+ vec2.append(rating2)

+ similarity_matrix[i1][i2] = np.corrcoef(vec1, vec2)[0][1]

+

+ print(similarity_matrix)

+ ```

+

+ ```

+ A B C D E

+ A 1.000000 -0.476731 -0.123091 0.532181 0.969458

+ B -0.476731 1.000000 0.645497 -0.310087 -0.478091

+ C -0.123091 0.645497 1.000000 -0.720577 -0.427618

+ D 0.532181 -0.310087 -0.720577 1.000000 0.581675

+ E 0.969458 -0.478091 -0.427618 0.581675 1.000000

+ ```

+

+3. 从 Alice 购买过的物品中,选出与物品 `E` 最相似的 `num` 件物品。

+

+ ```python

+ target_user = ' Alice '

+ target_item = 'E'

+ num = 2

+

+ sim_items = []

+ sim_items_list = similarity_matrix[target_item].sort_values(ascending=False).index.tolist()

+ for item in sim_items_list:

+ # 如果target_user对物品item评分过

+ if target_user in item_data[item]:

+ sim_items.append(item)

+ if len(sim_items) == num:

+ break

+ print(f'与物品{target_item}最相似的{num}个物品为:{sim_items}')

+ ```

+

+ ```

+ 与物品E最相似的2个物品为:['A', 'D']

+ ```

+

+4. 预测用户 Alice 对物品 `E` 的评分

+

+ ```python

+ target_user_mean_rating = np.mean(list(item_data[target_item].values()))

+ weighted_scores = 0.

+ corr_values_sum = 0.

+

+ target_item = 'E'

+ for item in sim_items:

+ corr_value = similarity_matrix[target_item][item]

+ user_mean_rating = np.mean(list(item_data[item].values()))

+

+ weighted_scores += corr_value * (item_data[item][target_user] - user_mean_rating)

+ corr_values_sum += corr_value

+

+ target_item_pred = target_user_mean_rating + weighted_scores / corr_values_sum

+ print(f'用户{target_user}对物品{target_item}的预测评分为:{target_item_pred}')

+ ```

+

+ ```

+ 用户 Alice 对物品E的预测评分为:4.6

+ ```

+

+# 协同过滤算法的权重改进

+

+* base 公式

+ $$

+ w_{i j}=\frac{|N(i) \bigcap N(j)|}{|N(i)|}

+ $$

+

+ + 该公式表示同时喜好物品 $i$ 和物品 $j$ 的用户数,占喜爱物品 $i$ 的比例。

+ + 缺点:若物品 $j$ 为热门物品,那么它与任何物品的相似度都很高。

+

+* 对热门物品进行惩罚

+ $$

+ w_{i j}=\frac{|N(i) \cap N(j)|}{\sqrt{|N(i)||N(j)|}}

+ $$

+

+

+ * 根据 base 公式在的问题,对物品 $j$ 进行打压。打压的出发点很简单,就是在分母再除以一个物品 $j$ 被购买的数量。

+ * 此时,若物品 $j$ 为热门物品,那么对应的 $N(j)$ 也会很大,受到的惩罚更多。

+

+* 控制对热门物品的惩罚力度

+ $$

+ w_{i j}=\frac{|N(i) \cap N(j)|}{|N(i)|^{1-\alpha}|N(j)|^{\alpha}}

+ $$

+

+ * 除了第二点提到的办法,在计算物品之间相似度时可以对热门物品进行惩罚外。

+ * 可以在此基础上,进一步引入参数 $\alpha$ ,这样可以通过控制参数 $\alpha$来决定对热门物品的惩罚力度。

+

+* 对活跃用户的惩罚

+

+ * 在计算物品之间的相似度时,可以进一步将用户的活跃度考虑进来。

+ $$

+ w_{i j}=\frac{\sum_{\operatorname{\text {u}\in N(i) \cap N(j)}} \frac{1}{\log 1+|N(u)|}}{|N(i)|^{1-\alpha}|N(j)|^{\alpha}}

+ $$

+

+ + 对于异常活跃的用户,在计算物品之间的相似度时,他的贡献应该小于非活跃用户。

+

+# 协同过滤算法的问题分析

+

+协同过滤算法存在的问题之一就是泛化能力弱:

+

++ 即协同过滤无法将两个物品相似的信息推广到其他物品的相似性上。

++ 导致的问题是**热门物品具有很强的头部效应, 容易跟大量物品产生相似, 而尾部物品由于特征向量稀疏, 导致很少被推荐**。

+

+比如下面这个例子:

+

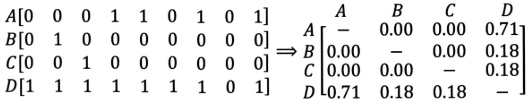

+

+

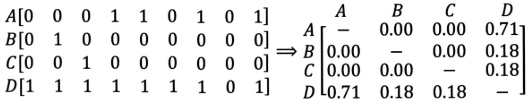

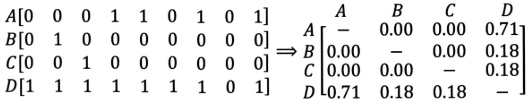

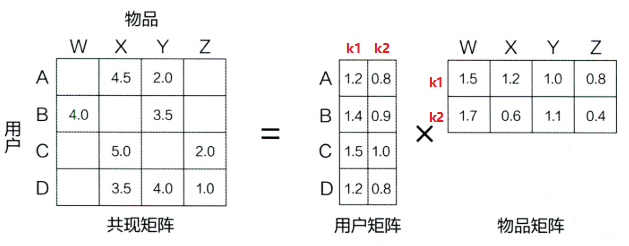

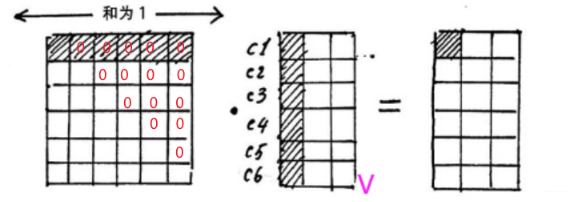

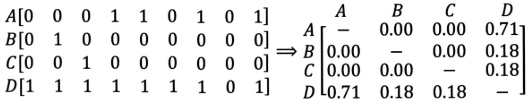

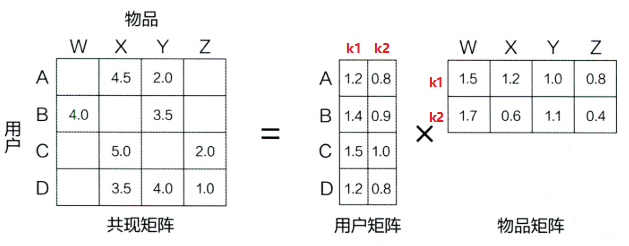

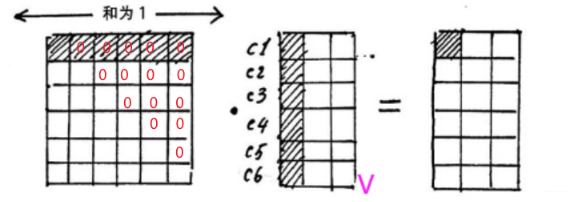

++ 左边矩阵中,$A, B, C, D$ 表示的是物品。

++ 可以看出,$D $ 是一件热门物品,其与 $A、B、C$ 的相似度比较大。因此,推荐系统更可能将 $D$ 推荐给用过 $A、B、C$ 的用户。

++ 但是,推荐系统无法找出 $A,B,C$ 之间相似性的原因是交互数据太稀疏, 缺乏相似性计算的直接数据。

+

+所以这就是协同过滤的天然缺陷:**推荐系统头部效应明显, 处理稀疏向量的能力弱**。

+

+为了解决这个问题, 同时增加模型的泛化能力。2006年,**矩阵分解技术(Matrix Factorization, MF**)被提出:

+

++ 该方法在协同过滤共现矩阵的基础上, 使用更稠密的隐向量表示用户和物品, 挖掘用户和物品的隐含兴趣和隐含特征。

++ 在一定程度上弥补协同过滤模型处理稀疏矩阵能力不足的问题。

+

+# 课后思考

+

+1. **什么时候使用UserCF,什么时候使用ItemCF?为什么?**

+

+> (1)UserCF

+>

+> + 由于是基于用户相似度进行推荐, 所以具备更强的社交特性, 这样的特点非常适于**用户少, 物品多, 时效性较强的场合**。

+>

+> + 比如新闻推荐场景, 因为新闻本身兴趣点分散, 相比用户对不同新闻的兴趣偏好, 新闻的及时性,热点性往往更加重要, 所以正好适用于发现热点,跟踪热点的趋势。

+> + 另外还具有推荐新信息的能力, 更有可能发现惊喜, 因为看的是人与人的相似性, 推出来的结果可能更有惊喜,可以发现用户潜在但自己尚未察觉的兴趣爱好。

+>

+> (2)ItemCF

+>

+> + 这个更适用于兴趣变化较为稳定的应用, 更接近于个性化的推荐, 适合**物品少,用户多,用户兴趣固定持久, 物品更新速度不是太快的场合**。

+> + 比如推荐艺术品, 音乐, 电影。

+

+

+

+2.**协同过滤在计算上有什么缺点?有什么比较好的思路可以解决(缓解)?**

+

+> 该问题答案参考上一小节的**协同过滤算法的问题分析**。

+

+

+

+**3.上面介绍的相似度计算方法有什么优劣之处?**

+

+> cosine相似度计算简单方便,一般较为常用。但是,当用户的评分数据存在 bias 时,效果往往不那么好。

+>

+> + 简而言之,就是不同用户评分的偏向不同。部分用户可能乐于给予好评,而部分用户习惯给予差评或者乱评分。

+> + 这个时候,根据cosine 相似度计算出来的推荐结果效果会打折扣。

+>

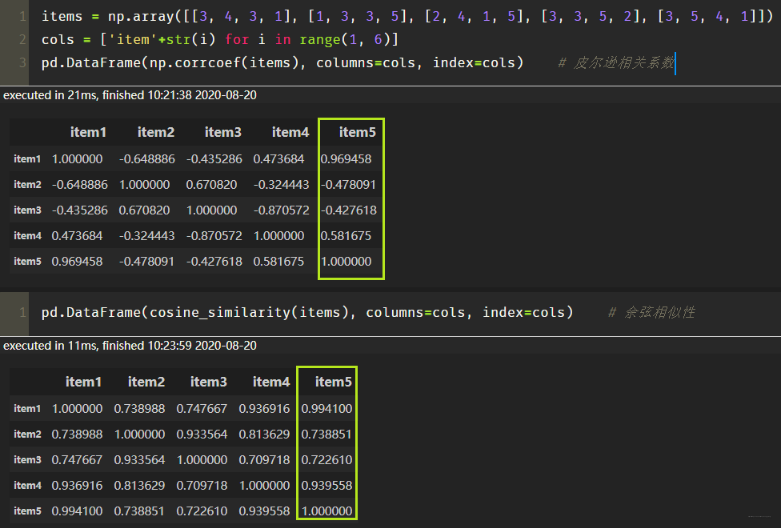

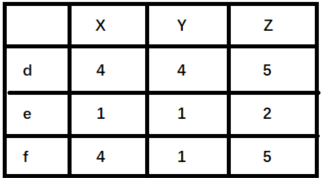

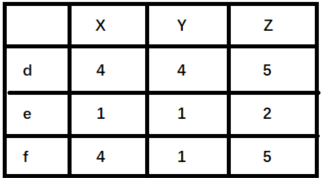

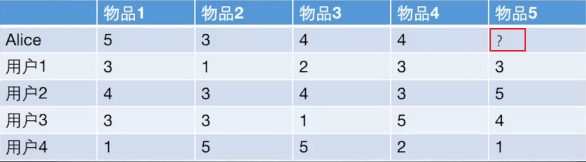

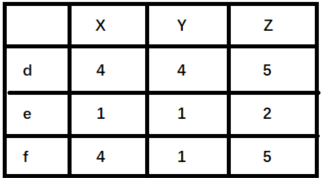

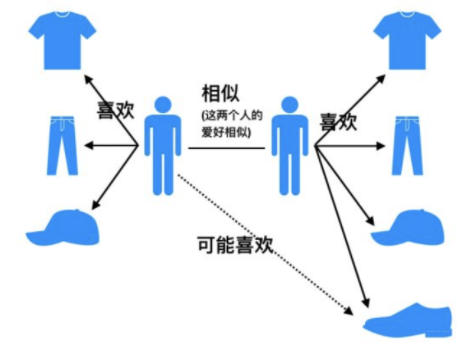

+> 举例来说明,如下图(`X,Y,Z` 表示物品,`d,e,f`表示用户):

+>

+>

+>

+> + 如果使用余弦相似度进行计算,用户 d 和 e 之间较为相似。但是实际上,用户 d 和 f 之间应该更加相似。只不过由于 d 倾向于打高分,e 倾向于打低分导致二者之间的余弦相似度更高。

+> + 这种情况下,可以考虑使用皮尔逊相关系数计算用户之间的相似性关系。

+

+

+

+4.**协同过滤还存在其他什么缺陷?有什么比较好的思路可以解决(缓解)?**

+

+> + 协同过滤的优点就是没有使用更多的用户或者物品属性信息,仅利用用户和物品之间的交互信息就能完成推荐,该算法简单高效。

+> + 但这也是协同过滤算法的一个弊端。由于未使用更丰富的用户和物品特征信息,这也导致协同过滤算法的模型表达能力有限。

+> + 对于该问题,逻辑回归模型(LR)可以更好地在推荐模型中引入更多特征信息,提高模型的表达能力。

+

+

+

+# 参考资料

+

+* [基于用户的协同过滤来构建推荐系统:https://mp.weixin.qq.com/s/ZtnaQrVIpVOPJpqMdLWOcw](https://mp.weixin.qq.com/s/ZtnaQrVIpVOPJpqMdLWOcw)

+* [协同过滤算法概述:https://chenk.tech/posts/8ad63d9d.html](https://chenk.tech/posts/8ad63d9d.html)

+* B站黑马推荐系统实战课程

+

+

+

+

+

diff --git a/4.人工智能/ch02/ch2.1/ch2.1.1/mf.md b/4.人工智能/ch02/ch2.1/ch2.1.1/mf.md

new file mode 100644

index 0000000..7065d45

--- /dev/null

+++ b/4.人工智能/ch02/ch2.1/ch2.1.1/mf.md

@@ -0,0 +1,370 @@

+# 隐语义模型与矩阵分解

+

+协同过滤算法的特点:

+

++ 协同过滤算法的特点就是完全没有利用到物品本身或者是用户自身的属性, 仅仅利用了用户与物品的交互信息就可以实现推荐,是一个可解释性很强, 非常直观的模型。

++ 但是也存在一些问题,处理稀疏矩阵的能力比较弱。

+

+为了使得协同过滤更好处理稀疏矩阵问题, 增强泛化能力。从协同过滤中衍生出矩阵分解模型(Matrix Factorization, MF)或者叫隐语义模型:

+

++ 在协同过滤共现矩阵的基础上, 使用更稠密的隐向量表示用户和物品。

++ 通过挖掘用户和物品的隐含兴趣和隐含特征, 在一定程度上弥补协同过滤模型处理稀疏矩阵能力不足的问题。

+

+

+

+# 隐语义模型

+

+隐语义模型最早在文本领域被提出,用于找到文本的隐含语义。在2006年, 被用于推荐中, 它的核心思想是通过隐含特征(latent factor)联系用户兴趣和物品(item), 基于用户的行为找出潜在的主题和分类, 然后对物品进行自动聚类,划分到不同类别/主题(用户的兴趣)。

+

+以项亮老师《推荐系统实践》书中的内容为例:

+

+>如果我们知道了用户A和用户B两个用户在豆瓣的读书列表, 从他们的阅读列表可以看出,用户A的兴趣涉及侦探小说、科普图书以及一些计算机技术书, 而用户B的兴趣比较集中在数学和机器学习方面。 那么如何给A和B推荐图书呢? 先说说协同过滤算法, 这样好对比不同:

+>* 对于UserCF,首先需要找到和他们看了同样书的其他用户(兴趣相似的用户),然后给他们推荐那些用户喜欢的其他书。

+>* 对于ItemCF,需要给他们推荐和他们已经看的书相似的书,比如作者B看了很多关于数据挖掘的书,可以给他推荐机器学习或者模式识别方面的书。

+>

+>而如果是隐语义模型的话, 它会先通过一些角度把用户兴趣和这些书归一下类, 当来了用户之后, 首先得到他的兴趣分类, 然后从这个分类中挑选他可能喜欢的书籍。

+

+隐语义模型和协同过滤的不同主要体现在隐含特征上, 比如书籍的话它的内容, 作者, 年份, 主题等都可以算隐含特征。

+

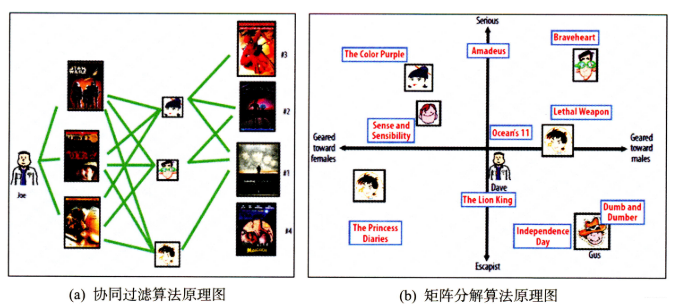

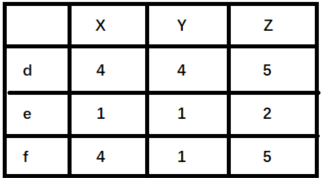

+以王喆老师《深度学习推荐系统》中的一个原理图为例,看看是如何通过隐含特征来划分开用户兴趣和物品的。

+

+

+

+3. 根据皮尔逊相关系数, 可以找到与物品5最相似的2个物品是 item1 和 item4, 下面基于上面的公式计算最终得分:

+

+$$

+P_{Alice, 物品5}=\bar{R}_{物品5}+\frac{\sum_{k=1}^{2}\left(w_{物品5,物品 k}\left(R_{Alice, 物品k}-\bar{R}_{物品k}\right)\right)}{\sum_{k=1}^{2} w_{物品k, 物品5}} \\

+=\frac{13}{4}+\frac{0.97*(5-3.2)+0.58*(4-3.4)}{0.97+0.58}=4.6

+$$

+

+## ItemCF编程实现

+

+1. 构建物品-用户的评分矩阵

+

+ ```python

+ import numpy as np

+ import pandas as pd

+

+

+ def loadData():

+ items = {'A': {'Alice': 5.0, 'user1': 3.0, 'user2': 4.0, 'user3': 3.0, 'user4': 1.0},

+ 'B': {'Alice': 3.0, 'user1': 1.0, 'user2': 3.0, 'user3': 3.0, 'user4': 5.0},

+ 'C': {'Alice': 4.0, 'user1': 2.0, 'user2': 4.0, 'user3': 1.0, 'user4': 5.0},

+ 'D': {'Alice': 4.0, 'user1': 3.0, 'user2': 3.0, 'user3': 5.0, 'user4': 2.0},

+ 'E': {'user1': 3.0, 'user2': 5.0, 'user3': 4.0, 'user4': 1.0}

+ }

+ return items

+ ```

+

+2. 计算物品间的相似度矩阵

+

+ ```python

+ item_data = loadData()

+

+ similarity_matrix = pd.DataFrame(

+ np.identity(len(item_data)),

+ index=item_data.keys(),

+ columns=item_data.keys(),

+ )

+

+ # 遍历每条物品-用户评分数据

+ for i1, users1 in item_data.items():

+ for i2, users2 in item_data.items():

+ if i1 == i2:

+ continue

+ vec1, vec2 = [], []

+ for user, rating1 in users1.items():

+ rating2 = users2.get(user, -1)

+ if rating2 == -1:

+ continue

+ vec1.append(rating1)

+ vec2.append(rating2)

+ similarity_matrix[i1][i2] = np.corrcoef(vec1, vec2)[0][1]

+

+ print(similarity_matrix)

+ ```

+

+ ```

+ A B C D E

+ A 1.000000 -0.476731 -0.123091 0.532181 0.969458

+ B -0.476731 1.000000 0.645497 -0.310087 -0.478091

+ C -0.123091 0.645497 1.000000 -0.720577 -0.427618

+ D 0.532181 -0.310087 -0.720577 1.000000 0.581675

+ E 0.969458 -0.478091 -0.427618 0.581675 1.000000

+ ```

+

+3. 从 Alice 购买过的物品中,选出与物品 `E` 最相似的 `num` 件物品。

+

+ ```python

+ target_user = ' Alice '

+ target_item = 'E'

+ num = 2

+

+ sim_items = []

+ sim_items_list = similarity_matrix[target_item].sort_values(ascending=False).index.tolist()

+ for item in sim_items_list:

+ # 如果target_user对物品item评分过

+ if target_user in item_data[item]:

+ sim_items.append(item)

+ if len(sim_items) == num:

+ break

+ print(f'与物品{target_item}最相似的{num}个物品为:{sim_items}')

+ ```

+

+ ```

+ 与物品E最相似的2个物品为:['A', 'D']

+ ```

+

+4. 预测用户 Alice 对物品 `E` 的评分

+

+ ```python

+ target_user_mean_rating = np.mean(list(item_data[target_item].values()))

+ weighted_scores = 0.

+ corr_values_sum = 0.

+

+ target_item = 'E'

+ for item in sim_items:

+ corr_value = similarity_matrix[target_item][item]

+ user_mean_rating = np.mean(list(item_data[item].values()))

+

+ weighted_scores += corr_value * (item_data[item][target_user] - user_mean_rating)

+ corr_values_sum += corr_value

+

+ target_item_pred = target_user_mean_rating + weighted_scores / corr_values_sum

+ print(f'用户{target_user}对物品{target_item}的预测评分为:{target_item_pred}')

+ ```

+

+ ```

+ 用户 Alice 对物品E的预测评分为:4.6

+ ```

+

+# 协同过滤算法的权重改进

+

+* base 公式

+ $$

+ w_{i j}=\frac{|N(i) \bigcap N(j)|}{|N(i)|}

+ $$

+

+ + 该公式表示同时喜好物品 $i$ 和物品 $j$ 的用户数,占喜爱物品 $i$ 的比例。

+ + 缺点:若物品 $j$ 为热门物品,那么它与任何物品的相似度都很高。

+

+* 对热门物品进行惩罚

+ $$

+ w_{i j}=\frac{|N(i) \cap N(j)|}{\sqrt{|N(i)||N(j)|}}

+ $$

+

+

+ * 根据 base 公式在的问题,对物品 $j$ 进行打压。打压的出发点很简单,就是在分母再除以一个物品 $j$ 被购买的数量。

+ * 此时,若物品 $j$ 为热门物品,那么对应的 $N(j)$ 也会很大,受到的惩罚更多。

+

+* 控制对热门物品的惩罚力度

+ $$

+ w_{i j}=\frac{|N(i) \cap N(j)|}{|N(i)|^{1-\alpha}|N(j)|^{\alpha}}

+ $$

+

+ * 除了第二点提到的办法,在计算物品之间相似度时可以对热门物品进行惩罚外。

+ * 可以在此基础上,进一步引入参数 $\alpha$ ,这样可以通过控制参数 $\alpha$来决定对热门物品的惩罚力度。

+

+* 对活跃用户的惩罚

+

+ * 在计算物品之间的相似度时,可以进一步将用户的活跃度考虑进来。

+ $$

+ w_{i j}=\frac{\sum_{\operatorname{\text {u}\in N(i) \cap N(j)}} \frac{1}{\log 1+|N(u)|}}{|N(i)|^{1-\alpha}|N(j)|^{\alpha}}

+ $$

+

+ + 对于异常活跃的用户,在计算物品之间的相似度时,他的贡献应该小于非活跃用户。

+

+# 协同过滤算法的问题分析

+

+协同过滤算法存在的问题之一就是泛化能力弱:

+

++ 即协同过滤无法将两个物品相似的信息推广到其他物品的相似性上。

++ 导致的问题是**热门物品具有很强的头部效应, 容易跟大量物品产生相似, 而尾部物品由于特征向量稀疏, 导致很少被推荐**。

+

+比如下面这个例子:

+

+

+

++ 左边矩阵中,$A, B, C, D$ 表示的是物品。

++ 可以看出,$D $ 是一件热门物品,其与 $A、B、C$ 的相似度比较大。因此,推荐系统更可能将 $D$ 推荐给用过 $A、B、C$ 的用户。

++ 但是,推荐系统无法找出 $A,B,C$ 之间相似性的原因是交互数据太稀疏, 缺乏相似性计算的直接数据。

+

+所以这就是协同过滤的天然缺陷:**推荐系统头部效应明显, 处理稀疏向量的能力弱**。

+

+为了解决这个问题, 同时增加模型的泛化能力。2006年,**矩阵分解技术(Matrix Factorization, MF**)被提出:

+

++ 该方法在协同过滤共现矩阵的基础上, 使用更稠密的隐向量表示用户和物品, 挖掘用户和物品的隐含兴趣和隐含特征。

++ 在一定程度上弥补协同过滤模型处理稀疏矩阵能力不足的问题。

+

+# 课后思考

+

+1. **什么时候使用UserCF,什么时候使用ItemCF?为什么?**

+

+> (1)UserCF

+>

+> + 由于是基于用户相似度进行推荐, 所以具备更强的社交特性, 这样的特点非常适于**用户少, 物品多, 时效性较强的场合**。

+>

+> + 比如新闻推荐场景, 因为新闻本身兴趣点分散, 相比用户对不同新闻的兴趣偏好, 新闻的及时性,热点性往往更加重要, 所以正好适用于发现热点,跟踪热点的趋势。

+> + 另外还具有推荐新信息的能力, 更有可能发现惊喜, 因为看的是人与人的相似性, 推出来的结果可能更有惊喜,可以发现用户潜在但自己尚未察觉的兴趣爱好。

+>

+> (2)ItemCF

+>

+> + 这个更适用于兴趣变化较为稳定的应用, 更接近于个性化的推荐, 适合**物品少,用户多,用户兴趣固定持久, 物品更新速度不是太快的场合**。

+> + 比如推荐艺术品, 音乐, 电影。

+

+

+

+2.**协同过滤在计算上有什么缺点?有什么比较好的思路可以解决(缓解)?**

+

+> 该问题答案参考上一小节的**协同过滤算法的问题分析**。

+

+

+

+**3.上面介绍的相似度计算方法有什么优劣之处?**

+

+> cosine相似度计算简单方便,一般较为常用。但是,当用户的评分数据存在 bias 时,效果往往不那么好。

+>

+> + 简而言之,就是不同用户评分的偏向不同。部分用户可能乐于给予好评,而部分用户习惯给予差评或者乱评分。

+> + 这个时候,根据cosine 相似度计算出来的推荐结果效果会打折扣。

+>

+> 举例来说明,如下图(`X,Y,Z` 表示物品,`d,e,f`表示用户):

+>

+>

+>

+> + 如果使用余弦相似度进行计算,用户 d 和 e 之间较为相似。但是实际上,用户 d 和 f 之间应该更加相似。只不过由于 d 倾向于打高分,e 倾向于打低分导致二者之间的余弦相似度更高。

+> + 这种情况下,可以考虑使用皮尔逊相关系数计算用户之间的相似性关系。

+

+

+

+4.**协同过滤还存在其他什么缺陷?有什么比较好的思路可以解决(缓解)?**

+

+> + 协同过滤的优点就是没有使用更多的用户或者物品属性信息,仅利用用户和物品之间的交互信息就能完成推荐,该算法简单高效。

+> + 但这也是协同过滤算法的一个弊端。由于未使用更丰富的用户和物品特征信息,这也导致协同过滤算法的模型表达能力有限。

+> + 对于该问题,逻辑回归模型(LR)可以更好地在推荐模型中引入更多特征信息,提高模型的表达能力。

+

+

+

+# 参考资料

+

+* [基于用户的协同过滤来构建推荐系统:https://mp.weixin.qq.com/s/ZtnaQrVIpVOPJpqMdLWOcw](https://mp.weixin.qq.com/s/ZtnaQrVIpVOPJpqMdLWOcw)

+* [协同过滤算法概述:https://chenk.tech/posts/8ad63d9d.html](https://chenk.tech/posts/8ad63d9d.html)

+* B站黑马推荐系统实战课程

+

+

+

+

+

diff --git a/4.人工智能/ch02/ch2.1/ch2.1.1/mf.md b/4.人工智能/ch02/ch2.1/ch2.1.1/mf.md

new file mode 100644

index 0000000..7065d45

--- /dev/null

+++ b/4.人工智能/ch02/ch2.1/ch2.1.1/mf.md

@@ -0,0 +1,370 @@

+# 隐语义模型与矩阵分解

+

+协同过滤算法的特点:

+

++ 协同过滤算法的特点就是完全没有利用到物品本身或者是用户自身的属性, 仅仅利用了用户与物品的交互信息就可以实现推荐,是一个可解释性很强, 非常直观的模型。

++ 但是也存在一些问题,处理稀疏矩阵的能力比较弱。

+

+为了使得协同过滤更好处理稀疏矩阵问题, 增强泛化能力。从协同过滤中衍生出矩阵分解模型(Matrix Factorization, MF)或者叫隐语义模型:

+

++ 在协同过滤共现矩阵的基础上, 使用更稠密的隐向量表示用户和物品。

++ 通过挖掘用户和物品的隐含兴趣和隐含特征, 在一定程度上弥补协同过滤模型处理稀疏矩阵能力不足的问题。

+

+

+

+# 隐语义模型

+

+隐语义模型最早在文本领域被提出,用于找到文本的隐含语义。在2006年, 被用于推荐中, 它的核心思想是通过隐含特征(latent factor)联系用户兴趣和物品(item), 基于用户的行为找出潜在的主题和分类, 然后对物品进行自动聚类,划分到不同类别/主题(用户的兴趣)。

+

+以项亮老师《推荐系统实践》书中的内容为例:

+

+>如果我们知道了用户A和用户B两个用户在豆瓣的读书列表, 从他们的阅读列表可以看出,用户A的兴趣涉及侦探小说、科普图书以及一些计算机技术书, 而用户B的兴趣比较集中在数学和机器学习方面。 那么如何给A和B推荐图书呢? 先说说协同过滤算法, 这样好对比不同:

+>* 对于UserCF,首先需要找到和他们看了同样书的其他用户(兴趣相似的用户),然后给他们推荐那些用户喜欢的其他书。

+>* 对于ItemCF,需要给他们推荐和他们已经看的书相似的书,比如作者B看了很多关于数据挖掘的书,可以给他推荐机器学习或者模式识别方面的书。

+>

+>而如果是隐语义模型的话, 它会先通过一些角度把用户兴趣和这些书归一下类, 当来了用户之后, 首先得到他的兴趣分类, 然后从这个分类中挑选他可能喜欢的书籍。

+

+隐语义模型和协同过滤的不同主要体现在隐含特征上, 比如书籍的话它的内容, 作者, 年份, 主题等都可以算隐含特征。

+

+以王喆老师《深度学习推荐系统》中的一个原理图为例,看看是如何通过隐含特征来划分开用户兴趣和物品的。

+

+ +

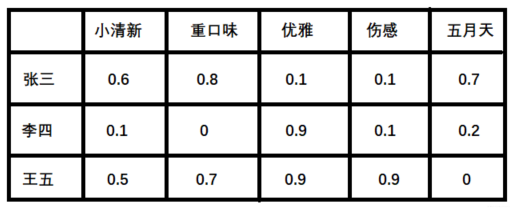

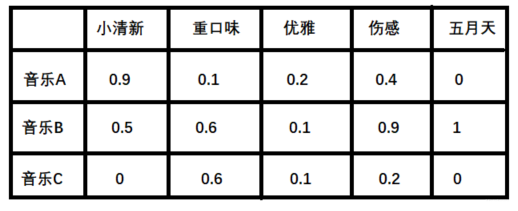

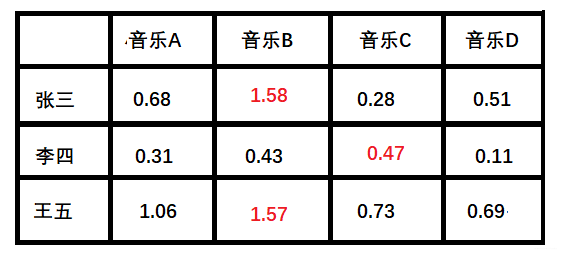

+## 音乐评分实例

+

+假设每个用户都有自己的听歌偏好, 比如用户 A 喜欢带有**小清新的**, **吉他伴奏的**, **王菲**的歌曲,如果一首歌正好**是王菲唱的, 并且是吉他伴奏的小清新**, 那么就可以将这首歌推荐给这个用户。 也就是说是**小清新, 吉他伴奏, 王菲**这些元素连接起了用户和歌曲。

+

+当然每个用户对不同的元素偏好不同, 每首歌包含的元素也不一样, 所以我们就希望找到下面的两个矩阵:

+

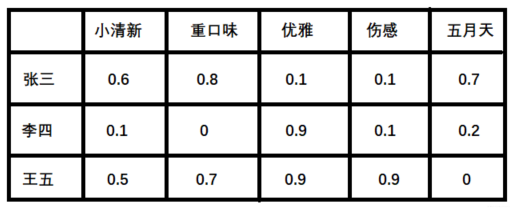

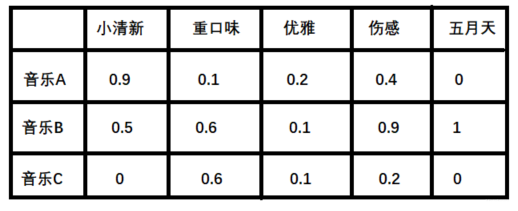

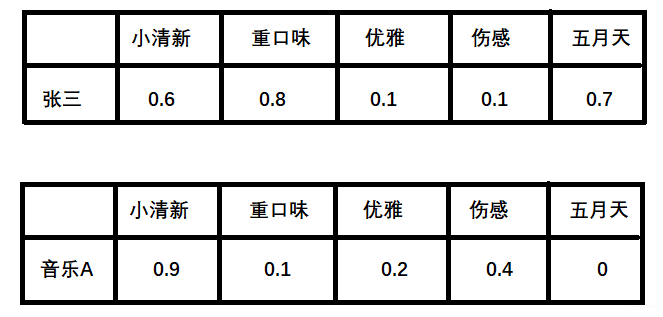

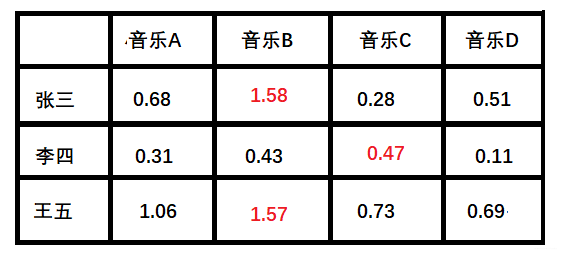

+1. 潜在因子—— 用户矩阵Q

+ 这个矩阵表示不同用户对于不同元素的偏好程度, 1代表很喜欢, 0代表不喜欢, 比如下面这样:

+

+

+

+## 音乐评分实例

+

+假设每个用户都有自己的听歌偏好, 比如用户 A 喜欢带有**小清新的**, **吉他伴奏的**, **王菲**的歌曲,如果一首歌正好**是王菲唱的, 并且是吉他伴奏的小清新**, 那么就可以将这首歌推荐给这个用户。 也就是说是**小清新, 吉他伴奏, 王菲**这些元素连接起了用户和歌曲。

+

+当然每个用户对不同的元素偏好不同, 每首歌包含的元素也不一样, 所以我们就希望找到下面的两个矩阵:

+

+1. 潜在因子—— 用户矩阵Q

+ 这个矩阵表示不同用户对于不同元素的偏好程度, 1代表很喜欢, 0代表不喜欢, 比如下面这样:

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+## 计算过程

+

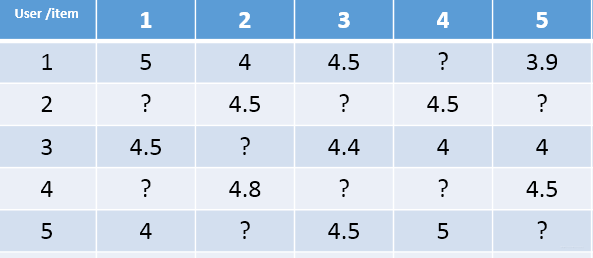

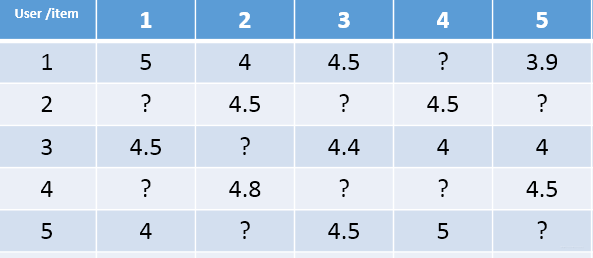

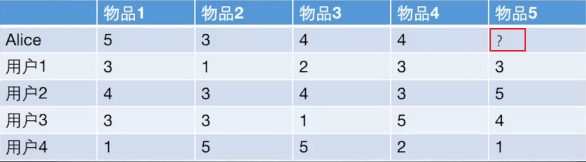

+以下图为例,给用户推荐物品的过程可以形象化为一个猜测用户对物品进行打分的任务,表格里面是5个用户对于5件物品的一个打分情况,就可以理解为用户对物品的喜欢程度。

+

+

+

+UserCF算法的两个步骤:

+

++ 首先,根据前面的这些打分情况(或者说已有的用户向量)计算一下 Alice 和用户1, 2, 3, 4的相似程度, 找出与 Alice 最相似的 n 个用户。

+

++ 根据这 n 个用户对物品 5 的评分情况和与 Alice 的相似程度会猜测出 Alice 对物品5的评分。如果评分比较高的话, 就把物品5推荐给用户 Alice, 否则不推荐。

+

+**具体过程:**

+

+1. 计算用户之间的相似度

+

+ + 根据 1.2 节的几种方法, 我们可以计算出各用户之间的相似程度。对于用户 Alice,选取出与其最相近的 $N$ 个用户。

+

+2. 计算用户对新物品的评分预测

+

+ + 常用的方式之一:利用目标用户与相似用户之间的相似度以及相似用户对物品的评分,来预测目标用户对候选物品的评分估计:

+ $$

+ R_{\mathrm{u}, \mathrm{p}}=\frac{\sum_{\mathrm{s} \in S}\left(w_{\mathrm{u}, \mathrm{s}} \cdot R_{\mathrm{s}, \mathrm{p}}\right)}{\sum_{\mathrm{s} \in S} w_{\mathrm{u}, \mathrm{s}}}

+ $$

+

+ + 其中,权重 $w_{u,s}$ 是用户 $u$ 和用户 $s$ 的相似度, $R_{s,p}$ 是用户 $s$ 对物品 $p$ 的评分。

+

+ + 另一种方式:考虑到用户评分的偏置,即有的用户喜欢打高分, 有的用户喜欢打低分的情况。公式如下:

+ $$

+ R_{\mathrm{u}, \mathrm{p}}=\bar{R}_{u} + \frac{\sum_{\mathrm{s} \in S}\left(w_{\mathrm{u}, \mathrm{s}} \cdot \left(R_{s, p}-\bar{R}_{s}\right)\right)}{\sum_{\mathrm{s} \in S} w_{\mathrm{u}, \mathrm{s}}}

+ $$

+

+ + 其中,$\bar{R}_{s}$ 表示用户 $s$ 对物品的历史平均评分。

+

+3. 对用户进行物品推荐

+

+ + 在获得用户 $u$ 对不同物品的评价预测后, 最终的推荐列表根据预测评分进行排序得到。

+

+**手动计算:**

+

+根据上面的问题, 下面手动计算 Alice 对物品 5 的得分:

+

+

+1. 计算 Alice 与其他用户的相似度(基于皮尔逊相关系数)

+

+ + 手动计算 Alice 与用户 1 之间的相似度:

+

+ >用户向量 $\text {Alice}:(5,3,4,4) , \text{user1}:(3,1,2,3) , \text {user2}:( 4,3,4,3) , \text {user3}:(3,3,1,5) , \text {user4}:(1,5,5,2) $

+ >

+ >+ 计算Alice与user1的余弦相似性:

+ >$$

+ >\operatorname{sim}(\text { Alice, user1 })=\cos (\text { Alice, user } 1)=\frac{15+3+8+12}{\operatorname{sqrt}(25+9+16+16) * \operatorname{sqrt}(9+1+4+9)}=0.975

+ >$$

+ >

+ >+ 计算Alice与user1皮尔逊相关系数:

+ > + $Alice\_ave =4 \quad user1\_ave =2.25 $

+ > + 向量减去均值: $\text {Alice}:(1,-1, 0,0) \quad \text { user1 }:(0.75,-1.25,-0.25,0.75)$

+ >

+ >+ 计算这俩新向量的余弦相似度和上面计算过程一致, 结果是 0.852 。

+ >

+

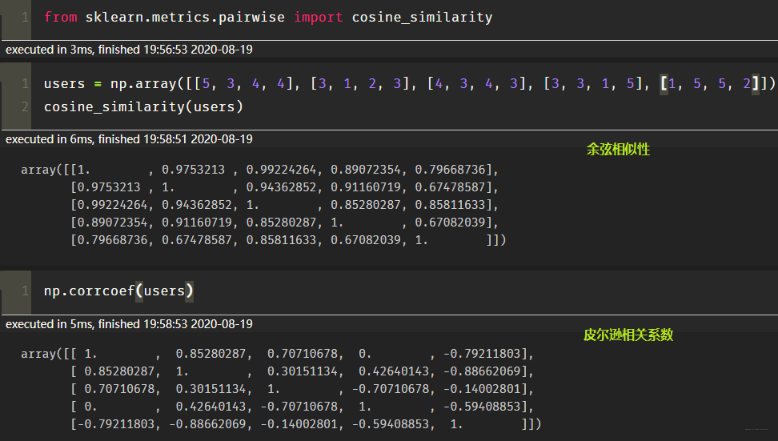

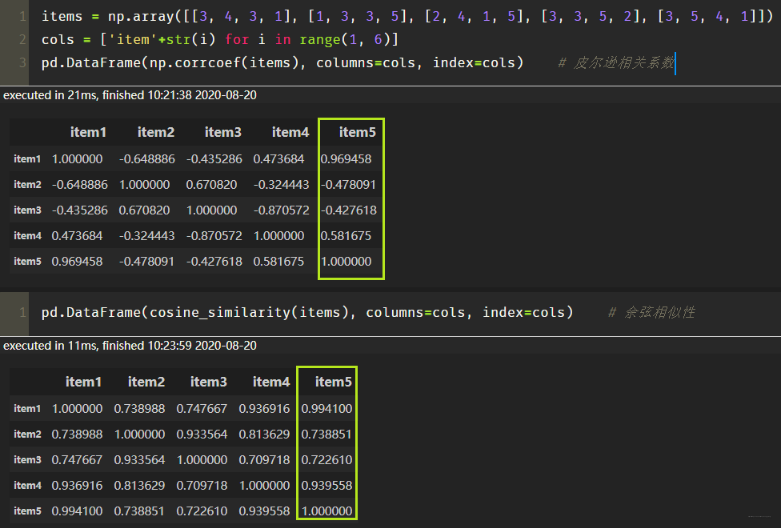

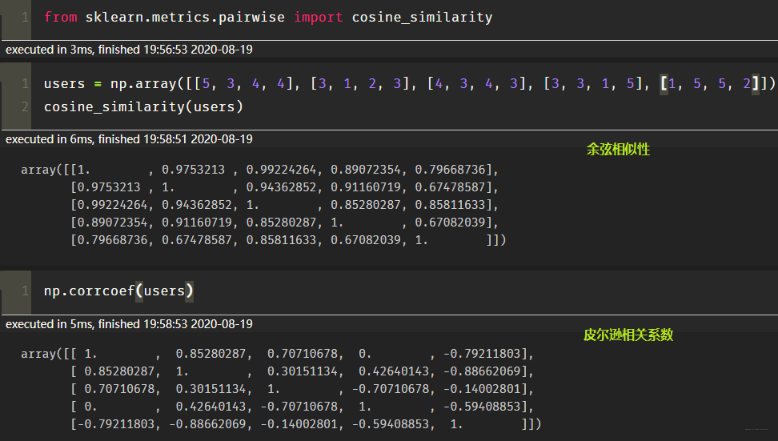

+ + 基于 sklearn 计算所有用户之间的皮尔逊相关系数。可以看出,与 Alice 相似度最高的用户为用户1和用户2。

+

+

+

+## 计算过程

+

+以下图为例,给用户推荐物品的过程可以形象化为一个猜测用户对物品进行打分的任务,表格里面是5个用户对于5件物品的一个打分情况,就可以理解为用户对物品的喜欢程度。

+

+

+

+UserCF算法的两个步骤:

+

++ 首先,根据前面的这些打分情况(或者说已有的用户向量)计算一下 Alice 和用户1, 2, 3, 4的相似程度, 找出与 Alice 最相似的 n 个用户。

+

++ 根据这 n 个用户对物品 5 的评分情况和与 Alice 的相似程度会猜测出 Alice 对物品5的评分。如果评分比较高的话, 就把物品5推荐给用户 Alice, 否则不推荐。

+

+**具体过程:**

+

+1. 计算用户之间的相似度

+

+ + 根据 1.2 节的几种方法, 我们可以计算出各用户之间的相似程度。对于用户 Alice,选取出与其最相近的 $N$ 个用户。

+

+2. 计算用户对新物品的评分预测

+

+ + 常用的方式之一:利用目标用户与相似用户之间的相似度以及相似用户对物品的评分,来预测目标用户对候选物品的评分估计:

+ $$

+ R_{\mathrm{u}, \mathrm{p}}=\frac{\sum_{\mathrm{s} \in S}\left(w_{\mathrm{u}, \mathrm{s}} \cdot R_{\mathrm{s}, \mathrm{p}}\right)}{\sum_{\mathrm{s} \in S} w_{\mathrm{u}, \mathrm{s}}}

+ $$

+

+ + 其中,权重 $w_{u,s}$ 是用户 $u$ 和用户 $s$ 的相似度, $R_{s,p}$ 是用户 $s$ 对物品 $p$ 的评分。

+

+ + 另一种方式:考虑到用户评分的偏置,即有的用户喜欢打高分, 有的用户喜欢打低分的情况。公式如下:

+ $$

+ R_{\mathrm{u}, \mathrm{p}}=\bar{R}_{u} + \frac{\sum_{\mathrm{s} \in S}\left(w_{\mathrm{u}, \mathrm{s}} \cdot \left(R_{s, p}-\bar{R}_{s}\right)\right)}{\sum_{\mathrm{s} \in S} w_{\mathrm{u}, \mathrm{s}}}

+ $$

+

+ + 其中,$\bar{R}_{s}$ 表示用户 $s$ 对物品的历史平均评分。

+

+3. 对用户进行物品推荐

+

+ + 在获得用户 $u$ 对不同物品的评价预测后, 最终的推荐列表根据预测评分进行排序得到。

+

+**手动计算:**

+

+根据上面的问题, 下面手动计算 Alice 对物品 5 的得分:

+

+

+1. 计算 Alice 与其他用户的相似度(基于皮尔逊相关系数)

+

+ + 手动计算 Alice 与用户 1 之间的相似度:

+

+ >用户向量 $\text {Alice}:(5,3,4,4) , \text{user1}:(3,1,2,3) , \text {user2}:( 4,3,4,3) , \text {user3}:(3,3,1,5) , \text {user4}:(1,5,5,2) $

+ >

+ >+ 计算Alice与user1的余弦相似性:

+ >$$

+ >\operatorname{sim}(\text { Alice, user1 })=\cos (\text { Alice, user } 1)=\frac{15+3+8+12}{\operatorname{sqrt}(25+9+16+16) * \operatorname{sqrt}(9+1+4+9)}=0.975

+ >$$

+ >

+ >+ 计算Alice与user1皮尔逊相关系数:

+ > + $Alice\_ave =4 \quad user1\_ave =2.25 $

+ > + 向量减去均值: $\text {Alice}:(1,-1, 0,0) \quad \text { user1 }:(0.75,-1.25,-0.25,0.75)$

+ >

+ >+ 计算这俩新向量的余弦相似度和上面计算过程一致, 结果是 0.852 。

+ >

+

+ + 基于 sklearn 计算所有用户之间的皮尔逊相关系数。可以看出,与 Alice 相似度最高的用户为用户1和用户2。

+

+  +

+2. **根据相似度用户计算 Alice对物品5的最终得分**

+ 用户1对物品5的评分是3, 用户2对物品5的打分是5, 那么根据上面的计算公式, 可以计算出 Alice 对物品5的最终得分是

+ $$

+ P_{Alice, 物品5}=\bar{R}_{Alice}+\frac{\sum_{k=1}^{2}\left(w_{Alice,user k}\left(R_{userk, 物品5}-\bar{R}_{userk}\right)\right)}{\sum_{k=1}^{2} w_{Alice, userk}}=4+\frac{0.85*(3-2.4)+0.7*(5-3.8)}{0.85+0.7}=4.87

+ $$

+

+ + 同样方式,可以计算用户 Alice 对其他物品的评分预测。

+

+3. **根据用户评分对用户进行推荐**

+

+ + 根据 Alice 的打分对物品排个序从大到小:$$物品1>物品5>物品3=物品4>物品2$$。

+ + 如果要向 Alice 推荐2款产品的话, 我们就可以推荐物品 1 和物品 5 给 Alice。

+

+ 至此, 基于用户的协同过滤算法原理介绍完毕。

+

+## UserCF编程实现

+

+1. 建立实验使用的数据表:

+

+ ```python

+ import numpy as np

+ import pandas as pd

+

+

+ def loadData():

+ users = {'Alice': {'A': 5, 'B': 3, 'C': 4, 'D': 4},

+ 'user1': {'A': 3, 'B': 1, 'C': 2, 'D': 3, 'E': 3},

+ 'user2': {'A': 4, 'B': 3, 'C': 4, 'D': 3, 'E': 5},

+ 'user3': {'A': 3, 'B': 3, 'C': 1, 'D': 5, 'E': 4},

+ 'user4': {'A': 1, 'B': 5, 'C': 5, 'D': 2, 'E': 1}

+ }

+ return users

+ ```

+

+ + 这里使用字典来建立用户-物品的交互表。

+ + 字典`users`的键表示不同用户的名字,值为一个评分字典,评分字典的键值对表示某物品被当前用户的评分。

+ + 由于现实场景中,用户对物品的评分比较稀疏。如果直接使用矩阵进行存储,会存在大量空缺值,故此处使用了字典。

+

+2. 计算用户相似性矩阵

+

+ + 由于训练数据中共包含 5 个用户,所以这里的用户相似度矩阵的维度也为 $5 \times 5$。

+

+ ```python

+ user_data = loadData()

+ similarity_matrix = pd.DataFrame(

+ np.identity(len(user_data)),

+ index=user_data.keys(),

+ columns=user_data.keys(),

+ )

+

+ # 遍历每条用户-物品评分数据

+ for u1, items1 in user_data.items():

+ for u2, items2 in user_data.items():

+ if u1 == u2:

+ continue

+ vec1, vec2 = [], []

+ for item, rating1 in items1.items():

+ rating2 = items2.get(item, -1)

+ if rating2 == -1:

+ continue

+ vec1.append(rating1)

+ vec2.append(rating2)

+ # 计算不同用户之间的皮尔逊相关系数

+ similarity_matrix[u1][u2] = np.corrcoef(vec1, vec2)[0][1]

+

+ print(similarity_matrix)

+ ```

+

+ ```

+ 1 2 3 4 5

+ 1 1.000000 0.852803 0.707107 0.000000 -0.792118

+ 2 0.852803 1.000000 0.467707 0.489956 -0.900149

+ 3 0.707107 0.467707 1.000000 -0.161165 -0.466569

+ 4 0.000000 0.489956 -0.161165 1.000000 -0.641503

+ 5 -0.792118 -0.900149 -0.466569 -0.641503 1.000000

+ ```

+

+3. 计算与 Alice 最相似的 `num` 个用户

+

+ ```python

+ target_user = ' Alice '

+ num = 2

+ # 由于最相似的用户为自己,去除本身

+ sim_users = similarity_matrix[target_user].sort_values(ascending=False)[1:num+1].index.tolist()

+ print(f'与用户{target_user}最相似的{num}个用户为:{sim_users}')

+ ```

+

+ ```

+ 与用户 Alice 最相似的2个用户为:['user1', 'user2']

+ ```

+

+4. 预测用户 Alice 对物品 `E` 的评分

+

+ ```python

+ weighted_scores = 0.

+ corr_values_sum = 0.

+

+ target_item = 'E'

+ # 基于皮尔逊相关系数预测用户评分

+ for user in sim_users:

+ corr_value = similarity_matrix[target_user][user]

+ user_mean_rating = np.mean(list(user_data[user].values()))

+

+ weighted_scores += corr_value * (user_data[user][target_item] - user_mean_rating)

+ corr_values_sum += corr_value

+

+ target_user_mean_rating = np.mean(list(user_data[target_user].values()))

+ target_item_pred = target_user_mean_rating + weighted_scores / corr_values_sum

+ print(f'用户{target_user}对物品{target_item}的预测评分为:{target_item_pred}')

+ ```

+

+ ```

+ 用户 Alice 对物品E的预测评分为:4.871979899370592

+ ```

+

+## UserCF优缺点

+

+User-based算法存在两个重大问题:

+

+

+1. 数据稀疏性

+ + 一个大型的电子商务推荐系统一般有非常多的物品,用户可能买的其中不到1%的物品,不同用户之间买的物品重叠性较低,导致算法无法找到一个用户的邻居,即偏好相似的用户。

+ + 这导致UserCF不适用于那些正反馈获取较困难的应用场景(如酒店预订, 大件物品购买等低频应用)。

+

+1. 算法扩展性

+ + 基于用户的协同过滤需要维护用户相似度矩阵以便快速的找出 $TopN$ 相似用户, 该矩阵的存储开销非常大,存储空间随着用户数量的增加而增加。

+ + 故不适合用户数据量大的情况使用。

+

+由于UserCF技术上的两点缺陷, 导致很多电商平台并没有采用这种算法, 而是采用了ItemCF算法实现最初的推荐系统。

+

+

+

+# 算法评估

+

+由于UserCF和ItemCF结果评估部分是共性知识点, 所以在这里统一标识。

+

+## 召回率

+

+对用户 $u$ 推荐 $N$ 个物品记为 $R(u)$, 令用户 $u$ 在测试集上喜欢的物品集合为$T(u)$, 那么召回率定义为:

+$$

+\operatorname{Recall}=\frac{\sum_{u}|R(u) \cap T(u)|}{\sum_{u}|T(u)|}

+$$

++ 含义:在模型召回预测的物品中,预测准确的物品占用户实际喜欢的物品的比例。

+

+## 精确率

+精确率定义为:

+$$

+\operatorname{Precision}=\frac{\sum_{u} \mid R(u) \cap T(u)|}{\sum_{u}|R(u)|}

+$$

++ 含义:推荐的物品中,对用户准确推荐的物品占总物品的比例。

++ 如要确保召回率高,一般是推荐更多的物品,期望推荐的物品中会涵盖用户喜爱的物品。而实际中,推荐的物品中用户实际喜爱的物品占少数,推荐的精确率就会很低。故同时要确保高召回率和精确率往往是矛盾的,所以实际中需要在二者之间进行权衡。

+

+## 覆盖率

+覆盖率反映了推荐算法发掘长尾的能力, 覆盖率越高, 说明推荐算法越能将长尾中的物品推荐给用户。

+$$

+\text { Coverage }=\frac{\left|\bigcup_{u \in U} R(u)\right|}{|I|}

+$$

+

++ 含义:推荐系统能够推荐出来的物品占总物品集合的比例。

+ + 其中 $|I|$ 表示所有物品的个数;

+ + 系统的用户集合为$U$;

+ + 推荐系统给每个用户推荐一个长度为 $N$ 的物品列表$R(u)$.

+

++ 覆盖率表示最终的推荐列表中包含多大比例的物品。如果所有物品都被给推荐给至少一个用户, 那么覆盖率是100%。

+

+## 新颖度

+用推荐列表中物品的平均流行度度量推荐结果的新颖度。 如果推荐出的物品都很热门, 说明推荐的新颖度较低。 由于物品的流行度分布呈长尾分布, 所以为了流行度的平均值更加稳定, 在计算平均流行度时对每个物品的流行度取对数。

+

+- O’scar Celma 在博士论文 "[Music Recommendation and Discovery in the Long Tail](http://mtg.upf.edu/static/media/PhD_ocelma.pdf) " 中研究了新颖度的评测。

+

+

+

+# 参考资料

+

+* [基于用户的协同过滤来构建推荐系统:https://mp.weixin.qq.com/s/ZtnaQrVIpVOPJpqMdLWOcw](https://mp.weixin.qq.com/s/ZtnaQrVIpVOPJpqMdLWOcw)

+* [协同过滤算法概述:https://chenk.tech/posts/8ad63d9d.html](https://chenk.tech/posts/8ad63d9d.html)

+* B站黑马推荐系统实战课程

diff --git a/4.人工智能/ch02/ch2.1/ch2.1.2/Airbnb.md b/4.人工智能/ch02/ch2.1/ch2.1.2/Airbnb.md

new file mode 100644

index 0000000..65ce7bc

--- /dev/null

+++ b/4.人工智能/ch02/ch2.1/ch2.1.2/Airbnb.md

@@ -0,0 +1,332 @@

+# 前言

+这是 Airbnb 于2018年发表的一篇论文,主要介绍了 Airbnb 在 Embedding 技术上的应用,并获得了 KDD 2018 的 Best Paper。Airbnb 是全球最大的短租平台,包含了数百万种不同的房源。这篇论文介绍了 Airbnb 如何使用 Embedding 来实现相似房源推荐以及实时个性化搜索。在本文中,Airbnb 在用户和房源的 Embedding 上的生成都是基于谷歌的 Word2Vec 模型,故阅读本文要求大家了解 Word2Vec 模型,特别是 Skip-Gram 模型**(重点*)**。

+本文将从以下几个方面来介绍该论文:

+

+- 了解 Airbnb 是如何利用 Word2Vec 技术生成房源和用户的Embedding,并做出了哪些改进。

+- 了解 Airbnb 是如何利用 Embedding 解决房源冷启动问题。

+- 了解 Airbnb 是如何衡量生成的 Embedding 的有效性。

+- 了解 Airbnb 是如何利用用户和房源 Embedding 做召回和搜索排序。

+

+考虑到本文的目的是为了让大家快速了解 Airbnb 在 Embedding 技术上的应用,故不会完全翻译原论文。如需进一步了解,建议阅读原论文或文末的参考链接。原论文链接:https://dl.acm.org/doi/pdf/10.1145/3219819.3219885

+

+# Airbnb 的业务背景

+在介绍 Airbnb 在 Embedding 技术上的方法前,先了解 Airbnb 的业务背景。

+

+- Airbnb 平台包含数百万种不同的房源,用户可以通过**浏览搜索结果页面**来寻找想要的房源。Airbnb 技术团队通过复杂的机器学习模型,并使用上百种信号对搜索结果中的房源进行排序。

+- 当用户在查看某一个房源时,接下来的有两种方式继续搜索:

+ - 返回搜索结果页,继续查看其他搜索结果。

+

+

+

+2. **根据相似度用户计算 Alice对物品5的最终得分**

+ 用户1对物品5的评分是3, 用户2对物品5的打分是5, 那么根据上面的计算公式, 可以计算出 Alice 对物品5的最终得分是

+ $$

+ P_{Alice, 物品5}=\bar{R}_{Alice}+\frac{\sum_{k=1}^{2}\left(w_{Alice,user k}\left(R_{userk, 物品5}-\bar{R}_{userk}\right)\right)}{\sum_{k=1}^{2} w_{Alice, userk}}=4+\frac{0.85*(3-2.4)+0.7*(5-3.8)}{0.85+0.7}=4.87

+ $$

+

+ + 同样方式,可以计算用户 Alice 对其他物品的评分预测。

+

+3. **根据用户评分对用户进行推荐**

+

+ + 根据 Alice 的打分对物品排个序从大到小:$$物品1>物品5>物品3=物品4>物品2$$。

+ + 如果要向 Alice 推荐2款产品的话, 我们就可以推荐物品 1 和物品 5 给 Alice。

+

+ 至此, 基于用户的协同过滤算法原理介绍完毕。

+

+## UserCF编程实现

+

+1. 建立实验使用的数据表:

+

+ ```python

+ import numpy as np

+ import pandas as pd

+

+

+ def loadData():

+ users = {'Alice': {'A': 5, 'B': 3, 'C': 4, 'D': 4},

+ 'user1': {'A': 3, 'B': 1, 'C': 2, 'D': 3, 'E': 3},

+ 'user2': {'A': 4, 'B': 3, 'C': 4, 'D': 3, 'E': 5},

+ 'user3': {'A': 3, 'B': 3, 'C': 1, 'D': 5, 'E': 4},

+ 'user4': {'A': 1, 'B': 5, 'C': 5, 'D': 2, 'E': 1}

+ }

+ return users

+ ```

+

+ + 这里使用字典来建立用户-物品的交互表。

+ + 字典`users`的键表示不同用户的名字,值为一个评分字典,评分字典的键值对表示某物品被当前用户的评分。

+ + 由于现实场景中,用户对物品的评分比较稀疏。如果直接使用矩阵进行存储,会存在大量空缺值,故此处使用了字典。

+

+2. 计算用户相似性矩阵

+

+ + 由于训练数据中共包含 5 个用户,所以这里的用户相似度矩阵的维度也为 $5 \times 5$。

+

+ ```python

+ user_data = loadData()

+ similarity_matrix = pd.DataFrame(

+ np.identity(len(user_data)),

+ index=user_data.keys(),

+ columns=user_data.keys(),

+ )

+

+ # 遍历每条用户-物品评分数据

+ for u1, items1 in user_data.items():

+ for u2, items2 in user_data.items():

+ if u1 == u2:

+ continue

+ vec1, vec2 = [], []

+ for item, rating1 in items1.items():

+ rating2 = items2.get(item, -1)

+ if rating2 == -1:

+ continue

+ vec1.append(rating1)

+ vec2.append(rating2)

+ # 计算不同用户之间的皮尔逊相关系数

+ similarity_matrix[u1][u2] = np.corrcoef(vec1, vec2)[0][1]

+

+ print(similarity_matrix)

+ ```

+

+ ```

+ 1 2 3 4 5

+ 1 1.000000 0.852803 0.707107 0.000000 -0.792118

+ 2 0.852803 1.000000 0.467707 0.489956 -0.900149

+ 3 0.707107 0.467707 1.000000 -0.161165 -0.466569

+ 4 0.000000 0.489956 -0.161165 1.000000 -0.641503

+ 5 -0.792118 -0.900149 -0.466569 -0.641503 1.000000

+ ```

+

+3. 计算与 Alice 最相似的 `num` 个用户

+

+ ```python

+ target_user = ' Alice '

+ num = 2

+ # 由于最相似的用户为自己,去除本身

+ sim_users = similarity_matrix[target_user].sort_values(ascending=False)[1:num+1].index.tolist()

+ print(f'与用户{target_user}最相似的{num}个用户为:{sim_users}')

+ ```

+

+ ```

+ 与用户 Alice 最相似的2个用户为:['user1', 'user2']

+ ```

+

+4. 预测用户 Alice 对物品 `E` 的评分

+

+ ```python

+ weighted_scores = 0.

+ corr_values_sum = 0.

+

+ target_item = 'E'

+ # 基于皮尔逊相关系数预测用户评分

+ for user in sim_users:

+ corr_value = similarity_matrix[target_user][user]

+ user_mean_rating = np.mean(list(user_data[user].values()))

+

+ weighted_scores += corr_value * (user_data[user][target_item] - user_mean_rating)

+ corr_values_sum += corr_value

+

+ target_user_mean_rating = np.mean(list(user_data[target_user].values()))

+ target_item_pred = target_user_mean_rating + weighted_scores / corr_values_sum

+ print(f'用户{target_user}对物品{target_item}的预测评分为:{target_item_pred}')

+ ```

+

+ ```

+ 用户 Alice 对物品E的预测评分为:4.871979899370592

+ ```

+

+## UserCF优缺点

+

+User-based算法存在两个重大问题:

+

+

+1. 数据稀疏性

+ + 一个大型的电子商务推荐系统一般有非常多的物品,用户可能买的其中不到1%的物品,不同用户之间买的物品重叠性较低,导致算法无法找到一个用户的邻居,即偏好相似的用户。

+ + 这导致UserCF不适用于那些正反馈获取较困难的应用场景(如酒店预订, 大件物品购买等低频应用)。

+

+1. 算法扩展性

+ + 基于用户的协同过滤需要维护用户相似度矩阵以便快速的找出 $TopN$ 相似用户, 该矩阵的存储开销非常大,存储空间随着用户数量的增加而增加。

+ + 故不适合用户数据量大的情况使用。

+

+由于UserCF技术上的两点缺陷, 导致很多电商平台并没有采用这种算法, 而是采用了ItemCF算法实现最初的推荐系统。

+

+

+

+# 算法评估

+

+由于UserCF和ItemCF结果评估部分是共性知识点, 所以在这里统一标识。

+

+## 召回率

+

+对用户 $u$ 推荐 $N$ 个物品记为 $R(u)$, 令用户 $u$ 在测试集上喜欢的物品集合为$T(u)$, 那么召回率定义为:

+$$

+\operatorname{Recall}=\frac{\sum_{u}|R(u) \cap T(u)|}{\sum_{u}|T(u)|}

+$$

++ 含义:在模型召回预测的物品中,预测准确的物品占用户实际喜欢的物品的比例。

+

+## 精确率

+精确率定义为:

+$$

+\operatorname{Precision}=\frac{\sum_{u} \mid R(u) \cap T(u)|}{\sum_{u}|R(u)|}

+$$

++ 含义:推荐的物品中,对用户准确推荐的物品占总物品的比例。

++ 如要确保召回率高,一般是推荐更多的物品,期望推荐的物品中会涵盖用户喜爱的物品。而实际中,推荐的物品中用户实际喜爱的物品占少数,推荐的精确率就会很低。故同时要确保高召回率和精确率往往是矛盾的,所以实际中需要在二者之间进行权衡。

+

+## 覆盖率

+覆盖率反映了推荐算法发掘长尾的能力, 覆盖率越高, 说明推荐算法越能将长尾中的物品推荐给用户。

+$$

+\text { Coverage }=\frac{\left|\bigcup_{u \in U} R(u)\right|}{|I|}

+$$

+

++ 含义:推荐系统能够推荐出来的物品占总物品集合的比例。

+ + 其中 $|I|$ 表示所有物品的个数;

+ + 系统的用户集合为$U$;

+ + 推荐系统给每个用户推荐一个长度为 $N$ 的物品列表$R(u)$.

+

++ 覆盖率表示最终的推荐列表中包含多大比例的物品。如果所有物品都被给推荐给至少一个用户, 那么覆盖率是100%。

+

+## 新颖度

+用推荐列表中物品的平均流行度度量推荐结果的新颖度。 如果推荐出的物品都很热门, 说明推荐的新颖度较低。 由于物品的流行度分布呈长尾分布, 所以为了流行度的平均值更加稳定, 在计算平均流行度时对每个物品的流行度取对数。

+

+- O’scar Celma 在博士论文 "[Music Recommendation and Discovery in the Long Tail](http://mtg.upf.edu/static/media/PhD_ocelma.pdf) " 中研究了新颖度的评测。

+

+

+

+# 参考资料

+

+* [基于用户的协同过滤来构建推荐系统:https://mp.weixin.qq.com/s/ZtnaQrVIpVOPJpqMdLWOcw](https://mp.weixin.qq.com/s/ZtnaQrVIpVOPJpqMdLWOcw)

+* [协同过滤算法概述:https://chenk.tech/posts/8ad63d9d.html](https://chenk.tech/posts/8ad63d9d.html)

+* B站黑马推荐系统实战课程

diff --git a/4.人工智能/ch02/ch2.1/ch2.1.2/Airbnb.md b/4.人工智能/ch02/ch2.1/ch2.1.2/Airbnb.md

new file mode 100644

index 0000000..65ce7bc

--- /dev/null

+++ b/4.人工智能/ch02/ch2.1/ch2.1.2/Airbnb.md

@@ -0,0 +1,332 @@

+# 前言

+这是 Airbnb 于2018年发表的一篇论文,主要介绍了 Airbnb 在 Embedding 技术上的应用,并获得了 KDD 2018 的 Best Paper。Airbnb 是全球最大的短租平台,包含了数百万种不同的房源。这篇论文介绍了 Airbnb 如何使用 Embedding 来实现相似房源推荐以及实时个性化搜索。在本文中,Airbnb 在用户和房源的 Embedding 上的生成都是基于谷歌的 Word2Vec 模型,故阅读本文要求大家了解 Word2Vec 模型,特别是 Skip-Gram 模型**(重点*)**。

+本文将从以下几个方面来介绍该论文:

+

+- 了解 Airbnb 是如何利用 Word2Vec 技术生成房源和用户的Embedding,并做出了哪些改进。

+- 了解 Airbnb 是如何利用 Embedding 解决房源冷启动问题。

+- 了解 Airbnb 是如何衡量生成的 Embedding 的有效性。

+- 了解 Airbnb 是如何利用用户和房源 Embedding 做召回和搜索排序。

+

+考虑到本文的目的是为了让大家快速了解 Airbnb 在 Embedding 技术上的应用,故不会完全翻译原论文。如需进一步了解,建议阅读原论文或文末的参考链接。原论文链接:https://dl.acm.org/doi/pdf/10.1145/3219819.3219885

+

+# Airbnb 的业务背景

+在介绍 Airbnb 在 Embedding 技术上的方法前,先了解 Airbnb 的业务背景。

+

+- Airbnb 平台包含数百万种不同的房源,用户可以通过**浏览搜索结果页面**来寻找想要的房源。Airbnb 技术团队通过复杂的机器学习模型,并使用上百种信号对搜索结果中的房源进行排序。

+- 当用户在查看某一个房源时,接下来的有两种方式继续搜索:

+ - 返回搜索结果页,继续查看其他搜索结果。

+

+ +

+ - 在当前房源的详情页下,「相似房源」板块(你可能还喜欢)所推荐的房源。

+

+

+

+ - 在当前房源的详情页下,「相似房源」板块(你可能还喜欢)所推荐的房源。

+

+ +

+- Airbnb 平台 99% 的房源预订来自于搜索排序和相似房源推荐。

+# Embedding 方法

+Airbnb 描述了两种 Embedding 的构建方法,分别为:

+

+- 用于描述短期实时性的个性化特征 Embedding:**listing Embeddings**

+ - **listing 表示房源的意思,它将贯穿全文,请务必了解。**

+- 用于描述长期的个性化特征 Embedding:**user-type & listing type Embeddings**

+## Listing Embeddings

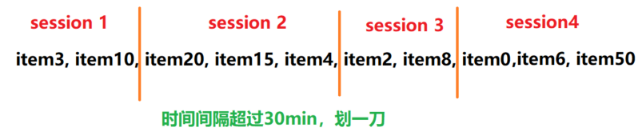

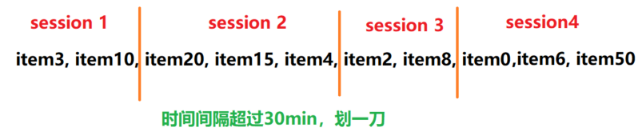

+Listing Embeddings 是基于用户的点击 session 学习得到的,用于表示房源的短期实时性特征。给定数据集 $ \mathcal{S} $ ,其中包含了 $ N $ 个用户的 $ S $ 个点击 session(序列)。

+

+- 每个 session $ s=\left(l_{1}, \ldots, l_{M}\right) \in \mathcal{S} $ ,包含了 $ M $ 个被用户点击过的 listing ids 。

+- 对于用户连续两次点击,若时间间隔超过了30分钟,则启动新的 session。

+

+在拿到多个用户点击的 session 后,可以基于 Word2Vec 的 Skip-Gram 模型来学习不同 listing 的 Embedding 表示。最大化目标函数 $ \mathcal{L} $ :

+$$

+\mathcal{L}=\sum_{s \in \mathcal{S}} \sum_{l_{i} \in s}\left(\sum_{-m \geq j \leq m, i \neq 0} \log \mathbb{P}\left(l_{i+j} \mid l_{i}\right)\right)

+$$

+概率 $ \mathbb{P}\left(l_{i+j} \mid l_{i}\right) $ 是基于 soft-max 函数的表达式。表示在一个 session 中,已知中心 listing $ l_i $ 来预测上下文 listing $ l_{i+j} $ 的概率:

+$$

+\mathbb{P}\left(l_{i+j} \mid l_{i}\right)=\frac{\exp \left(\mathbf{v}_{l_{i}}^{\top} \mathbf{v}_{l_{i+j}}^{\prime}\right)}{\sum_{l=1}^{|\mathcal{V}|} \exp \left(\mathbf{v}_{l_{i}}^{\top} \mathbf{v}_{l}^{\prime}\right)}

+$$

+

+- 其中, $ \mathbf{v}_{l_{i}} $ 表示 listing $ l_i $ 的 Embedding 向量, $ |\mathcal{V}| $ 表示全部的物料库的数量。

+

+考虑到物料库 $ \mathcal{V} $ 过大,模型中参数更新的时间成本和 $ |\mathcal{V}| $ 成正比。为了降低计算复杂度,要进行负采样。负采样后,优化的目标函数如下:

+$$

+\underset{\theta}{\operatorname{argmax}} \sum_{(l, c) \in \mathcal{D}_{p}} \log \frac{1}{1+e^{-\mathbf{v}_{c}^{\prime^{\prime}} \mathbf{v}_{l}}}+\sum_{(l, c) \in \mathcal{D}_{n}} \log \frac{1}{1+e^{\mathbf{v}_{c}^{\prime} \mathbf{v}_{l}}}

+$$

+至此,对 Skip-Gram 模型和 NEG 了解的同学肯定很熟悉,上述方法和 Word2Vec 思想基本一致。

+下面,将进一步介绍 Airbnb 是如何改进 Listing Embedding 的学习以及其他方面的应用。

+**(1)正负样本集构建的改进**

+

+- 使用 booked listing 作为全局上下文

+ - booked listing 表示用户在 session 中最终预定的房源,一般只会出现在结束的 session 中。

+ - Airbnb 将最终预定的房源,始终作为滑窗的上下文,即全局上下文。如下图:

+ - 如图,对于当前滑动窗口的 central listing,实线箭头表示context listings,虚线(指向booked listing)表示 global context listing。

+

+

+

+- Airbnb 平台 99% 的房源预订来自于搜索排序和相似房源推荐。

+# Embedding 方法

+Airbnb 描述了两种 Embedding 的构建方法,分别为:

+

+- 用于描述短期实时性的个性化特征 Embedding:**listing Embeddings**

+ - **listing 表示房源的意思,它将贯穿全文,请务必了解。**

+- 用于描述长期的个性化特征 Embedding:**user-type & listing type Embeddings**

+## Listing Embeddings

+Listing Embeddings 是基于用户的点击 session 学习得到的,用于表示房源的短期实时性特征。给定数据集 $ \mathcal{S} $ ,其中包含了 $ N $ 个用户的 $ S $ 个点击 session(序列)。

+

+- 每个 session $ s=\left(l_{1}, \ldots, l_{M}\right) \in \mathcal{S} $ ,包含了 $ M $ 个被用户点击过的 listing ids 。

+- 对于用户连续两次点击,若时间间隔超过了30分钟,则启动新的 session。

+

+在拿到多个用户点击的 session 后,可以基于 Word2Vec 的 Skip-Gram 模型来学习不同 listing 的 Embedding 表示。最大化目标函数 $ \mathcal{L} $ :

+$$

+\mathcal{L}=\sum_{s \in \mathcal{S}} \sum_{l_{i} \in s}\left(\sum_{-m \geq j \leq m, i \neq 0} \log \mathbb{P}\left(l_{i+j} \mid l_{i}\right)\right)

+$$

+概率 $ \mathbb{P}\left(l_{i+j} \mid l_{i}\right) $ 是基于 soft-max 函数的表达式。表示在一个 session 中,已知中心 listing $ l_i $ 来预测上下文 listing $ l_{i+j} $ 的概率:

+$$

+\mathbb{P}\left(l_{i+j} \mid l_{i}\right)=\frac{\exp \left(\mathbf{v}_{l_{i}}^{\top} \mathbf{v}_{l_{i+j}}^{\prime}\right)}{\sum_{l=1}^{|\mathcal{V}|} \exp \left(\mathbf{v}_{l_{i}}^{\top} \mathbf{v}_{l}^{\prime}\right)}

+$$

+

+- 其中, $ \mathbf{v}_{l_{i}} $ 表示 listing $ l_i $ 的 Embedding 向量, $ |\mathcal{V}| $ 表示全部的物料库的数量。

+

+考虑到物料库 $ \mathcal{V} $ 过大,模型中参数更新的时间成本和 $ |\mathcal{V}| $ 成正比。为了降低计算复杂度,要进行负采样。负采样后,优化的目标函数如下:

+$$

+\underset{\theta}{\operatorname{argmax}} \sum_{(l, c) \in \mathcal{D}_{p}} \log \frac{1}{1+e^{-\mathbf{v}_{c}^{\prime^{\prime}} \mathbf{v}_{l}}}+\sum_{(l, c) \in \mathcal{D}_{n}} \log \frac{1}{1+e^{\mathbf{v}_{c}^{\prime} \mathbf{v}_{l}}}

+$$

+至此,对 Skip-Gram 模型和 NEG 了解的同学肯定很熟悉,上述方法和 Word2Vec 思想基本一致。

+下面,将进一步介绍 Airbnb 是如何改进 Listing Embedding 的学习以及其他方面的应用。

+**(1)正负样本集构建的改进**

+

+- 使用 booked listing 作为全局上下文

+ - booked listing 表示用户在 session 中最终预定的房源,一般只会出现在结束的 session 中。

+ - Airbnb 将最终预定的房源,始终作为滑窗的上下文,即全局上下文。如下图:

+ - 如图,对于当前滑动窗口的 central listing,实线箭头表示context listings,虚线(指向booked listing)表示 global context listing。

+

+ +

+ - booked listing 作为全局正样本,故优化的目标函数更新为:

+

+$$

+\underset{\theta}{\operatorname{argmax}} \sum_{(l, c) \in \mathcal{D}_{p}} \log \frac{1}{1+e^{-\mathbf{v}_{c}^{\prime^{\prime}} \mathbf{v}_{l}}}+\sum_{(l, c) \in \mathcal{D}_{n}} \log \frac{1}{1+e^{\mathbf{v}_{c}^{\prime} \mathbf{v}_{l}}} +

+\log \frac{1}{1+e^{-\mathbf{v}_{c}^{\prime} \mathbf{v}_{l_b}}}

+$$

+

+- 优化负样本的选择

+ - 用户通过在线网站预定房间时,通常只会在同一个 market (将要停留区域)内进行搜索。

+

+ - 对于用户点击过的样本集 $ \mathcal{D}_{p} $ (正样本集)而言,它们大概率位于同一片区域。考虑到负样本集 $ \mathcal{D}_{n} $ 是随机抽取的,大概率来源不同的区域。

+

+ - Airbnb 发现这种样本的不平衡,在学习同一片区域房源的 Embedding 时会得到次优解。

+

+ - 解决办法也很简单,对于每个滑窗中的中心 lisitng,其负样本的选择新增了与其位于同一个 market 的 listing。至此,优化函数更新如下:

+ $$

+ \underset{\theta}{\operatorname{argmax}} \sum_{(l, c) \in \mathcal{D}_{p}} \log \frac{1}{1+e^{-\mathbf{v}_{c}^{\prime^{\prime}} \mathbf{v}_{l}}}+\sum_{(l, c) \in \mathcal{D}_{n}} \log \frac{1}{1+e^{\mathbf{v}_{c}^{\prime} \mathbf{v}_{l}}} +\log \frac{1}{1+e^{-\mathbf{v}_{c}^{\prime} \mathbf{v}_{l_b}}} +

+ \sum_{(l, m_n ) \in \mathcal{D}_{m_n}} \log \frac{1}{1+e^{\mathbf{v}_{m_n}^{\prime} \mathbf{v}_{l}}}

+ $$

+

+ + $ \mathcal{D}_{m_n} $ 表示与滑窗中的中心 listing 位于同一区域的负样本集。

+

+**(2)Listing Embedding 的冷启动**

+

+- Airbnb 每天都有新的 listings 产生,而这些 listings 却没有 Embedding 向量表征。

+- Airbnb 建议利用其他 listing 的现有的 Embedding 来为新的 listing 创建 Embedding。

+ - 在新的 listing 被创建后,房主需要提供如位置、价格、类型等在内的信息。

+ - 然后利用房主提供的房源信息,为其查找3个相似的 listing,并将它们 Embedding 的均值作为新 listing 的 Embedding表示。

+ - 这里的相似,包含了位置最近(10英里半径内),房源类型相似,价格区间相近。

+- 通过该手段,Airbnb 可以解决 98% 以上的新 listing 的 Embedding 冷启动问题。

+

+**(3)Listing Embedding 的评估**

+经过上述的两点对 Embedding 的改进后,为了评估改进后 listing Embedding 的效果。

+

+- Airbnb 使用了800万的点击 session,并将 Embedding 的维度设为32。

+

+评估方法包括:

+

+- 评估 Embedding 是否包含 listing 的地理位置相似性。

+ - 理论上,同一区域的房源相似性应该更高,不同区域房源相似性更低。

+ - Airbnb 利用 k-means 聚类,将加利福尼亚州的房源聚成100个集群,来验证类似位置的房源是否聚集在一起。

+

+

+

+ - booked listing 作为全局正样本,故优化的目标函数更新为:

+

+$$

+\underset{\theta}{\operatorname{argmax}} \sum_{(l, c) \in \mathcal{D}_{p}} \log \frac{1}{1+e^{-\mathbf{v}_{c}^{\prime^{\prime}} \mathbf{v}_{l}}}+\sum_{(l, c) \in \mathcal{D}_{n}} \log \frac{1}{1+e^{\mathbf{v}_{c}^{\prime} \mathbf{v}_{l}}} +

+\log \frac{1}{1+e^{-\mathbf{v}_{c}^{\prime} \mathbf{v}_{l_b}}}

+$$

+

+- 优化负样本的选择

+ - 用户通过在线网站预定房间时,通常只会在同一个 market (将要停留区域)内进行搜索。

+

+ - 对于用户点击过的样本集 $ \mathcal{D}_{p} $ (正样本集)而言,它们大概率位于同一片区域。考虑到负样本集 $ \mathcal{D}_{n} $ 是随机抽取的,大概率来源不同的区域。

+

+ - Airbnb 发现这种样本的不平衡,在学习同一片区域房源的 Embedding 时会得到次优解。

+

+ - 解决办法也很简单,对于每个滑窗中的中心 lisitng,其负样本的选择新增了与其位于同一个 market 的 listing。至此,优化函数更新如下:

+ $$

+ \underset{\theta}{\operatorname{argmax}} \sum_{(l, c) \in \mathcal{D}_{p}} \log \frac{1}{1+e^{-\mathbf{v}_{c}^{\prime^{\prime}} \mathbf{v}_{l}}}+\sum_{(l, c) \in \mathcal{D}_{n}} \log \frac{1}{1+e^{\mathbf{v}_{c}^{\prime} \mathbf{v}_{l}}} +\log \frac{1}{1+e^{-\mathbf{v}_{c}^{\prime} \mathbf{v}_{l_b}}} +

+ \sum_{(l, m_n ) \in \mathcal{D}_{m_n}} \log \frac{1}{1+e^{\mathbf{v}_{m_n}^{\prime} \mathbf{v}_{l}}}

+ $$

+

+ + $ \mathcal{D}_{m_n} $ 表示与滑窗中的中心 listing 位于同一区域的负样本集。

+

+**(2)Listing Embedding 的冷启动**

+

+- Airbnb 每天都有新的 listings 产生,而这些 listings 却没有 Embedding 向量表征。

+- Airbnb 建议利用其他 listing 的现有的 Embedding 来为新的 listing 创建 Embedding。

+ - 在新的 listing 被创建后,房主需要提供如位置、价格、类型等在内的信息。

+ - 然后利用房主提供的房源信息,为其查找3个相似的 listing,并将它们 Embedding 的均值作为新 listing 的 Embedding表示。

+ - 这里的相似,包含了位置最近(10英里半径内),房源类型相似,价格区间相近。

+- 通过该手段,Airbnb 可以解决 98% 以上的新 listing 的 Embedding 冷启动问题。

+

+**(3)Listing Embedding 的评估**

+经过上述的两点对 Embedding 的改进后,为了评估改进后 listing Embedding 的效果。

+

+- Airbnb 使用了800万的点击 session,并将 Embedding 的维度设为32。

+

+评估方法包括:

+

+- 评估 Embedding 是否包含 listing 的地理位置相似性。

+ - 理论上,同一区域的房源相似性应该更高,不同区域房源相似性更低。

+ - Airbnb 利用 k-means 聚类,将加利福尼亚州的房源聚成100个集群,来验证类似位置的房源是否聚集在一起。

+

+ +

+- 评估不同类型、价格区间的房源之间的相似性。

+ - 简而言之,我们希望类型相同、价格区间一致的房源它们之间的相似度更高。

+

+

+

+- 评估不同类型、价格区间的房源之间的相似性。

+ - 简而言之,我们希望类型相同、价格区间一致的房源它们之间的相似度更高。

+

+ +

+- 评估房源的隐式特征

+ - Airbnb 在训练房源(listing)的 Embedding时,并没有用到房源的图像信息。

+ - 对于一些隐式信息,例如架构、风格、观感等是无法直接学习。

+ - 为了验证基于 Word2Vec 学习到的 Embedding是否隐含了它们在外观等隐式信息上的相似性,Airbnb 内部开发了一款内部相似性探索工具。

+ - 大致原理就是,利用训练好的 Embedding 进行 K 近邻相似度检索。

+ - 如下,与查询房源在 Embedding 相似性高的其他房源,它们之间的外观风格也很相似。

+

+

+

+- 评估房源的隐式特征

+ - Airbnb 在训练房源(listing)的 Embedding时,并没有用到房源的图像信息。

+ - 对于一些隐式信息,例如架构、风格、观感等是无法直接学习。

+ - 为了验证基于 Word2Vec 学习到的 Embedding是否隐含了它们在外观等隐式信息上的相似性,Airbnb 内部开发了一款内部相似性探索工具。

+ - 大致原理就是,利用训练好的 Embedding 进行 K 近邻相似度检索。

+ - 如下,与查询房源在 Embedding 相似性高的其他房源,它们之间的外观风格也很相似。

+

+ +

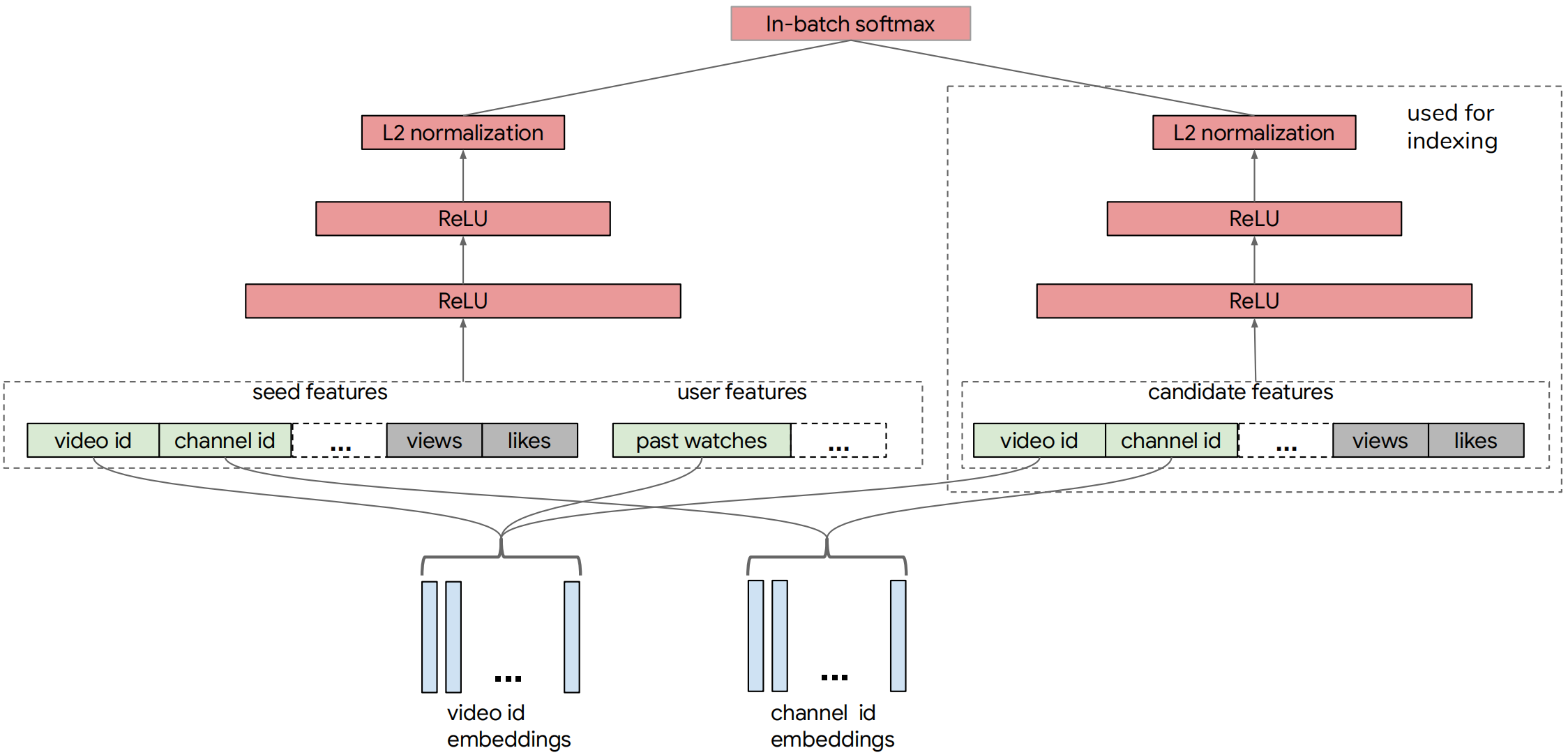

+## User-type & Listing-type Embedding

+

+前面提到的 Listing Embedding,它是基于用户的点击 sessions 学习得到的。

+

+- 同一个 session 内的点击时间间隔低于30分钟,所以**它们更适合短期,session 内的个性化需求**。

+- 在用户搜索 session 期间,该方法有利于向用户展示与点击过的 listing 更相似的其他 listings 。

+

+Airbnb 除了挖掘 Listing 的短期兴趣特征表示外,还对 User 和 Listing 的长期兴趣特征表示进行了探索。长期兴趣的探索是有利于 Airbnb 的业务发展。例如,用户当前在洛杉矶进行搜索,并且过去在纽约和伦敦预定过其他房源。那么,向用户推荐与之前预定过的 listing 相似的 listings 是更合适的。

+

+- 长期兴趣的探索是基于 booking session(用户的历史预定序列)。

+- 与前面 Listing Embedding 的学习类似,Airbnb 希望借助了 Skip-Gram 模型学习不同房源的 Embedding 表示。

+

+但是,面临着如下的挑战:

+

+- booking sessions $ \mathcal{S}_{b} $ 数据量的大小远远小于 click sessions $ \mathcal{S} $ ,因为预定本身就是一件低频率事件。

+- 许多用户过去只预定了单个数量的房源,无法从长度为1的 session 中学习 Embedding

+- 对于任何实体,要基于 context 学习到有意义的 Embedding,该实体至少在数据中出现5-10次。

+ - 但平台上大多数 listing_ids 被预定的次数低于5-10次。

+- 用户连续两次预定的时间间隔可能较长,在此期间用户的行为(如价格敏感点)偏好可能会发生改变(由于职业的变化)。

+

+为了解决该问题,Airbnb 提出了基于 booking session 来学习用户和房源的 Type Embedding。给定一个 booking sessions 集合 $ \mathcal{S}_{b} $ ,其中包含了 $ M $ 个用户的 booking session:

+

+- 每个 booking session 表示为: $ s_{b}=\left(l_{b 1}, \ldots, l_{b M}\right) $

+- 这里 $ l_{b1} $ 表示 listing_id,学习到 Embedding 记作 $ \mathbf{v}_{l_{i d}} $

+

+**(1)什么是Type Embedding ?**

+在介绍 Type Embedding 之前,回顾一下 Listing Embedding:

+

+- 在 Listing Embedding 的学习中,只学习房源的 Embedding 表示,未学习用户的 Embedding。

+- 对于 Listing Embedding,与相应的 Lisitng ID 是一一对应的, 每个 Listing 它们的 Embedding 表示是唯一的。

+

+对于 Type Embedding ,有如下的区别:

+

+- 对于不同的 Listing,它们的 Type Embedding **可能是相同的**(User 同样如此)。

+- Type Embedding 包含了 User-type Embedding 和 Listing-type Embedding。

+

+为了更直接快速地了解什么是 Listing-type 和 User-type,举个简单的例子:

+

+- 小王,是一名西藏人,性别男,今年21岁,就读于中国山东的蓝翔技校的挖掘机专业。

+- 通常,对于不同的用户(如小王),给定一个 ID 编码,然后学习相应的 User Embedding。

+ - 但前面说了,用户数据过于稀疏,学习到的 User Embedding 特征表达能力不好。

+- 另一种方式:利用小王身上的用户标签,先组合出他的 User-type,然后学习 Embedding 表示。

+ - 小王的 User-type:西藏人_男_学生_21岁_位置中国山东_南翔技校_挖掘机专业。

+ - 组合得到的 User-type 本质上可视为一个 Category 特征,然后学习其对应的 Embedding 表示。

+

+下表给出了原文中,Listing-type 和 User-type 包含的属性及属性的值:

+

+- 所有的属性,都基于一定的规则进行了分桶(buckets)。例如21岁,被分桶到 20-30 岁的区间。

+- 对于首次预定的用户,他的属性为 buckets 的前5行,因为预定之前没有历史预定相关的信息。

+

+

+

+## User-type & Listing-type Embedding

+

+前面提到的 Listing Embedding,它是基于用户的点击 sessions 学习得到的。

+

+- 同一个 session 内的点击时间间隔低于30分钟,所以**它们更适合短期,session 内的个性化需求**。

+- 在用户搜索 session 期间,该方法有利于向用户展示与点击过的 listing 更相似的其他 listings 。

+

+Airbnb 除了挖掘 Listing 的短期兴趣特征表示外,还对 User 和 Listing 的长期兴趣特征表示进行了探索。长期兴趣的探索是有利于 Airbnb 的业务发展。例如,用户当前在洛杉矶进行搜索,并且过去在纽约和伦敦预定过其他房源。那么,向用户推荐与之前预定过的 listing 相似的 listings 是更合适的。

+

+- 长期兴趣的探索是基于 booking session(用户的历史预定序列)。

+- 与前面 Listing Embedding 的学习类似,Airbnb 希望借助了 Skip-Gram 模型学习不同房源的 Embedding 表示。

+

+但是,面临着如下的挑战:

+

+- booking sessions $ \mathcal{S}_{b} $ 数据量的大小远远小于 click sessions $ \mathcal{S} $ ,因为预定本身就是一件低频率事件。

+- 许多用户过去只预定了单个数量的房源,无法从长度为1的 session 中学习 Embedding

+- 对于任何实体,要基于 context 学习到有意义的 Embedding,该实体至少在数据中出现5-10次。

+ - 但平台上大多数 listing_ids 被预定的次数低于5-10次。

+- 用户连续两次预定的时间间隔可能较长,在此期间用户的行为(如价格敏感点)偏好可能会发生改变(由于职业的变化)。

+

+为了解决该问题,Airbnb 提出了基于 booking session 来学习用户和房源的 Type Embedding。给定一个 booking sessions 集合 $ \mathcal{S}_{b} $ ,其中包含了 $ M $ 个用户的 booking session:

+

+- 每个 booking session 表示为: $ s_{b}=\left(l_{b 1}, \ldots, l_{b M}\right) $

+- 这里 $ l_{b1} $ 表示 listing_id,学习到 Embedding 记作 $ \mathbf{v}_{l_{i d}} $

+

+**(1)什么是Type Embedding ?**

+在介绍 Type Embedding 之前,回顾一下 Listing Embedding:

+

+- 在 Listing Embedding 的学习中,只学习房源的 Embedding 表示,未学习用户的 Embedding。

+- 对于 Listing Embedding,与相应的 Lisitng ID 是一一对应的, 每个 Listing 它们的 Embedding 表示是唯一的。

+

+对于 Type Embedding ,有如下的区别:

+

+- 对于不同的 Listing,它们的 Type Embedding **可能是相同的**(User 同样如此)。

+- Type Embedding 包含了 User-type Embedding 和 Listing-type Embedding。

+

+为了更直接快速地了解什么是 Listing-type 和 User-type,举个简单的例子:

+

+- 小王,是一名西藏人,性别男,今年21岁,就读于中国山东的蓝翔技校的挖掘机专业。

+- 通常,对于不同的用户(如小王),给定一个 ID 编码,然后学习相应的 User Embedding。

+ - 但前面说了,用户数据过于稀疏,学习到的 User Embedding 特征表达能力不好。

+- 另一种方式:利用小王身上的用户标签,先组合出他的 User-type,然后学习 Embedding 表示。

+ - 小王的 User-type:西藏人_男_学生_21岁_位置中国山东_南翔技校_挖掘机专业。

+ - 组合得到的 User-type 本质上可视为一个 Category 特征,然后学习其对应的 Embedding 表示。

+

+下表给出了原文中,Listing-type 和 User-type 包含的属性及属性的值:

+

+- 所有的属性,都基于一定的规则进行了分桶(buckets)。例如21岁,被分桶到 20-30 岁的区间。

+- 对于首次预定的用户,他的属性为 buckets 的前5行,因为预定之前没有历史预定相关的信息。

+

+ +

+看到过前面那个简单的例子后,现在可以看一个原文的 Listing-type 的例子:

+

+- 一个来自 US 的 Entire Home listing(lt1),它是一个二人间(c2),1 床(b1),一个卧室(bd2),1 个浴室(bt2),每晚平均价格为 60.8 美元(pn3),每晚每个客人的平均价格为 29.3 美元(pg3),5 个评价(r3),所有均 5 星好评(5s4),100% 的新客接受率(nu3)。

+- 因此该 listing 根据上表规则可以映射为:Listing-type = US_lt1_pn3_pg3_r3_5s4_c2_b1_bd2_bt2_nu3。

+

+**(2)Type Embedding 的好处**

+前面在介绍 Type Embedding 和 Listing Embedding 的区别时,提到过不同 User 或 Listing 他们的 Type 可能相同。

+

+- 故 User-type 和 Listing-type 在一定程度上可以缓解数据稀疏性的问题。

+- 对于 user 和 listing 而言,他们的属性可能会随着时间的推移而变化。

+ - 故它们的 Embedding 在时间上也具备了动态变化属性。

+

+**(3)Type Embedding 的训练过程**

+Type Embedding 的学习同样是基于 Skip-Gram 模型,但是有两点需要注意:

+

+- 联合训练 User-type Embedding 和 Listing-type Embedding

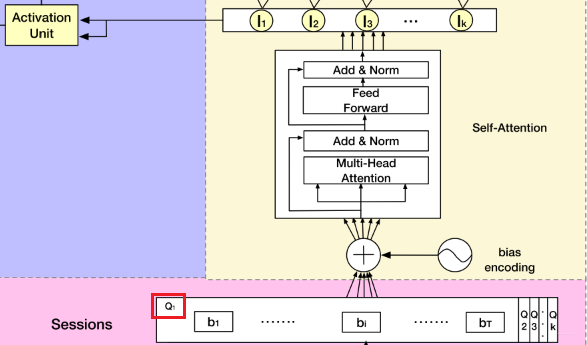

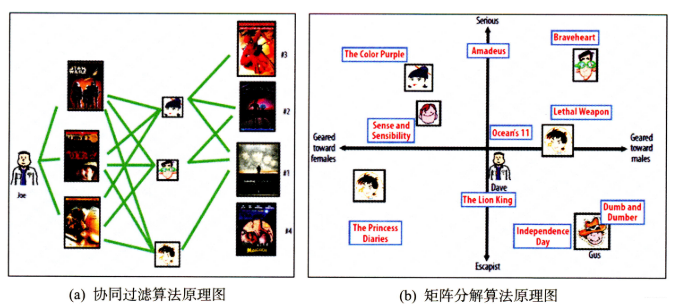

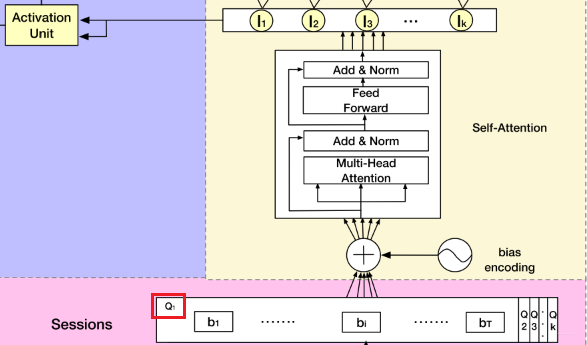

+ - 如下图(a),在 booking session 中,每个元素代表的是 (User-type, Listing-type)组合。

+ - 为了学习在相同向量空间中的 User-type 和 Listing-type 的 Embeddings,Airbnb 的做法是将 User-type 插入到 booking sessions 中。

+ - 形成一个(User-type, Listing-type)组成的元组序列,这样就可以让 User-type 和 Listing-type 的在 session 中的相对位置保持一致了。

+

+ - User-type 的目标函数:

+ $$

+ \underset{\theta}{\operatorname{argmax}} \sum_{\left(u_{t}, c\right) \in \mathcal{D}_{b o o k}} \log \frac{1}{1+e^{-\mathbf{v}_{c}^{\prime} \mathbf{v}_{u_{t}}}}+\sum_{\left(u_{t}, c\right) \in \mathcal{D}_{n e g}} \log \frac{1}{1+e^{\mathbf{v}_{c}^{\prime} \mathbf{v}_{u_{t}}}}

+ $$

+

+ + $ \mathcal{D}_{\text {book }} $ 中的 $ u_t $ (中心词)表示 User-type, $ c $ (上下文)表示用户最近的预定过的 Listing-type。 $ \mathcal{D}_{\text {neg}} $ 中的 $ c $ 表示 negative Listing-type。

+ + $ u_t $ 表示 User-type 的 Embedding, $ \mathbf{v}_{c}^{\prime} $ 表示 Listing-type 的Embedding。

+

+ - Listing-type 的目标函数:

+ $$

+ \begin{aligned}

+ \underset{\theta}{\operatorname{argmax}} & \sum_{\left(l_{t}, c\right) \in \mathcal{D}_{b o o k}} \log \frac{1}{1+\exp ^{-\mathrm{v}_{c}^{\prime} \mathbf{v}_{l_{t}}}}+\sum_{\left(l_{t}, c\right) \in \mathcal{D}_{n e g}} \log \frac{1}{1+\exp ^{\mathrm{v}_{c}^{\prime} \mathbf{v}_{l_{t}}}} \\

+ \end{aligned}

+ $$

+

+ + 同理,不过窗口中的中心词为 Listing-type, 上下文为 User-type。

+

+- Explicit Negatives for Rejections

+ - 用户预定房源以后,还要等待房源主人的确认,主人可能接受或者拒绝客人的预定。

+ - 拒接的原因可能包括,客人星级评定不佳,资料不完整等。

+

+ - 前面学习到的 User-type Embedding 包含了客人的兴趣偏好,Listing-type Embedding 包含了房源的属性特征。

+ - 但是,用户的 Embedding 未包含更容易被哪类房源主人拒绝的潜语义信息。

+ - 房源的 Embedding 未包含主人对哪类客人的拒绝偏好。

+

+ - 为了提高用户预定房源以后,被主人接受的概率。同时,降低房源主人拒绝客人的概率。Airbnb 在训练 User-type 和 Listing-type 的 Embedding时,将用户预定后却被拒绝的样本加入负样本集中(如下图b)。

+ - 更新后,Listing-type 的目标函数:

+ $$

+ \begin{aligned}

+ \underset{\theta}{\operatorname{argmax}} & \sum_{\left(u_{t}, c\right) \in \mathcal{D}_{b o o k}} \log \frac{1}{1+\exp ^{-\mathbf{v}_{c}^{\prime} \mathbf{v}_{u_{t}}}}+\sum_{\left(u_{t}, c\right) \in \mathcal{D}_{n e g}} \log \frac{1}{1+\exp ^{\mathbf{v}_{c}^{\prime} \mathbf{v}_{u_{t}}}} \\

+ &+\sum_{\left(u_{t}, l_{t}\right) \in \mathcal{D}_{\text {reject }}} \log \frac{1}{1+\exp ^{\mathrm{v}_{{l_{t}}}^{\prime} \mathrm{v}_{u_{t}}}}

+ \end{aligned}

+ $$

+

+ - 更新后,User-type 的目标函数:

+ $$

+ \begin{aligned}

+ \underset{\theta}{\operatorname{argmax}} & \sum_{\left(l_{t}, c\right) \in \mathcal{D}_{b o o k}} \log \frac{1}{1+\exp ^{-\mathrm{v}_{c}^{\prime} \mathbf{v}_{l_{t}}}}+\sum_{\left(l_{t}, c\right) \in \mathcal{D}_{n e g}} \log \frac{1}{1+\exp ^{\mathrm{v}_{c}^{\prime} \mathbf{v}_{l_{t}}}} \\

+ &+\sum_{\left(l_{t}, u_{t}\right) \in \mathcal{D}_{\text {reject }}} \log \frac{1}{1+\exp ^{\mathrm{v}^{\prime}_{u_{t}} \mathrm{v}_{l_{t}}}}

+ \end{aligned}

+ $$

+

+

+

+看到过前面那个简单的例子后,现在可以看一个原文的 Listing-type 的例子:

+

+- 一个来自 US 的 Entire Home listing(lt1),它是一个二人间(c2),1 床(b1),一个卧室(bd2),1 个浴室(bt2),每晚平均价格为 60.8 美元(pn3),每晚每个客人的平均价格为 29.3 美元(pg3),5 个评价(r3),所有均 5 星好评(5s4),100% 的新客接受率(nu3)。

+- 因此该 listing 根据上表规则可以映射为:Listing-type = US_lt1_pn3_pg3_r3_5s4_c2_b1_bd2_bt2_nu3。

+

+**(2)Type Embedding 的好处**

+前面在介绍 Type Embedding 和 Listing Embedding 的区别时,提到过不同 User 或 Listing 他们的 Type 可能相同。

+

+- 故 User-type 和 Listing-type 在一定程度上可以缓解数据稀疏性的问题。

+- 对于 user 和 listing 而言,他们的属性可能会随着时间的推移而变化。

+ - 故它们的 Embedding 在时间上也具备了动态变化属性。

+

+**(3)Type Embedding 的训练过程**

+Type Embedding 的学习同样是基于 Skip-Gram 模型,但是有两点需要注意:

+

+- 联合训练 User-type Embedding 和 Listing-type Embedding

+ - 如下图(a),在 booking session 中,每个元素代表的是 (User-type, Listing-type)组合。

+ - 为了学习在相同向量空间中的 User-type 和 Listing-type 的 Embeddings,Airbnb 的做法是将 User-type 插入到 booking sessions 中。

+ - 形成一个(User-type, Listing-type)组成的元组序列,这样就可以让 User-type 和 Listing-type 的在 session 中的相对位置保持一致了。

+

+ - User-type 的目标函数:

+ $$

+ \underset{\theta}{\operatorname{argmax}} \sum_{\left(u_{t}, c\right) \in \mathcal{D}_{b o o k}} \log \frac{1}{1+e^{-\mathbf{v}_{c}^{\prime} \mathbf{v}_{u_{t}}}}+\sum_{\left(u_{t}, c\right) \in \mathcal{D}_{n e g}} \log \frac{1}{1+e^{\mathbf{v}_{c}^{\prime} \mathbf{v}_{u_{t}}}}

+ $$

+

+ + $ \mathcal{D}_{\text {book }} $ 中的 $ u_t $ (中心词)表示 User-type, $ c $ (上下文)表示用户最近的预定过的 Listing-type。 $ \mathcal{D}_{\text {neg}} $ 中的 $ c $ 表示 negative Listing-type。

+ + $ u_t $ 表示 User-type 的 Embedding, $ \mathbf{v}_{c}^{\prime} $ 表示 Listing-type 的Embedding。

+

+ - Listing-type 的目标函数:

+ $$

+ \begin{aligned}

+ \underset{\theta}{\operatorname{argmax}} & \sum_{\left(l_{t}, c\right) \in \mathcal{D}_{b o o k}} \log \frac{1}{1+\exp ^{-\mathrm{v}_{c}^{\prime} \mathbf{v}_{l_{t}}}}+\sum_{\left(l_{t}, c\right) \in \mathcal{D}_{n e g}} \log \frac{1}{1+\exp ^{\mathrm{v}_{c}^{\prime} \mathbf{v}_{l_{t}}}} \\

+ \end{aligned}

+ $$

+

+ + 同理,不过窗口中的中心词为 Listing-type, 上下文为 User-type。

+

+- Explicit Negatives for Rejections

+ - 用户预定房源以后,还要等待房源主人的确认,主人可能接受或者拒绝客人的预定。

+ - 拒接的原因可能包括,客人星级评定不佳,资料不完整等。

+

+ - 前面学习到的 User-type Embedding 包含了客人的兴趣偏好,Listing-type Embedding 包含了房源的属性特征。

+ - 但是,用户的 Embedding 未包含更容易被哪类房源主人拒绝的潜语义信息。

+ - 房源的 Embedding 未包含主人对哪类客人的拒绝偏好。

+

+ - 为了提高用户预定房源以后,被主人接受的概率。同时,降低房源主人拒绝客人的概率。Airbnb 在训练 User-type 和 Listing-type 的 Embedding时,将用户预定后却被拒绝的样本加入负样本集中(如下图b)。

+ - 更新后,Listing-type 的目标函数:

+ $$

+ \begin{aligned}

+ \underset{\theta}{\operatorname{argmax}} & \sum_{\left(u_{t}, c\right) \in \mathcal{D}_{b o o k}} \log \frac{1}{1+\exp ^{-\mathbf{v}_{c}^{\prime} \mathbf{v}_{u_{t}}}}+\sum_{\left(u_{t}, c\right) \in \mathcal{D}_{n e g}} \log \frac{1}{1+\exp ^{\mathbf{v}_{c}^{\prime} \mathbf{v}_{u_{t}}}} \\

+ &+\sum_{\left(u_{t}, l_{t}\right) \in \mathcal{D}_{\text {reject }}} \log \frac{1}{1+\exp ^{\mathrm{v}_{{l_{t}}}^{\prime} \mathrm{v}_{u_{t}}}}

+ \end{aligned}

+ $$

+

+ - 更新后,User-type 的目标函数:

+ $$

+ \begin{aligned}

+ \underset{\theta}{\operatorname{argmax}} & \sum_{\left(l_{t}, c\right) \in \mathcal{D}_{b o o k}} \log \frac{1}{1+\exp ^{-\mathrm{v}_{c}^{\prime} \mathbf{v}_{l_{t}}}}+\sum_{\left(l_{t}, c\right) \in \mathcal{D}_{n e g}} \log \frac{1}{1+\exp ^{\mathrm{v}_{c}^{\prime} \mathbf{v}_{l_{t}}}} \\

+ &+\sum_{\left(l_{t}, u_{t}\right) \in \mathcal{D}_{\text {reject }}} \log \frac{1}{1+\exp ^{\mathrm{v}^{\prime}_{u_{t}} \mathrm{v}_{l_{t}}}}

+ \end{aligned}

+ $$

+

+ +

+# 实验部分

+

+前面介绍了两种 Embedding 的生成方法,分别为 Listing Embedding 和 User-type & Listing-type Embedding。本节的实验部分,将会介绍它们是如何被使用的。回顾 Airbnb 的业务背景,当用户查看一个房源时,他们有两种方式继续搜索:返回搜索结果页,或者查看房源详情页的「相似房源」。

+## 相似房源检索

+在给定学习到的 Listing Embedding,通过计算其向量 $ v_l $ 和来自同一区域的所有 Listing 的向量 $ v_j $ 之间的余弦相似度,可以找到给定房源 $ l $ 的相似房源。

+

+- 这些相似房源可在同一日期被预定(如果入住-离开时间已确定)。

+- 相似度最高的 $ K $ 个房源被检索为相似房源。

+- 计算是在线执行的,并使用我们的分片架构并行进行,其中部分 Embedding 存储在每个搜索机器上。

+

+A/B 测试显示,基于 Embedding 的解决方案使「相似房源」点击率增加了21%,最终通过「相似房源」产生的预订增加了 4.9%。

+

+## 实时个性化搜索排名

+Airbnb 的搜索排名的大致流程为:

+

+- 给定查询 $ q $ ,返回 $ K $ 条搜索结果。

+- 基于排序模型 GBDT,对预测结果进行排序。

+- 将排序后的结果展示给用户。

+

+**(1)Query Embedding**

+原文中似乎并没有详细介绍 Airbnb 的搜索技术,在参考的博客中对他们的 Query Embedding 技术进行了描述。如下:

+

+> Airbnb 对搜索的 Query 也进行了 Embedding,和普通搜索引擎的 Embedding 不太相同的是,这里的 Embedding 不是用自然语言中的语料库去训练的,而是用 Search Session 作为关系训练数据,训练方式更类似于 Item2Vec,Airbnb 中 Queue Embedding 的一个很重要的作用是捕获用户模糊查询与相关目的地的关联,这样做的好处是可以使搜索结果不再仅仅是简单地进行关键字匹配,而是通过更深层次的语义和关系来找到关联信息。比如下图所示的使用 Query Embedding 之前和之后的两个示例(Airbnb 非常人性化地在搜索栏的添加了自动补全,通过算法去 “猜想” 用户的真实目的,大大提高了用户的检索体验)

+

+**(2)特征构建**

+对于各查询,给定的训练数据形式为: $ D_s = \left(\mathbf{x}_{i}, y_{i}\right), i=1 \ldots K $ ,其中 $ K $ 表示查询返回的房源数量。

+

+- $ \mathbf{x}_{i} $ 表示第 $ i $ 个房源结果的 vector containing features:

+ - 由 listing features,user features,query features 以及 cross-features 组成。

+- $ y_{i} \in\{0,0.01,0.25,1,-0.4\} $ 表示第 $ i $ 个结果的标签。

+ - $ y_i=1 $ 表示用户预定了房源,..., $ y_i=-0.4 $ 表示房主拒绝了用户。

+

+下面,介绍 Airbnb 是如何利用前面的两种种 Embedding 进行特征构建的。

+

+- 如果用一句话来概括,这些基于 Embedding 的构建特征均为余弦相似度。

+- 新构建的特征均为样本 $ \mathbf{x}_{i} $ 特征的一部分。

+

+构建的特征如下表所示:

+

+- 表中的 Embedding Features 包含了8种类型,前6种类型的特征计算方式相同。

+

+

+

+# 实验部分

+

+前面介绍了两种 Embedding 的生成方法,分别为 Listing Embedding 和 User-type & Listing-type Embedding。本节的实验部分,将会介绍它们是如何被使用的。回顾 Airbnb 的业务背景,当用户查看一个房源时,他们有两种方式继续搜索:返回搜索结果页,或者查看房源详情页的「相似房源」。

+## 相似房源检索

+在给定学习到的 Listing Embedding,通过计算其向量 $ v_l $ 和来自同一区域的所有 Listing 的向量 $ v_j $ 之间的余弦相似度,可以找到给定房源 $ l $ 的相似房源。

+

+- 这些相似房源可在同一日期被预定(如果入住-离开时间已确定)。

+- 相似度最高的 $ K $ 个房源被检索为相似房源。

+- 计算是在线执行的,并使用我们的分片架构并行进行,其中部分 Embedding 存储在每个搜索机器上。

+

+A/B 测试显示,基于 Embedding 的解决方案使「相似房源」点击率增加了21%,最终通过「相似房源」产生的预订增加了 4.9%。

+

+## 实时个性化搜索排名

+Airbnb 的搜索排名的大致流程为:

+

+- 给定查询 $ q $ ,返回 $ K $ 条搜索结果。

+- 基于排序模型 GBDT,对预测结果进行排序。

+- 将排序后的结果展示给用户。

+

+**(1)Query Embedding**

+原文中似乎并没有详细介绍 Airbnb 的搜索技术,在参考的博客中对他们的 Query Embedding 技术进行了描述。如下:

+

+> Airbnb 对搜索的 Query 也进行了 Embedding,和普通搜索引擎的 Embedding 不太相同的是,这里的 Embedding 不是用自然语言中的语料库去训练的,而是用 Search Session 作为关系训练数据,训练方式更类似于 Item2Vec,Airbnb 中 Queue Embedding 的一个很重要的作用是捕获用户模糊查询与相关目的地的关联,这样做的好处是可以使搜索结果不再仅仅是简单地进行关键字匹配,而是通过更深层次的语义和关系来找到关联信息。比如下图所示的使用 Query Embedding 之前和之后的两个示例(Airbnb 非常人性化地在搜索栏的添加了自动补全,通过算法去 “猜想” 用户的真实目的,大大提高了用户的检索体验)

+

+**(2)特征构建**

+对于各查询,给定的训练数据形式为: $ D_s = \left(\mathbf{x}_{i}, y_{i}\right), i=1 \ldots K $ ,其中 $ K $ 表示查询返回的房源数量。

+

+- $ \mathbf{x}_{i} $ 表示第 $ i $ 个房源结果的 vector containing features:

+ - 由 listing features,user features,query features 以及 cross-features 组成。

+- $ y_{i} \in\{0,0.01,0.25,1,-0.4\} $ 表示第 $ i $ 个结果的标签。

+ - $ y_i=1 $ 表示用户预定了房源,..., $ y_i=-0.4 $ 表示房主拒绝了用户。

+

+下面,介绍 Airbnb 是如何利用前面的两种种 Embedding 进行特征构建的。

+

+- 如果用一句话来概括,这些基于 Embedding 的构建特征均为余弦相似度。

+- 新构建的特征均为样本 $ \mathbf{x}_{i} $ 特征的一部分。

+

+构建的特征如下表所示:

+

+- 表中的 Embedding Features 包含了8种类型,前6种类型的特征计算方式相同。

+

+ +

+**① 基于 Listing Embedding Features 的特征构建**

+

+- Airbnb 保留了用户过去两周6种不同类型的历史行为,如下图:

+

+

+

+**① 基于 Listing Embedding Features 的特征构建**

+

+- Airbnb 保留了用户过去两周6种不同类型的历史行为,如下图:

+

+ +

+- 对于每个行为,还要将其按照 market (地域)进行划分。以 $ H_c $ 为例:

+

+ - 假如 $ H_c $ 包含了 New YorK 和 Los Angeles 两个 market 的点击记录,则划分为 $ H_c(NY) $ 和 $ H_c(LA) $ 。

+

+ - 计算候选房源和不同行为之间的相似度。

+ - 上述6种行为对应的相似度特征计算方式是相同的,以 $ H_c $ 为例:

+ $$

+ \operatorname{EmbClickSim}\left(l_{i}, H_{c}\right)=\max _{m \in M} \cos \left(\mathbf{v}_{l_{i}}, \sum_{l_{h} \in m, l_{h} \in H_{c}} \mathbf{v}_{l_{h}}\right)

+ $$

+

+ - 其中, $ M $ 表示 market 的集合。第二项实际上为 Centroid Embedding(Embedding 的均值)。

+

+- 除此之外,Airbnb 还计算了候选房源的 Embedding 与 latest long click 的 Embedding 之间的余弦相似度。

+ $$

+ \operatorname{EmbLastLongClickSim }\left(l_{i}, H_{l c}\right)=\cos \left(\mathbf{v}_{l_{i}}, \mathbf{v}_{l_{\text {last }}}\right)

+ $$

+

+**② 基于 User-type & Listing-type Embedding Features 的特征构建**

+

+- 对于候选房源 $ l_i $ ,先查到其对应的 Listing-type $ l_t $ ,再找到用户的 User-type $ u_t $ 。

+

+- 最后,计算 $ u_t $ 与 $ l_t $ 对应的 Embedding 之间的余弦相似度:

+ $$

+ \text { UserTypeListingTypeSim }\left(u_{t}, l_{t}\right)=\cos \left(\mathbf{v}_{u_{t}}, \mathbf{v}_{l_{t}}\right)

+ $$

+

+为了验证上述特征的构建是否有效,Airbnb 还做了特征重要性排序,如下表:

+

+

+

+- 对于每个行为,还要将其按照 market (地域)进行划分。以 $ H_c $ 为例:

+

+ - 假如 $ H_c $ 包含了 New YorK 和 Los Angeles 两个 market 的点击记录,则划分为 $ H_c(NY) $ 和 $ H_c(LA) $ 。

+

+ - 计算候选房源和不同行为之间的相似度。

+ - 上述6种行为对应的相似度特征计算方式是相同的,以 $ H_c $ 为例:

+ $$

+ \operatorname{EmbClickSim}\left(l_{i}, H_{c}\right)=\max _{m \in M} \cos \left(\mathbf{v}_{l_{i}}, \sum_{l_{h} \in m, l_{h} \in H_{c}} \mathbf{v}_{l_{h}}\right)

+ $$

+

+ - 其中, $ M $ 表示 market 的集合。第二项实际上为 Centroid Embedding(Embedding 的均值)。

+

+- 除此之外,Airbnb 还计算了候选房源的 Embedding 与 latest long click 的 Embedding 之间的余弦相似度。

+ $$

+ \operatorname{EmbLastLongClickSim }\left(l_{i}, H_{l c}\right)=\cos \left(\mathbf{v}_{l_{i}}, \mathbf{v}_{l_{\text {last }}}\right)

+ $$

+

+**② 基于 User-type & Listing-type Embedding Features 的特征构建**

+

+- 对于候选房源 $ l_i $ ,先查到其对应的 Listing-type $ l_t $ ,再找到用户的 User-type $ u_t $ 。

+

+- 最后,计算 $ u_t $ 与 $ l_t $ 对应的 Embedding 之间的余弦相似度:

+ $$

+ \text { UserTypeListingTypeSim }\left(u_{t}, l_{t}\right)=\cos \left(\mathbf{v}_{u_{t}}, \mathbf{v}_{l_{t}}\right)

+ $$

+

+为了验证上述特征的构建是否有效,Airbnb 还做了特征重要性排序,如下表:

+

+ +

+**(3)模型**

+特征构建完成后,开始对模型进行训练。

+

+- Airbnb 在搜索排名中使用的是 GBDT 模型,该模型是一个回归模型。

+- 模型的训练数据包括数据集 $ \mathcal{D} $ 和 search labels 。

+

+最后,利用 GBDT 模型来预测线上各搜索房源的在线分数。得到预测分数后,将按照降序的方式展现给用户。

+# 参考链接

+

++ [Embedding 在大厂推荐场景中的工程化实践 - 卢明冬的博客 (lumingdong.cn)](https://lumingdong.cn/engineering-practice-of-embedding-in-recommendation-scenario.html#Airbnb)

+

++ [KDD'2018 Best Paper-Embedding技术在Airbnb实时搜索排序中的应用 (qq.com)](https://mp.weixin.qq.com/s/f9IshxX29sWg9NhSa7CaNg)

+

++ [再评Airbnb的经典Embedding论文 - 知乎 (zhihu.com)](https://zhuanlan.zhihu.com/p/162163054)

+

++ [Airbnb爱彼迎房源排序中的嵌入(Embedding)技术 - 知乎 (zhihu.com)](https://zhuanlan.zhihu.com/p/43295545)

diff --git a/4.人工智能/ch02/ch2.1/ch2.1.2/DSSM.md b/4.人工智能/ch02/ch2.1/ch2.1.2/DSSM.md

new file mode 100644

index 0000000..8c94c46

--- /dev/null

+++ b/4.人工智能/ch02/ch2.1/ch2.1.2/DSSM.md

@@ -0,0 +1,629 @@

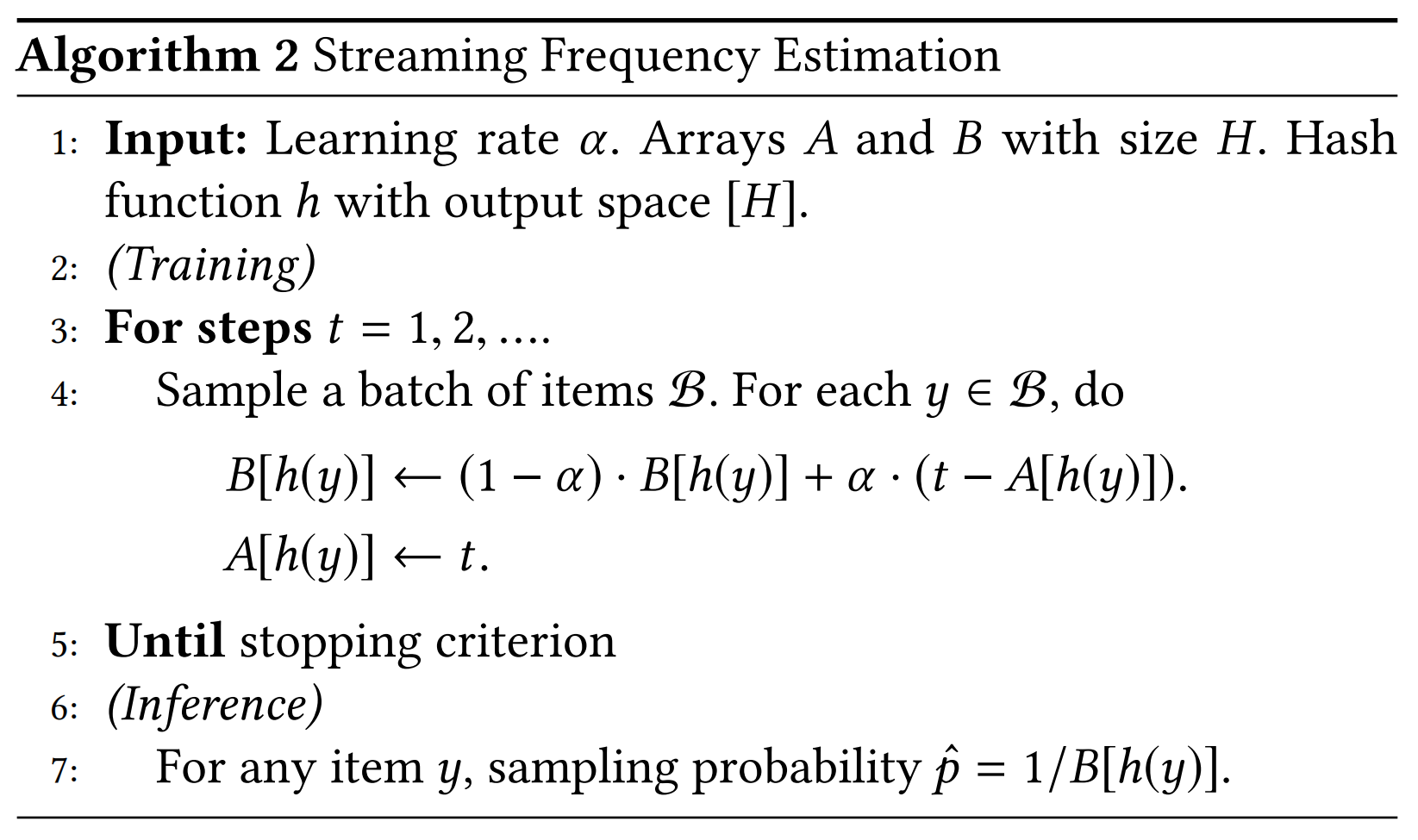

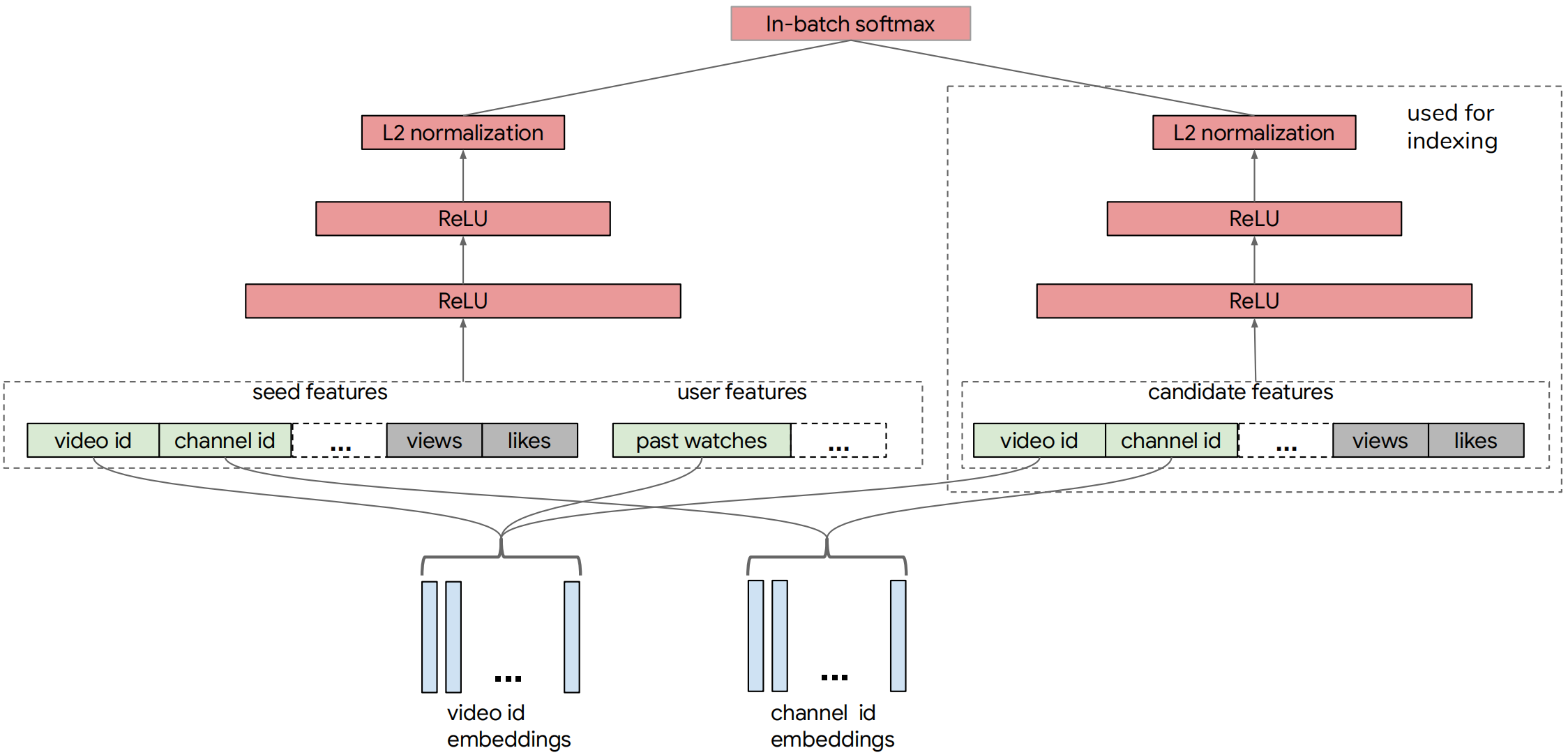

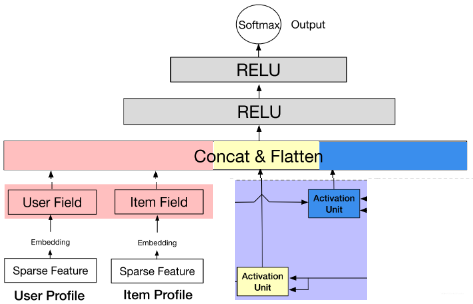

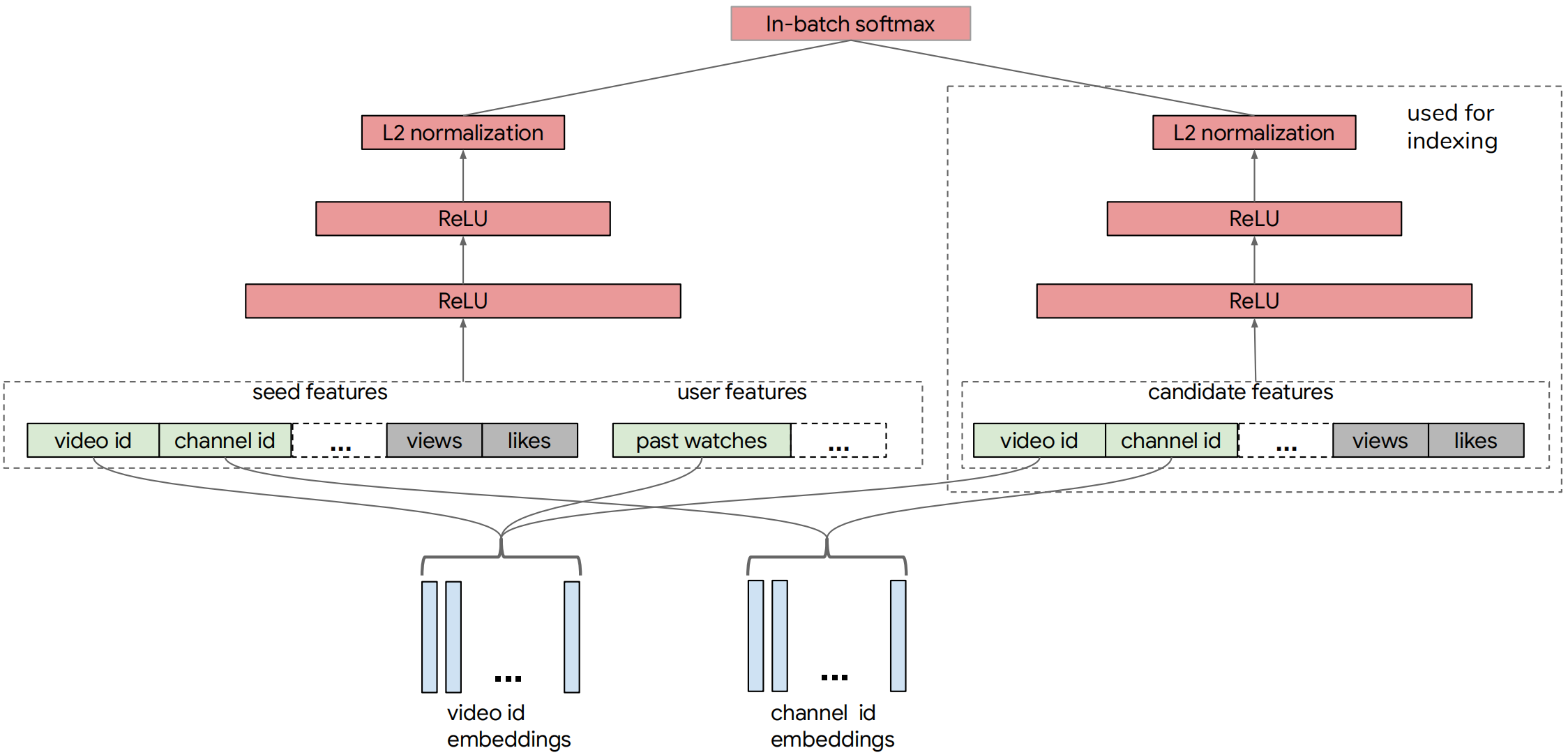

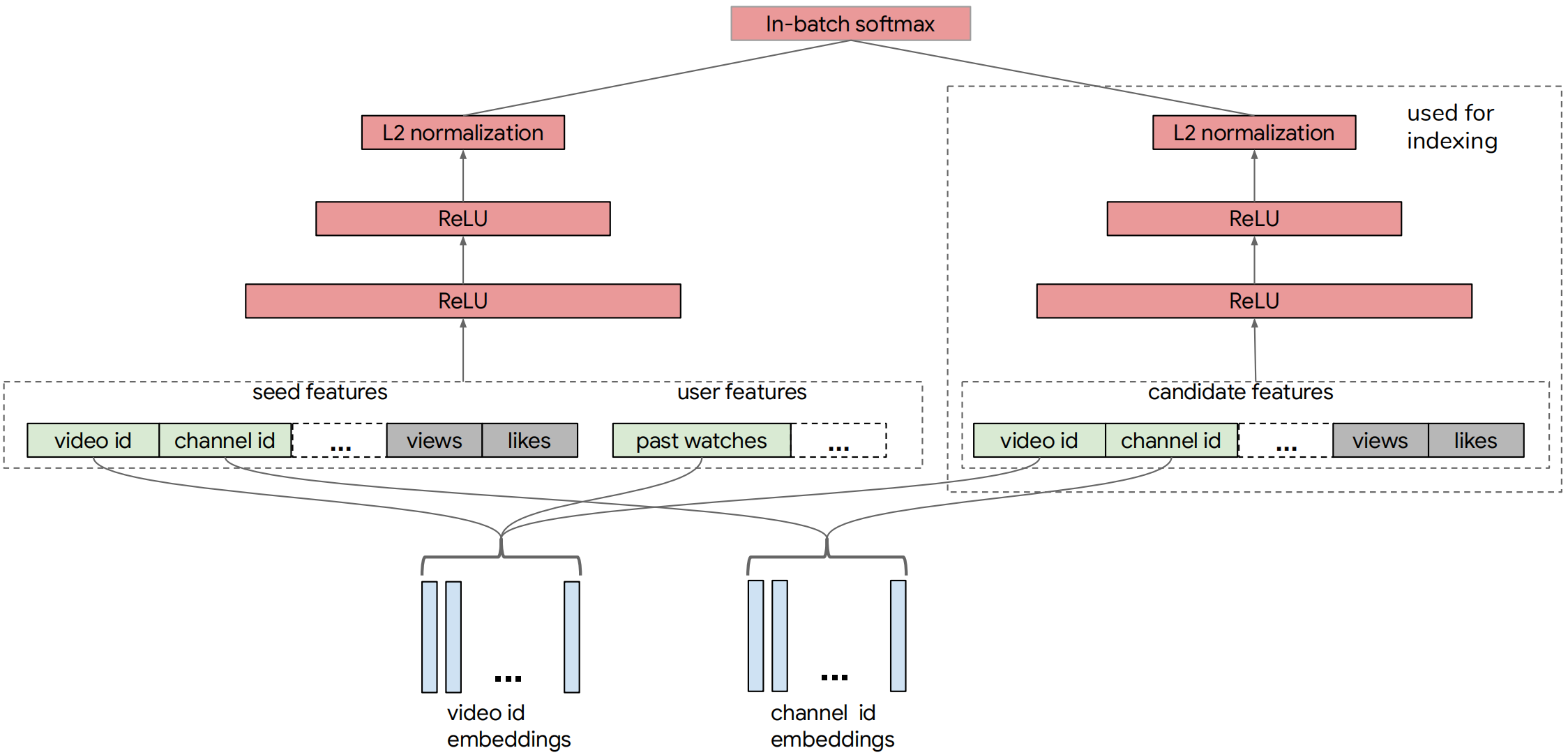

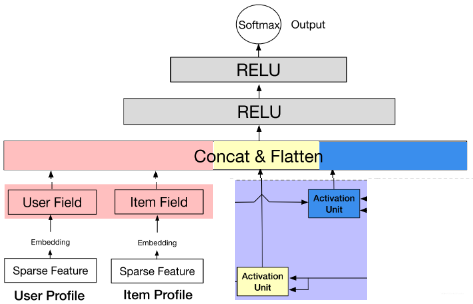

+# 双塔召回模型

+

+---

+

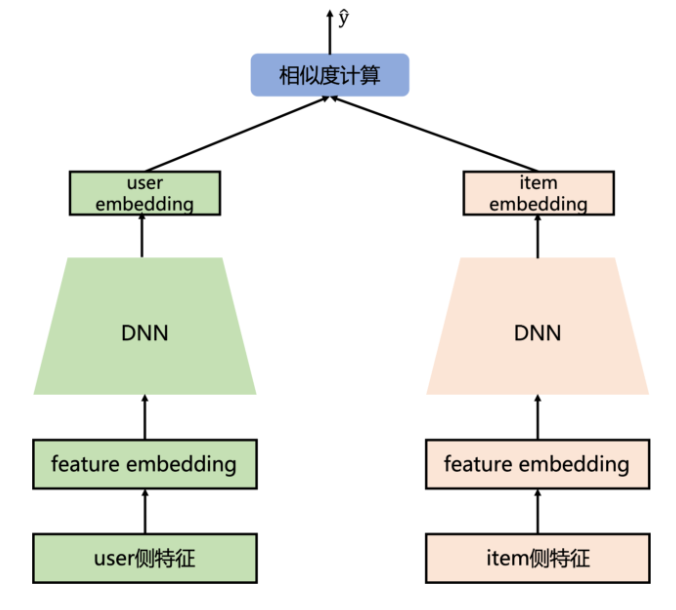

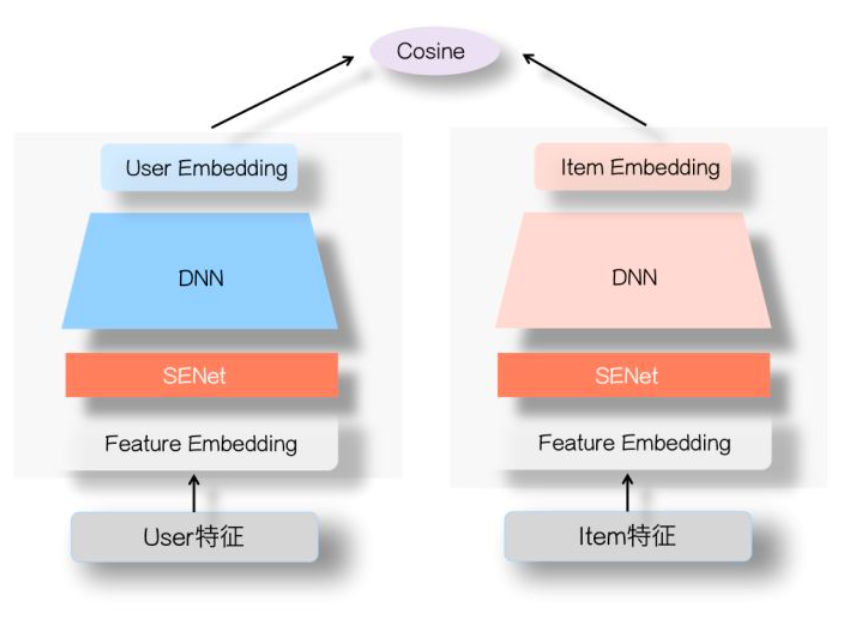

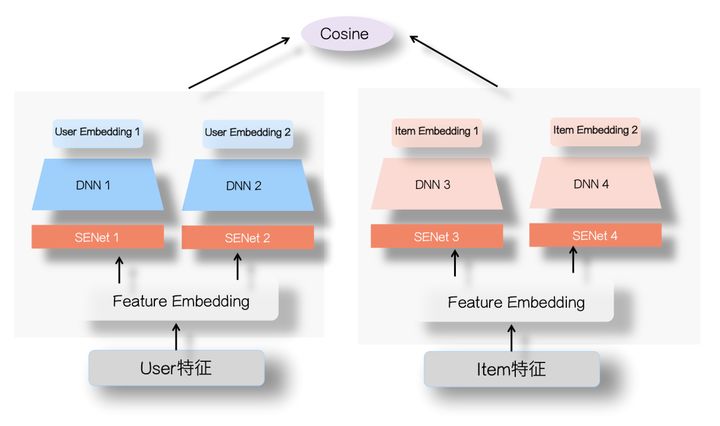

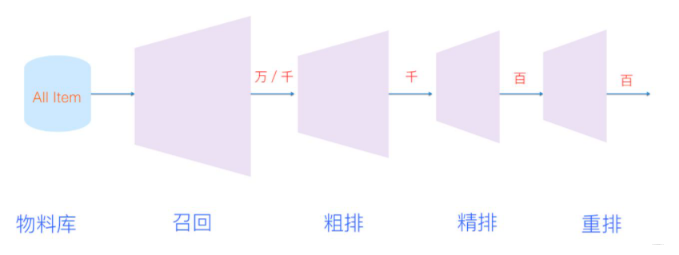

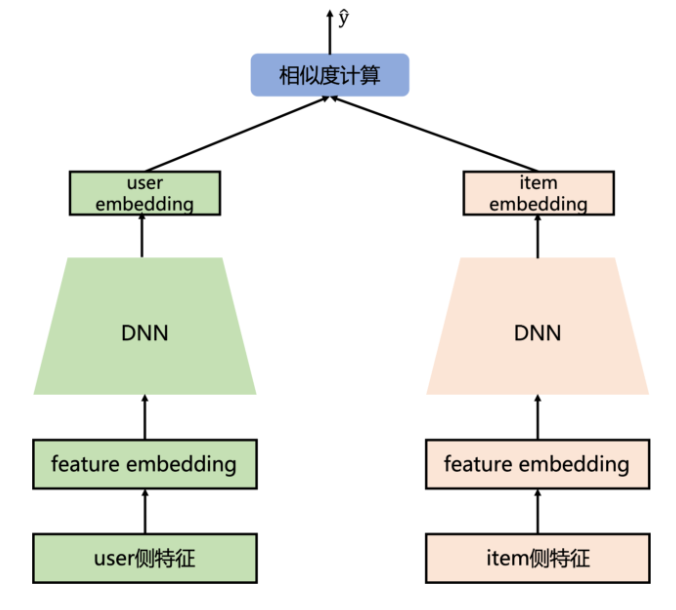

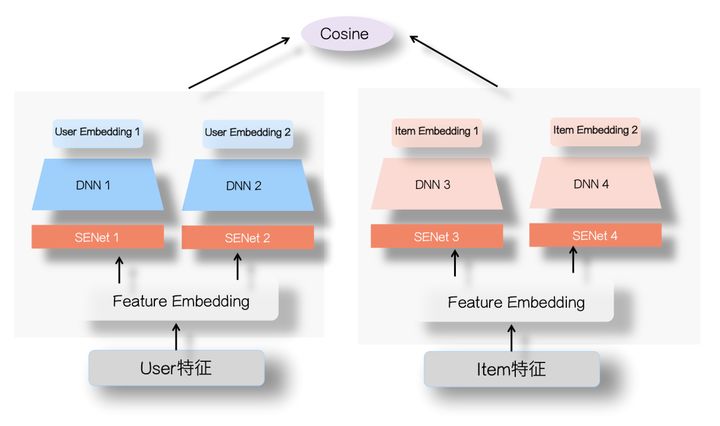

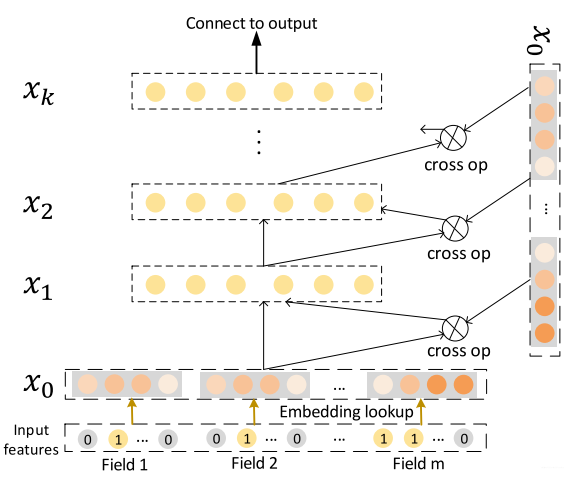

+双塔模型在推荐领域中是一个十分经典的模型,无论是在召回还是粗排阶段,都会是首选。这主要是得益于双塔模型结构,使得能够在线预估时满足低延时的要求。但也是因为其模型结构的问题,使得无法考虑到user和item特之间的特征交叉,使得影响模型最终效果,因此很多工作尝试调整经典双塔模型结构,在保持在线预估低延时的同时,保证双塔两侧之间有效的信息交叉。下面针对于经典双塔模型以及一些改进版本进行介绍。

+

+

+

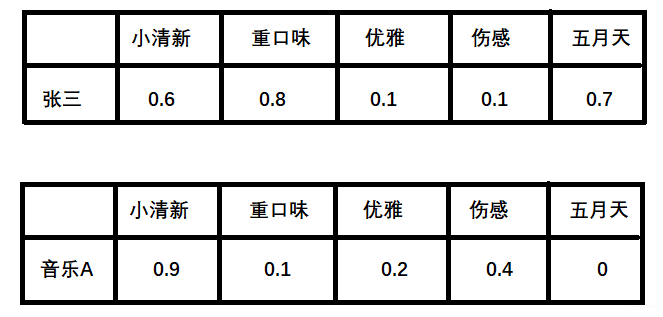

+## 经典双塔模型

+

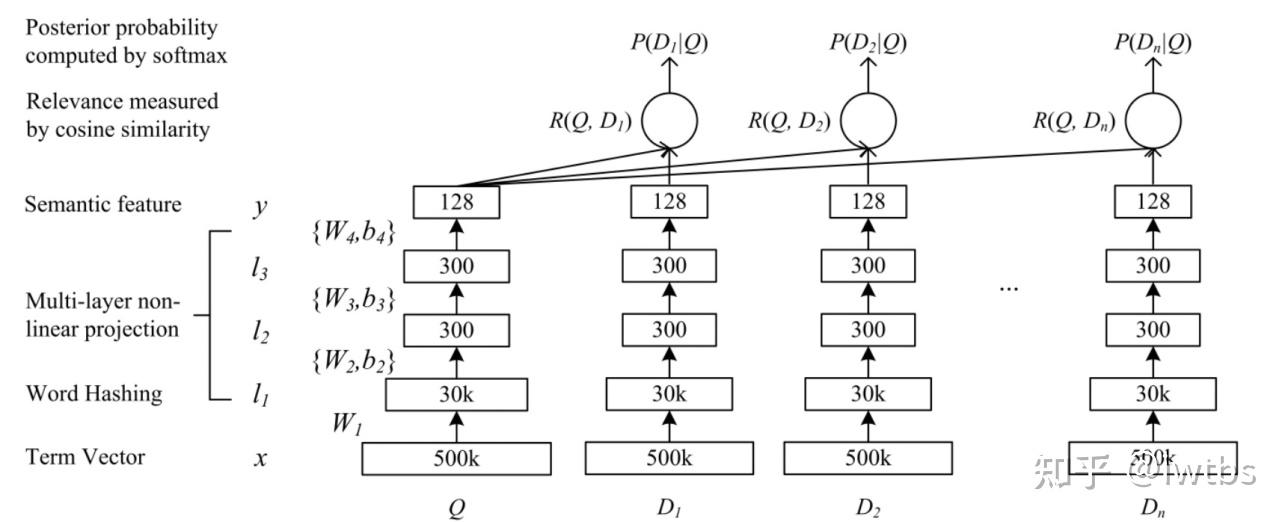

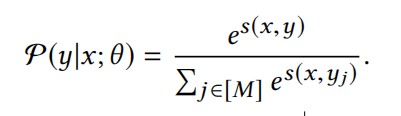

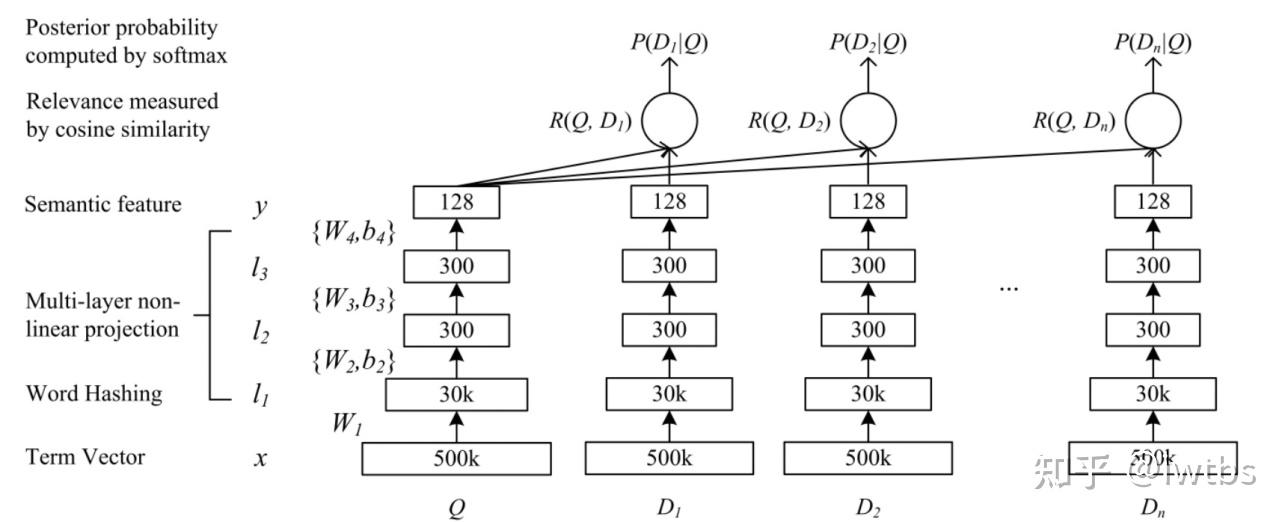

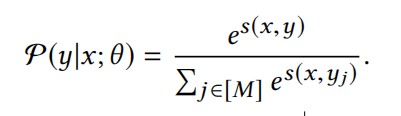

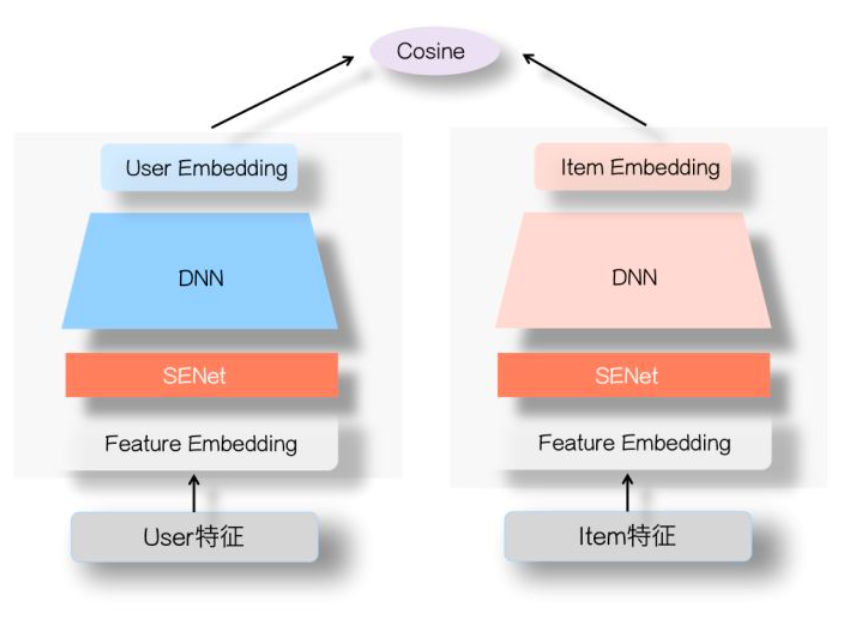

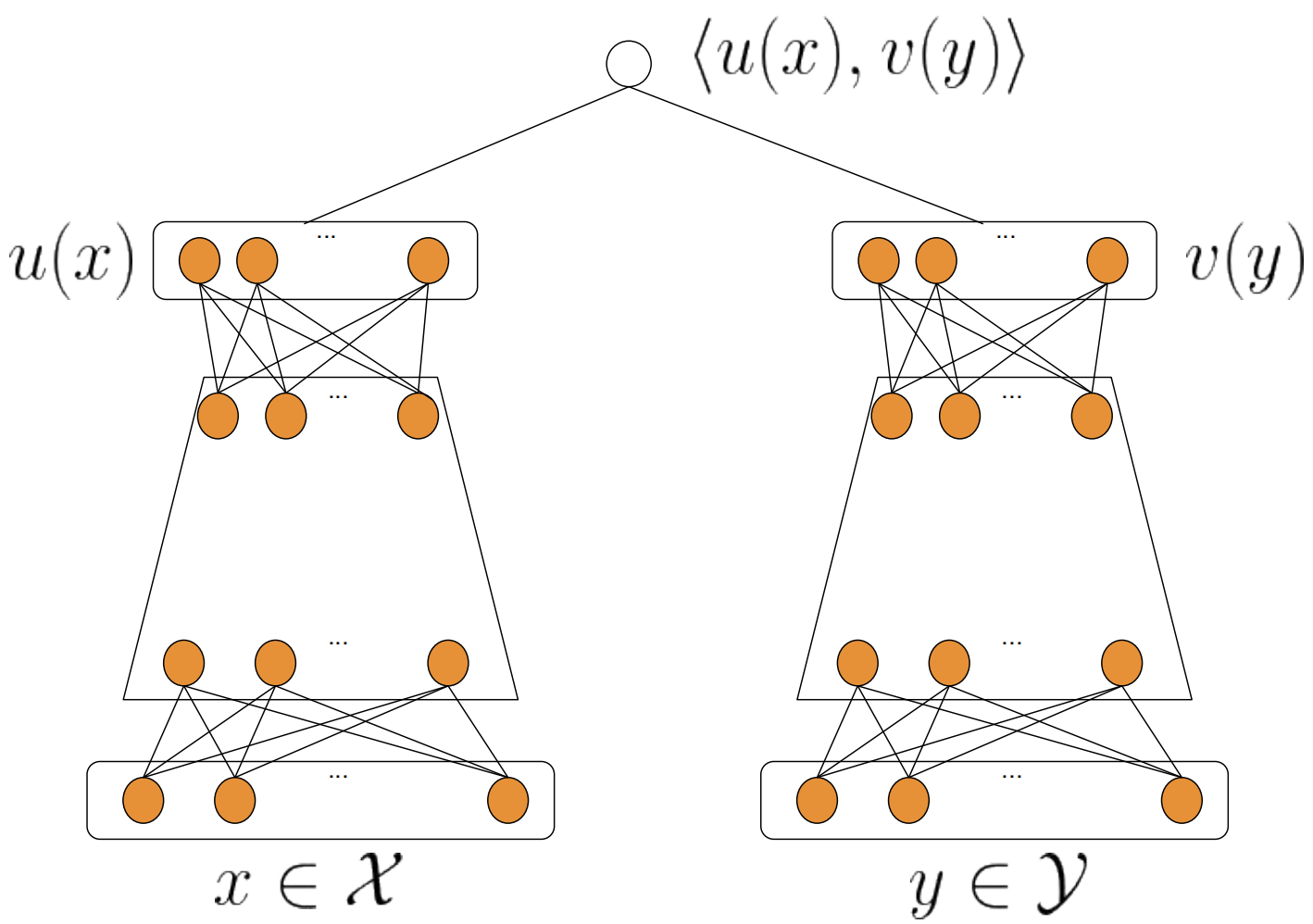

+DSSM(Deep Structured Semantic Model)是由微软研究院于CIKM在2013年提出的一篇工作,该模型主要用来解决NLP领域语义相似度任务 ,利用深度神经网络将文本表示为低维度的向量,用来提升搜索场景下文档和query匹配的问题。DSSM 模型的原理主要是:通过用户搜索行为中query 和 doc 的日志数据,通过深度学习网络将query和doc映射到到共同维度的语义空间中,通过最大化query和doc语义向量之 间的余弦相似度,从而训练得到隐含语义模型,即 query 侧特征的 embedding 和 doc 侧特征的 embedding,进而可以获取语句的低维 语义向量表达 sentence embedding,可以预测两句话的语义相似度。模型结构如下所示:

+

+

+

+**(3)模型**

+特征构建完成后,开始对模型进行训练。

+

+- Airbnb 在搜索排名中使用的是 GBDT 模型,该模型是一个回归模型。

+- 模型的训练数据包括数据集 $ \mathcal{D} $ 和 search labels 。

+

+最后,利用 GBDT 模型来预测线上各搜索房源的在线分数。得到预测分数后,将按照降序的方式展现给用户。

+# 参考链接

+

++ [Embedding 在大厂推荐场景中的工程化实践 - 卢明冬的博客 (lumingdong.cn)](https://lumingdong.cn/engineering-practice-of-embedding-in-recommendation-scenario.html#Airbnb)

+

++ [KDD'2018 Best Paper-Embedding技术在Airbnb实时搜索排序中的应用 (qq.com)](https://mp.weixin.qq.com/s/f9IshxX29sWg9NhSa7CaNg)

+

++ [再评Airbnb的经典Embedding论文 - 知乎 (zhihu.com)](https://zhuanlan.zhihu.com/p/162163054)

+

++ [Airbnb爱彼迎房源排序中的嵌入(Embedding)技术 - 知乎 (zhihu.com)](https://zhuanlan.zhihu.com/p/43295545)

diff --git a/4.人工智能/ch02/ch2.1/ch2.1.2/DSSM.md b/4.人工智能/ch02/ch2.1/ch2.1.2/DSSM.md

new file mode 100644

index 0000000..8c94c46

--- /dev/null

+++ b/4.人工智能/ch02/ch2.1/ch2.1.2/DSSM.md

@@ -0,0 +1,629 @@

+# 双塔召回模型

+

+---

+

+双塔模型在推荐领域中是一个十分经典的模型,无论是在召回还是粗排阶段,都会是首选。这主要是得益于双塔模型结构,使得能够在线预估时满足低延时的要求。但也是因为其模型结构的问题,使得无法考虑到user和item特之间的特征交叉,使得影响模型最终效果,因此很多工作尝试调整经典双塔模型结构,在保持在线预估低延时的同时,保证双塔两侧之间有效的信息交叉。下面针对于经典双塔模型以及一些改进版本进行介绍。

+

+

+

+## 经典双塔模型

+

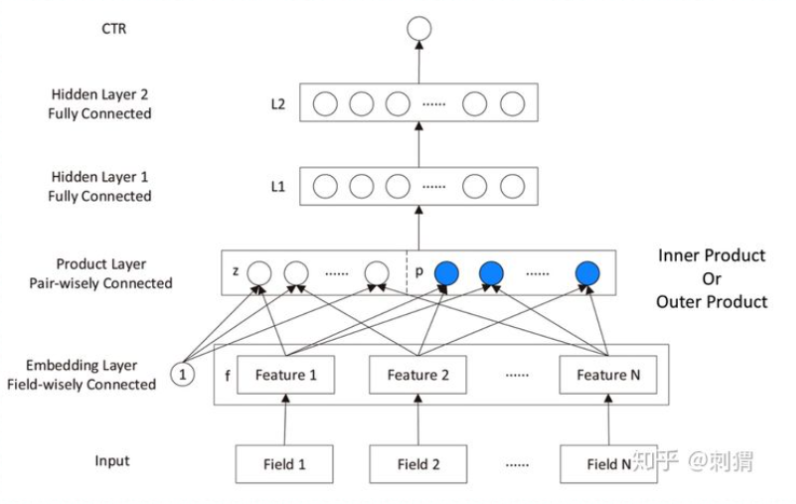

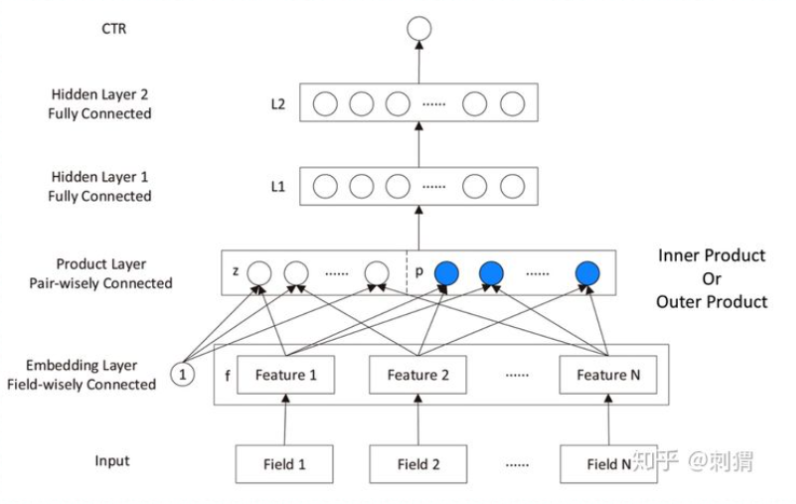

+DSSM(Deep Structured Semantic Model)是由微软研究院于CIKM在2013年提出的一篇工作,该模型主要用来解决NLP领域语义相似度任务 ,利用深度神经网络将文本表示为低维度的向量,用来提升搜索场景下文档和query匹配的问题。DSSM 模型的原理主要是:通过用户搜索行为中query 和 doc 的日志数据,通过深度学习网络将query和doc映射到到共同维度的语义空间中,通过最大化query和doc语义向量之 间的余弦相似度,从而训练得到隐含语义模型,即 query 侧特征的 embedding 和 doc 侧特征的 embedding,进而可以获取语句的低维 语义向量表达 sentence embedding,可以预测两句话的语义相似度。模型结构如下所示:

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

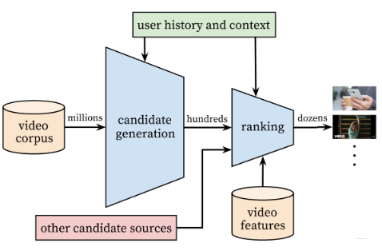

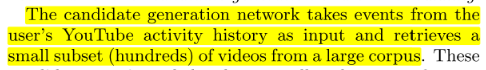

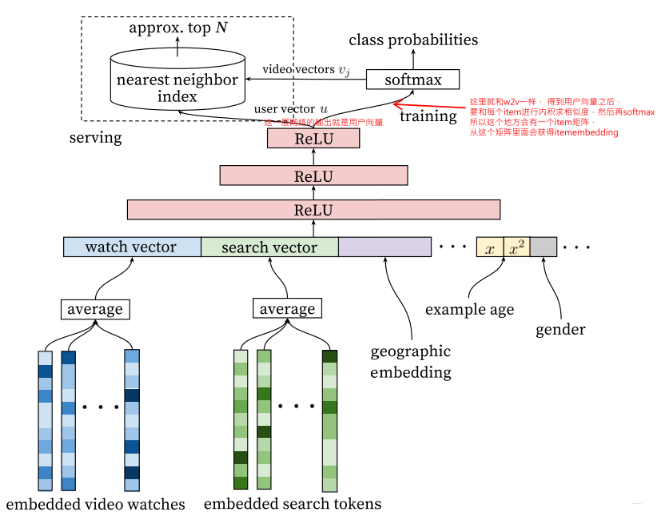

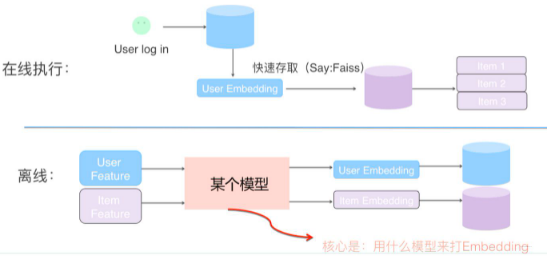

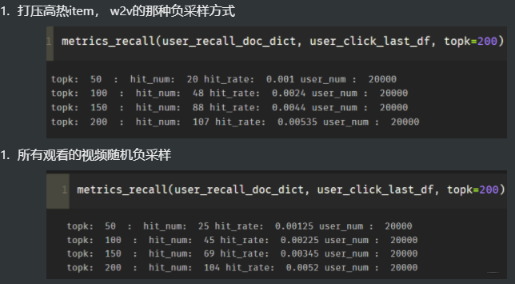

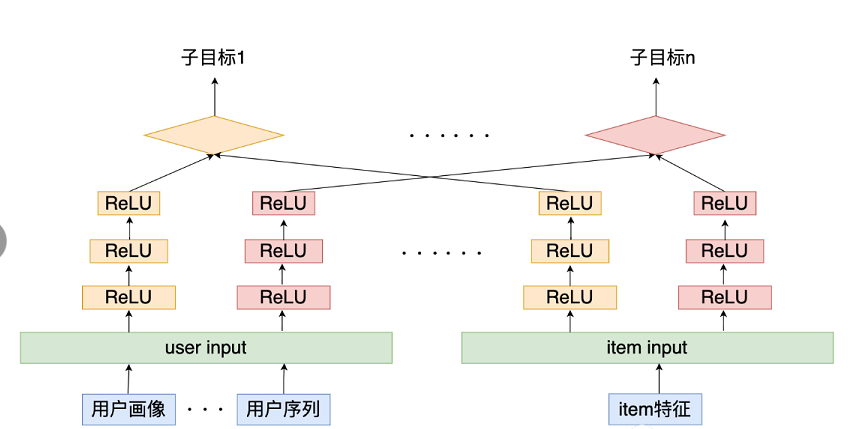

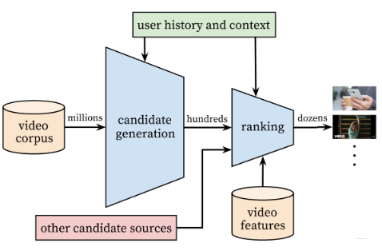

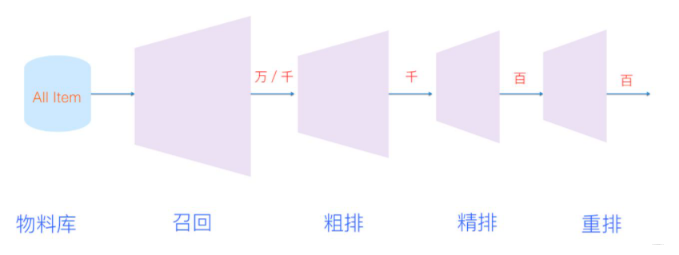

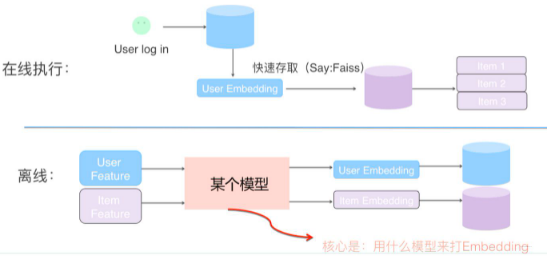

召回侧, 目前根据我的理解,大致上有两大类召回方式,一类是策略规则,一类是监督模型+embedding,其中策略规则,往往和真实场景有关,比如热度,历史重定向等等,不同的场景会有不同的召回方式,这种属于"特异性"知识。

+

后面的模型+embedding思路是一种"普适"方法,我上面图里面梳理出了目前给用户和物品打embedding的主流方法, 这些方法大致成几个系列,比如FM系列(FM,FFM等), 用户行为序列,基于图和知识图谱系列,经典双塔系列等,这些方法看似很多很复杂,其实本质上还是给用户或者是物品打embedding而已,只不过考虑的角度方式不同。 这里的YouTubeDNN召回模型,也是这里的一种方式而已。

+2. 精排侧

+

+

+

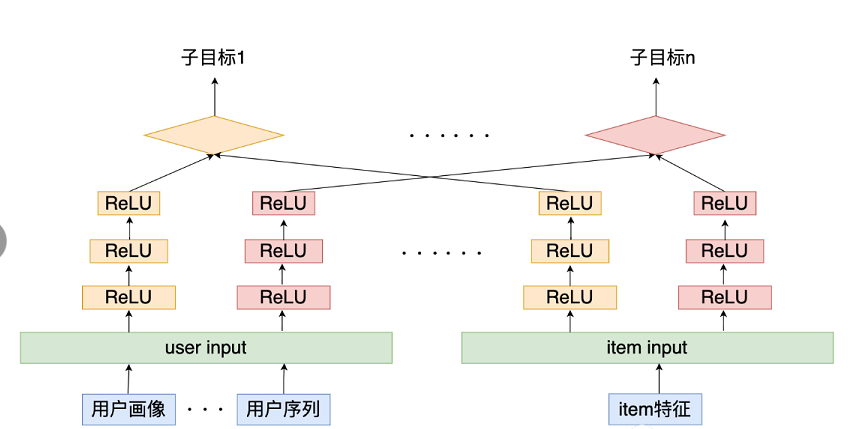

+ 精排侧,这一块的大致发展趋势,从ctr预估到多目标, 而模型演化上,从人工特征工程到特征工程自动化。主要是三大块, CTR预估主要分为了传统的LR,FM大家族,以及后面自动特征交叉的DNN家族,而多目标优化,目前是很多大公司的研究现状,更是未来的一大发展趋势,如何能让模型在各个目标上面的学习都能"游刃有余"是一件非常具有挑战的事情,毕竟不同的目标可能会互相冲突,互相影响,所以这里的研究热点又可以拆分成网络结构演化以及loss设计优化等, 而网络结构演化中,又可以再一次细分。 当然这每个模型或者技术几乎都有对应paper,我们依然可以通过读paper的方式,把这些关键技术学习到。

+

+这两阶段的方法, 就能保证我们从大规模视频库中实时推荐, 又能保证个性化,吸引用户。 当然,随着时间的发展, 可能数据量非常非常大了, 此时召回结果规模精排依然无法处理,所以现在一般还会在召回和精排之间,加一个粗排进一步筛选作为过渡, 而随着场景越来越复杂, 精排产生的结果也不是直接给到用户,而是会再后面加一个重排后处理下,这篇paper里面其实也简单的提了下这种思想,在排序那块会整理到。 所以如今的漏斗, 也变得长了些。

+

+

+

+

+

除了这种算好embedding方式之外,还可以过embedding层,跟上面的DNN一起训练,这些都是常规操作,之前整理的精排模型里面大都是用这种方式。

+

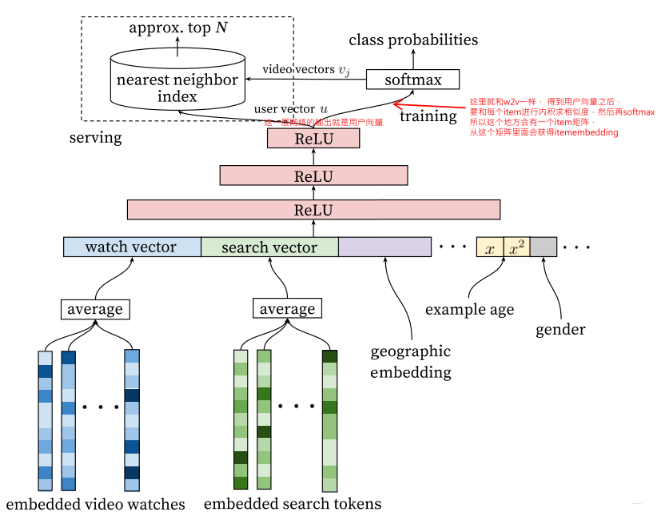

+ 论文里面使用了用户最近的50次观看历史,用户最近50次搜索历史token, embedding维度是256维, 采用的average pooling。 当然,这里还可以把item的类别信息也隐射到embedding, 与前面的concat起来。

+* 用户人文特征, 这种特征处理方式就是离散型的依然是labelEncoder,然后embedding转成低维稠密, 而连续型特征,一般是先归一化操作,然后直接输入,当然有的也通过分桶,转成离散特征,这里不过多整理,特征工程做的事情了。 当然,这里还有一波操作值得注意,就是连续型特征除了用了$x$本身,还用了$x^2$,$logx$这种, 可以加入更多非线性,增加模型表达能力。

+ 这些特征对新用户的推荐会比较有帮助,常见的用户的地理位置, 设备, 性别,年龄等。

+* 这里一个比较特色的特征是example age,这个特征后面需要单独整理。

+

+这些特征处理好了之后,拼接起来,就成了一个非常长的向量,然后就是过DNN,这里用了一个三层的DNN, 得到了输出, 这个输出也是向量。

+

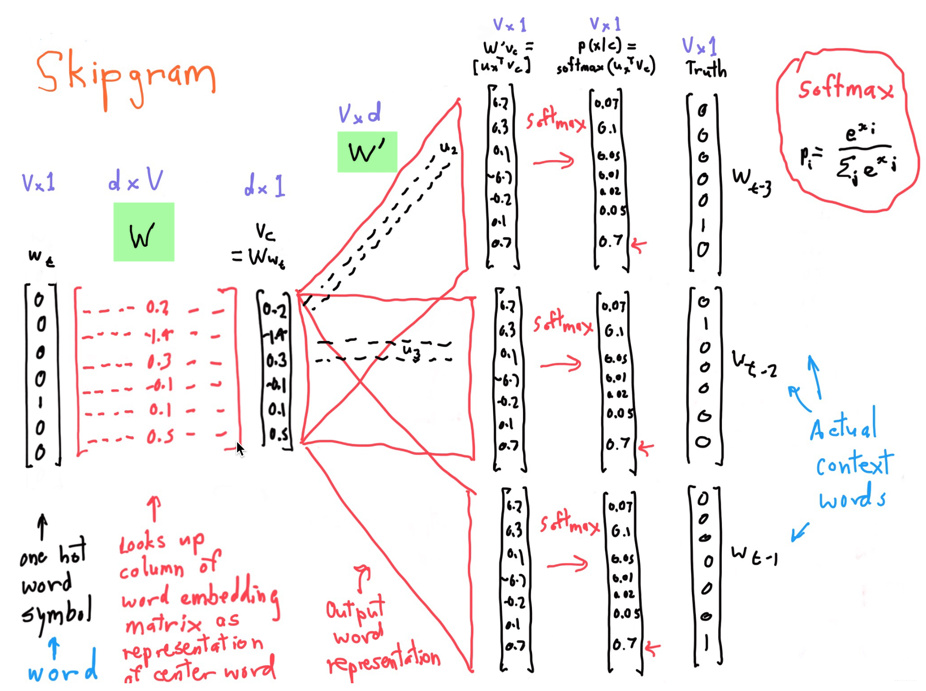

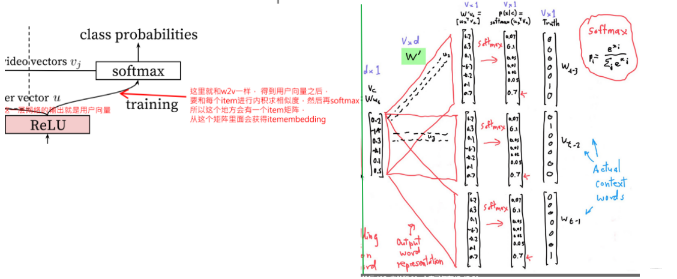

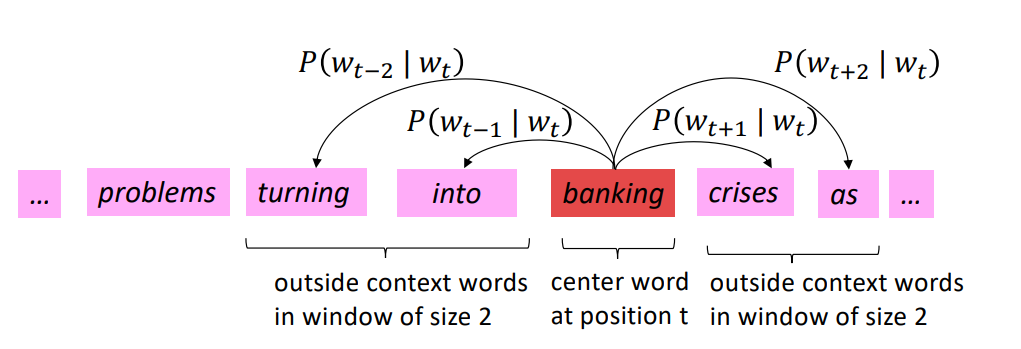

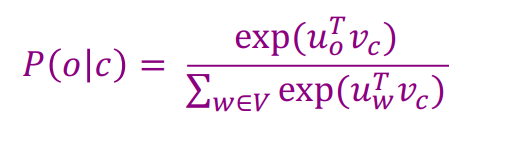

+Ok,到这里平淡无奇, 前向传播也大致上快说完了, 还差最后一步。 最后这一步,就是做多分类问题,然后求损失,这就是training那边做的事情。 但是在详细说这个之前, 我想先简单回忆下word2vec里面的skip-gram Model, 这个模型,如果回忆起来,这里理解起来就非常的简单了。

+

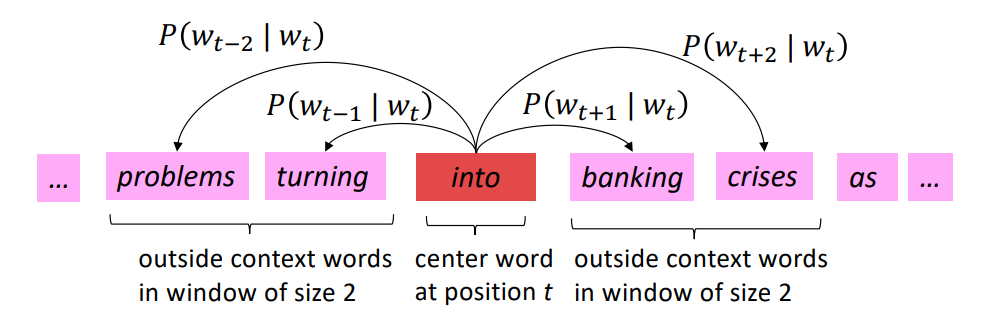

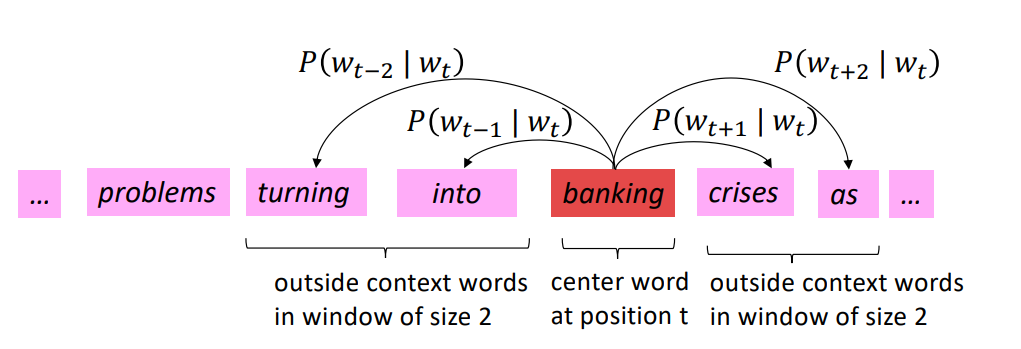

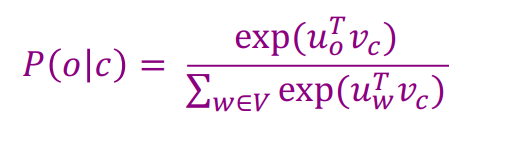

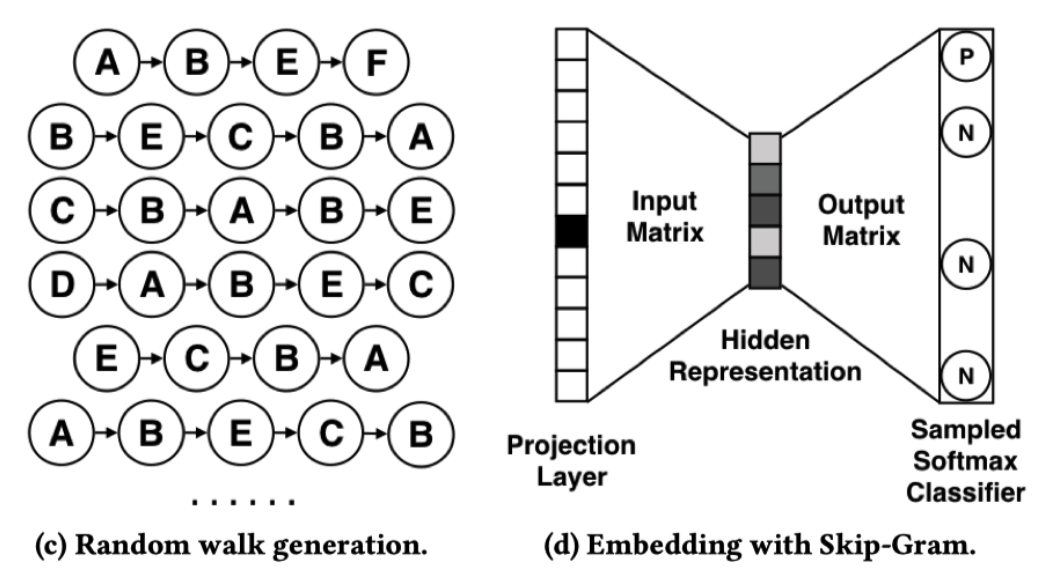

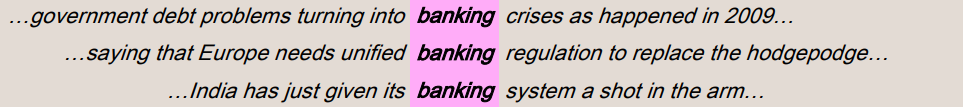

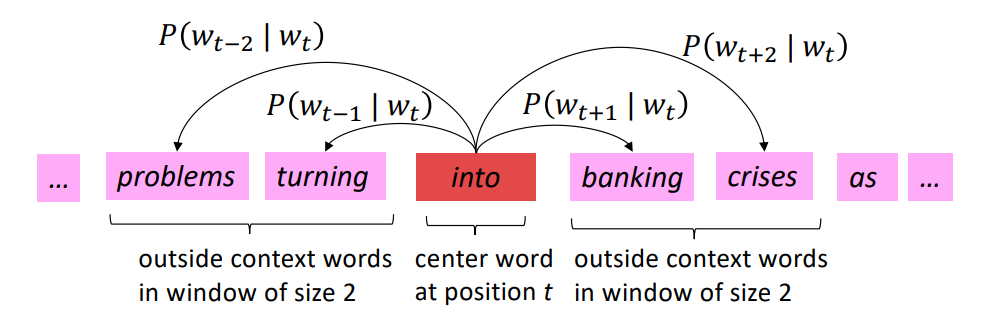

+这里只需要看一张图即可, 这个来自cs231N公开课PPT, 我之前整理w2v的时候用到的,详细内容可看我[这篇博客](https://zhongqiang.blog.csdn.net/article/details/106948860), 这里的思想其实也是从w2v那边过来的。

+

+

+

+

然后就是$v_c$和上下文矩阵$W'$相乘, 这里的$W'$是$V\times d$的一个矩阵, 每一行代表每个单词作为上下文的时候的词向量表示, 也就是$u_w$, 每一列是词嵌入的维度。 这样通过$W'*v_c$就会得到一个$V\times 1$的向量,这个表示的就是中心单词$w_t$与每个单词的相似程度。

+>

最后,我们通过softmax操作把这个相似程度转成概率, 选择概率最大的index输出。

+

+这就是这个模型的前向传播过程。

+

+有了这个过程, 再理解YouTubeDNN顶部就非常容易了, 我单独截出来:

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

+

那么这样的操作为啥会work呢? example age这个我理解,是有了这个特征, 就可以把某视频的热度分布信息传递给模型了, 比如某个example age时间段该视频播放较多, 而另外的时间段播放较少, 这样模型就能发现用户的这种新颖偏好, 消除热度偏见。

这个地方看了一些文章写说, 这样做有利于让模型推新热内容, 总感觉不是很通。 我这里理解是类似让模型消除位置偏见那样, 这里消除一种热度偏见。

我理解是这样,假设没有这样一个example age特征表示视频新颖信息,或者一个位置特征表示商品的位置信息,那模型训练的样本,可能是用户点击了这个item,就是正样本, 但此时有可能是用户真的喜欢这个item, 也有可能是因为一些bias, 比如用户本身喜欢新颖, 用户本身喜欢点击上面位置的item等, 但模型推理的时候,都会误认为是用户真的喜欢这个item。 所以,为了让模型了解到可能是存在后面这种bias, 我们就把item的新颖信息, item的位置信息等做成特征, 在模型训练的时候就告诉模型,用户点了这个东西可能是它比较新或者位置比较靠上面等,这样模型在训练的时候, 就了解到了这些bias,等到模型在线推理的时候呢, 我们把这些bias特征都弄成一样的,这样每个样品在模型看来,就没有了新颖信息和位置信息bias(一视同仁了),只能靠着相关性去推理, 这样才能推到用户真正感兴趣的东西吧。

而有些文章记录的, 能够推荐更热门的视频啥的, 我很大一个疑问就是推理的时候,不是把example age用0表示吗? 模型应该不知道这些视频哪个新不新吧。 当然,这是我自己的看法,感兴趣的可以帮我解答下呀。

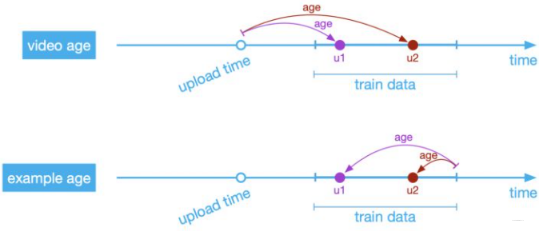

+

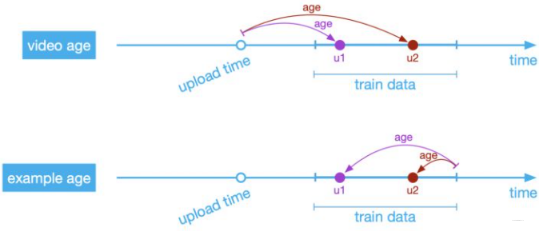

+`example age`这个特征到这里还没完, 原来加入这种时间bias的传统方法是使用`video age`, 即一个video上传到样本生成的这段时间跨度, 这么说可能有些懵, 看个图吧, 原来这是两个东西:

+

+

+

+

+

+

+

+

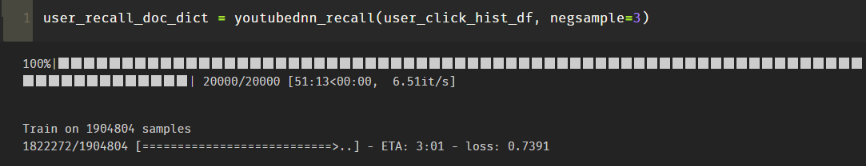

我这里面加入的一些策略,负样本候选集生成我单独写成一个函数,因为尝试了随机采样和打压热门item采样两种方式, 可以通过methods参数选择。 另外一个就是正样本里面也按照热门实现了打压, 减少高热item成为正样本概率,增加高热item成为负样本概率。 还加了一个控制用户样本数量的参数,去保证每个用户生成一样多的样本数量,打压下高活用户。

+5. 构造模型输入

+ 这个也是调包的定式操作,必须按照这个写法来:

+

+

+ ```python

+ def gen_model_input(train_set, his_seq_max_len):

+ """构造模型的输入"""

+ # row: [user_id, hist_list, cur_doc_id, city, age, gender, label, hist_len]

+ train_uid = np.array([row[0] for row in train_set])

+ train_hist_seq = [row[1] for row in train_set]

+ train_iid = np.array([row[2] for row in train_set])

+ train_u_city = np.array([row[3] for row in train_set])

+ train_u_age = np.array([row[4] for row in train_set])

+ train_u_gender = np.array([row[5] for row in train_set])

+ train_u_example_age = np.array([row[6] for row in train_set])

+ train_label = np.array([row[7] for row in train_set])

+ train_hist_len = np.array([row[8] for row in train_set])

+

+ train_seq_pad = pad_sequences(train_hist_seq, maxlen=his_seq_max_len, padding='post', truncating='post', value=0)

+ train_model_input = {

+ "user_id": train_uid,

+ "click_doc_id": train_iid,

+ "hist_doc_ids": train_seq_pad,

+ "hist_len": train_hist_len,

+ "u_city": train_u_city,

+ "u_age": train_u_age,

+ "u_gender": train_u_gender,

+ "u_example_age":train_u_example_age

+ }

+ return train_model_input, train_label

+ ```

+ 上面构造数据集的时候,是把每个特征加入到了二维数组里面去, 这里得告诉模型,每一个维度是啥特征数据。如果相加特征,首先构造数据集的时候,得把数据加入到数组中, 然后在这个函数里面再指定新加入的特征是啥。 下面的那个词典, 是为了把数据输入和模型的Input层给对应起来,通过字典键进行标识。

+6. 训练YouTubeDNN

+ 这一块也是定式, 在建模型事情,要把特征封装起来,告诉模型哪些是离散特征,哪些是连续特征, 模型要为这些特征建立不同的Input层,处理方式是不一样的

+

+ ```python

+ def train_youtube_model(train_model_input, train_label, embedding_dim, feature_max_idx, his_seq_maxlen, batch_size, epochs, verbose, validation_split):

+ """构建youtubednn并完成训练"""

+ # 特征封装

+ user_feature_columns = [

+ SparseFeat('user_id', feature_max_idx['user_id'], embedding_dim),