feat(WIKI): wiki 2025 BREAKING CHANGE: Older content is categorized into older folders

262

2023旧版内容/4.人工智能/4.10LLMAgent之结构化输出.md

Normal file

@@ -0,0 +1,262 @@

|

||||

# LLM Agent 之结构化输出

|

||||

|

||||

author:Marlene

|

||||

|

||||

*Last revised 2023/07/26*

|

||||

|

||||

## 引言

|

||||

|

||||

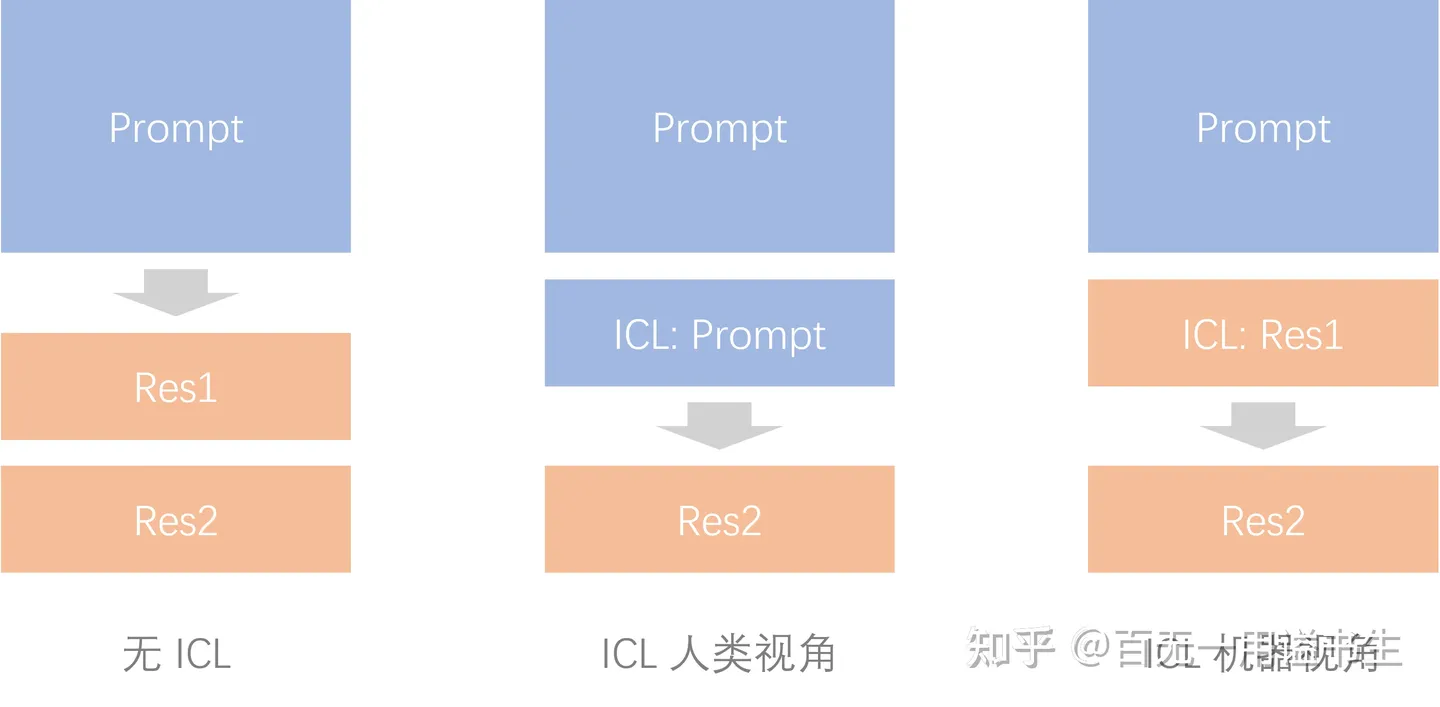

自去年年底以来,GPT 的迅速发展诞生了一系列大模型。出现了更新、更大、更强的 GPT-4。OpenAI 不断推出 GPT-4,ChatGPT Plugins,代码解释器,Function calling,图片处理等等。7 月的 WAIC 上,笔者也有幸见到了国内一众企业相继展示自家的大模型。在这段时间里,LLM 从最初的 PE 工程走向智能体交互。而笔者从最开始考虑 LLM 能不能多人协作,思考”一个专家完成所有任务好还是很多人分工完成好“,到各种论文层出不穷,到如今火热的 LLM Agent 开发模式。可以说,如果你从大学里随便问某个人都知道 GPT,甚至大部分都用过。

|

||||

|

||||

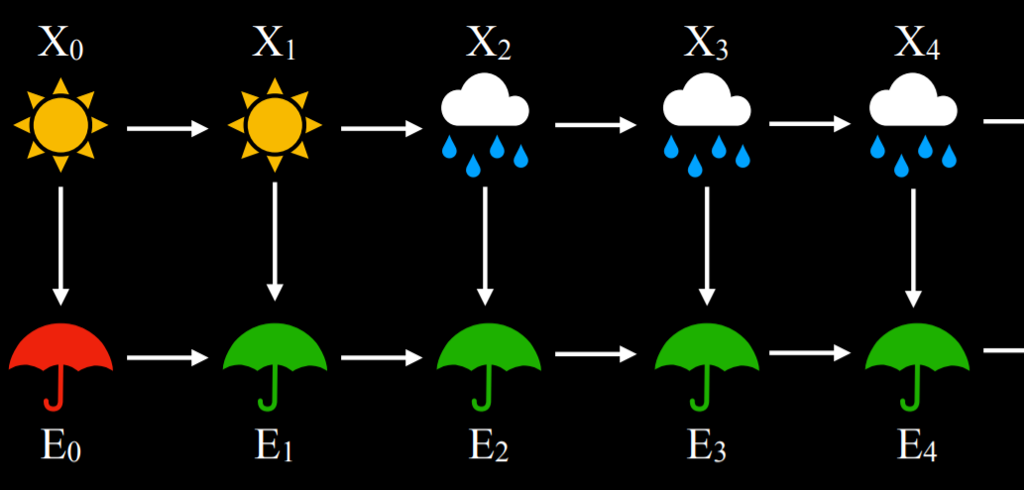

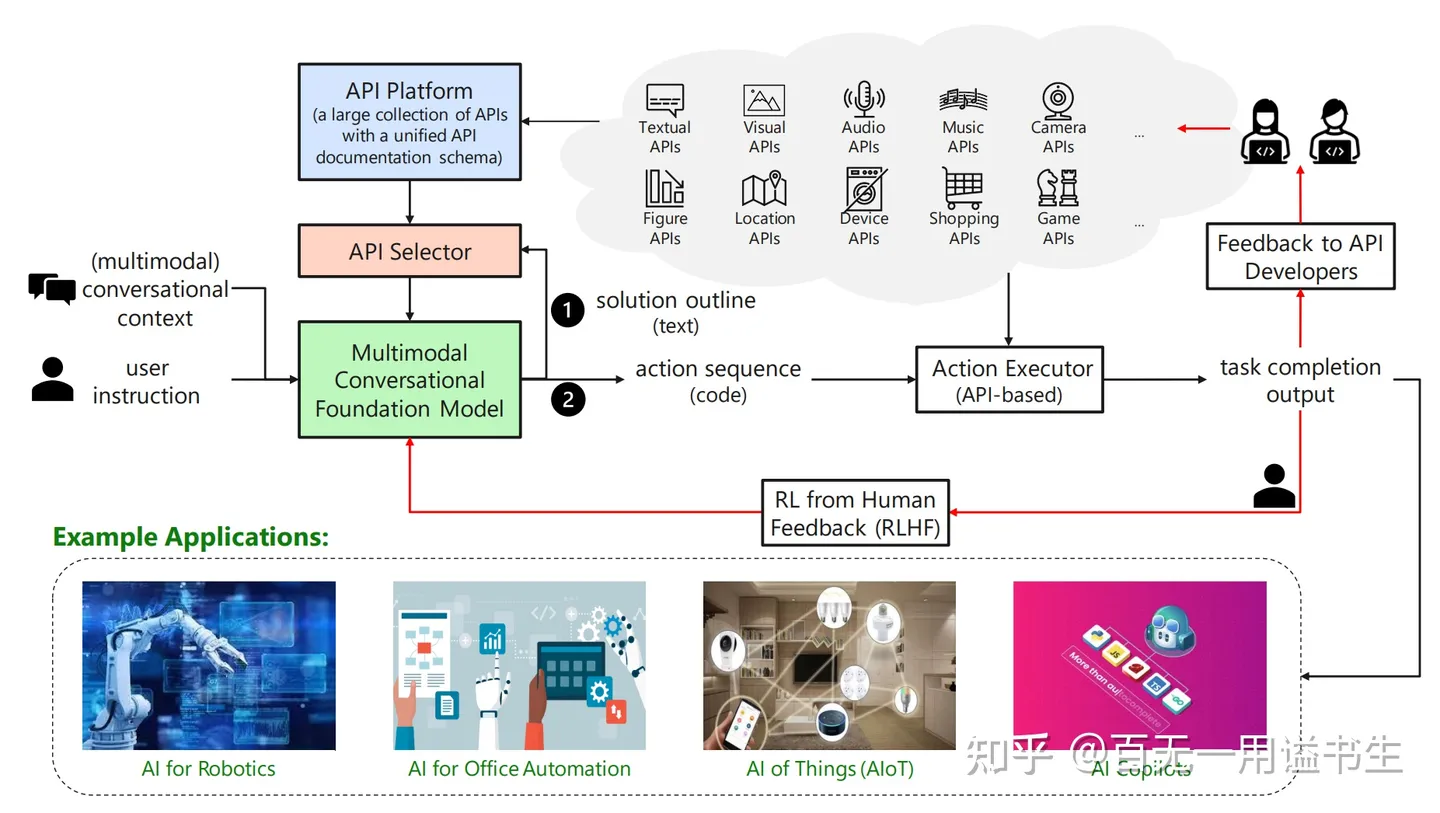

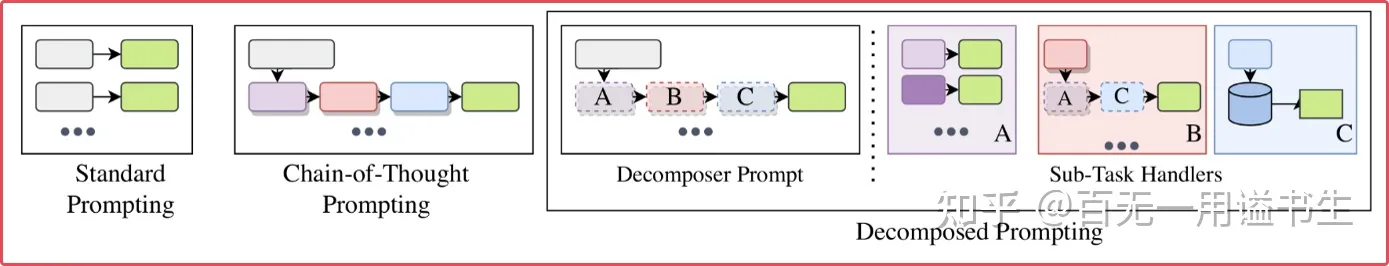

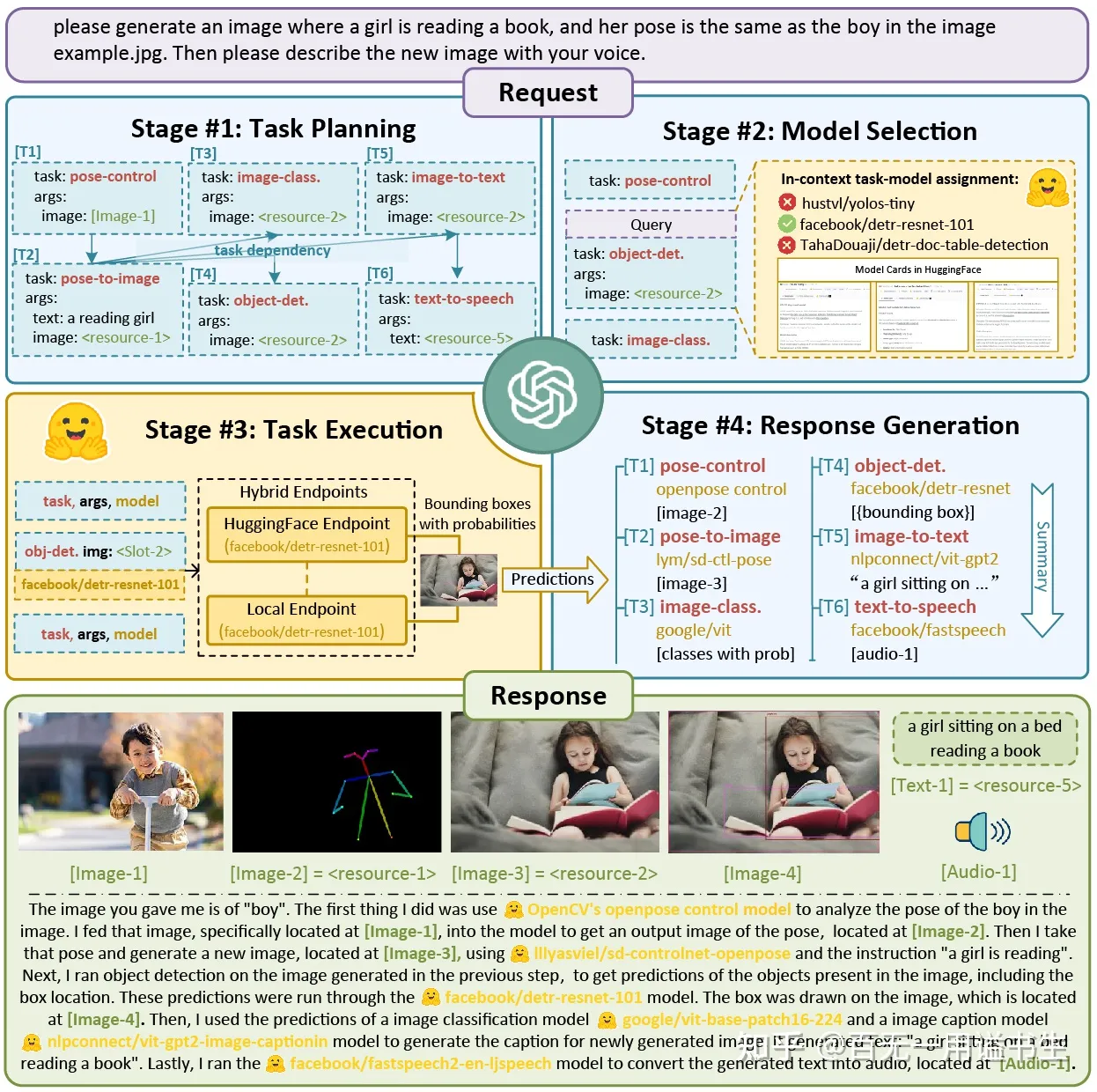

好了,前言少叙。进入正题。众所周知,Agent 基本= LLM(大型语言模型)+ 记忆 + 规划技能 + 工具使用。

|

||||

|

||||

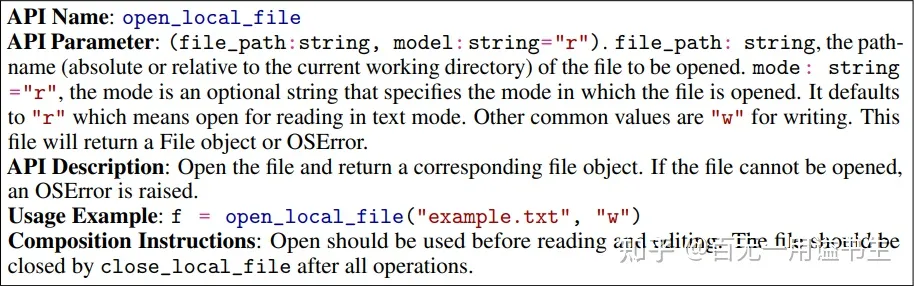

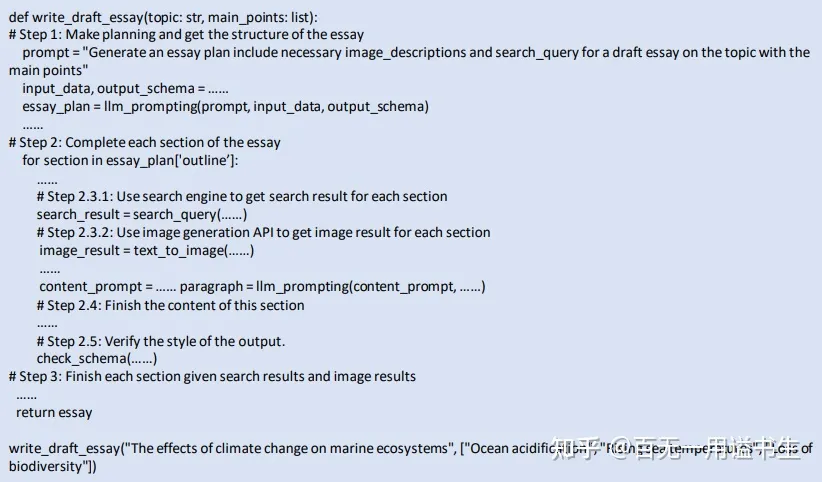

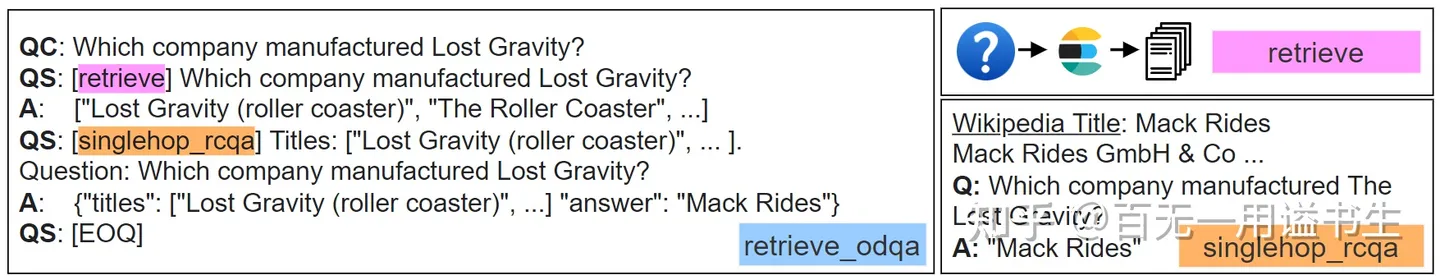

想要使用工具,让 GPT 掌握如何使用工具,常见的方法是告知 GPT 工具(通常是一个可以调用的函数)的参数,让 GPT 生成这些参数即可。那么如何让 GPT 可靠的生成这些规定的参数呢?换一种说法,如何让 GPT 输出结构化的数据信息呢?

|

||||

|

||||

## 原理及相关框架

|

||||

|

||||

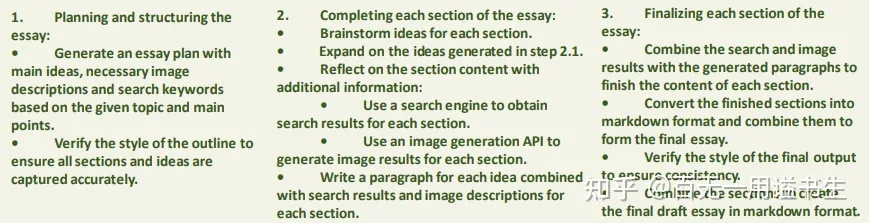

现如今大部分的结构化输出工具的原理都是:告诉 GPT 要输出一个怎么样的结构即可。没错~当然,为什么会出现这么多开发工具都用来解决这个问题,明明是一个简单的原理呢?

|

||||

|

||||

```txt

|

||||

1. 通过 prompt 告知 LLM 我们所需要的返回格式,并进行生成。

|

||||

2. 通过一些规则来检查返回结果,如果不符合格式,生成相关错误信息。

|

||||

3. 将上一次的生成内容和检查的错误信息告知 LLM,进行下一次的修正生成。

|

||||

4. 重复 2-3 步骤,直到生成的内容完全符合我们的要求。

|

||||

```

|

||||

|

||||

首先,关于怎样描述这样一个结构的 prompt 模板,众口难调。有些人认为结构就应该用自然语言描述,这样足够简单,上手难度足够低,方便快速迭代开发。有些人认为结构描述?JSON Schema 不就够了?有些人觉得 YAML 也可以。有些人觉得上面这些对于我的需求还是够不着啊,于是自己造了一个伪代码描述。

|

||||

其次,自动处理修正机制也可以做很多文章。还有许多对性能和开销的优化。

|

||||

下文就是关于一众框架的简单分析。希望会对选择困难症的你有所帮助。

|

||||

|

||||

### **guardrails**

|

||||

|

||||

guardrails 这个项目,就是将上述的步骤做了进一步的抽象与封装,提供更加 high level 的配置与 API 来完成整个过程。

|

||||

优点:

|

||||

|

||||

1. 定义了一套 RAIL spec

|

||||

2. 更聚焦于错误信息

|

||||

|

||||

```markdown

|

||||

<rail version="0.1">

|

||||

|

||||

<output>

|

||||

<object name="patient_info">

|

||||

<string name="gender" description="Patient's gender" />

|

||||

<integer name="age" format="valid-range: 0 100" />

|

||||

<list

|

||||

name="symptoms"

|

||||

description="Symptoms that the patient is currently experiencing. Each symptom should be classified into a separate item in the list.">

|

||||

<object>

|

||||

<string name="symptom" description="Symptom that a patient is experiencing"/>

|

||||

<string

|

||||

name="affected area"

|

||||

description="What part of the body the symptom is affecting"

|

||||

format="valid-choices: {['head', 'neck', 'chest']}"

|

||||

on-fail-valid-choices="reask"

|

||||

/>

|

||||

</object>

|

||||

</list>

|

||||

<list name="current_meds" description="Medications the patient is currently taking and their response">

|

||||

<object>

|

||||

<string name="medication" description="Name of the medication the patient is taking" />

|

||||

<string

|

||||

name="response"

|

||||

description="How the patient is responding to the medication"

|

||||

/>

|

||||

</object>

|

||||

</list>

|

||||

</object>

|

||||

</output>

|

||||

|

||||

<prompt>

|

||||

|

||||

Given the following doctor's notes about a patient, please extract a dictionary that contains the patient's information.

|

||||

|

||||

{{doctors_notes}}

|

||||

|

||||

@complete_json_suffix_v2

|

||||

</prompt>

|

||||

</rail>

|

||||

```

|

||||

|

||||

可以看到,guardrails 定义了一套类似 xml 的语言用于结构化输出,又结合了自然语言的 prompt。虽然比起常见的模板语言要更加“繁琐”,但可以包含的内容也可以更加完善。比如可以提供字段的描述信息,检查规范,一定程度上也能帮助 LLM 更好地理解需求,生成预期的结果。

|

||||

|

||||

```markdown

|

||||

I was given the following JSON response, which had problems due to incorrect values.

|

||||

|

||||

{

|

||||

"patient_info": {

|

||||

"symptoms": [

|

||||

{

|

||||

"affected area": {

|

||||

"incorrect_value": "face & hair",

|

||||

"error_message": "Value face & hair is not in choices ['head', 'neck', 'chest']."

|

||||

}

|

||||

},

|

||||

{

|

||||

"affected area": {

|

||||

"incorrect_value": "beard, eyebrows & nares",

|

||||

"error_message": "Value beard, eyebrows & nares is not in choices ['head', 'neck', 'chest']."

|

||||

}

|

||||

}

|

||||

]

|

||||

}

|

||||

}

|

||||

|

||||

Help me correct the incorrect values based on the given error messages.

|

||||

```

|

||||

|

||||

后续 LLM 的返回可以仅针对这部分问题的修正,而不需要再重复生成整个 json。生成的新结果会由 guardrails 再自动填写回原来的位置,非常丝滑。除了 json 格式的检查外,RAIL spec 中还提供了通过脚本检查的扩展支持,可以用来检查更加复杂的内容,例如 Python 代码是否合法,结果中是否有敏感信息,甚至通过 LLM 再来检查生成的内容是否有害,做结果过滤等。

|

||||

|

||||

### **NeMo-Guardrails**

|

||||

|

||||

来自 Nvidia 的一个同名项目,其目标相比 guardrails 更有野心,想要确保 LLM 应用整体的可信度,无害性以及数据安全性等,而不仅仅只是输出的结构化检查和修复。因此其实现思路上也复杂不少,设计了一种专门的 Colang 语言,来支持更加通用多样的业务流,而不仅仅是生成 -> 检查 -> 修复。不过它的设计都是基于对话做的。实际开发应用可能不太合适。

|

||||

|

||||

```markdown

|

||||

define user ask capabilities

|

||||

"What can you do?"

|

||||

"What can you help me with?"

|

||||

"tell me what you can do"

|

||||

"tell me about you"

|

||||

"How can I use your help?"

|

||||

|

||||

define flow

|

||||

user ask capabilities

|

||||

bot inform capabilities

|

||||

|

||||

define bot inform capabilities

|

||||

"I am an AI assistant which helps answer questions based on a given knowledge base. For this interaction, I can answer question based on the job report published by US Bureau of Labor Statistics."

|

||||

```

|

||||

|

||||

从代码可以看出其结合了 python 和自然语言,方便相似度检索。

|

||||

其整体的运作流程如下:

|

||||

|

||||

1. 根据用户输入识别用户意图。在这一步,系统会将用户的输入在 flow 定义的各种用户回复文本中做相似性查找,也就是上面文件中“What can you do?”这一连串内容。这些检索到的预设用户意图内容,结合其它信息如对话样例,最近聊天记录等,形成整体的 prompt,发给 LLM 来生成回复。最终再从回复中提取用户意图。

|

||||

2. 根据意图,判断下一步操作动作。这一步有两种做法,一是当前的状态能够匹配上预定义的 flow。例如用户就是提了一个 bot 能力的问题,那么就会匹配上面定义的 user ask capabilities,下一步动作自然就是 bot inform capabilities。如果没有匹配上,就要由 LLM 自己来决定下一步动作,这时候也会跟生成用户意图一样,对于 flow 定义做一个相似性查找,将相关信息发给 LLM 来做生成。

|

||||

3. 生成 bot 回复。如果上一步生成的 bot 回复意图已经有明确定义了(例如上面的 bot 能力的回复),那么就直接用预定义的回复内容来回复用户。如果没有,就跟生成用户意图一样,做意图的相似性查找,将相关信息给 LLM 来生成回复。注意到很多动态的问题例如 QA 场景,是很难预先定义好回复内容的,这里也支持对接知识库,同样是做 vector search 之后,将相关 context 信息发给 LLM 来生成具体回复。

|

||||

|

||||

### guidance

|

||||

|

||||

之前在 guardrails 中的做法是在 prompt 中给出说明和示范,希望 LLM 能够遵循指令来输出。但现实中往往会出现各种问题,例如额外带了一些其它的文字说明,或者生成的 json 格式不正确等,所以需要后续的 ReAsk 来进行修正。LangChain 里也提供了各种 output parser 来帮忙提取回复中的结构化信息部分,但也经常容易运行失败。

|

||||

|

||||

在 guidance 中,也是通过“模板语言”来定义 LLM 的输出结构,以确保输出格式的正确性。

|

||||

|

||||

```markdown

|

||||

# load a model locally (we use LLaMA here)

|

||||

guidance.llm = guidance.llms.Transformers("your_local_path/llama-7b", device=0)

|

||||

|

||||

# we can pre-define valid option sets

|

||||

valid_weapons = ["sword", "axe", "mace", "spear", "bow", "crossbow"]

|

||||

|

||||

# define the prompt

|

||||

program = guidance("""The following is a character profile for an RPG game in JSON format.

|

||||

json

|

||||

{

|

||||

"description": "{{description}}",

|

||||

"name": "{{gen 'name'}}",

|

||||

"age": {{gen 'age' pattern='[0-9]+' stop=','}},

|

||||

"armor": "{{#select 'armor'}}leather{{or}}chainmail{{or}}plate{{/select}}",

|

||||

"weapon": "{{select 'weapon' options=valid_weapons}}",

|

||||

"class": "{{gen 'class'}}",

|

||||

"mantra": "{{gen 'mantra'}}",

|

||||

"strength": {{gen 'strength' pattern='[0-9]+' stop=','}},

|

||||

"items": [{{#geneach 'items' num_iterations=3}}

|

||||

"{{gen 'this'}}",{{/geneach}}

|

||||

]

|

||||

}""")

|

||||

|

||||

# execute the prompt

|

||||

program(description="A quick and nimble fighter.", valid_weapons=valid_weapons)

|

||||

```

|

||||

|

||||

在之前传统的做法中,这一整个 json 都需要由 LLM 来生成。但是 json 的结构是我们预先定义的,例如有哪些字段,开闭的花括号等,其实都不需要 LLM 来生成。

|

||||

优点:

|

||||

|

||||

1. 生成的 json 结构是保证合法且可控的,不会出现语法错误或者缺失/错误字段等。

|

||||

2. 通过 LLM 生成的 token 数量减少了,理论上可以提升生成速度。

|

||||

|

||||

除了 prompt 模板,它还提供了:

|

||||

|

||||

- 支持 hidden block,例如 LLM 的一些推理过程可能并不需要暴露给最终用户,就可以灵活利用这个特性来生成一些中间结果。

|

||||

- Generation caching,自动把已经生成过的结果缓存起来,提升速度。

|

||||

- 支持 HuggingFace 模型的 guidance acceleration,进一步提升生成速度。

|

||||

- Token healing,不看这个我还不知道 LLM 有这种问题……

|

||||

- Regex pattern guide,在模板的基础上进一步通过正则表达来限定生成的内容规范。

|

||||

|

||||

从项目代码来看,还是有比较浓的“research 味道”的,可读性并不好。实际测试结果也比较翻车。

|

||||

|

||||

### lmql

|

||||

|

||||

在 guidance 的基础上,lmql 这个项目进一步把“prompt 模板”这个概念推进到了一种新的编程语言。从官网能看到给出的一系列示例。语法结构看起来有点像 SQL,但函数与缩进都是 Python 的风格。

|

||||

|

||||

从支持的功能来看,相比 guidance 毫不逊色。例如各种限制条件,代码调用,各种 caching 加速,工具集成等基本都具备。这个框架的格式化输出是其次,其各种可控的输出及语言本身或许更值得关注。

|

||||

|

||||

### TypeChat

|

||||

|

||||

TypeChat 将 prompt 工程替换为 schema 工程:无需编写非结构化的自然语言 prompt 来描述所需输出的格式,而是编写 TS 类型定义。TypeChat 可以帮助 LLM 以 JSON 的形式响应,并且响应结果非常合理:例如用户要求将这句话「我可以要一份蓝莓松饼和一杯特级拿铁咖啡吗?」转化成 JSON 格式,TypeChat 响应结果如下:

|

||||

|

||||

其本质原理是把 interface 之类的 ts 代码作为 prompt 模板。因此它不仅可以对输出结果进行 ts 校验,甚至能够输入注释描述,不可谓非常方便 js 开发者。不过,近日 typechat 爆火,很多开发者企图尝试将 typechat 移植到 python,笔者认为这是缘木求鱼,因为其校验本身依赖的是 ts。笔者在开发过程中,将 typechat 融合到自己的库中,效果不错。但是它本身自带的 prompt 和笔者输入的 prompt 还是存在冲突,还是需要扣扣源码。

|

||||

|

||||

### Langchain

|

||||

|

||||

如果你关注了过去几个月中人工智能的爆炸式发展,那你大概率听说过 LangChain。简单来说,LangChain 是一个 Python 和 JavaScript 库,由 Harrison Chase 开发,用于连接 OpenAI 的 GPT API(后续已扩展到更多模型)以生成人工智能文本。

|

||||

|

||||

langchain 具有特别多的结构化输出工具。例如使用 yaml 定义 Schema,输出结构化 JSON。使用 zodSchema 定义 Schema,输出结构化 JSON。使用 FunctionParameters 定义 Schema,输出结构化 JSON。

|

||||

|

||||

但是笔者这里不打算介绍 langchain。究其原因,是笔者被 langchain 折磨不堪。明明可以几行代码写清楚的东西,langchain 可以各种封装,花了好几十行才写出来。更何况,笔者是用 ts 开发,开发时甚至偷不了任何懒,甚至其文档丝毫不友好。这几天,《机器之心》发布文章表示放弃 langchain。要想让 LangChain 做笔者想让它做的事,就必须花大力气破解它,这将造成大量的技术负担。因为使用人工智能本身就需要花费足够的脑力。LangChain 是为数不多的在大多数常用情况下都会增加开销的软件之一。所以笔者建议非必要,不使用 langchain。

|

||||

|

||||

## LLM 对于结构化信息的理解

|

||||

|

||||

LLM 的可控性、稳定性、事实性、安全性等问题是推进企业级应用中非常关键的问题,上面分享的这些项目都是在这方面做了很多探索,也有很多值得借鉴的地方。总体思路上来说,主要是:

|

||||

|

||||

- 提供一套 prompt 模板定义,允许用户指定 LLM 生成的格式或内容主题。

|

||||

- 在模板基础上,也有不少项目进一步设计了相应的编程语言,让 LLM 与确定性程序的交互更加直观。

|

||||

- 提供各类 validator,保证生成内容符合预期,并且提供了自动处理/修正机制。

|

||||

- 更进一步,也可以在生成前进行干预,例如在 prompt 中给近似案例,修改模型 decode 时的概率分布等。

|

||||

- 其它在可控性基础上做的各种性能与开销的优化,例如缓存,减少 token 消耗量,对开源模型能力的挖掘等。

|

||||

|

||||

即使我们不直接使用上述的项目做开发,也可以从中学习到很多有用的思路。当然也非常期待这个领域出现更多有意思的想法与研究,以及 prompt 与编程语言结合能否碰撞出更多的火花。

|

||||

|

||||

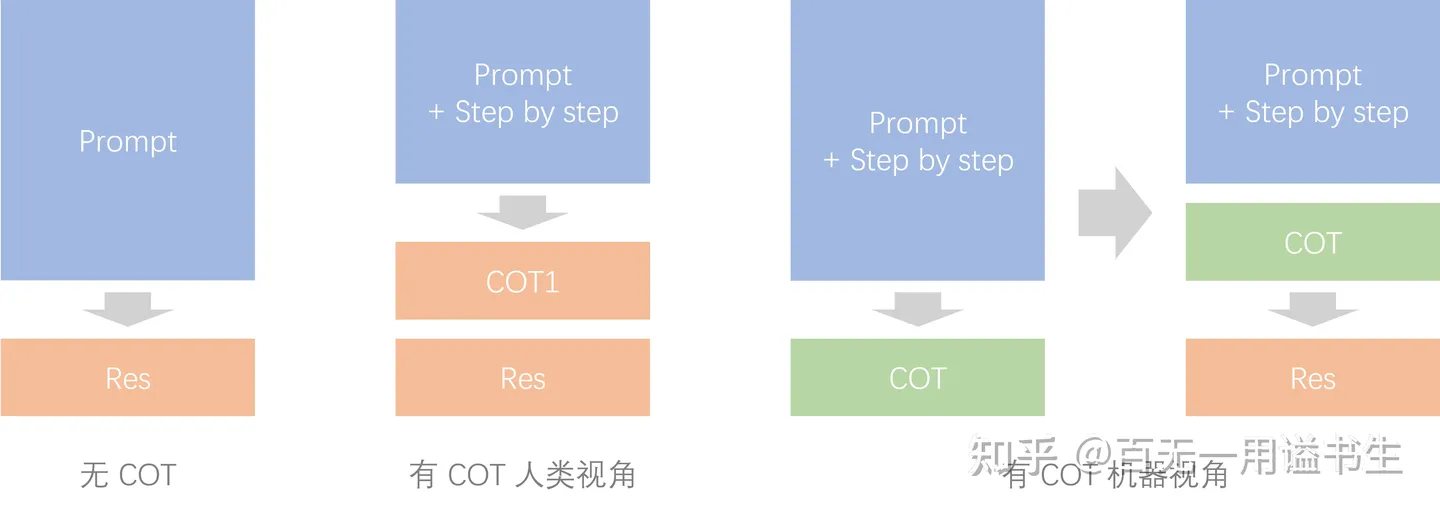

同时笔者认为自动处理机制、自己设计的编程语言等等内容,随着时间发展,一定会层出不穷,不断迭代更新。笔者抛去这些时效性较弱的内容,从描述信息和位置信息两方面思考 peompt 模板该如何设计,当然只是浅浅的抛砖引玉一下。

|

||||

|

||||

### 描述信息

|

||||

|

||||

到底哪种方式更容易于 LLM 去理解?我们不谈框架的设计,只考虑 prompt 的设计。上述框架关于这方面有一些参考,例如有些直接拿 json 作为 prompt 模板,有些拿 xml 作为 prompt 模板,有些拿自己设计的语言作为 prompt,有些拿自然语言作为 prompt 模板。时至今日,选用哪种最适合 LLM 去理解格式化的信息,输出格式化的内容完全没有盖棺定论。甚至时至今日,格式化输出问题还是没有得到可靠稳定的解决,要不然笔者肯定不会介绍这么多框架实践了。

|

||||

|

||||

笔者认为不管哪种方式,都可以从两个方面考量:更简单,更结构。如果想要在开发的时候更简单,或者在使用时更简单,选择 md、yaml 方式描述结构化信息更合适。如果想要更结构化的方式,选择 json、xml、ts,输出都能更有结构,甚至之后做结构校验都更方便。

|

||||

|

||||

想要 LLM 结构化输出更加稳定和理想,笔者认为选择 prompt 模板时必须考虑每个字段是否有足够的辅助信息。例如 xml 描述时,每个标签都有一个描述属性描述这个标签时什么意思。

|

||||

|

||||

#### 额外引申

|

||||

|

||||

笔者之前在开发 LLM 应用时,也曾思考类似的问题。笔者需要将多模态的数据进行结构化的标注,方便 LLM 去理解。但是标注成什么样却是一个很大的难题。笔者选择的是 JSON。但是,关于里面许多内容的标注。笔者在众多方案中徘徊。在细节处深挖,如何设计一种既简单,又能表示各种结构复杂关系,还能够节约 token 的方案及其的难。

|

||||

> 关于后续如何解决,请容笔者卖个关子 sai~

|

||||

|

||||

### 位置信息

|

||||

|

||||

是否有人注意到 llm 对于关键信息在 prompt 中的位置会对结果产生影响呢?在设计 prompt 方面,人们通常建议为语言模型提供详尽的任务描述和背景信息。近期的一些语言模型有能力输入较长的上下文,但它究竟能多好地利用更长的上下文?这一点却相对少有人知。近日,有学者研究发现如果上下文太长,语言模型会更关注其中的前后部分,中间部分却几乎被略过不看,导致模型难以找到放在输入上下文中部的相关信息。下文部分是该论文一些核心内容:

|

||||

|

||||

这是由其本身训练和结构设计有关的,但却对于我们开发有着莫大的帮助和指导意义。

|

||||

|

||||

相比之下,在多文档问答任务上,查询感知型上下文化的影响很小。特别指出,当相关信息位于输入上下文的最开始时,它可以提高性能,但在其他设置中会稍微降低性能。借此,我们可以认为,将重要的信息放在开头,结尾放置结构化模板,或许是一种优质选择。

|

||||

|

||||

那么如果真的为其提供这么多 token,那会真的有用吗?这个问题的答案是:由下游任务决定。因为这取决于所添加上下文的边际价值以及模型有效使用长输入上下文的能力。所以如果能有效地对检索文档排序(让相关信息与输入上下文的起始处更近)或对已排序的列表进行截断处理(必要时返回更少的文档),那么也许可以提升基于语言模型的阅读器使用检索上下文的能力。

|

||||

|

||||

## 题外话

|

||||

|

||||

之前,妙鸭相机突然爆火。其只需 9.9 即可生成同款数字分身,效果拔群。但是很多人发现,其生成的内容极其容易造成肖像权侵犯,这显然是有问题的。更有甚至的是,用户发现妙鸭相机的用户协议存在问题。根据该应用最初版本的用户服务协议,用户需授权妙鸭相机在全世界(包括元宇宙等虚拟空间)范围内享有永久的、不可撤销的、可转让的、可转授权的、免费的和非独家的许可,使得妙鸭相机可以任何形式、任何媒体或技术(无论现在已知或以后开发)使用用户的内容。对于上述内容,妙鸭相机称系“为了使我方能够提供、确保和改进本服务(包括但不限于使用 AI 生成内容作为再训练数据等)”。

|

||||

|

||||

一句话理解,就是你的肖像它随便用,与你无关。

|

||||

|

||||

这不禁让我联想到一部非常发人深省的剧作:《黑镜》。它的第六季第一集讲述的同样是隐私的问题。该集中,主人公的生活隐私由于同意了用户协议,被无时无刻搜集。然后当天晚上就发现流媒体电视上居然出现了跟她同名的电视剧,内容与它当天的生活一模一样,台词甚至更加夸张。于是她的不方便公之于众的生活变得一塌涂地,但她甚至没有办法打官司,因为肯定会输。更令人深省的是,电视剧的主人公是 AI 生成的视频,其肖像确是根据现实存在的明星生成的。那位明星也无法对她的肖像有任何权利。这样一个荒诞的故事,但是仔细想想,却又非常可能发生。

|

||||

|

||||

如今的社会出现了各种大模型。大模型的发展必定需要大数据的支撑。企业为了盈利必定会想方设法的搜集数据,然后肆意使用,转卖。而很多用户对此不自知,更有甚至是非常乐意。例如抖音、B 站,当你对其交互时,你希望它推荐更适合你的视频,它也在搜集你的数据,这是明知且主动的。

|

||||

|

||||

隐私的掠夺是无声的。你认为你的一下点击是没啥价值的隐私数据,殊不知这正中了资本家的下怀。几年前,我也是这样的。高中的大门出现了闸机,可以刷脸进校园。我当时以为这需要像手机解锁一样需要扫描人脸 ID。结果发现,我可以直接进去,闸机上甚至会出现我的照片。我仔细看了看,发现是我入学的证件照。原来一张照片就能刷脸进校园。原来就连学校也可以不经同学同意,将照片用作其他用途。那更何况其他的呢。

|

||||

我想,未来,这样的隐私问题会越来越多。

|

||||

|

||||

## 参考

|

||||

|

||||

<https://mp.weixin.qq.com/s?__biz=MzA3MzI4MjgzMw==&mid=2650885029&idx=4&sn=ac01576a8957b41529dd3c877d262d5e&chksm=84e48fdbb39306cd8979a4fa7f7da14a9428dc28ccc47880d668ef6293b1a8b7b0964569ec36&mpshare=1&scene=23&srcid=0725w9FPsVnOOzkPGPB7lH8h&sharer_sharetime=1690303766527&sharer_shareid=d2396b329b12f49d34967e2b183540dd#rd>

|

||||

<https://mp.weixin.qq.com/s/BngY2WgCcpTOlvdyBNJxqA>

|

||||

<https://microsoft.github.io/TypeChat/>

|

||||

<https://mp.weixin.qq.com/s?__biz=MzA3MzI4MjgzMw==&mid=2650885029&idx=4&sn=ac01576a8957b41529dd3c877d262d5e&chksm=84e48fdbb39306cd8979a4fa7f7da14a9428dc28ccc47880d668ef6293b1a8b7b0964569ec36&mpshare=1&scene=23&srcid=0725w9FPsVnOOzkPGPB7lH8h&sharer_sharetime=1690303766527&sharer_shareid=d2396b329b12f49d34967e2b183540dd#rd>

|

||||

66

2023旧版内容/4.人工智能/4.11本章节内容的局限性.md

Normal file

@@ -0,0 +1,66 @@

|

||||

# 本章节内容的局限性

|

||||

|

||||

作为一个本科生和部分研究生为主书写的教程,必须承认的是,我们在本章节内容,存在非常多的局限性,而本节内容,就是对目前存在的局限性和为什么还没有立马改进做的一定解释。

|

||||

|

||||

## 缺少一些前沿的内容

|

||||

|

||||

让我们时时刻刻都跟进最前沿的内容并且进行输出是相当困难的,当然我们也欢迎各位得贡献

|

||||

|

||||

## 少有机器学习的一些算法

|

||||

|

||||

机器学习领域有非常庞大的知识体系和一代人十几年的积累。

|

||||

|

||||

无数伟大的科学家究其一生的研究和探索它,但是你发现本章内容少有相关内容,还是以深度学习为主?为什么?

|

||||

|

||||

## 原因一:时代的浪潮

|

||||

|

||||

近乎全民深度学习的浪潮下,机器学习的知识被科研界一而再再而三的抛掷脑后,大家争先恐后的刷点,并使用深度学习的解决问题,因此深度学习领域的知识材料得到了井喷式的增长,而少有人愿意投入非常长的时间去研究机器学习的每一条数学公式的背后机理。

|

||||

|

||||

也正因如此,诸位花费自己的大学四年时光去钻研几条算法兴许是有意义的,但是对你拓展视野增长知识面的帮助没那么大,也没有办法帮助你引导到一些实操项目的工作中去,因此除了真正热爱的那一批人以外,过多的投入时间去学机器学习知识可能会让你感觉患得患失最后半途而废。

|

||||

|

||||

## 原因二:算法的性质

|

||||

|

||||

算法的性质就是严谨,一丝不苟的推导。因此,他涉及了大量的数学方程以及严谨的一步一步的推导过程。在学习的过程中,没有捷径,也没有更快的方法,你只能踏踏实实一步一步的进行积累。

|

||||

|

||||

而本教程的性质更偏向于导学,当你决心在机器学习算法深耕的时候,你已经脱离了需要导学的范畴更偏向于领域内容钻研,这是一项伟大的但是在当今时代略有吃力不讨好的工作,我真心祝愿你能乐在其中~感受到学习的快乐。

|

||||

|

||||

## 原因三:缺乏应用空间

|

||||

|

||||

ZZM 曾经尝试过投入大量时间去钻研数学以及机器学习相关的算法,但是发现了一个很残酷的现实就是,我们欠缺的积累和知识不是靠猛然突击可以弥补的,自己学都很吃力了,写出来不是误人子弟么 hhhh。

|

||||

|

||||

同时,尽管知识的内容让人很快乐,但是如果你不经常使用,或者实打实的拿一张白纸从头到尾推演一遍的话,你忘记的速度是非常快的,因此我们写下他,你们看一遍甚至说认真的阅览一遍,也不会留下太多内容。

|

||||

|

||||

## 如果真的感兴趣这方面内容呢

|

||||

|

||||

如果你阅览了本章节的数学相关知识和内容以及拓展感觉非常感兴趣并且毫无压力的话,我推荐你尝试去啃一啃大家公认的困难的书籍,比如说著名的花书,互联网上,社区内也有大量的辅助材料来帮助你更进一步的入门

|

||||

|

||||

## 科研导向明显

|

||||

|

||||

整篇教程大范围的在教怎么从科研角度去理解一些知识,感觉和工业上的逻有不符之处。

|

||||

|

||||

确实如此,工业界的逻辑和科研界的逻辑是截然不同的。

|

||||

|

||||

工业界的逻辑更偏向于低成本,高产出。而科研更偏向于你在一个好故事的背景下做了如何优雅的提升。

|

||||

|

||||

粗鲁地说就是工业更注重你这个项目,如果现在有一百万人用,能不能把百分之九十正确率的这个东西用好,科研更偏向于九十五到九十九。

|

||||

|

||||

我们自身并没有接触过太多的工业项目,也无法深入大厂去揭示他的算法,自然就算写东西写出来也不具备任何说服力。

|

||||

|

||||

因此如果你对这方面感兴趣,可能你需要别的途径去获取更多的思考和资源了。

|

||||

|

||||

## 繁杂的知识内容

|

||||

|

||||

这点非常抱歉,AI 领域的知识本身就是网状的,复杂的,甚至是互相引用的,这点会导致不可避免的内容变得冗长。

|

||||

|

||||

可能需要你花费大量的时间建立自己的知识框架和逻辑体系

|

||||

|

||||

而不是别人强行灌输给你的

|

||||

|

||||

## 还有更多???

|

||||

|

||||

联系 ZZM,我努力改

|

||||

::: tip 邮箱

|

||||

<1264517821@qq.com>

|

||||

:::

|

||||

|

||||

<img src="https://cdn.xyxsw.site/boxcnfYSoVgoERduiWP0jWNWMxf.jpg" width=200>

|

||||

99

2023旧版内容/4.人工智能/4.1前言.md

Normal file

@@ -0,0 +1,99 @@

|

||||

# 对 AI 大致方向的概述

|

||||

|

||||

## 前言

|

||||

|

||||

在这个时代,相关内容是非常泛滥的,我们在本章内容中,大致的写一些目前比较有名的方向以及它的简介(也许会比 wiki 和百度有趣一点?)

|

||||

|

||||

## 深度学习 的大致方向分类

|

||||

|

||||

本模块会粗略地介绍目前审读学习的研究与应用领域,在这里提前说明:笔者也只是一名普通的杭电学生,视野与认知有限,某些领域我们了解较多就会介绍地更加详细,某些领域了解较少或笔者中无人从事相关研究,就难免会简略介绍甚至有所偏颇,欢迎大家的指正。

|

||||

|

||||

### CV(计算机视觉)

|

||||

|

||||

计算机视觉旨在**用计算机模拟人类处理图片信息的能力**,就比如这里有一张图片——手写数字 9

|

||||

|

||||

|

||||

|

||||

对我们人类而言,能够很轻松地知道这张图片中包含的信息(数字 9),而对计算机来说这只是一堆像素。计算机视觉的任务就是让计算机能够从这堆像素中得到‘数字 9’这个信息。

|

||||

|

||||

相信你通过上面简单的介绍应该能够了解到计算机视觉是在干嘛了,接下来我会举几个相对复杂的例子来让大家了解一下目前的 cv 是在做怎样的研究:

|

||||

|

||||

::: warning 🐱 **图像分割**是在图片中对物体分类,并且把它们所对应的位置标示出来。下图就是把人的五官,面部皮肤和头发分割出来,效 (小) 果 (丑) 图如下:

|

||||

:::

|

||||

|

||||

<table>

|

||||

<tr>

|

||||

<td><img src=https://cdn.xyxsw.site/boxcnxn5GlJZmsrMV5qKNwMlDPc.jpg width=175></td>

|

||||

<td><img src=https://cdn.xyxsw.site/boxcnokdWGegr2XCi1vfg0ZZiWg.png width=200></td>

|

||||

<td><img src=https://cdn.xyxsw.site/boxcn2o9ilOZg6jI6ssTYWhoeme.png width=200></td>

|

||||

</tr>

|

||||

</table>

|

||||

|

||||

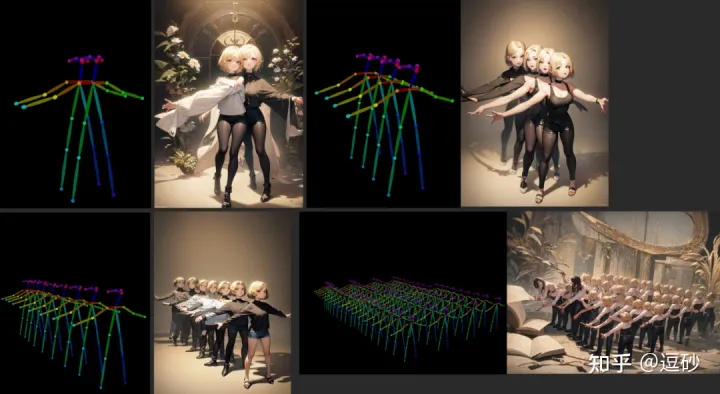

::: warning 🐱 **图像生成**相信大家一定不陌生,NovalAI 在 2022 年火的一塌糊涂,我觉得不需要我过多赘述,对它 (Diffusion model) 的改进工作也是层出不穷,这里就放一张由可控姿势网络 (ControlNet) 生成的图片吧:

|

||||

:::

|

||||

|

||||

|

||||

|

||||

::: warning 🐱 **三维重建**也是很多研究者关注的方向,指的是传入对同一物体不同视角的照片,来生成 3D 建模的任务。这方面比图像处理更加前沿并且难度更大。具体见[4.6.5.4 神经辐射场 (NeRF)](4.6.5.4%E7%A5%9E%E7%BB%8F%E8%BE%90%E5%B0%84%E5%9C%BA(NeRF).md) 章节。

|

||||

:::

|

||||

|

||||

如果对计算机视觉有兴趣,可以通过以下路线进行学习:深度学习快速入门—> 经典网络。本块内容的主要撰写者之一**SRT 社团**多数成员主要从事 CV 方向研究,欢迎与我们交流。

|

||||

|

||||

### NLP(自然语言处理)

|

||||

|

||||

这就更好理解了,让计算机能够像人类一样,理解文本中的“真正含义”。在计算机眼中,文本就是单纯的字符串,NLP 的工作就是把字符转换为计算机可理解的数据。举个例子,ChatGPT(或者 New Bing) 都是 NLP 的成果。在过去,NLP 领域被细分为了多个小任务,比如文本情感分析、关键段落提取等。而 ChatGPT 的出现可以说是集几乎所有小任务于大成,接下来 NLP 方向的工作会向 ChatGPT 的方向靠近。

|

||||

|

||||

<table>

|

||||

<tr>

|

||||

<td><img src=https://cdn.xyxsw.site/boxcnyh6pakAkcxCKq6pLylSdef.png width=580></td>

|

||||

<td><img src=https://cdn.xyxsw.site/boxcnwWnoEDulgWdqGkY0WeYogc.png width=200></td>

|

||||

</tr>

|

||||

</table>

|

||||

|

||||

### 多模态 (跨越模态的处理)

|

||||

|

||||

模态,可以简单理解为数据形式,比如图片是一种模态,文本是一种模态,声音是一种模态,等等……

|

||||

|

||||

而多模态就是让计算机能够将不同模态的信息相对应,一种常用的方法就是让计算机把图片的内容和文本的内容理解为相同的语义(在这个领域一般用一个较长的向量来表示语义)。

|

||||

|

||||

也就是说我**传入一张狗子的照片经过模型得到的向量**与**DOG 这个单词经过模型得到的向量**相近。

|

||||

|

||||

具体的任务比如说**图片问答**,传入一张图片,问 AI 这张图片里面有几只猫猫,它们是什么颜色,它告诉我有一只猫猫,是橙色的:

|

||||

|

||||

|

||||

|

||||

### 对比学习

|

||||

|

||||

因为传统 AI 训练一般都需要数据集标注,比如说图片分割数据集需要人工在数万张图片上抠出具体位置,才能进行训练,这样的人力成本是巨大的,而且难以得到更多数据。因此,对比学习应运而生,这是一种不需要进行标注或者只需要少量标注的训练方式

|

||||

|

||||

### 强化学习

|

||||

|

||||

强调模型如何依据环境(比如扫地机器人在学习家里的陈设,这时陈设就是环境)的变化而改进,以取得最大的收益(比如游戏得到最高分)。

|

||||

|

||||

强化学习是除了监督学习和非监督学习之外的第三种基本的机器学习方法。与监督学习不同的是,强化学习不需要带标签的输入输出对,同时也无需对非最优解的精确地纠正。其关注点在于寻找探索(对未知领域的)和利用(对已有知识的)的平衡。 -------wiki

|

||||

|

||||

强化学习主要理论来源于心理学中的动物学习和最优控制的控制理论。说的通俗点,强化学习就是操控智能体与环境交互、去不断试错,在这个过程中进行学习。因此,强化学习被普遍地应用于游戏、资源优化分配、机器人等领域。强化学习本身已经是个老东西了,但是和深度学习结合之后焕发出了第二春——深度强化学习(DRL)。

|

||||

|

||||

深度强化学习最初来源是 2013 年谷歌 DeepMind 团队发表的《Playing Atari with Deep Reinforcement Learning》一文,正式提出 Deep Q-network(DQN)算法。在这篇论文中,DeepMind 团队训练智能体 Agent 玩雅达利游戏,并取得了惊人的成绩。事实上,深度强化学习最为人熟知的成就是 AlphaGO Zero,它没有使用任何人类棋谱进行训练,训练了三天的成就就已经超过了人类几千年的经验积累<del>导致柯洁道心破碎</del>。

|

||||

|

||||

## 交叉学科&经典机器学习算法

|

||||

|

||||

交叉学科巨大的难度在于你往往需要掌握多个学科以及其相对应的知识。

|

||||

|

||||

举个例子:如果你想要做出一个可以识别病人是否得了某种疾病,现在你得到了一批数据,你首先得自己可以标注出或者找到这个数据中,哪些是有问题的,并且可以指明问题在哪,如果你想分出更具体的,比如具体哪里有问题,那你可能甚至需要熟悉他并且把他标注出来。

|

||||

|

||||

目前其实全学科都有向着 AI 走的趋势,例如量化金融,医疗,生物科学 (nature 的那篇有关氨基酸的重大发现真的很 cool)。他们很多都在用非常传统的机器学习算法,甚至有的大公司的算法岗在处理某些数据的时候,可能会先考虑用最简单的决策树试一试

|

||||

|

||||

当然,在大语言模型出现的趋势下,很多学科的应用会被融合会被简化会被大一统 (科研人的崇高理想),但是不得不提的是,传统的机器学习算法和模型仍然希望你能去了解甚至更进一步学习。

|

||||

|

||||

除了能让你了解所谓前人的智慧,还可以给你带来更进一步的在数学思维,算法思维上的提高。

|

||||

|

||||

## And more?

|

||||

|

||||

我们对 AI 的定义如果仅仅只有这些内容,我认为还是太过于狭隘了,我们可以把知识规划,知识表征等等东西都可以将他划入 AI 的定义中去,当然这些还期待着你的进一步探索和思考~

|

||||

|

||||

## 特别致谢

|

||||

|

||||

非常荣幸能在本章中得到 IIPL 智能信息处理实验室 [http://iipl.net.cn](http://iipl.net.cn) 的宝贵贡献,衷心感谢他们的无私支持与帮助!

|

||||

|

||||

<!-- 希望加入 IIPL?欢迎移步[SRT 社团介绍](SRT.md)~ -->

|

||||

455

2023旧版内容/4.人工智能/4.2机器学习(AI)快速入门(quick start).md

Normal file

@@ -0,0 +1,455 @@

|

||||

# 机器学习(AI)快速入门(quick start)

|

||||

|

||||

::: warning 😇 本章内容需要你掌握一定的 python 基础知识。

|

||||

|

||||

如果你想要快速了解机器学习,并且动手尝试去实践他,你可以先阅览本部分内容。

|

||||

|

||||

里面包含 python 内容的一点点基本语法包括 if,for 等语句,函数等概念即可,你可以遇到了再去学。

|

||||

|

||||

就算没有编程基础也基本能看懂,选择着跳过吧

|

||||

|

||||

当然我需要承认一点,为了让大家都可以看懂,我做了很多抽象,具有了很多例子,某些内容不太准确,这是必然的,最为准确的往往是课本上精确到少一个字都不行的概念,这是难以理解的。

|

||||

|

||||

本篇内容只适合新手理解使用,所以不免会损失一些精度。

|

||||

:::

|

||||

|

||||

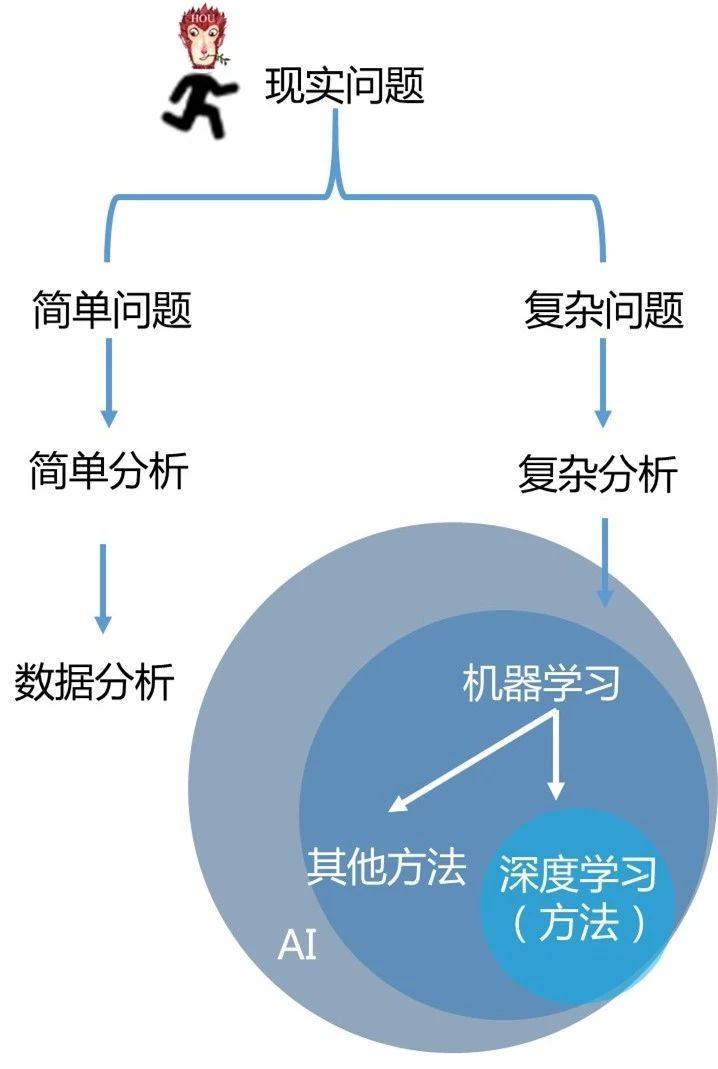

## 什么是机器学习

|

||||

|

||||

这个概念其实不需要那么多杂七杂八的概念去解释。

|

||||

|

||||

首先你要认识到他是人工智能的一部分,不需要写任何与问题有关的特定代码。你把数据输入相关的算法里面,他给你总结相应的规律。

|

||||

|

||||

我举个例子,你现在把他当成一个黑盒,不需要知道里面有什么,但是你知道他会回答你的问题。你想知道房价会怎么变动来决定现在买不买房。然后你给了他十年的房价数据,他发现每年都在涨,所以给你预测了一个数值。

|

||||

|

||||

然后你给了他更多信息,比如说国家给出了某些条例,他分析这个条例一出,房价就会降低,他给你了个新的数据。

|

||||

|

||||

因此我们得出一个结论:机器学习 = 泛型算法。

|

||||

|

||||

甚至深度学习,也只是机器学习的一部分,不过使用了更多技巧和方法,增大了计算能力罢了。

|

||||

|

||||

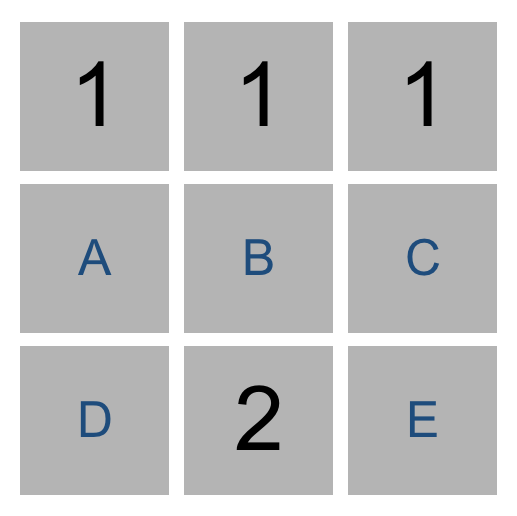

|

||||

|

||||

## 两种机器学习算法

|

||||

|

||||

你可以把机器学习算法分为两大类:监督式学习(supervised Learning)和非监督式学习(unsupervised Learning)。要区分两者很简单,但也非常重要。

|

||||

|

||||

### 监督式学习

|

||||

|

||||

你是卖方的,你公司很大,因此你雇了一批新员工来帮忙。

|

||||

|

||||

但是问题来了——虽然你可以一眼估算出房子的价格,但新员工却不像你这样经验丰富,他们不知道如何给房子估价。

|

||||

|

||||

为了帮助你的新员工,你决定写一个可以根据房屋大小、地段以及同类房屋成交价等因素来评估一间房屋的价格的小软件。

|

||||

|

||||

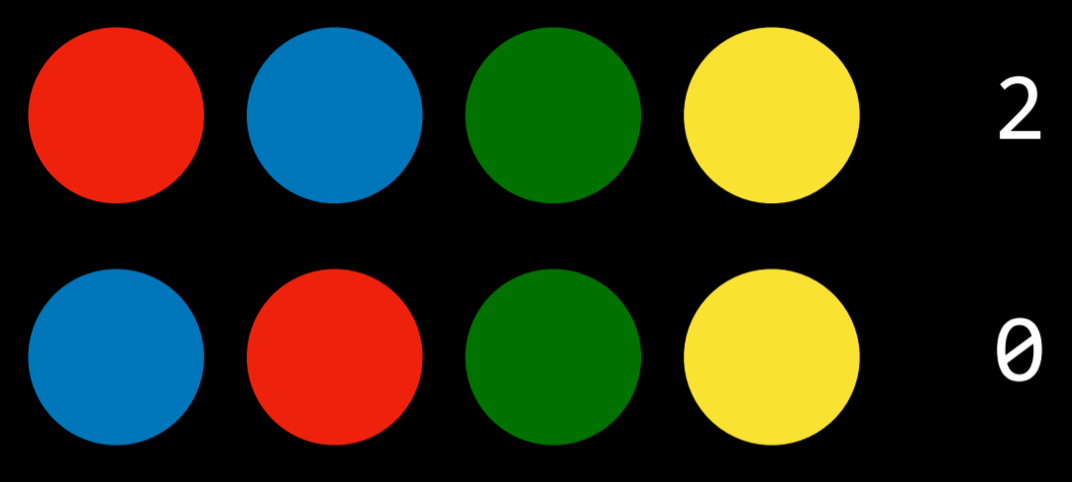

近三个月来,每当你的城市里有人卖了房子,你都记录了下面的细节——卧室数量、房屋大小、地段等等。但最重要的是,你写下了最终的成交价:

|

||||

|

||||

|

||||

|

||||

然后你让新人根据着你的成交价来估计新的数量

|

||||

|

||||

|

||||

|

||||

这就是监督学习,你有一个参照物可以帮你决策。

|

||||

|

||||

### 无监督学习

|

||||

|

||||

没有答案怎么办?

|

||||

|

||||

你可以把类似的分出来啊!

|

||||

|

||||

我举个例子,比如说警察叔叔要查晚上的现金流,看看有没有谁干了不好的事情,于是把数据拎出来。

|

||||

|

||||

发现晚上十点到十二点间,多数的现金交易是几十块几百块。有十几个是交易几千块的。

|

||||

|

||||

然后再把交易给私人账户的和公司账户的分开,发现只有一个是给个人账户的,发现他还是在酒店交易的!

|

||||

|

||||

这下糟糕了,警察叔叔去那个酒店一查,果然发现了有人在干不好的事情。

|

||||

|

||||

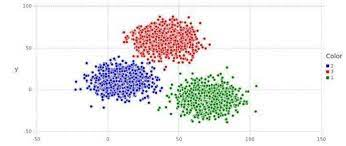

这其实就是一种经典的聚类算法

|

||||

|

||||

|

||||

|

||||

可以把特征不一样的数据分开,有非常多的操作,你感兴趣可以选择性的去了解一下。

|

||||

|

||||

## 太酷炫了,但这也叫 AI?这也叫学习?

|

||||

|

||||

作为人类的一员,你的大脑可以应付绝大多数情况,并且在没有任何明确指令时也能够学习如何处理这些情况。而目前的机器学习就是在帮助我们机器建立起解决问题的能力。

|

||||

|

||||

但是目前的机器学习算法还没有那么强大——它们只能在非常特定的、有限的问题上有效。也许在这种情况下,「学习」更贴切的定义是「在少量样本数据的基础上找出一个公式来解决特定的问题」。

|

||||

|

||||

但是「机器在少量样本数据的基础上找出一个公式来解决特定的问题」不是个好名字。所以最后我们用「机器学习」取而代之。而深度学习,则是机器在数据的基础上通过很深的网络(很多的公式)找一个及解决方案来解决问题。

|

||||

|

||||

## 看看 Code

|

||||

|

||||

如果你完全不懂机器学习知识,你可能会用一堆 if else 条件判断语句来判断比如说房价

|

||||

|

||||

```python

|

||||

def estimate_house_sales_price(num_of_bedrooms, sqft, neighborhood):

|

||||

price = 0 # In my area, the average house costs $200 per sqft

|

||||

price_per_sqft = 200 i f neighborhood == "hipsterton":

|

||||

# but some areas cost a bit more

|

||||

price_per_sqft = 400 elif neighborhood == "skid row":

|

||||

# and some areas cost less

|

||||

price_per_sqft = 100 # start with a base price estimate based on how big the place is

|

||||

price = price_per_sqft * sqft # now adjust our estimate based on the number of bedrooms

|

||||

if num_of_bedrooms == 0:

|

||||

# Studio apartments are cheap

|

||||

price = price — 20000

|

||||

else:

|

||||

# places with more bedrooms are usually

|

||||

# more valuable

|

||||

price = price + (num_of_bedrooms * 1000)

|

||||

return price

|

||||

```

|

||||

|

||||

假如你像这样瞎忙几个小时,最后也许会得到一些像模像样的东西。但是永远感觉差点东西。

|

||||

|

||||

并且,你维护起来非常吃力,你只能不断地加 if else。

|

||||

|

||||

现在看起来还好,但是如果有一万行 if else 呢?

|

||||

|

||||

所以你最好考虑换一种方法:如果能让计算机找出实现上述函数功能的办法,岂不更好?只要返回的房价数字正确,谁会在乎函数具体干了些什么呢?

|

||||

|

||||

```python

|

||||

def estimate_house_sales_price(num_of_bedrooms, sqft, neighborhood):

|

||||

price = <电脑电脑快显灵>

|

||||

return price

|

||||

```

|

||||

|

||||

如果你可以找到这么一个公式:

|

||||

|

||||

Y(房价)=W(参数) \* X1(卧室数量) + W \*X2(面积) + W \* X3(地段)

|

||||

|

||||

你是不是会舒服很多,可以把他想象成,你要做菜,然后那些参数就是佐料的配比

|

||||

|

||||

有一种笨办法去求每一个参数的值:

|

||||

|

||||

第一步:将所有参数都设置为 1

|

||||

|

||||

```python

|

||||

def estimate_house_sales_price(num_of_bedrooms, sqft, neighborhood):

|

||||

price = 0 # a little pinch of this

|

||||

price += num_of_bedrooms *1.0 # and a big pinch of that

|

||||

price += sqft * 1.0 # maybe a handful of this

|

||||

price += neighborhood * 1.0 # and finally, just a little extra salt for good measure

|

||||

price += 1.0

|

||||

return price

|

||||

```

|

||||

|

||||

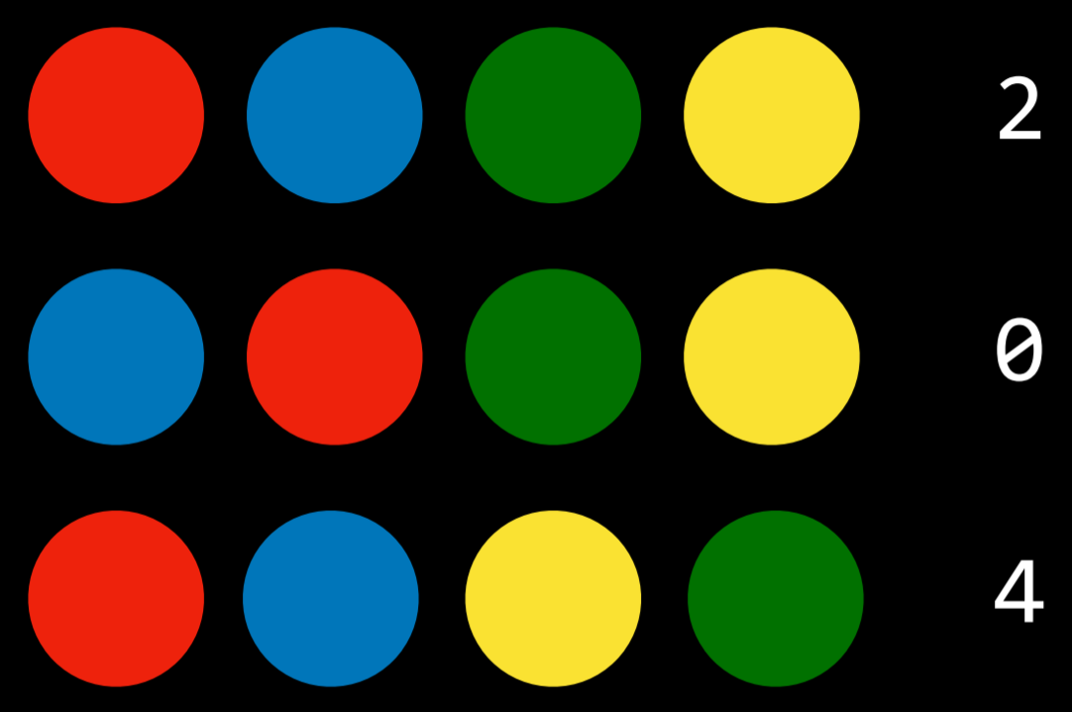

第二步把每个数值都带入进行运算。

|

||||

|

||||

|

||||

|

||||

比如说,如果第一套房产实际成交价为 25 万美元,你的函数估价为 17.8 万美元,这一套房产你就差了 7.2 万。

|

||||

|

||||

现在,将你的数据集中的每套房产估价偏离值平方后求和。假设你的数据集中交易了 500 套房产,估价偏离值平方求和总计为 86,123,373 美元。这个数字就是你的函数现在的「错误」程度。

|

||||

|

||||

现在,将总和除以 500,得到每套房产的估价偏差的平均值。将这个平均误差值称为你函数的代价(cost)。

|

||||

|

||||

如果你能通过调整权重,使得这个代价变为 0,你的函数就完美了。它意味着,根据输入的数据,你的程序对每一笔房产交易的估价都是分毫不差。所以这就是我们的目标——通过尝试不同的权重值,使代价尽可能的低。

|

||||

|

||||

第三步:

|

||||

|

||||

通过尝试所有可能的权重值组合,不断重复第二步。哪一个权重组合的代价最接近于 0,你就使用哪个。当你找到了合适的权重值,你就解决了问题!

|

||||

|

||||

兴奋的时刻到了!

|

||||

|

||||

挺简单的,对吧?想一想刚才你做了些什么。你拿到了一些数据,将它们输入至三个泛型的、简单的步骤中,最后你得到了一个可以对你所在区域任何房屋进行估价的函数。房价网站们,你们要小心了!

|

||||

|

||||

但是下面的一些事实可能会让你更兴奋:

|

||||

|

||||

1. 过去 40 年来,很多领域(如语言学、翻译学)的研究表明,这种「搅拌数字汤」(我编的词)的泛型学习算法已经超过了那些真人尝试明确规则的方法。机器学习的「笨」办法终于打败了人类专家。

|

||||

2. 你最后写出的程序是很笨的,它甚至不知道什么是「面积」和「卧室数量」。它知道的只是搅拌,改变数字来得到正确的答案。

|

||||

3. 你可能会对「为何一组特殊的权重值会有效」一无所知。你只是写出了一个你实际上并不理解却能证明有效的函数。

|

||||

4. 试想,如果你的预测函数输入的参数不是「面积」和「卧室数量」,而是一列数字,每个数字代表了你车顶安装的摄像头捕捉的画面中的一个像素。然后,假设预测的输出不是「价格」而是「方向盘转动角度」,这样你就得到了一个程序可以自动操纵你的汽车了!

|

||||

|

||||

这可行吗?瞎尝试这不得尝试到海枯石烂?

|

||||

|

||||

为了避免这种情况,数学家们找到了很多种[聪明的办法](https://en.wikipedia.org/wiki/Gradient_descent)来快速找到优秀的权重值。下面是一种:

|

||||

|

||||

|

||||

|

||||

这就是被称为 loss 函数的东西。

|

||||

|

||||

这是个专业属于,你可以选择性忽略他,我们将它改写一下

|

||||

|

||||

|

||||

|

||||

*θ 表示当前的权重值。J(θ) 表示「当前权重的代价」。*

|

||||

|

||||

这个等式表示,在当前权重值下,我们估价程序的偏离程度。

|

||||

|

||||

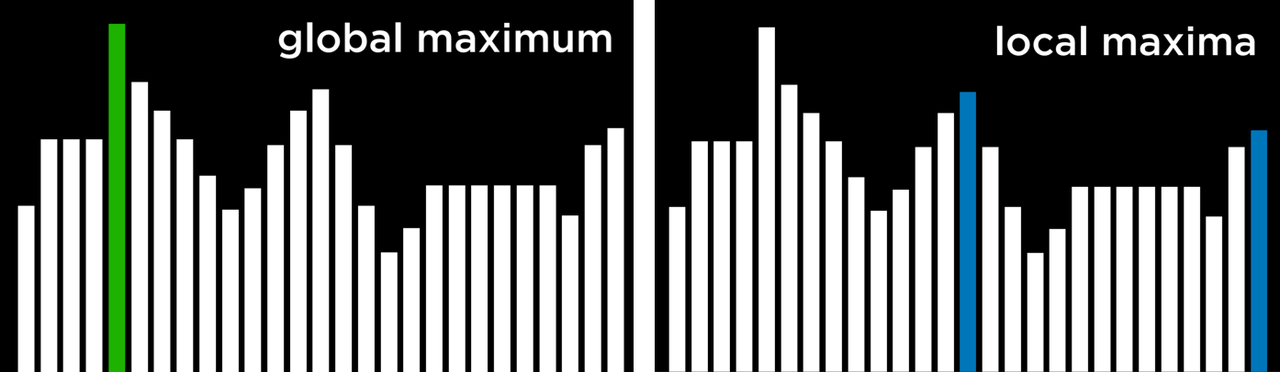

如果我们为这个等式中所有卧室数和面积的可能权重值作图的话,我们会得到类似下图的图表:

|

||||

|

||||

|

||||

|

||||

因此,我们需要做的只是调整我们的权重,使得我们在图上朝着最低点「走下坡路」。如果我们不断微调权重,一直向最低点移动,那么我们最终不用尝试太多权重就可以到达那里。

|

||||

|

||||

如果你还记得一点微积分的话,你也许记得如果你对一个函数求导,它会告诉你函数任意一点切线的斜率。换句话说,对于图上任意给定的一点,求导能告诉我们哪条是下坡路。我们可以利用这个知识不断走向最低点。

|

||||

|

||||

所以,如果我们对代价函数关于每一个权重求偏导,那么我们就可以从每一个权重中减去该值。这样可以让我们更加接近山底。一直这样做,最终我们将到达底部,得到权重的最优值。(读不懂?不用担心,继续往下读)。

|

||||

|

||||

这种为函数找出最佳权重的方法叫做批量梯度下降(Batch Gradient Descent)。

|

||||

|

||||

当你使用一个机器学习算法库来解决实际问题时,这些都已经为你准备好了。但清楚背后的原理依然是有用的。

|

||||

|

||||

|

||||

|

||||

枚举法

|

||||

|

||||

上面我描述的三步算法被称为多元线性回归(multivariate linear regression)。你在估算一个能够拟合所有房价数据点的直线表达式。然后,你再根据房子可能在你的直线上出现的位置,利用这个等式来估算你从未见过的房屋的价格。这是一个十分强大的想法,你可以用它来解决「实际」问题。

|

||||

|

||||

但是,尽管我展示给你的这种方法可能在简单的情况下有效,它却不能应用于所有情况。原因之一,就是因为房价不会是简简单单一条连续的直线。

|

||||

|

||||

不过幸运的是,有很多办法来处理这种情况。有许多机器学习算法可以处理非线性数据。除此之外,灵活使用线性回归也能拟合更复杂的线条。在所有的情况下,寻找最优权重这一基本思路依然适用。

|

||||

|

||||

**如果你还是无法理解,你可以将 cost 类比为你出错误的程度,而数学科学家找到各种方法来降低这种程度,当程度降到最低时,我们就可以知道我们要求的数值了**

|

||||

|

||||

另外,我忽略了过拟合(overfitting)的概念。得到一组能完美预测原始数据集中房价的权重组很简单,但用这组权重组来预测原始数据集之外的任何新房屋其实都不怎么准确。这也是有许多解决办法的(如[正则化](https://en.wikipedia.org/wiki/Regularization_(mathematics))以及使用[交叉验证](https://en.wikipedia.org/wiki/Cross-validation_(statistics))的数据集)。学习如何应对这一问题,是学习如何成功应用机器学习技术的重点之一。

|

||||

|

||||

换言之,尽管基本概念非常简单,要通过机器学习得到有用的结果还是需要一些技巧和经验的。但是,这是每个开发者都能学会的技巧。

|

||||

|

||||

## 更为智能的预测

|

||||

|

||||

我们通过上一次的函数假设已经得到了一些值。

|

||||

|

||||

```python

|

||||

def estimate_house_sales_price(num_of_bedrooms, sqft, neighborhood):

|

||||

price = 0# a little pinch of this

|

||||

price += num_of_bedrooms * 0.123# and a big pinch of that

|

||||

price += sqft * 0.41# maybe a handful of this

|

||||

price += neighborhood * 0.57

|

||||

return price

|

||||

```

|

||||

|

||||

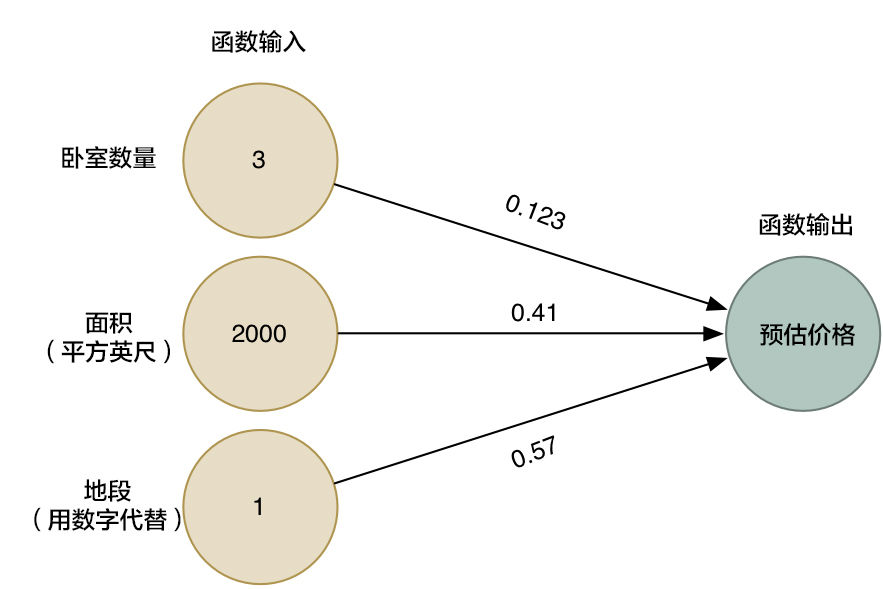

我们换一个好看的形式给他展示

|

||||

|

||||

|

||||

|

||||

*箭头头表示了函数中的权重。*

|

||||

|

||||

然而,这个算法仅仅能用于处理一些简单的问题,就是那些输入和输出有着线性关系的问题。但如果真实价格和决定因素的关系并不是如此简单,那我们该怎么办?比如说,地段对于大户型和小户型的房屋有很大影响,然而对中等户型的房屋并没有太大影响。那我们该怎么在我们的模型中收集这种复杂的信息呢?

|

||||

|

||||

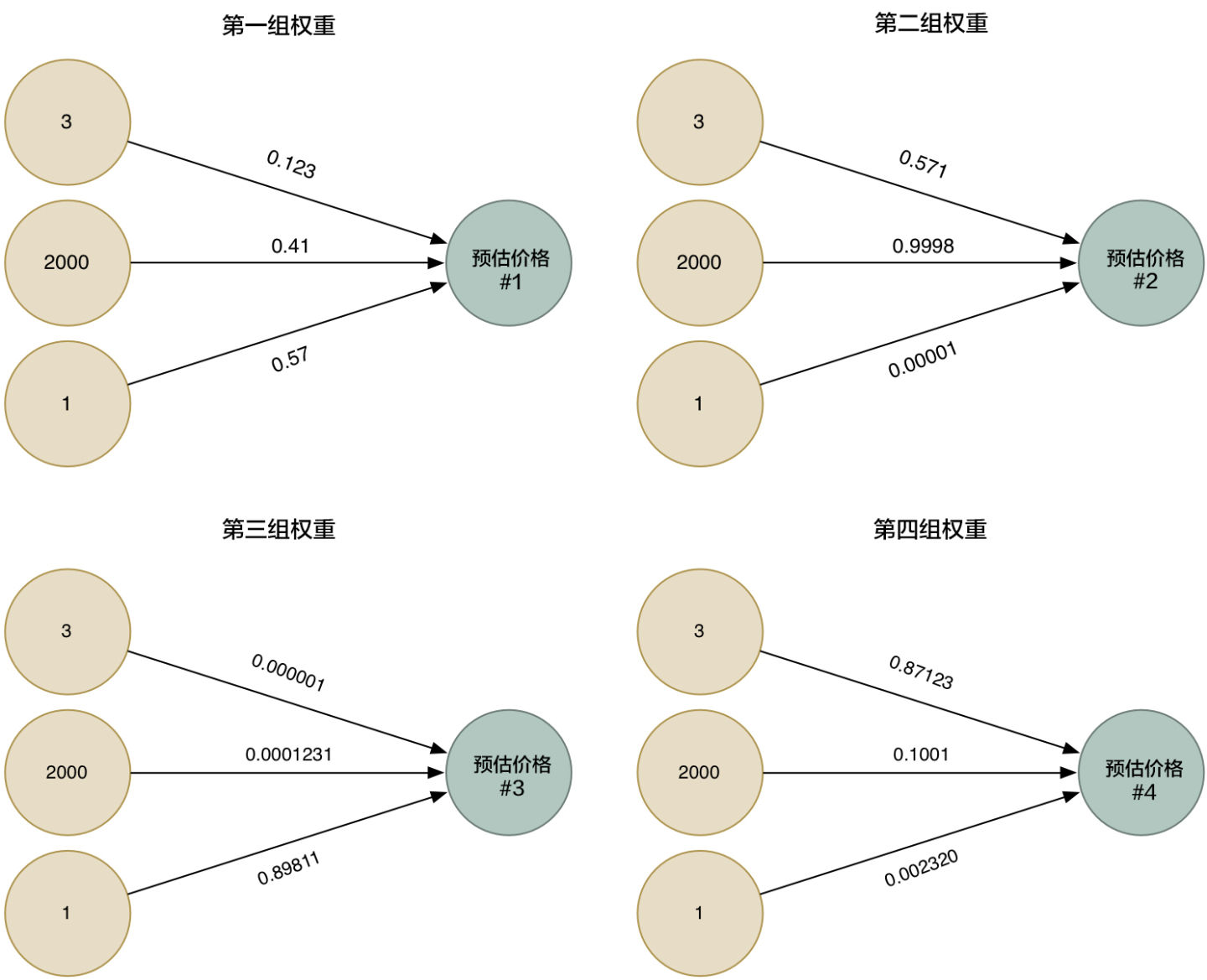

所以为了更加的智能化,我们可以利用不同的权重来多次运行这个算法,收集各种不同情况下的估价。

|

||||

|

||||

|

||||

|

||||

然后我们把四种整合到一起,就得到一个超级答案

|

||||

|

||||

|

||||

|

||||

这样我们相当于得到了更为准确的答案

|

||||

|

||||

## 神经网络是什么

|

||||

|

||||

|

||||

|

||||

我们把四个超级网络的结合图整体画出来,其实这就是个超级简单的神经网络,虽然我们省略了很多的内容,但是他仍然有了一定的拟合能力

|

||||

|

||||

最重要的是下面的这些内容:

|

||||

|

||||

我们制造了一个权重 × 因素的简单函数,我们把这个函数叫做神经元。

|

||||

|

||||

通过连接许许多多的简单神经元,我们能模拟那些不能被一个神经元所模拟的函数。

|

||||

|

||||

通过对这些神经元的有效拼接,我们可以得到我们想要的结果。

|

||||

|

||||

当我用 pytorch 写对一个函数拟合时

|

||||

|

||||

```python

|

||||

import torch

|

||||

|

||||

x_data =torch.Tensor ([[1.0],[2.0], [3.0]])

|

||||

y_data = torch.Tensor([[2.0], [4.0], [6.0]])

|

||||

|

||||

class LinearModel(torch.nn.Module):

|

||||

def __init__(self):

|

||||

super(LinearModel,self).__init__()

|

||||

self.linear=torch.nn.Linear(1,1)

|

||||

|

||||

def forward(self,x):

|

||||

y_pred=self.linear(x)

|

||||

return y_pred

|

||||

'''

|

||||

线性模型所必须的前馈传播,即 wx+b

|

||||

'''

|

||||

|

||||

model=LinearModel()

|

||||

#对于对象的直接使用

|

||||

criterion=torch.nn.MSELoss()

|

||||

#损失函数的计算

|

||||

optimizer=torch.optim.SGD(model.parameters(),lr=0.01)

|

||||

#优化器

|

||||

for epoch in range(100):

|

||||

y_pred=model(x_data)

|

||||

loss=criterion(y_pred,y_data)

|

||||

print(epoch,loss)

|

||||

|

||||

optimizer.zero_grad()

|

||||

loss.backward()

|

||||

#反向传播

|

||||

optimizer.step()

|

||||

#数值更新

|

||||

print('w=',model.linear.weight.item())

|

||||

print('b=',model.linear.bias.item())

|

||||

|

||||

x_test=torch.Tensor([[4.0]])

|

||||

y_test=model(x_test)

|

||||

print('y_pred=',y_test.data)

|

||||

```

|

||||

|

||||

## 由浅入深(不会涉及代码)

|

||||

|

||||

::: warning 😇 为什么不教我写代码?

|

||||

|

||||

因为你可能看这些基础知识感觉很轻松毫无压力,但是倘若附上很多代码,会一瞬间拉高这里的难度,虽然仅仅只是调包。

|

||||

|

||||

但是我还是会在上面贴上一点代码,但不会有很详细的讲解,因为很多都是调包,没什么好说的,如果你完全零基础,忽略这部分内容即可

|

||||

|

||||

:::

|

||||

|

||||

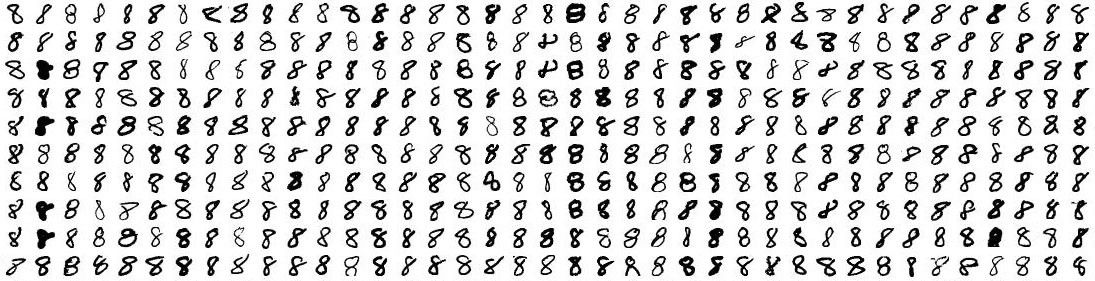

我们尝试做一个神奇的工作,那就是用神经网络来识别一下手写数字,听上去非常不可思议,但是我要提前说的一点是,图像也不过是数据的组合,每一张图片有不同程度的像素值,如果我们把每一个像素值都当成神经网络的输入值,然后经过一个黑盒,让他识别出一个他认为可能的数字,然后进行纠正即可。

|

||||

|

||||

机器学习只有在你拥有数据(最好是大量数据)的情况下,才能有效。所以,我们需要有大量的手写「8」来开始我们的尝试。幸运的是,恰好有研究人员建立了《MNIST 手写数字数据库》 ,它能助我们一臂之力。MNIST 提供了 60,000 张手写数字的图片,每张图片分辨率为 18×18。即有这么多的数据。

|

||||

|

||||

```python

|

||||

(X_train, y_train), (X_test, y_test) = mnist.load_data()

|

||||

#这段是导入 minist 的方法,但是你看不到,如果你想看到的话需要其他操作

|

||||

```

|

||||

|

||||

我们试着只识别一个数字 8

|

||||

|

||||

|

||||

|

||||

|

||||

|

||||

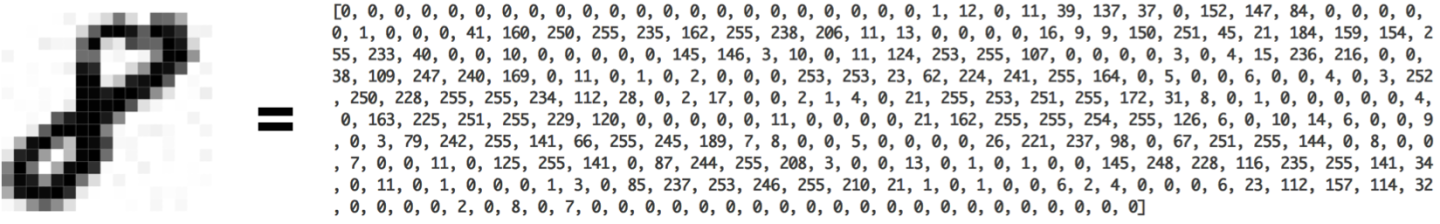

我们把一幅 18×18 像素的图片当成一串含有 324 个数字的数组,就可以把它输入到我们的神经网络里面了:

|

||||

|

||||

|

||||

|

||||

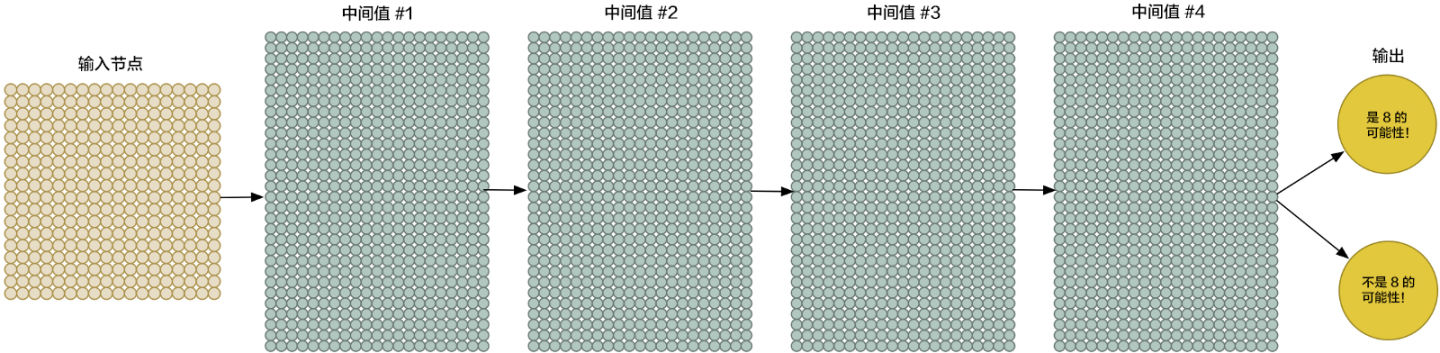

为了更好地操控我们的输入数据,我们把神经网络的输入节点扩大到 324 个:

|

||||

|

||||

|

||||

|

||||

请注意,我们的神经网络现在有了两个输出(而不仅仅是一个房子的价格)。第一个输出会预测图片是「8」的概率,而第二个则输出不是「8」的概率。概括地说,我们就可以依靠多种不同的输出,利用神经网络把要识别的物品进行分组。

|

||||

|

||||

```python

|

||||

model = Sequential([Dense(32, input_shape=(784,)),

|

||||

Activation('relu'),Dense(10),Activation('softmax')])

|

||||

# 你也可以通过 .add() 方法简单地添加层:

|

||||

model = Sequential()

|

||||

model.add(Dense(32, input_dim=784))

|

||||

model.add(Activation('relu'))# 激活函数,你可以理解为加上这个东西可以让他效果更好

|

||||

```

|

||||

|

||||

虽然我们的神经网络要比上次大得多(这次有 324 个输入,上次只有 3 个!),但是现在的计算机一眨眼的功夫就能够对这几百个节点进行运算。当然,你的手机也可以做到。

|

||||

|

||||

现在唯一要做的就是用各种「8」和非「8」的图片来训练我们的神经网络了。当我们喂给神经网络一个「8」的时候,我们会告诉它是「8」的概率是 100% ,而不是「8」的概率是 0%,反之亦然。

|

||||

|

||||

## 仅此而已吗

|

||||

|

||||

当数字并不是正好在图片中央的时候,我们的识别器就完全不工作了。一点点的位移我们的识别器就掀桌子不干了

|

||||

|

||||

|

||||

|

||||

这是因为我们的网络只学习到了正中央的「8」。它并不知道那些偏离中心的「8」长什么样子。它仅仅知道中间是「8」的图片规律。

|

||||

|

||||

在真实世界中,这种识别器好像并没什么卵用。真实世界的问题永远不会如此轻松简单。所以,我们需要知道,当「8」不在图片正中时,怎么才能让我们的神经网络识别它。

|

||||

|

||||

### 暴力方法:更多的数据和更深的网络

|

||||

|

||||

他不能识别靠左靠右的数据?我们都给他!给他任何位置的图片!

|

||||

|

||||

或者说,我们可以用一些库把图片进行一定的裁剪,翻转,甚至添加一些随机噪声。

|

||||

|

||||

如果这些都识别一遍,那不是都懂了吗?

|

||||

|

||||

当然,你同时也需要更强的拟合能力和更深的网络。

|

||||

|

||||

|

||||

|

||||

|

||||

|

||||

一层一层堆叠起来,这种方法很早就出现了。

|

||||

|

||||

### 更好的方法?

|

||||

|

||||

你可以通过卷积神经网络进行进一步的处理

|

||||

|

||||

作为人类,你能够直观地感知到图片中存在某种层级(hierarchy)或者是概念结构(conceptual structure)。比如说,你在看

|

||||

|

||||

|

||||

|

||||

你会快速的辨认出一匹马,一个人。

|

||||

|

||||

当这些东西换个地方出现的时候,他该是马还是马该是人还是人。

|

||||

|

||||

但是现在,我们的神经网络做不到这些。它认为「8」出现在图片的不同位置,就是不一样的东西。它不能理解「物体出现在图片的不同位置还是同一个物体」这个概念。这意味着在每种可能出现的位置上,它必须重新学习识别各种物体。

|

||||

|

||||

有人对此做过研究,人的眼睛可能会逐步判断一个物体的信息,比如说你看到一张图片,你会先看颜色,然后看纹理然后再看整体,那么我们需要一种操作来模拟这个过程,我们管这种操作叫卷积操作。

|

||||

|

||||

|

||||

|

||||

### 卷积是如何工作的

|

||||

|

||||

之前我们提到过,我们可以把一整张图片当做一串数字输入到神经网络里面。不同的是,这次我们会利用**平移不变性**的概念来把这件事做得更智能。

|

||||

|

||||

当然也有最新研究说卷积不具备平移不变性,但是我这里使用这个概念是为了大伙更好的理解,举个例子:你将 8 无论放在左上角还是左下角都改变不了他是 8 的事实

|

||||

|

||||

|

||||

|

||||

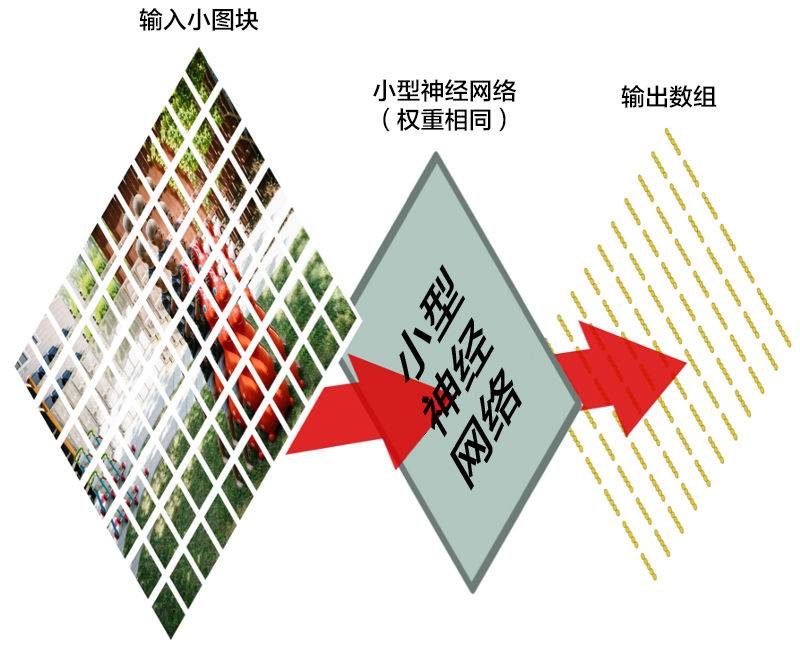

我们将一张图像分成这么多个小块,然后输入神经网络中的是一个小块。*每次判断一张小图块。*

|

||||

|

||||

然而,有一个非常重要的不同:对于每个小图块,我们会使用同样的神经网络权重。换一句话来说,我们平等对待每一个小图块。如果哪个小图块有任何异常出现,我们就认为这个图块是「异常」

|

||||

|

||||

|

||||

|

||||

换一句话来说,我们从一整张图片开始,最后得到一个稍小一点的数组,里面存储着我们图片中的哪一部分有异常。

|

||||

|

||||

### 池化层

|

||||

|

||||

图像可能特别大。比如说 1024*1024 再来个颜色 RGB

|

||||

|

||||

那就有 1024*1024*3 这么多的数据,这对计算机来说去处理是不可想象的占用计算资源,所以我们需要用一种方式来降低他的计算量并且尽可能地保证丢失的数据不多。

|

||||

|

||||

让我们先来看每个 2×2 的方阵数组,并且留下最大的数:

|

||||

|

||||

|

||||

|

||||

每一波我们只保留一个数,这样就大大减少了图片的计算量了。

|

||||

|

||||

当然你也可以不选最大的,池化有很多种方式。

|

||||

|

||||

这损失也太大了吧!

|

||||

|

||||

这样子搞不会很糟糕么?确实,他会损失大量的数据,也正因如此,我们需要往里面塞大量的数据,有的数据集大的超乎你的想象,你可以自行查阅 imagenet 这种大型数据集。

|

||||

|

||||

当然,还有一些未公开的商用数据集,它们的数量更为庞大,运算起来更为复杂。

|

||||

|

||||

尽管如此,我们依然要感谢先驱,他们让一件事从能变成了不能

|

||||

|

||||

我们也要感谢显卡,这项技术早就出现了但是一直算不了,有了显卡让这件事成为了可能。

|

||||

|

||||

### 作出预测

|

||||

|

||||

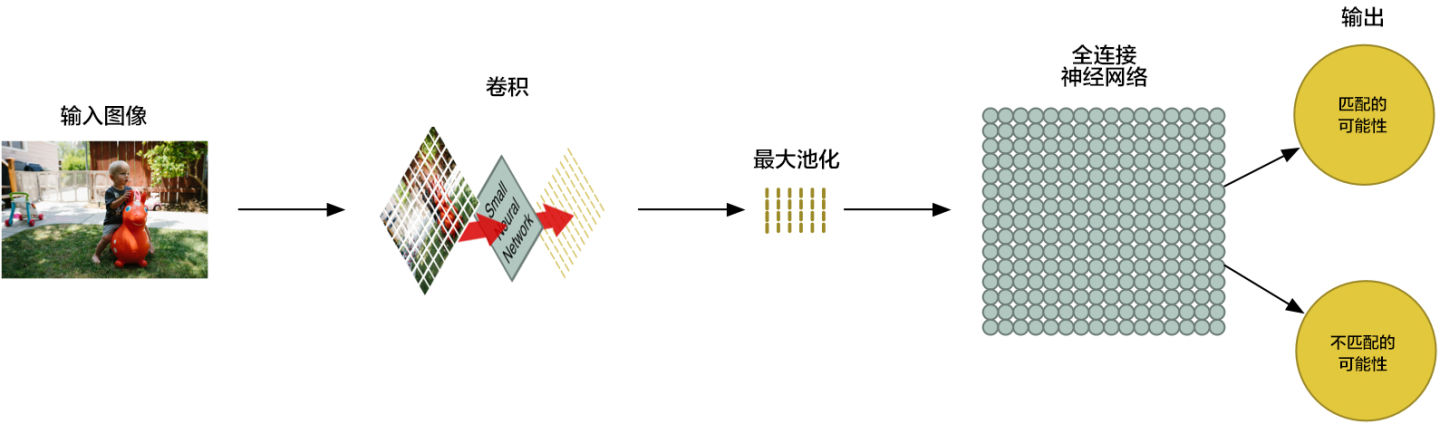

到现在为止,我们已经把一个很大的图片缩减到了一个相对较小的数组。

|

||||

|

||||

你猜怎么着?数组就是一串数字而已,所以我们我们可以把这个数组输入到另外一个神经网络里面去。最后的这个神经网络会决定这个图片是否匹配。为了区分它和卷积的不同,我们把它称作「全连接」网络

|

||||

|

||||

|

||||

|

||||

我们的图片处理管道是一系列的步骤:卷积、最大池化,还有最后的「全连接」网络。

|

||||

|

||||

你可以把这些步骤任意组合、堆叠多次,来解决真实世界中的问题!你可以有两层、三层甚至十层卷积层。当你想要缩小你的数据大小时,你也随时可以调用最大池化函数。

|

||||

|

||||

我们解决问题的基本方法,就是从一整个图片开始,一步一步逐渐地分解它,直到你找到了一个单一的结论。你的卷积层越多,你的网络就越能识别出复杂的特征。

|

||||

|

||||

比如说,第一个卷积的步骤可能就是尝试去识别尖锐的东西,而第二个卷积步骤则是通过找到的尖锐物体来找鸟类的喙,最后一步是通过鸟喙来识别整只鸟,以此类推。

|

||||

|

||||

## 结语

|

||||

|

||||

这篇文章仅仅只是粗略的讲述了一些机器学习的一些基本操作,如果你要更深一步学习的话你可能还需要更多的探索。

|

||||

|

||||

## 参考资料

|

||||

|

||||

[machine-learning-for-software-engineers/README-zh-CN.md at master · ZuzooVn/machine-learning-for-sof](https://github.com/ZuzooVn/machine-learning-for-software-engineers/blob/master/README-zh-CN.md#%E6%9C%BA%E5%99%A8%E5%AD%A6%E4%B9%A0%E6%A6%82%E8%AE%BA)

|

||||

209

2023旧版内容/4.人工智能/4.3.1.1程序示例——maze迷宫解搜索.md

Normal file

@@ -0,0 +1,209 @@

|

||||

# 程序示例——maze 迷宫解搜索

|

||||

|

||||

::: warning 😋

|

||||

阅读程序中涉及搜索算法的部分,然后运行程序,享受机器自动帮你寻找路径的快乐!

|

||||

完成习题

|

||||

:::

|

||||

|

||||

::: tip 📥

|

||||

本节附件下载 <Download url="https://cdn.xyxsw.site/code/1-Lecture.zip"/>

|

||||

:::

|

||||

|

||||

## Node

|

||||

|

||||

```python

|

||||

# 节点类 Node

|

||||

class Node:

|

||||

def __init__(self, state, parent, action):

|

||||

self.state = state # 存储该结点的迷宫状态(即位置)

|

||||

self.parent = parent # 存储父结点

|

||||

self.action = action # 存储采取的行动

|

||||

```

|

||||

|

||||

## 节点复习

|

||||

|

||||

- 节点是一种包含以下数据的数据结构:

|

||||

- 状态——state

|

||||

- 其父节点,通过该父节点生成当前节点——parent node

|

||||

- 应用于父级状态以获取当前节点的操作——action

|

||||

- 从初始状态到该节点的路径成本——path cost

|

||||

|

||||

## 堆栈边域——DFS

|

||||

|

||||

```python

|

||||

class StackFrontier: # 堆栈边域

|

||||

def __init__(self):

|

||||

self.frontier = [] # 边域

|

||||

def add(self, node): # 堆栈添加结点

|

||||

self.frontier.append(node)

|

||||

def contains_state(self, state):

|

||||

return any(node.state == state for node in self.frontier)

|

||||

def empty(self): # 判断边域为空

|

||||

return len(self.frontier) == 0

|

||||

def remove(self): # 移除结点

|

||||

if self.empty():

|

||||

raise Exception("empty frontier")

|

||||

else:

|

||||

node = self.frontier[-1]

|

||||

self.frontier = self.frontier[:-1]

|

||||

return node

|

||||

```

|

||||

|

||||

## 深度优先搜索复习

|

||||

|

||||

深度优先搜索算法在尝试另一个方向之前耗尽每个方向。在这些情况下,边域作为堆栈数据结构进行管理。这里需要记住的流行语是“后进先出”。在将节点添加到边域后,第一个要删除和考虑的节点是最后一个要添加的节点。这导致了一种搜索算法,该算法在第一个方向上尽可能深入,直到尽头,同时将所有其他方向留到后面。“不撞南墙不回头”

|

||||

|

||||

## 队列边域——BFS

|

||||

|

||||

```python

|

||||

class QueueFrontier(StackFrontier): # 队列边域

|

||||

def remove(self):

|

||||

if self.empty():

|

||||

raise Exception("empty frontier")

|

||||

else:

|

||||

node = self.frontier[0]

|

||||

self.frontier = self.frontier[1:]

|

||||

return node

|

||||

```

|

||||

|

||||

## 广度优先搜索复习

|

||||

|

||||

广度优先搜索算法将同时遵循多个方向,在每个可能的方向上迈出一步,然后在每个方向上迈出第二步。在这种情况下,边域作为队列数据结构进行管理。这里需要记住的流行语是“先进先出”。在这种情况下,所有新节点都会排成一行,并根据先添加的节点来考虑节点(先到先得!)。这导致搜索算法在任何一个方向上迈出第二步之前,在每个可能的方向上迈出一步。

|

||||

|

||||

## 迷宫解——Maze_solution

|

||||

|

||||

```python

|

||||

class Maze:

|

||||

def __init__(self, filename): # 读入迷宫图

|

||||

# 读入文件,设置迷宫大小

|

||||

with open(filename) as f:

|

||||

contents = f.read()

|

||||

# 验证起点和目标

|

||||

if contents.count("A") != 1:

|

||||

raise Exception("maze must have exactly one start point")

|

||||

if contents.count("B") != 1:

|

||||

raise Exception("maze must have exactly one goal")

|

||||

# 绘制迷宫大小

|

||||

contents = contents.splitlines()

|

||||

self.height = len(contents)

|

||||

self.width = max(len(line) for line in contents)

|

||||

# 绘制迷宫墙,起点,终点

|

||||

self.walls = []

|

||||

for i in range(self.height):

|

||||

row = []

|

||||

for j in range(self.width):

|

||||

try:

|

||||

if contents[i][j] == "A": # 设置起点

|

||||

self.start = (i, j)

|

||||

row.append(False)

|

||||

elif contents[i][j] == "B":

|

||||

self.goal = (i, j) # 设置终点

|

||||

row.append(False)

|

||||

elif contents[i][j] == " ":

|

||||

row.append(False) # 设置墙体

|

||||

else:

|

||||

row.append(True) # 可移动的点为 True

|

||||

except IndexError:

|

||||

row.append(False)

|

||||

self.walls.append(row)

|

||||

self.solution = None

|

||||

# 打印结果

|

||||

def print(self):

|

||||

...

|

||||

# 寻找邻结点,返回元组 (动作,坐标 (x,y))

|

||||

def neighbors(self, state):

|

||||

row, col = state

|

||||

candidates = [

|

||||

("up", (row - 1, col)),

|

||||

("down", (row + 1, col)),

|

||||

("left", (row, col - 1)),

|

||||

("right", (row, col + 1))

|

||||

]

|

||||

result = []

|

||||

for action, (r, c) in candidates:

|

||||

if 0 <= r < self.height and 0 <= c < self.width and not self.walls[r][c]:

|

||||

result.append((action, (r, c)))

|

||||

return result

|

||||

def solve(self):

|

||||

# 搜索迷宫解

|

||||

self.num_explored = 0 # 已搜索的路径长度

|

||||

# 将边界初始化为起始位置

|

||||

start = Node(state=self.start, parent=None, action=None)

|

||||

frontier = StackFrontier() # 采用 DFS

|

||||

# frontier = QueueFrontier() # 采用 BFS

|

||||

frontier.add(start)

|

||||

# 初始化一个空的探索集

|

||||

self.explored = set() # 存储已搜索的结点

|

||||

# 保持循环直到找到解决方案

|

||||

while True:

|

||||

# 无解情况

|

||||

if frontier.empty():

|

||||

raise Exception("no solution")

|

||||

# 从边界中选择一个节点

|

||||

node = frontier.remove()

|

||||

self.num_explored += 1

|

||||

# 得到解决路径

|

||||

if node.state == self.goal:

|

||||

actions = []

|

||||

cells = []

|

||||

while node.parent is not None: # 遍历父节点得到路径动作

|

||||

actions.append(node.action)

|

||||

cells.append(node.state)

|

||||

node = node.parent

|

||||

actions.reverse()

|

||||

cells.reverse()

|

||||

self.solution = (actions, cells)

|

||||

return

|

||||

# 将节点标记为已探索

|

||||

self.explored.add(node.state)

|

||||

# 将邻居添加到边界(展开节点)

|

||||

for action, state in self.neighbors(node.state):

|

||||

if not frontier.contains_state(state) and state not in self.explored:

|

||||

child = Node(state=state, parent=node, action=action)

|

||||

frontier.add(child)

|

||||

def output_image(self, filename, show_solution=True, show_explored=False):

|

||||

...

|

||||

```

|

||||

|

||||

## Quiz

|

||||

|

||||

1. 在深度优先搜索(DFS)和广度优先搜索(BFS)之间,哪一个会在迷宫中找到更短的路径?

|

||||

1. DFS 将始终找到比 BFS 更短的路径

|

||||

2. BFS 将始终找到比 DFS 更短的路径

|

||||

3. DFS 有时(但并非总是)会找到比 BFS 更短的路径

|

||||

4. BFS 有时(但并非总是)会找到比 DFS 更短的路径

|

||||

5. 两种算法总是能找到相同长度的路径

|

||||

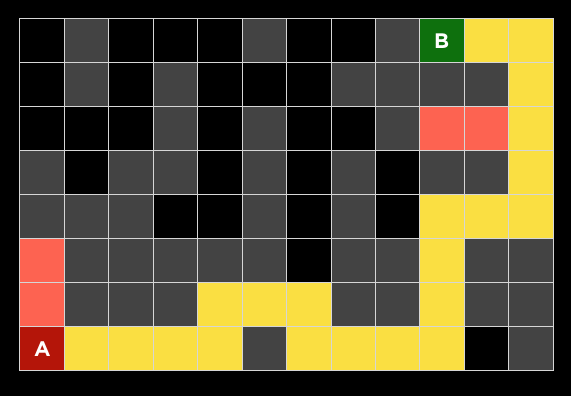

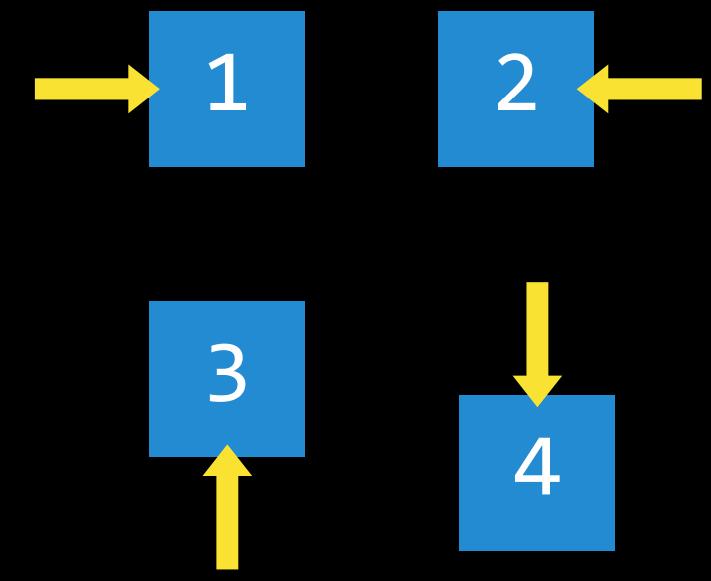

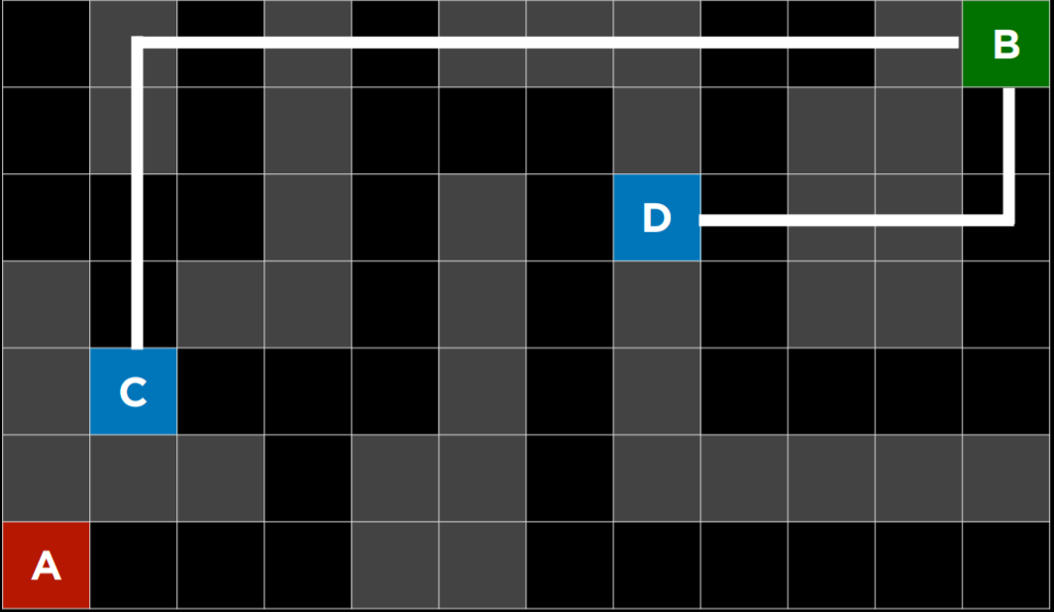

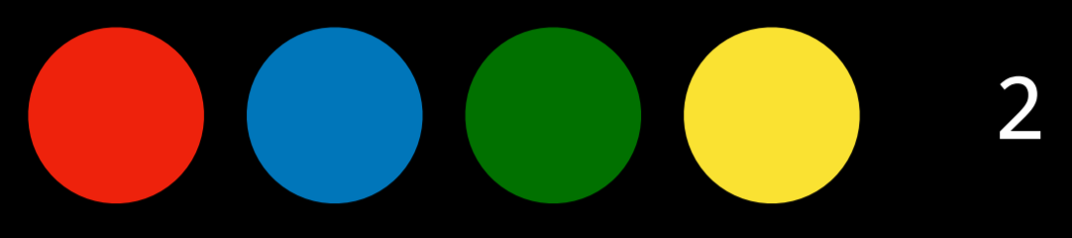

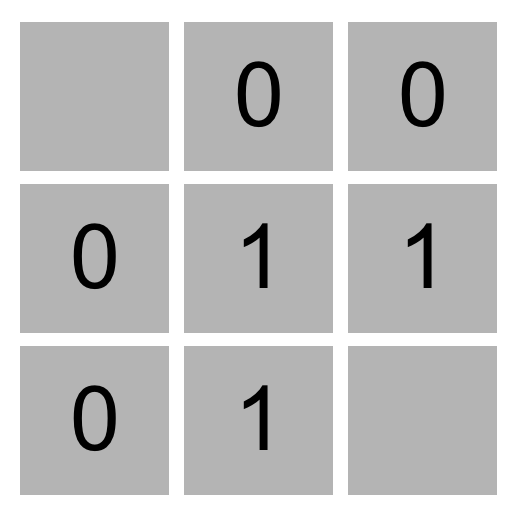

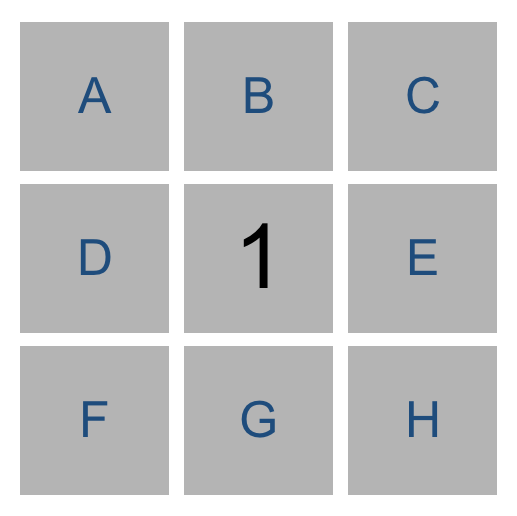

2. 下面的问题将问你关于下面迷宫的问题。灰色单元格表示墙壁。在这个迷宫上运行了一个搜索算法,找到了从 A 点到 B 点的黄色突出显示的路径。在这样做的过程中,红色突出显示的细胞是探索的状态,但并没有达到目标。

|

||||

|

||||

|

||||

|

||||

在讲座中讨论的四种搜索算法中——深度优先搜索、广度优先搜索、曼哈顿距离启发式贪婪最佳优先搜索和曼哈顿距离启发式$A^*$

|

||||

|

||||

搜索——可以使用哪一种(或多种,如果可能的话)?

|

||||

1. 只能是$A^*$

|

||||

2. 只能是贪婪最佳优先搜索

|

||||

3. 只能是 DFS

|

||||

4. 只能是 BFS

|

||||

5. 可能是$A^*$或贪婪最佳优先搜索

|

||||

6. 可以是 DFS 或 BFS

|

||||

7. 可能是四种算法中的任何一种

|

||||

8. 不可能是四种算法中的任何一种

|

||||

3. 为什么有深度限制的极大极小算法有时比没有深度限制的极大极小更可取?

|

||||

1. 深度受限的极大极小算法可以更快地做出决定,因为它探索的状态更少

|

||||

2. 深度受限的极大极小算法将在没有深度限制的情况下实现与极大极小算法相同的输出,但有时会使用较少的内存

|

||||

3. 深度受限的极大极小算法可以通过不探索已知的次优状态来做出更优化的决策

|

||||

4. 深度限制的极小极大值永远不会比没有深度限制的极大极小值更可取

|

||||

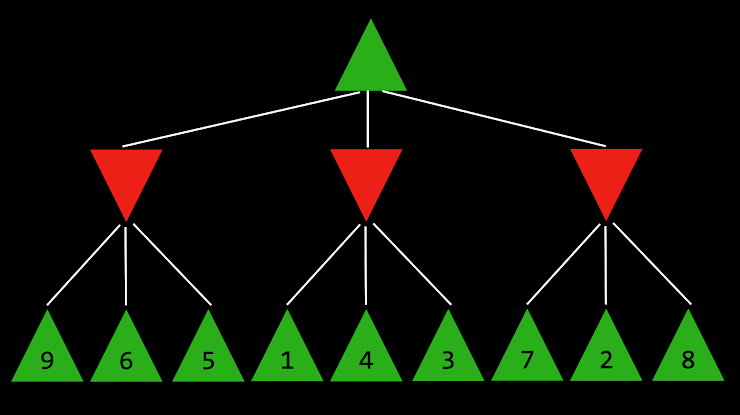

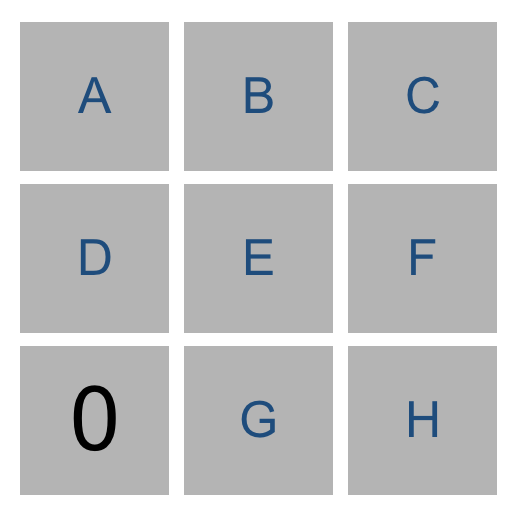

4. 下面的问题将询问您关于下面的 Minimax 树,其中绿色向上箭头表示 MAX 玩家,红色向下箭头表示 MIN 玩家。每个叶节点都标有其值。

|

||||

|

||||

|

||||

|

||||

根节点的值是多少?

|

||||

|

||||

1. 2

|

||||

2. 3

|

||||

3. 4

|

||||

4. 5

|

||||

5. 6

|

||||

6. 7

|

||||

7. 8

|

||||

8. 9

|

||||

65

2023旧版内容/4.人工智能/4.3.1.2项目:Tic-Tac-Toe井字棋.md

Normal file

@@ -0,0 +1,65 @@

|

||||

# 项目:Tic-Tac-Toe 井字棋

|

||||

|

||||

::: warning 😋 我们为你提供了一个简单有趣的项目,帮助你进行知识巩固,请认真阅读文档内容。

|

||||

|

||||

如果你卡住了,请记得回来阅读文档,或请求身边人的帮助。

|

||||

:::

|

||||

|

||||

::: tip 📥

|

||||

本节附件下载 <Download url="https://cdn.xyxsw.site/code/1-Projects.zip"/>

|

||||

:::

|

||||

|

||||

`pip3 install -r requirements.txt`

|

||||

|

||||

## 理解

|

||||

|

||||

这个项目有两个主要文件:`runner.py` 和 `tictactoe.py`。`tictactoe.py` 包含了玩游戏和做出最佳动作的所有逻辑。`runner.py` 已经为你实现,它包含了运行游戏图形界面的所有代码。一旦你完成了 `tictactoe.py` 中所有必需的功能,你就可以运行 `python runner.py` 来对抗你的人工智能了!

|

||||

|

||||

让我们打开 `tictactoe.py` 来了解所提供的内容。首先,我们定义了三个变量:X、O 和 EMPTY,以表示游戏的可能移动。

|

||||

|

||||

函数 `initial_state` 返回游戏的启动状态。对于这个问题,我们选择将游戏状态表示为三个列表的列表(表示棋盘的三行),其中每个内部列表包含三个值,即 X、O 或 EMPTY。以下是我们留给你实现的功能!

|

||||

|

||||

## 说明

|

||||

|

||||

实现 `player`, `actions`, `result`, `winner`, `terminal`, `utility`, 以及 `minimax`.

|

||||

|

||||

- `player` 函数应该以棋盘状态作为输入,并返回轮到哪个玩家(X 或 O)。

|

||||

|

||||

- 在初始游戏状态下,X 获得第一步。随后,玩家交替进行每一个动作。

|

||||

- 如果提供结束棋盘状态作为输入(即游戏已经结束),则任何返回值都是可接受的。

|

||||

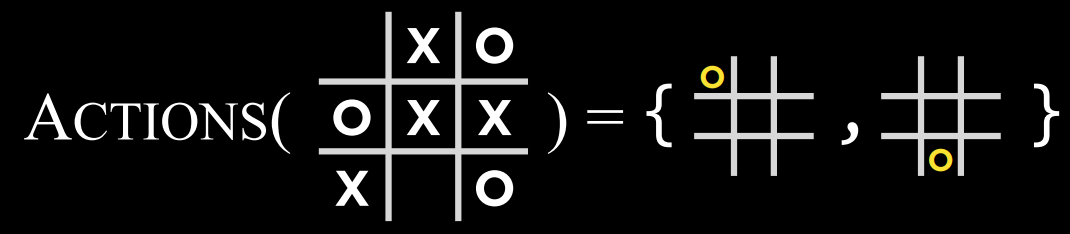

- `actions` 函数应该返回一组在给定的棋盘状态上可以采取的所有可能的操作。

|

||||

|

||||

- 每个动作都应该表示为元组 `(i,j)`,其中 `i` 对应于移动的行(0、1 或 2),`j` 对应于行中的哪个单元格对应于移动(也是 0、1、或 2)。

|

||||

- 可能的移动是棋盘上任何没有 X 或 O 的单元格。

|

||||

- 如果提供结束棋盘状态作为输入,则任何返回值都是可接受的。

|

||||

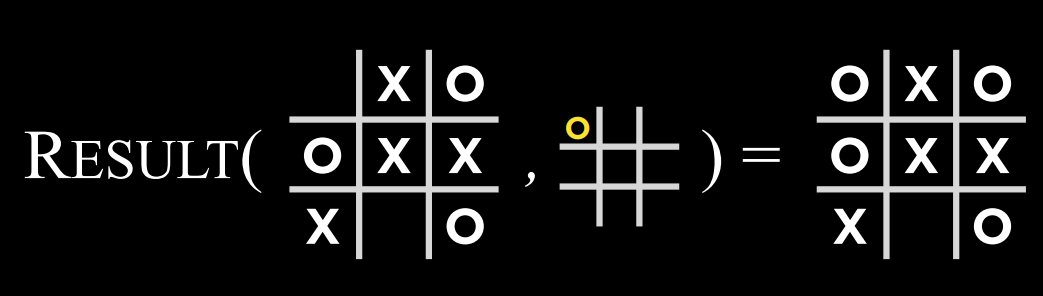

- `result` 函数以一个棋盘状态和一个动作作为输入,并且应该返回一个新的棋盘状态,而不修改原始棋盘。

|

||||

|

||||

- 如果 `action` 函数接受了一个无效的动作,你的程序应该<u>raise an exception</u>.

|

||||

- 返回的棋盘状态应该是从原始输入棋盘,并让轮到它的玩家在输入动作指示的单元格处移动所产生的棋盘。

|

||||

- 重要的是,原始棋盘应该保持不变:因为 Minimax 最终需要在计算过程中考虑许多不同的棋盘状态。这意味着简单地更新棋盘上的单元格本身并不是 `result` 函数的正确实现。在做出任何更改之前,你可能需要先对棋盘状态进行<u>deep copy</u>。

|

||||

- `winner` 函数应该接受一个棋盘作为输入,如果游戏结束,则返回游戏的获胜者。

|

||||

|

||||

- 如果 X 玩家赢得了游戏,函数应该返回 X。如果 O 玩家赢得了比赛,函数应该返回 O。

|

||||

- 一个人可以通过水平、垂直或对角连续三次移动赢得比赛。

|

||||

- 你可以认为最多会有一个赢家(也就是说,没有一个棋盘会同时有两个玩家连着三个,因为这将是一个无效的棋盘状态)。

|

||||

- 如果游戏没有赢家(要么是因为游戏正在进行,要么是因为比赛以平局结束),函数应该返回 `None`。

|

||||

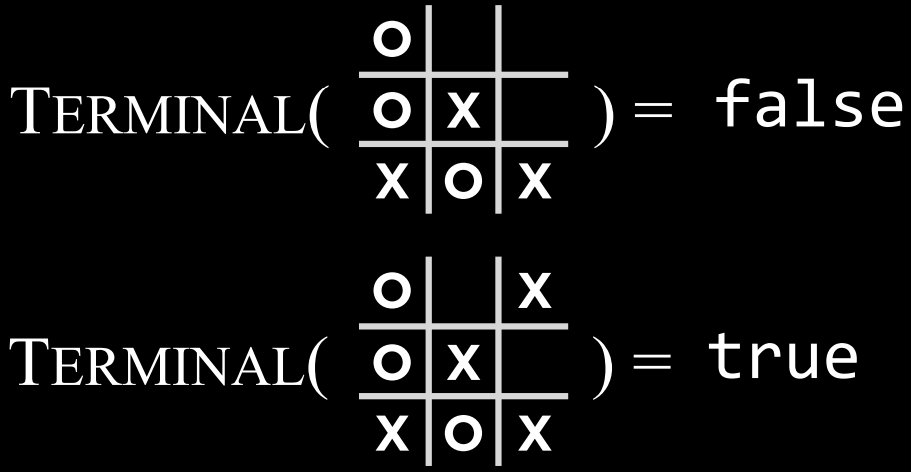

- `terminal` 函数应该接受一个棋盘作为输入,并返回一个布尔值,指示游戏是否结束。

|

||||

|

||||

- 如果游戏结束,要么是因为有人赢得了游戏,要么是由于所有单元格都已填充而没有人获胜,则函数应返回 `True`。

|

||||

- 否则,如果游戏仍在进行中,则函数应返回 `False`。

|

||||

- `utility` 函数应接受结束棋盘状态作为输入,并输出该棋盘的分数。

|

||||

|

||||

- 如果 X 赢得了比赛,则分数为 1。如果 O 赢得了比赛,则分数为 -1。如果比赛以平局结束,则分数为 0。

|

||||

- 你可以假设只有当 `terminal(board)` 为 True 时,才会在棋盘上调用 `utility`。

|

||||

- `minimax` 函数应该以一个棋盘作为输入,并返回玩家在该棋盘上移动的最佳移动。

|

||||

|

||||

- 返回的移动应该是最佳动作 `(i,j)`,这是棋盘上允许的动作之一。如果多次移动都是同样最佳的,那么这些移动中的任何一次都是可以接受的。

|

||||

- 如果该棋盘是结束棋盘状态,则 `minimax` 函数应返回 `None`。

|

||||

对于所有接受棋盘作为输入的函数,你可以假设它是一个有效的棋盘(即,它是包含三行的列表,每行都有三个值 X、O 或 EMPTY)。你不应该修改所提供的函数声明(每个函数的参数的顺序或数量)。、

|

||||

一旦所有功能都得到了正确的实现,你就应该能够运行 `python runner.py` 并与你的人工智能进行比赛。而且,由于井字棋是双方最佳比赛的平局,你永远不应该能够击败人工智能(尽管如果你打得不好,它可能会打败你!)

|

||||

|

||||

## 提示

|

||||

|

||||

- 如果你想在不同的 Python 文件中测试你的函数,你可以用类似于 `from tictactoe import initial_state` 的代码来导入它们。

|

||||

- 欢迎在 `tictactoe.py` 中添加其他辅助函数,前提是它们的名称不会与模块中已有的函数或变量名称冲突。

|

||||

- alpha-beta 剪枝是可选的,这可能会让你的人工智能运行更高效!

|

||||

356

2023旧版内容/4.人工智能/4.3.1搜索.md

Normal file

@@ -0,0 +1,356 @@

|

||||

# 搜索

|

||||

|

||||

::: warning 😅 在我们日常生活中,其实有非常多的地方使用了所谓的 AI 算法,只是我们通常没有察觉。

|

||||

|

||||

比如美团的外卖程序里面,可以看到外卖员到达你所在的位置的路线,它是如何规划出相关路线的呢?

|

||||

|

||||

在我们和电脑下围棋下五子棋的时候,他是如何“思考”的呢?希望你在阅读完本章内容之后,可以有一个最基本的理解。并且,我们还会给你留下一个井字棋的小任务,可以让你的电脑和你下井字棋,是不是很 cool

|

||||

|

||||

让我们现在开始吧!

|

||||

:::

|

||||

|

||||

## 基本定义

|

||||

|

||||

::: warning 🤔 也许第一次看会觉得云里雾里,没有必要全部记住所有的概念。可以先大致浏览一遍之后,再后续的代码中与概念进行结合,相信你会有更深入的理解

|

||||

:::

|

||||

|

||||

> 即检索存储在某个[数据结构](https://zh.wikipedia.org/wiki/%E6%95%B0%E6%8D%AE%E7%BB%93%E6%9E%84)中的信息,或者在问题域的搜索空间中计算的信息。 --wiki

|

||||

|

||||

从本质上来说,你将搜索问题理解为一个函数,那么它的输入将会是你用计算机的数据结构或计算机数据所构成的初始状态以及你期望他达成的目标状态,搜索问题将尝试从中得到解决方案。

|

||||

|

||||

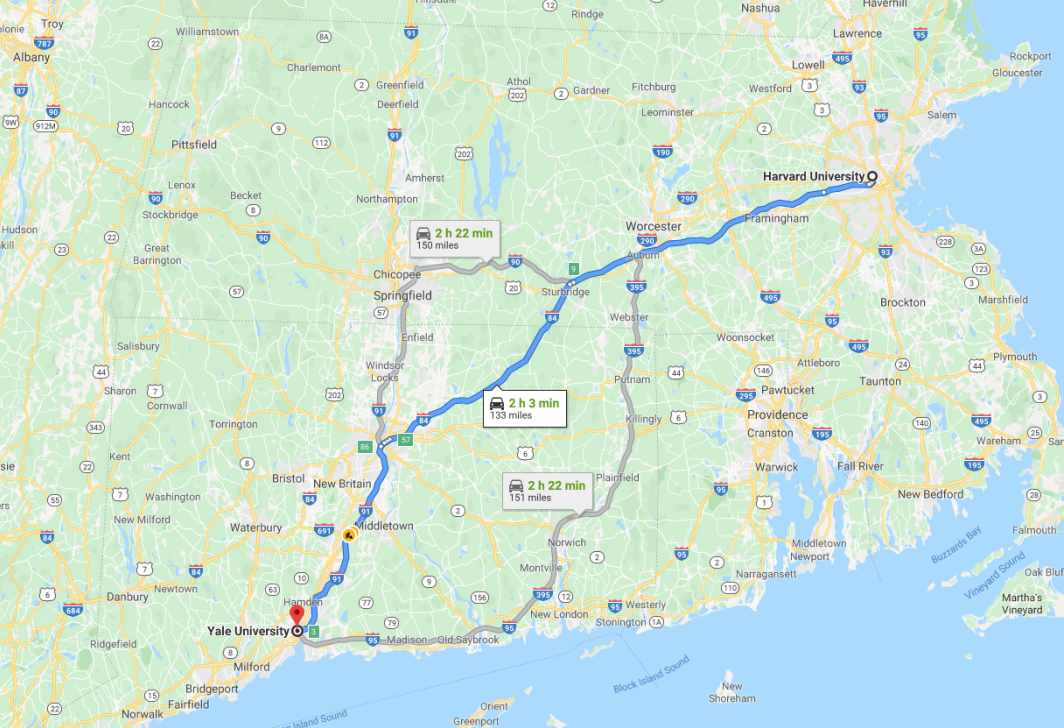

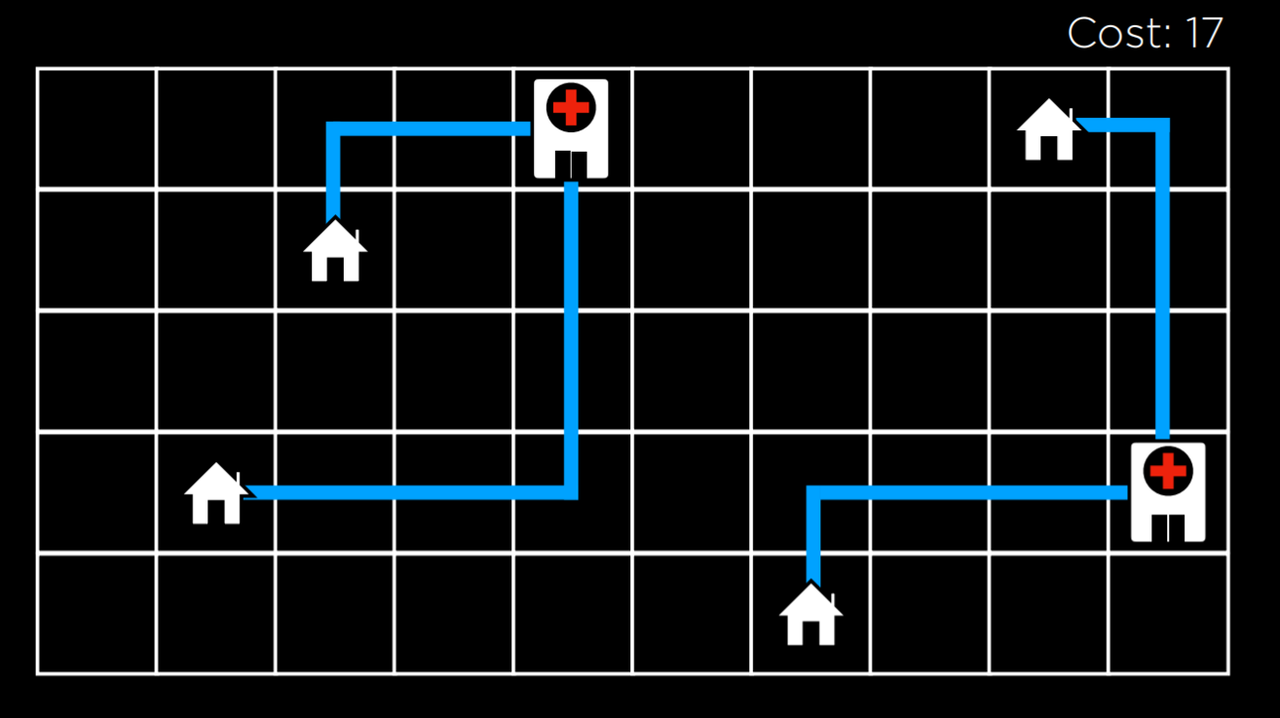

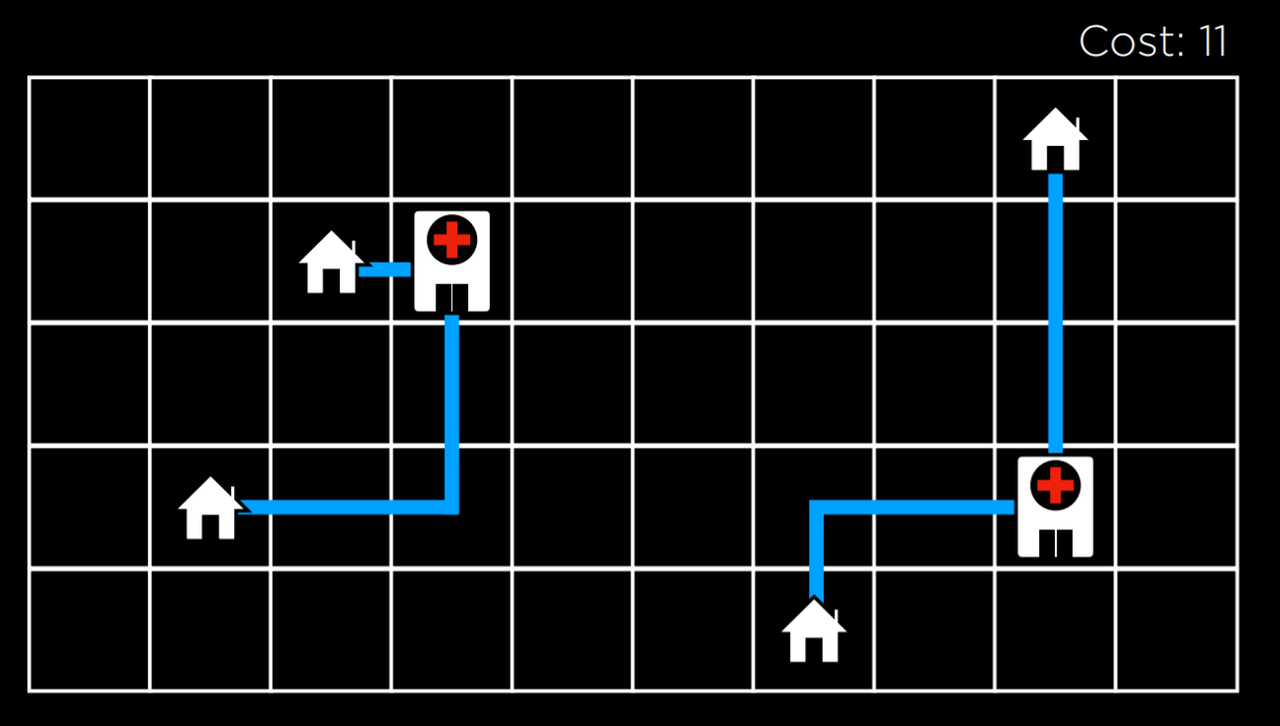

导航是使用搜索算法的一个典型的搜索,它接收您的当前位置和目的地作为输入,并根据搜索算法返回建议的路径。

|

||||

|

||||

|

||||

|

||||

在计算机科学中,还有许多其他形式的搜索问题,比如谜题或迷宫。

|

||||

|

||||

<table>

|

||||

<tr>

|

||||

<td><img src=https://cdn.xyxsw.site/SYw4bOzqAo65PQxZQLucbZAxnHd.png width=520></td>

|

||||

<td><img src=https://cdn.xyxsw.site/LPgEbVQg2oZBSexmGWwcwfbdnVd.png width=520></td>

|

||||

</tr>

|

||||

</table>

|

||||

|

||||

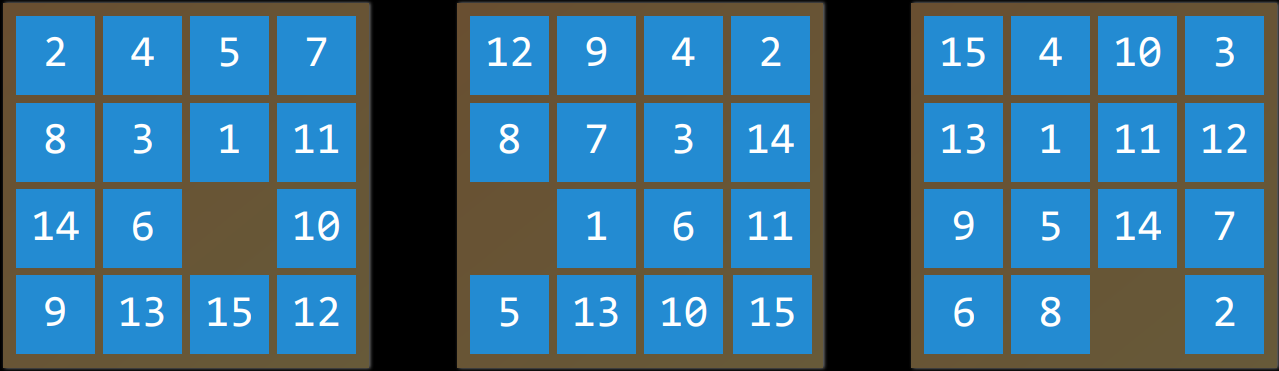

## 举个例子

|

||||

|

||||

要找到一个数字华容道谜题的解决方案,需要使用搜索算法。

|

||||

|

||||

- 智能主体 (Agent)

|

||||

|

||||

感知其环境并对该环境采取行动的实体。

|

||||

|

||||

例如,在导航应用程序中,智能主体将是一辆汽车的代表,它需要决定采取哪些行动才能到达目的地。

|

||||

|

||||

- 状态 (State)

|

||||

|

||||

智能主体在其环境中的配置。

|

||||

|

||||

例如,在一个数字华容道谜题中,一个状态是所有数字排列在棋盘上的任何一种方式。

|

||||

|

||||

- 初始状态(Initial State)

|

||||

|

||||

搜索算法开始的状态。在导航应用程序中,这将是当前位置。

|

||||

|

||||

|

||||

|

||||

- 动作 (Action)

|

||||

|

||||

一个状态可以做出的选择。更确切地说,动作可以定义为一个函数。当接收到状态$s$作为输入时,$Actions(s)$将返回可在状态$s$ 中执行的一组操作作为输出。

|

||||

|

||||

例如,在一个数字华容道中,给定状态的操作是您可以在当前配置中滑动方块的方式。

|

||||

|

||||

|

||||

|

||||

- 过渡模型 (Transition Model)

|

||||

|

||||

对在任何状态下执行任何适用操作所产生的状态的描述。

|

||||

|

||||

更确切地说,过渡模型可以定义为一个函数。

|

||||

|

||||

在接收到状态$s$和动作$a$作为输入时,$Results(s,a)$返回在状态$s$中执行动作$a$ 所产生的状态。

|

||||

|

||||

例如,给定数字华容道的特定配置(状态$s$),在任何方向上移动正方形(动作$a$)将导致谜题的新配置(新状态)。

|

||||

|

||||

|

||||

|

||||

- 状态空间 (State Space)

|

||||

|

||||

通过一系列的操作目标从初始状态可达到的所有状态的集合。

|

||||

|

||||

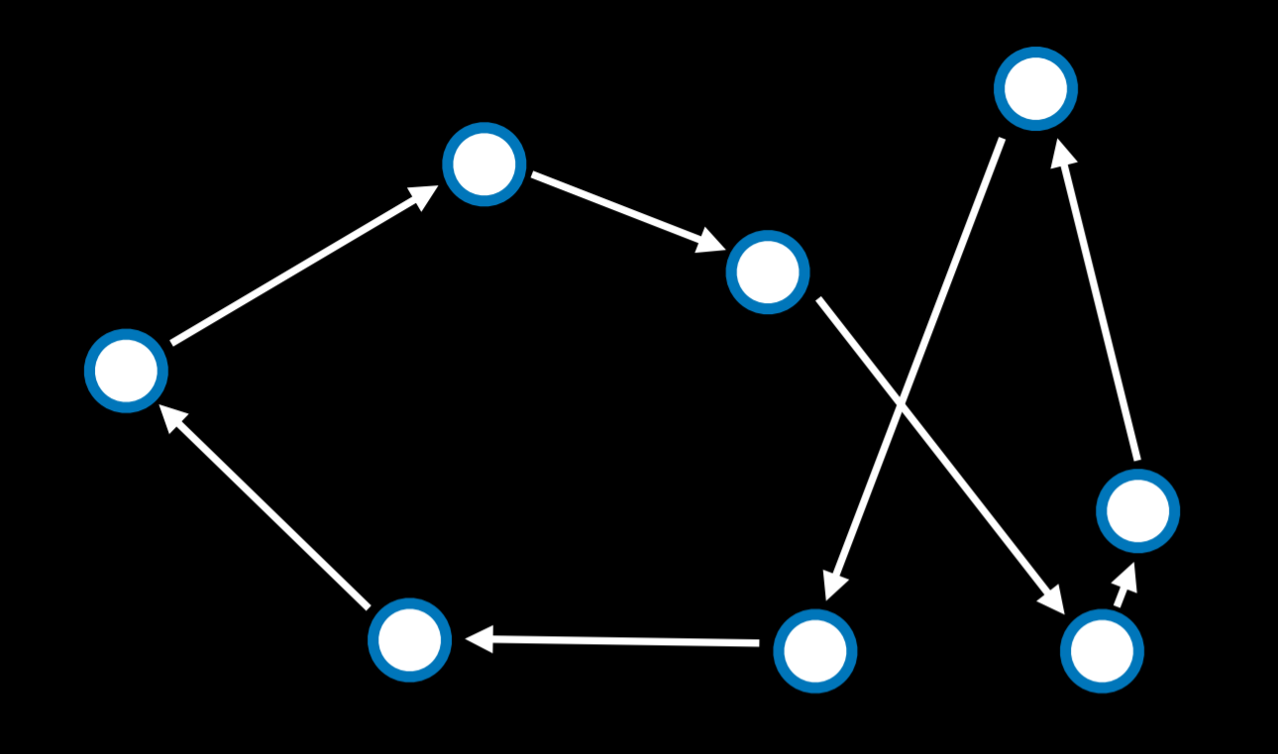

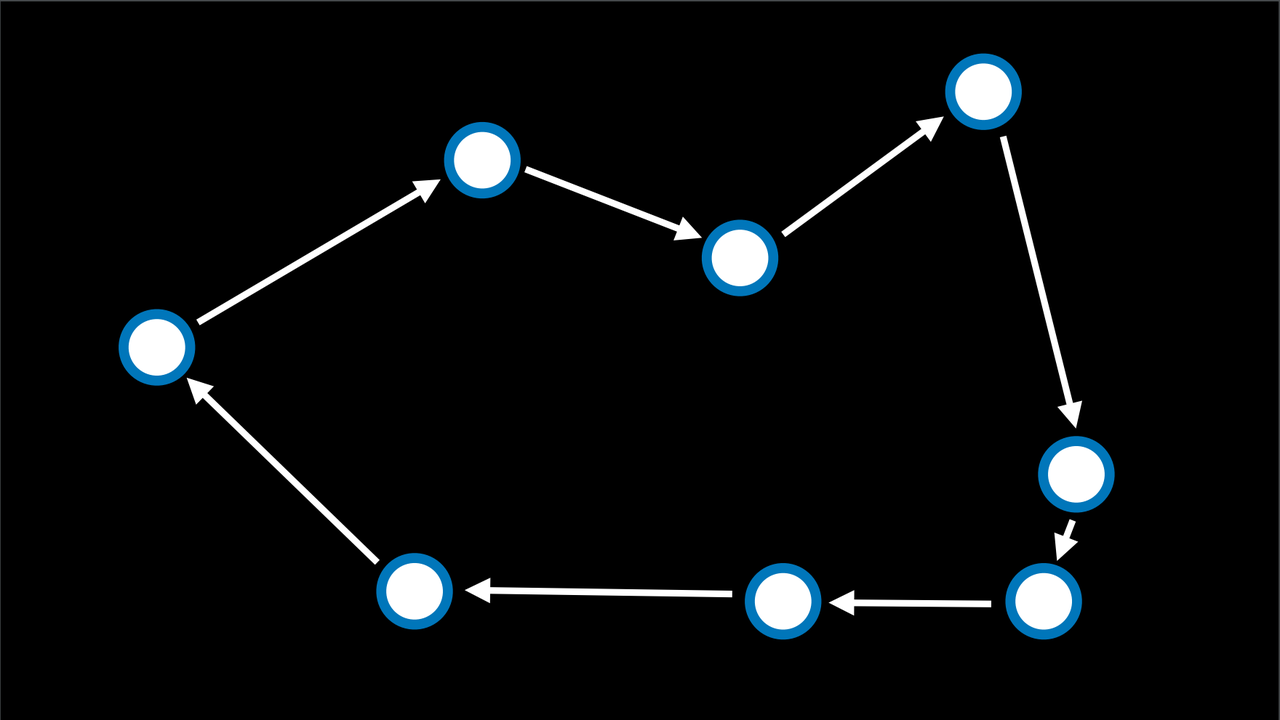

例如,在一个数字华容道谜题中,状态空间由所有$\frac{16!}{2}$种配置,可以从任何初始状态达到。状态空间可以可视化为有向图,其中状态表示为节点,动作表示为节点之间的箭头。

|

||||

|

||||

|

||||

|

||||

- 目标测试 (Goal Test)

|

||||

|

||||

确定给定状态是否为目标状态的条件。例如,在导航应用程序中,目标测试将是智能主体的当前位置是否在目的地。如果是,问题解决了。如果不是,我们将继续搜索。

|

||||

|

||||

- 路径成本 (Path Cost)

|

||||

|

||||

完成给定路径相关的代价。例如,导航应用程序并不是简单地让你达到目标;它这样做的同时最大限度地减少了路径成本,为您找到了达到目标状态的最快方法。

|

||||

|

||||

## 解决搜索问题

|

||||

|

||||

### 解 (solution)

|

||||

|

||||

从初始状态到目标状态的一系列动作。

|

||||

|

||||

### 最优解 (Optimal Solution)

|

||||

|

||||

- 在所有解决方案中路径成本最低的解决方案。

|

||||

|

||||

- 在搜索过程中,数据通常存储在**节点 (Node)** 中,节点是一种包含以下数据的数据结构:

|

||||

|

||||

- 状态——state

|

||||

- 其父节点,通过该父节点生成当前节点——parent node

|

||||

- 应用于父级状态以获取当前节点的操作——action

|

||||

- 从初始状态到该节点的路径成本——path cost

|

||||

- 节点包含的信息使它们对于搜索算法非常有用。

|

||||

|

||||

它们包含一个状态,可以使用目标测试来检查该状态是否为最终状态。

|

||||

|

||||

如果是,则可以将节点的路径成本与其他节点的路径代价进行比较,从而可以选择最佳解决方案。

|

||||

|

||||

一旦选择了节点,通过存储父节点和从父节点到当前节点的动作,就可以追溯从初始状态到该节点的每一步,而这一系列动作就是解决方案。

|

||||

|

||||

然而,节点只是一个数据结构——它们不搜索,而是保存信息。为了实际搜索,我们使用了边域 (frontier),即“管理”节点的机制。边域首先包含一个初始状态和一组空的已探索项目(探索集),然后重复以下操作,直到找到解决方案:

|

||||

|

||||

重复:

|

||||

|

||||

1. 如果边域为空

|

||||

- 停止,搜索问题无解

|

||||

2. 从边域中删除一个节点。这是将要考虑的节点。

|

||||

3. 如果节点包含目标状态。

|

||||

- 返回解决方案,停止

|

||||

否则:

|

||||

- 展开节点(找到可以从该节点到达的所有新节点),并将生成的节点添加到边域。

|

||||

- 将当前节点添加到探索集。

|

||||

|

||||

<table>

|

||||

<tr>

|

||||

<td><img src=https://cdn.xyxsw.site/K53FbGmswoM7JAxqJZxcQEjdnES.png width=520></td>

|

||||

<td><img src=https://cdn.xyxsw.site/THhpbemEHoxl80xHeTjc9d35nVh.png width=520></td>

|

||||

</tr>

|

||||

</table>

|

||||

|

||||

边域从节点 A 初始化开始

|

||||

|

||||

1. 取出边域中的节点 A,展开节点 A,将节点 B 添加到边域。

|

||||

2. 取出节点 B,展开,添加......

|

||||

3. 到达目标节点,停止,返回解决方案

|

||||

|

||||

<table>

|

||||

<tr>

|

||||

<td><img src=https://cdn.xyxsw.site/XmnObIGaUoF4ssxkgzUc4vTUnmf.png width=520></td>

|

||||

<td><img src=https://cdn.xyxsw.site/Wsntb9rLwogdAKxpJgLchrI8nae.png width=520></td>

|

||||

</tr>

|

||||

</table>

|

||||

|

||||

会出现什么问题?节点 A-> 节点 B-> 节点 A->......-> 节点 A。我们需要一个探索集,记录已搜索的节点!

|

||||

|

||||

### 不知情搜索 (Uninformed Search)

|

||||

|

||||

在之前对边域的描述中,有一件事没有被提及。在上面伪代码的第 1 阶段,应该删除哪个节点?这种选择对解决方案的质量和实现速度有影响。关于应该首先考虑哪些节点的问题,有多种方法,其中两种可以用堆栈(深度优先搜索)和队列(广度优先搜索)的数据结构来表示。

|

||||

|

||||

#### 深度优先搜索 (Depth-First Search)

|

||||

|

||||

深度优先搜索算法在尝试另一个方向之前耗尽每个方向。在这些情况下,边域作为堆栈数据结构进行管理。这里需要记住的流行语是“后进先出”。在将节点添加到边域后,第一个要删除和考虑的节点是最后一个要添加的节点。这导致了一种搜索算法,该算法在第一个方向上尽可能深入,直到尽头,同时将所有其他方向留到后面。“不撞南墙不回头”

|

||||

|

||||

(一个例子:以你正在寻找钥匙的情况为例。在深度优先搜索方法中,如果你选择从裤子里搜索开始,你会先仔细检查每一个口袋,清空每个口袋,仔细检查里面的东西。只有当你完全筋疲力尽时,你才会停止在裤子里搜索,开始在其他地方搜索。)

|

||||

|

||||

- 优点

|

||||

- 在最好的情况下,这个算法是最快的。如果它“运气好”,并且总是(偶然)选择正确的解决方案路径,那么深度优先搜索需要尽可能少的时间来找到解决方案。

|

||||

- 缺点

|

||||

- 所找到的解决方案可能不是最优的。

|

||||

- 在最坏的情况下,该算法将在找到解决方案之前探索每一条可能的路径,从而在到达解决方案之前花费尽可能长的时间。

|

||||

|

||||

<table>

|

||||

<tr>

|

||||

<td><img src=https://cdn.xyxsw.site/SGVWbCcTlobQwJxSjKvcNyJAnEG.png width=520></td>

|

||||

<td><img src=https://cdn.xyxsw.site/Vv9Sb26QfoMrkqx5apycIYPJnlf.png width=520></td>

|

||||

</tr>

|

||||

</table>

|

||||

|

||||

<table>

|

||||

<tr>

|

||||

<td><img src=https://cdn.xyxsw.site/Gjd5bpdpcoIxGtxcUJ0c2OVfnOf.png width=520></td>

|

||||

<td><img src=https://cdn.xyxsw.site/M2vZbA5hpoT9RExuAGwcBHF1nmh.png width=520></td>

|

||||

</tr>

|

||||

</table>

|

||||

|

||||

- 代码实现

|

||||

|

||||

```python

|

||||

def remove(self):

|

||||

if self.empty():

|

||||

raise Exception("empty frontier")

|

||||

else:

|

||||

node = self.frontier[-1]

|

||||

self.frontier = self.frontier[:-1]

|

||||

return node

|

||||

```

|

||||

|

||||

#### 广度优先搜索 (Breadth-First Search)

|

||||

|

||||

广度优先搜索算法将同时遵循多个方向,在每个可能的方向上迈出一步,然后在每个方向上迈出第二步。在这种情况下,边域作为队列数据结构进行管理。这里需要记住的流行语是“先进先出”。在这种情况下,所有新节点都会排成一行,并根据先添加的节点来考虑节点(先到先得!)。这导致搜索算法在任何一个方向上迈出第二步之前,在每个可能的方向上迈出一步。

|

||||

|

||||

(一个例子:假设你正在寻找钥匙。在这种情况下,如果你从裤子开始,你会看你的右口袋。之后,你会在一个抽屉里看一眼,而不是看你的左口袋。然后在桌子上。以此类推,在你能想到的每个地方。只有在你用完所有位置后,你才会回到你的裤子上,在下一个口袋里找。)

|

||||

|

||||

- 优点

|

||||

- 该算法可以保证找到最优解。

|

||||

- 缺点

|

||||

- 几乎可以保证该算法的运行时间会比最短时间更长。

|

||||

- 在最坏的情况下,这种算法需要尽可能长的时间才能运行。

|

||||

|

||||

<table>

|

||||

<tr>

|

||||

<td><img src=https://cdn.xyxsw.site/S6SRbMUrcoYQCYxZGgJczkdcnBP.png width=520></td>

|

||||

<td><img src=https://cdn.xyxsw.site/Xg7Qbv59IoQB3bxPFO1ceXgRnkf.png width=520></td>

|

||||

</tr>

|

||||

</table>

|

||||

|

||||

<table>

|

||||

<tr>

|

||||

<td><img src=https://cdn.xyxsw.site/X34Rb5R7AonUg3xYs7DcQzSfndg.png width=520></td>

|

||||

<td><img src=https://cdn.xyxsw.site/PQeZbJv3Bom6NYxa6lccT084nFn.png width=520></td>

|

||||

</tr>

|

||||

</table>

|

||||

|

||||

代码实现

|

||||

|

||||

```python

|

||||

def remove(self):

|

||||

if self.empty():

|

||||

raise Exception("empty frontier")

|

||||

else:

|

||||

node = self.frontier[0]

|

||||

self.frontier = self.frontier[1:]

|

||||

return node

|

||||

```

|

||||

|

||||

## 知情搜索 (Informed Search)

|

||||

|

||||

广度优先和深度优先都是不知情的搜索算法。也就是说,这些算法没有利用他们没有通过自己的探索获得的关于问题的任何知识。然而,大多数情况下,关于这个问题的一些知识实际上是可用的。例如,当人类进入一个路口时,人类可以看到哪条路沿着解决方案的大致方向前进,哪条路没有。人工智能也可以这样做。一种考虑额外知识以试图提高性能的算法被称为知情搜索算法。

|

||||

|

||||

### 贪婪最佳优先搜索 (Greedy Best-First Search)

|

||||

|

||||

贪婪最佳优先搜索扩展最接近目标的节点,如启发式函数$h(n)$所确定的。顾名思义,该函数估计下一个节点离目标有多近,但可能会出错。贪婪最佳优先算法的效率取决于启发式函数的好坏。例如,在迷宫中,算法可以使用启发式函数,该函数依赖于可能节点和迷宫末端之间的曼哈顿距离。曼哈顿距离忽略了墙壁,并计算了从一个位置到目标位置需要向上、向下或向两侧走多少步。这是一个简单的估计,可以基于当前位置和目标位置的$(x,y)$坐标导出。

|

||||

|

||||

|

||||

|

||||

然而,重要的是要强调,与任何启发式算法一样,它可能会出错,并导致算法走上比其他情况下更慢的道路。不知情的搜索算法有可能更快地提供一个更好的解决方案,但它比知情算法更不可能这样。

|

||||

|

||||

<table>

|

||||

<tr>

|

||||

<td><img src=https://cdn.xyxsw.site/SU2DbQeN2oxs5ex3K3NcMaJfnch.png width=520></td>

|

||||

<td><img src=https://cdn.xyxsw.site/HkvdbcEdmo6RtjxOqqic31XFnSh.png width=520></td>

|

||||

</tr>

|

||||

</table>

|

||||

|

||||

### $A^*$搜索

|

||||

|

||||

作为贪婪最佳优先算法的一种发展,$A^{*}$ 搜索不仅考虑了从当前位置到目标的估计成本 $h(n)$ ,还考虑了直到当前位置为止累积的成本 $g(n)$ 。通过组合这两个值,该算法可以更准确地确定解决方案的成本并在旅途中优化其选择。该算法跟踪(到目前为止的路径成本 + 到目标的估计成本, $g(n)+h(n)$ ),一旦它超过了之前某个选项的估计成本,该算法将放弃当前路径并返回到之前的选项,从而防止自己沿着 $h(n)$ 错误地标记为最佳的却长而低效的路径前进。

|

||||

|

||||

然而,由于这种算法也依赖于启发式,所以它依赖它所使用的启发式。在某些情况下,它可能比贪婪的最佳第一搜索甚至不知情的算法效率更低。对于最佳的$A^*$搜索,启发式函数$h(n)$应该:

|

||||

|

||||

- 可接受,从未高估真实成本。

|

||||

- 一致性,这意味着从新节点到目标的估计路径成本加上从先前节点转换到该新节点的成本应该大于或等于先前节点到目标的估计路径成本。用方程的形式表示,$h(n)$是一致的,如果对于每个节点 n$和后续节点 n'$,从 n$到$n'$的步长为 c$,满足$h(n) ≤ h(n') + c$.

|

||||

|

||||

<table>

|

||||

<tr>

|

||||

<td><img src=https://cdn.xyxsw.site/BbIiba1pwo3uI7x4k7QcwicznGc.png width=520></td>

|

||||

<td><img src=https://cdn.xyxsw.site/HhG9bcJP2okKMMxY0FGclP0AnXY.png width=520></td>

|

||||

</tr>

|

||||

</table>

|

||||

|

||||

## 对抗性搜索

|

||||

|

||||

尽管之前我们讨论过需要找到问题答案的算法,但在对抗性搜索中,算法面对的是试图实现相反目标的对手。通常,在游戏中会遇到使用对抗性搜索的人工智能,比如井字游戏。

|

||||

|

||||

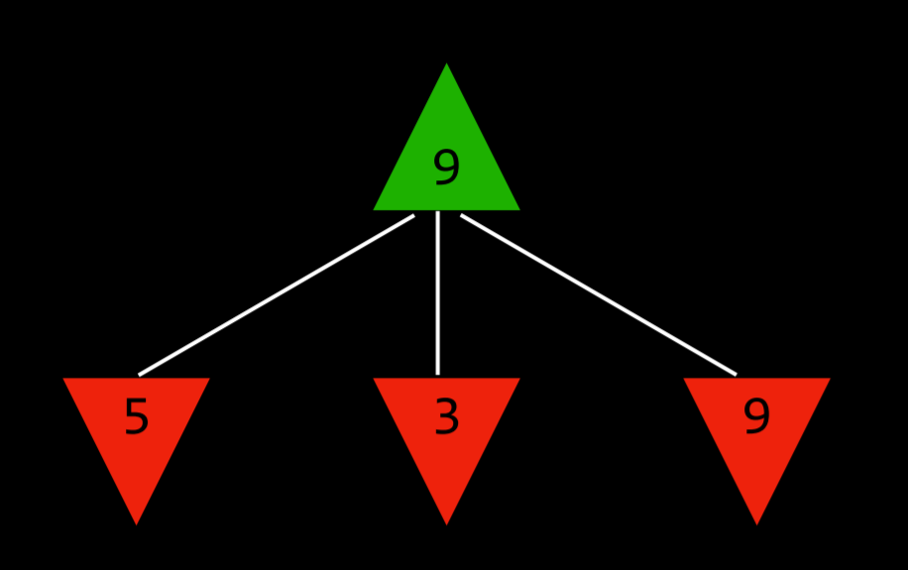

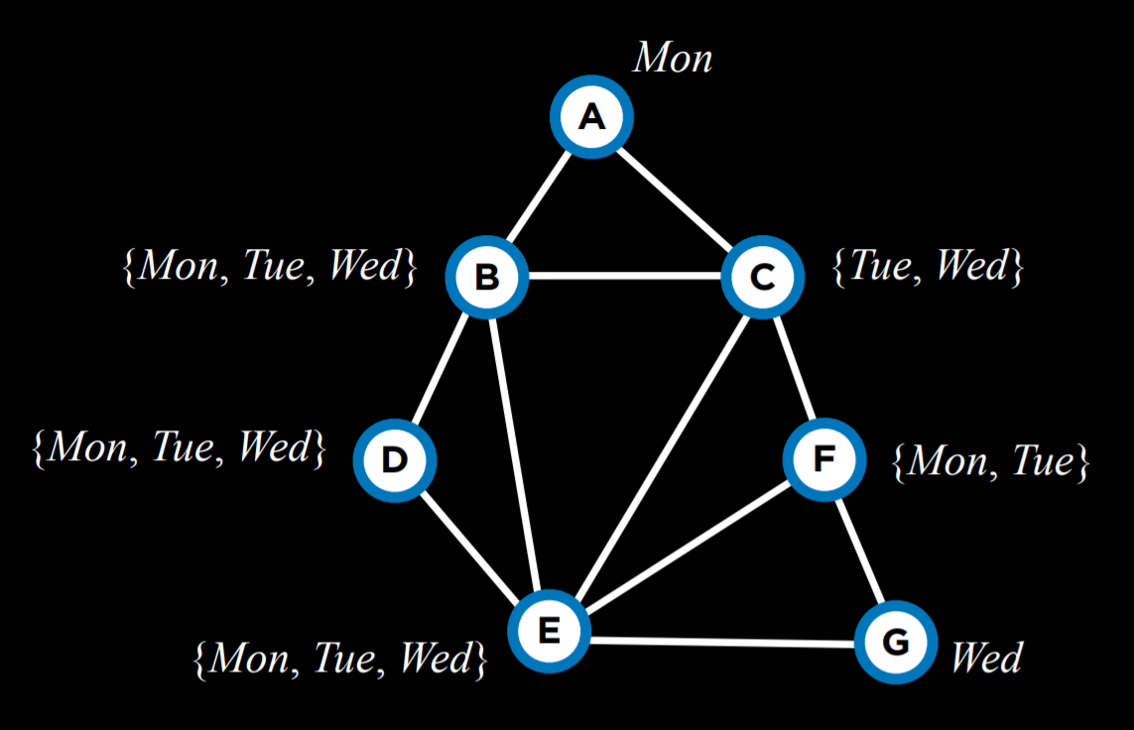

### 极大极小算法 (Minimax)

|

||||

|

||||

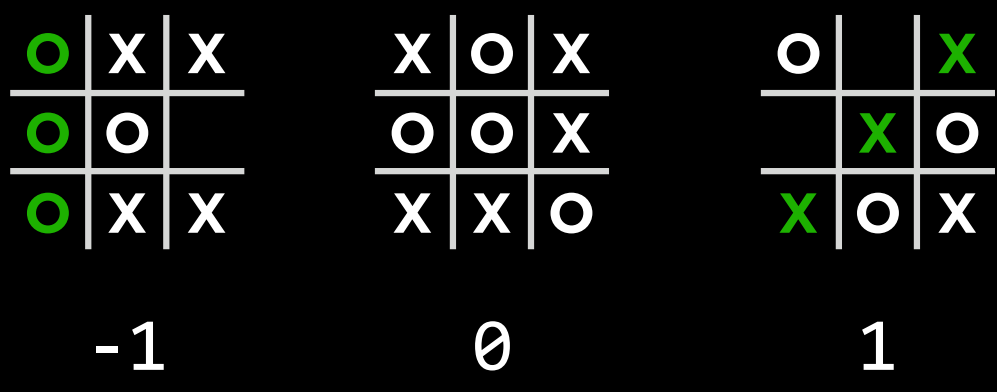

- 作为对抗性搜索中的一种算法,Minimax 将获胜条件表示为$(-1)$表示为一方,$(+1)$表示为另一方。进一步的行动将受到这些条件的驱动,最小化的一方试图获得最低分数,而最大化的一方则试图获得最高分数。

|

||||

|

||||

|

||||

|

||||

#### 井字棋 AI 为例

|

||||

|

||||

- $s_0$: 初始状态(在我们的情况下,是一个空的 3X3 棋盘)

|

||||

|

||||

|

||||

|

||||

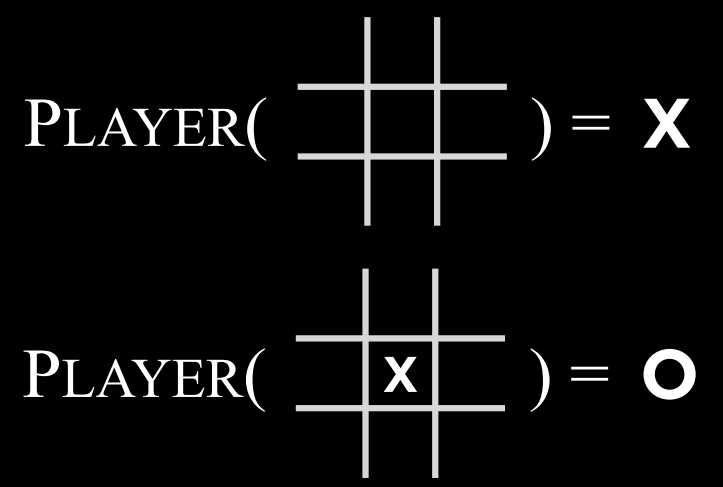

- $Players(s)$: 一个函数,在给定状态$s$的情况下,返回轮到哪个玩家(X 或 O)。

|

||||

|

||||

|

||||

|

||||

- $Actions(s)$: 一个函数,在给定状态$s$的情况下,返回该状态下的所有合法动作(棋盘上哪些位置是空的)。

|

||||

|

||||

|

||||

|

||||

- $Result(s, a)$: 一个函数,在给定状态$s$和操作$a$的情况下,返回一个新状态。这是在状态$s$上执行动作$a$(在游戏中移动)所产生的棋盘。

|

||||

|

||||

|

||||

|

||||

- $Terminal(s)$: 一个函数,在给定状态$s$的情况下,检查这是否是游戏的最后一步,即是否有人赢了或打成平手。如果游戏已结束,则返回 True,否则返回 False。

|

||||

|

||||

|

||||

|

||||

- $Utility(s)$: 一个函数,在给定终端状态 s 的情况下,返回状态的效用值:$-1、0 或 1$。

|

||||

|

||||

|

||||

|

||||

算法的工作原理:

|

||||

|

||||

- 该算法递归地模拟从当前状态开始直到达到终端状态为止可能发生的所有游戏状态。每个终端状态的值为$(-1)$、$0$或$(+1)$。

|

||||

|

||||

|

||||

- 根据轮到谁的状态,算法可以知道当前玩家在最佳游戏时是否会选择导致状态值更低或更高的动作。

|

||||

|

||||

通过这种方式,在最小化和最大化之间交替,算法为每个可能的动作产生的状态创建值。举一个更具体的例子,我们可以想象,最大化的玩家在每一个回合都会问:“如果我采取这个行动,就会产生一个新的状态。如果最小化的玩家发挥得最好,那么该玩家可以采取什么行动来达到最低值?”

|

||||

|

||||

然而,为了回答这个问题,最大化玩家必须问:“要想知道最小化玩家会做什么,我需要在最小化者的脑海中模拟同样的过程:最小化玩家会试图问:‘如果我采取这个动作,最大化玩家可以采取什么动作来达到最高值?’”

|

||||

|

||||

这是一个递归过程,你可能很难理解它;看看下面的伪代码会有所帮助。最终,通过这个递归推理过程,最大化玩家为每个状态生成值,这些值可能是当前状态下所有可能的操作所产生的。

|

||||

|

||||

在得到这些值之后,最大化的玩家会选择最高的一个。

|

||||

|

||||

|

||||

|

||||

具体算法:

|

||||

|

||||

- 给定状态 $s$

|

||||

- 最大化玩家在$Actions(s)$中选择动作$a$,该动作产生$Min-value(Result(s,a))$ 的最高值。

|

||||

- 最小化玩家在$Actions(s)$中选择动作$a$,该动作产生$Max-value(Result(s,a))$ 的最小值。

|

||||

|

||||

```txt

|

||||

Function Max-Value(state):

|

||||

v=-∞

|

||||

if Terminal(state):

|

||||

return Utility(state)

|

||||

for action in Actions(state):

|

||||

v = Max(v, Min-Value(Result(state, action)))

|

||||

return v

|

||||

Function Min-Value(state):

|

||||

v=+∞

|

||||

if Terminal(state):

|

||||

return Utility(state)

|

||||

for action in Actions(state):

|

||||

v = Min(v, Max-Value(Result(state, action)))

|

||||

return v

|

||||

```

|

||||

|

||||

不会理解递归?也许你需要看看这个:[阶段二:递归操作](../3.%E7%BC%96%E7%A8%8B%E6%80%9D%E7%BB%B4%E4%BD%93%E7%B3%BB%E6%9E%84%E5%BB%BA/3.6.4.2%E9%98%B6%E6%AE%B5%E4%BA%8C%EF%BC%9A%E9%80%92%E5%BD%92%E6%93%8D%E4%BD%9C.md)

|

||||

|

||||

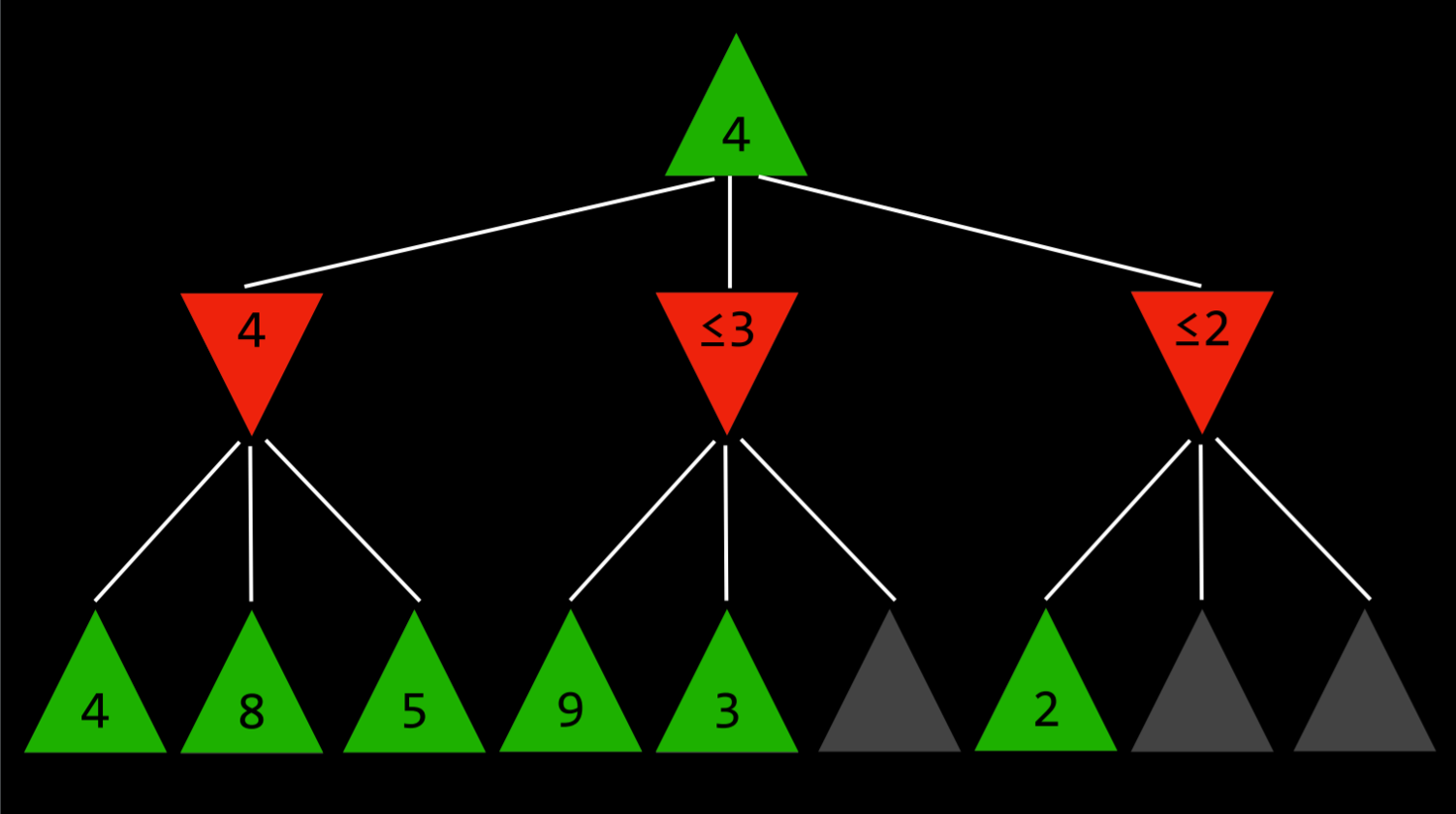

### $\alpha$-$\beta$剪枝 (Alpha-Beta Pruning)

|

||||

|

||||

作为一种优化 Minimax 的方法,Alpha-Beta 剪枝跳过了一些明显不利的递归计算。在确定了一个动作的价值后,如果有初步证据表明接下来的动作可以让对手获得比已经确定的动作更好的分数,那么就没有必要进一步调查这个动作,因为它肯定比之前确定的动作不利。

|

||||

|

||||

这一点最容易用一个例子来说明:最大化的玩家知道,在下一步,最小化的玩家将试图获得最低分数。假设最大化玩家有三个可能的动作,第一个动作的值为 4。然后玩家开始为下一个动作生成值。要做到这一点,如果当前玩家做出这个动作,玩家会生成最小化者动作的值,并且知道最小化者会选择最低的一个。然而,在完成最小化器所有可能动作的计算之前,玩家会看到其中一个选项的值为 3。这意味着没有理由继续探索最小化玩家的其他可能行动。尚未赋值的动作的值无关紧要,无论是 10 还是(-10)。如果该值为 10,则最小化器将选择最低选项 3,该选项已经比预先设定的 4 差。如果尚未估价的行动结果是(-10),那么最小化者将选择(-10)这一选项,这对最大化者来说更加不利。因此,在这一点上为最小化者计算额外的可能动作与最大化者无关,因为最大化玩家已经有了一个明确的更好的选择,其值为 4。

|

||||

|

||||

|

||||

|

||||

### 深度限制的极大极小算法 (Depth-Limited Minimax)

|

||||

|

||||

- 总共有$255168$个可能的井字棋游戏,以及有$10^{29000}$个可能的国际象棋中游戏。到目前为止,最小最大算法需要生成从某个点到**终端条件**的所有假设游戏状态。虽然计算所有的井字棋游戏状态对现代计算机来说并不是一个挑战,但目前用来计算国际象棋是不可能的。

|

||||

|

||||