update

many chore

This commit is contained in:

@@ -128,7 +128,9 @@ bool parseAndExecute(char *input)

|

|||||||

|

|

||||||

返回<em>false</em>将导致主循环结束。

|

返回<em>false</em>将导致主循环结束。

|

||||||

|

|

||||||

RTFM&&STFW 搞懂 strtok 和 strcmp 的用法

|

::: warning <font size=5><strong>RTFM&&STFW</strong></font>

|

||||||

|

搞懂 strtok 和 strcmp 的用法

|

||||||

|

:::

|

||||||

|

|

||||||

考虑一下 NULL 是干什么的

|

考虑一下 NULL 是干什么的

|

||||||

|

|

||||||

|

|||||||

@@ -23,7 +23,7 @@ Linux 命令行中的命令使用格式都是相同的:

|

|||||||

|

|

||||||

- (重要)首先教一个命令 `sudo su` 进入 root 账户(敲完之后会让你敲当前登录账户的密码 密码敲得过程中没有*****这种传统敲密码的提示 为 linux 传统艺能 其实是敲进去了),因为本身普通账户没什么权限,会出现处处的权限提示,建议直接使用 root 账户。

|

- (重要)首先教一个命令 `sudo su` 进入 root 账户(敲完之后会让你敲当前登录账户的密码 密码敲得过程中没有*****这种传统敲密码的提示 为 linux 传统艺能 其实是敲进去了),因为本身普通账户没什么权限,会出现处处的权限提示,建议直接使用 root 账户。

|

||||||

|

|

||||||

```text

|

```txt

|

||||||

这里有一个彩蛋(如果你用的是 centos 的话)

|

这里有一个彩蛋(如果你用的是 centos 的话)

|

||||||

当用户第一次使用 sudo 权限时 CentOS 的系统提示:

|

当用户第一次使用 sudo 权限时 CentOS 的系统提示:

|

||||||

我们信任您已经从系统管理员那里了解了日常注意事项。

|

我们信任您已经从系统管理员那里了解了日常注意事项。

|

||||||

|

|||||||

@@ -1,15 +1,14 @@

|

|||||||

# 对AI大致方向的概述

|

# 对 AI 大致方向的概述

|

||||||

|

|

||||||

|

## 前言

|

||||||

|

|

||||||

# 前言

|

在这个时代,相关内容是非常泛滥的,我们在本章内容中,大致的写一些目前比较有名的方向以及它的简介(也许会比 wiki 和百度有趣一点?)

|

||||||

|

|

||||||

在这个时代,相关内容是非常泛滥的,我们在本章内容中,大致的写一些目前比较有名的方向以及它的简介(也许会比wiki和百度有趣一点?)

|

## 深度学习 的大致方向分类

|

||||||

|

|

||||||

# 深度学习 的大致方向分类

|

|

||||||

|

|

||||||

本模块会粗略地介绍目前审读学习的研究与应用领域,在这里提前说明:笔者也只是一名普通的杭电学生,视野与认知有限,某些领域我们了解较多就会介绍地更加详细,某些领域了解较少或笔者中无人从事相关研究,就难免会简略介绍甚至有所偏颇,欢迎大家的指正。

|

本模块会粗略地介绍目前审读学习的研究与应用领域,在这里提前说明:笔者也只是一名普通的杭电学生,视野与认知有限,某些领域我们了解较多就会介绍地更加详细,某些领域了解较少或笔者中无人从事相关研究,就难免会简略介绍甚至有所偏颇,欢迎大家的指正。

|

||||||

|

|

||||||

## CV(计算机视觉)

|

### CV(计算机视觉)

|

||||||

|

|

||||||

计算机视觉旨在<strong>用计算机模拟人类处理图片信息的能力</strong>,就比如这里有一张图片——手写数字 9

|

计算机视觉旨在<strong>用计算机模拟人类处理图片信息的能力</strong>,就比如这里有一张图片——手写数字 9

|

||||||

|

|

||||||

@@ -19,31 +18,39 @@

|

|||||||

|

|

||||||

相信你通过上面简单的介绍应该能够了解到计算机视觉是在干嘛了,接下来我会举几个相对复杂的例子来让大家了解一下目前的 cv 是在做怎样的研究:

|

相信你通过上面简单的介绍应该能够了解到计算机视觉是在干嘛了,接下来我会举几个相对复杂的例子来让大家了解一下目前的 cv 是在做怎样的研究:

|

||||||

|

|

||||||

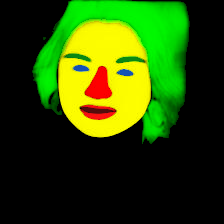

<strong>图像分割</strong>是在图片中对物体分类,并且把它们所对应的位置标示出来。下图就是把人的五官,面部皮肤和头发分割出来,效(小)果(丑)图如下:

|

::: warning 🐱 <strong>图像分割</strong>是在图片中对物体分类,并且把它们所对应的位置标示出来。下图就是把人的五官,面部皮肤和头发分割出来,效 (小) 果 (丑) 图如下:

|

||||||

|

:::

|

||||||

|

|

||||||

|

<table>

|

||||||

|

<tr>

|

||||||

|

<td><img src=https://cdn.xyxsw.site/boxcnxn5GlJZmsrMV5qKNwMlDPc.jpg width=175></td>

|

||||||

|

<td><img src=https://cdn.xyxsw.site/boxcnokdWGegr2XCi1vfg0ZZiWg.png width=200></td>

|

||||||

|

<td><img src=https://cdn.xyxsw.site/boxcn2o9ilOZg6jI6ssTYWhoeme.png width=200></td>

|

||||||

|

</tr>

|

||||||

|

</table>

|

||||||

|

|

||||||

|

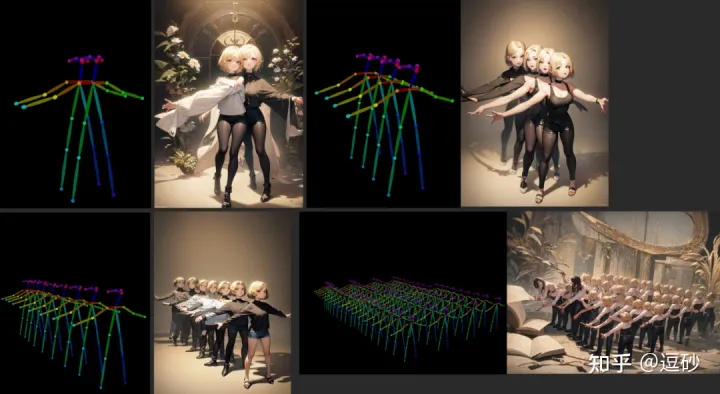

::: warning 🐱 <strong>图像生成</strong>相信大家一定不陌生,NovalAI 在 2022 年火的一塌糊涂,我觉得不需要我过多赘述,对它 (Diffusion model) 的改进工作也是层出不穷,这里就放一张由可控姿势网络 (ControlNet) 生成的图片吧:

|

||||||

|

:::

|

||||||

|

|

||||||

|

|

||||||

<strong>图像生成</strong>相信大家一定不陌生,NovalAI 在 2022 年火的一塌糊涂,我觉得不需要我过多赘述,对它(Diffusion model)的改进工作也是层出不穷,这里就放一张由可控姿势网络(ControlNet)生成的图片吧:

|

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

<strong>三维重建</strong>也是很多研究者关注的方向,指的是传入对同一物体不同视角的照片,来生成 3D 建模的任务。这方面比图像处理更加前沿并且难度更大。具体见[4.6.5.4神经辐射场(NeRF)](4.6.5.4%E7%A5%9E%E7%BB%8F%E8%BE%90%E5%B0%84%E5%9C%BA(NeRF).md) 章节。

|

::: warning 🐱 <strong>三维重建</strong>也是很多研究者关注的方向,指的是传入对同一物体不同视角的照片,来生成 3D 建模的任务。这方面比图像处理更加前沿并且难度更大。具体见[4.6.5.4 神经辐射场 (NeRF)](4.6.5.4%E7%A5%9E%E7%BB%8F%E8%BE%90%E5%B0%84%E5%9C%BA(NeRF).md) 章节。

|

||||||

|

:::

|

||||||

|

|

||||||

如果对计算机视觉有兴趣,可以通过以下路线进行学习:深度学习快速入门—> 经典网络。本块内容的主要撰写者之一<strong>SRT 社团</strong>多数成员主要从事 CV 方向研究,欢迎与我们交流。

|

如果对计算机视觉有兴趣,可以通过以下路线进行学习:深度学习快速入门—> 经典网络。本块内容的主要撰写者之一<strong>SRT 社团</strong>多数成员主要从事 CV 方向研究,欢迎与我们交流。

|

||||||

|

|

||||||

## NLP(自然语言处理)

|

### NLP(自然语言处理)

|

||||||

|

|

||||||

这就更好理解了,让计算机能够像人类一样,理解文本中的“真正含义”。在计算机眼中,文本就是单纯的字符串,NLP 的工作就是把字符转换为计算机可理解的数据。举个例子,ChatGPT(或者 New Bing)都是 NLP 的成果。在过去,NLP 领域被细分为了多个小任务,比如文本情感分析、关键段落提取等。而 ChatGPT 的出现可以说是集几乎所有小任务于大成,接下来 NLP 方向的工作会向 ChatGPT 的方向靠近。

|

这就更好理解了,让计算机能够像人类一样,理解文本中的“真正含义”。在计算机眼中,文本就是单纯的字符串,NLP 的工作就是把字符转换为计算机可理解的数据。举个例子,ChatGPT(或者 New Bing) 都是 NLP 的成果。在过去,NLP 领域被细分为了多个小任务,比如文本情感分析、关键段落提取等。而 ChatGPT 的出现可以说是集几乎所有小任务于大成,接下来 NLP 方向的工作会向 ChatGPT 的方向靠近。

|

||||||

|

|

||||||

|

<table>

|

||||||

|

<tr>

|

||||||

|

<td><img src=https://cdn.xyxsw.site/boxcnyh6pakAkcxCKq6pLylSdef.png width=580></td>

|

||||||

|

<td><img src=https://cdn.xyxsw.site/boxcnwWnoEDulgWdqGkY0WeYogc.png width=200></td>

|

||||||

|

</tr>

|

||||||

|

</table>

|

||||||

|

|

||||||

|

### 多模态 (跨越模态的处理)

|

||||||

|

|

||||||

## 多模态(跨越模态的处理)

|

|

||||||

|

|

||||||

模态,可以简单理解为数据形式,比如图片是一种模态,文本是一种模态,声音是一种模态,等等……

|

模态,可以简单理解为数据形式,比如图片是一种模态,文本是一种模态,声音是一种模态,等等……

|

||||||

|

|

||||||

@@ -55,11 +62,11 @@

|

|||||||

|

|

||||||

|

|

||||||

|

|

||||||

## 对比学习

|

### 对比学习

|

||||||

|

|

||||||

因为传统 AI 训练一般都需要数据集标注,比如说图片分割数据集需要人工在数万张图片上抠出具体位置,才能进行训练,这样的人力成本是巨大的,而且难以得到更多数据。因此,对比学习应运而生,这是一种不需要进行标注或者只需要少量标注的训练方式,具体可见[4.6.8对比学习](4.6.8%E5%AF%B9%E6%AF%94%E5%AD%A6%E4%B9%A0.md) 。

|

因为传统 AI 训练一般都需要数据集标注,比如说图片分割数据集需要人工在数万张图片上抠出具体位置,才能进行训练,这样的人力成本是巨大的,而且难以得到更多数据。因此,对比学习应运而生,这是一种不需要进行标注或者只需要少量标注的训练方式,具体可见[4.6.8 对比学习](4.6.8%E5%AF%B9%E6%AF%94%E5%AD%A6%E4%B9%A0.md) 。

|

||||||

|

|

||||||

## 强化学习

|

### 强化学习

|

||||||

|

|

||||||

强调模型如何依据环境(比如扫地机器人在学习家里的陈设,这时陈设就是环境)的变化而改进,以取得最大的收益(比如游戏得到最高分)。

|

强调模型如何依据环境(比如扫地机器人在学习家里的陈设,这时陈设就是环境)的变化而改进,以取得最大的收益(比如游戏得到最高分)。

|

||||||

|

|

||||||

@@ -67,27 +74,26 @@

|

|||||||

|

|

||||||

强化学习主要理论来源于心理学中的动物学习和最优控制的控制理论。说的通俗点,强化学习就是操控智能体与环境交互、去不断试错,在这个过程中进行学习。因此,强化学习被普遍地应用于游戏、资源优化分配、机器人等领域。强化学习本身已经是个老东西了,但是和深度学习结合之后焕发出了第二春——深度强化学习(DRL)。

|

强化学习主要理论来源于心理学中的动物学习和最优控制的控制理论。说的通俗点,强化学习就是操控智能体与环境交互、去不断试错,在这个过程中进行学习。因此,强化学习被普遍地应用于游戏、资源优化分配、机器人等领域。强化学习本身已经是个老东西了,但是和深度学习结合之后焕发出了第二春——深度强化学习(DRL)。

|

||||||

|

|

||||||

深度强化学习最初来源是2013年谷歌DeepMind团队发表的《Playing Atari with Deep Reinforcement Learning》一文,正式提出Deep Q-network(DQN)算法。在这篇论文中,DeepMind团队训练智能体Agent玩雅达利游戏,并取得了惊人的成绩。事实上,深度强化学习最为人熟知的成就是AlphaGO Zero,它没有使用任何人类棋谱进行训练,训练了三天的成就就已经超过了人类几千年的经验积累<del>导致柯洁道心破碎</del>。

|

深度强化学习最初来源是 2013 年谷歌 DeepMind 团队发表的《Playing Atari with Deep Reinforcement Learning》一文,正式提出 Deep Q-network(DQN)算法。在这篇论文中,DeepMind 团队训练智能体 Agent 玩雅达利游戏,并取得了惊人的成绩。事实上,深度强化学习最为人熟知的成就是 AlphaGO Zero,它没有使用任何人类棋谱进行训练,训练了三天的成就就已经超过了人类几千年的经验积累<del>导致柯洁道心破碎</del>。

|

||||||

|

|

||||||

# 交叉学科&经典机器学习算法

|

## 交叉学科&经典机器学习算法

|

||||||

|

|

||||||

交叉学科巨大的难度在于你往往需要掌握多个学科以及其相对应的知识。

|

交叉学科巨大的难度在于你往往需要掌握多个学科以及其相对应的知识。

|

||||||

|

|

||||||

举个例子:如果你想要做出一个可以识别病人是否得了某种疾病,现在你得到了一批数据,你首先得自己可以标注出或者找到这个数据中,哪些是有问题的,并且可以指明问题在哪,如果你想分出更具体的,比如具体哪里有问题,那你可能甚至需要熟悉他并且把他标注出来。

|

举个例子:如果你想要做出一个可以识别病人是否得了某种疾病,现在你得到了一批数据,你首先得自己可以标注出或者找到这个数据中,哪些是有问题的,并且可以指明问题在哪,如果你想分出更具体的,比如具体哪里有问题,那你可能甚至需要熟悉他并且把他标注出来。

|

||||||

|

|

||||||

目前其实全学科都有向着AI走的趋势,例如量化金融,医疗,生物科学(nature的那篇有关氨基酸的重大发现真的很cool)。他们很多都在用非常传统的机器学习算法,甚至有的大公司的算法岗在处理某些数据的时候,可能会先考虑用最简单的决策树试一试

|

目前其实全学科都有向着 AI 走的趋势,例如量化金融,医疗,生物科学 (nature 的那篇有关氨基酸的重大发现真的很 cool)。他们很多都在用非常传统的机器学习算法,甚至有的大公司的算法岗在处理某些数据的时候,可能会先考虑用最简单的决策树试一试

|

||||||

|

|

||||||

当然,在大语言模型出现的趋势下,很多学科的应用会被融合会被简化会被大一统(科研人的崇高理想),但是不得不提的是,传统的机器学习算法和模型仍然希望你能去了解甚至更进一步学习。

|

当然,在大语言模型出现的趋势下,很多学科的应用会被融合会被简化会被大一统 (科研人的崇高理想),但是不得不提的是,传统的机器学习算法和模型仍然希望你能去了解甚至更进一步学习。

|

||||||

|

|

||||||

除了能让你了解所谓前人的智慧,还可以给你带来更进一步的在数学思维,算法思维上的提高。

|

除了能让你了解所谓前人的智慧,还可以给你带来更进一步的在数学思维,算法思维上的提高。

|

||||||

|

|

||||||

# And more?

|

## And more?

|

||||||

|

|

||||||

我们对AI的定义如果仅仅只有这些内容,我认为还是太过于狭隘了,我们可以把知识规划,知识表征等等东西都可以将他划入AI的定义中去,当然这些还期待着你的进一步探索和思考~

|

我们对 AI 的定义如果仅仅只有这些内容,我认为还是太过于狭隘了,我们可以把知识规划,知识表征等等东西都可以将他划入 AI 的定义中去,当然这些还期待着你的进一步探索和思考~

|

||||||

|

|

||||||

|

## 特别致谢

|

||||||

|

|

||||||

# 特别致谢

|

非常荣幸能在本章中得到 IIPL 智能信息处理实验室 [http://iipl.net.cn](http://iipl.net.cn) 的宝贵贡献,衷心感谢他们的无私支持与帮助!

|

||||||

|

|

||||||

非常荣幸能在本章中得到 IIPL智能信息处理实验室 http://iipl.net.cn 的宝贵贡献,衷心感谢他们的无私支持与帮助!

|

希望加入 IIPL?欢迎移步[SRT 社团介绍](SRT.md)~

|

||||||

|

|

||||||

希望加入IIPL?欢迎移步[SRT社团介绍](SRT.md)~

|

|

||||||

|

|||||||

@@ -1,6 +1,6 @@

|

|||||||

# 机器学习(AI)快速入门(quick start)

|

# 机器学习(AI)快速入门(quick start)

|

||||||

|

|

||||||

本章内容需要你掌握一定的 python 基础知识。

|

::: warning 😇 本章内容需要你掌握一定的 python 基础知识。

|

||||||

|

|

||||||

如果你想要快速了解机器学习,并且动手尝试去实践他,你可以先阅览本部分内容。

|

如果你想要快速了解机器学习,并且动手尝试去实践他,你可以先阅览本部分内容。

|

||||||

|

|

||||||

@@ -11,8 +11,9 @@

|

|||||||

当然我需要承认一点,为了让大家都可以看懂,我做了很多抽象,具有了很多例子,某些内容不太准确,这是必然的,最为准确的往往是课本上精确到少一个字都不行的概念,这是难以理解的。

|

当然我需要承认一点,为了让大家都可以看懂,我做了很多抽象,具有了很多例子,某些内容不太准确,这是必然的,最为准确的往往是课本上精确到少一个字都不行的概念,这是难以理解的。

|

||||||

|

|

||||||

本篇内容只适合新手理解使用,所以不免会损失一些精度。

|

本篇内容只适合新手理解使用,所以不免会损失一些精度。

|

||||||

|

:::

|

||||||

|

|

||||||

# 什么是机器学习

|

## 什么是机器学习

|

||||||

|

|

||||||

这个概念其实不需要那么多杂七杂八的概念去解释。

|

这个概念其实不需要那么多杂七杂八的概念去解释。

|

||||||

|

|

||||||

@@ -22,17 +23,17 @@

|

|||||||

|

|

||||||

然后你给了他更多信息,比如说国家给出了某些条例,他分析这个条例一出,房价就会降低,他给你了个新的数据。

|

然后你给了他更多信息,比如说国家给出了某些条例,他分析这个条例一出,房价就会降低,他给你了个新的数据。

|

||||||

|

|

||||||

因此我们得出一个结论:机器学习 = 泛型算法。

|

因此我们得出一个结论:机器学习 = 泛型算法。

|

||||||

|

|

||||||

甚至深度学习,也只是机器学习的一部分,不过使用了更多技巧和方法,增大了计算能力罢了。

|

甚至深度学习,也只是机器学习的一部分,不过使用了更多技巧和方法,增大了计算能力罢了。

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

# 两种机器学习算法

|

## 两种机器学习算法

|

||||||

|

|

||||||

你可以把机器学习算法分为两大类:监督式学习(supervised Learning)和非监督式学习(unsupervised Learning)。要区分两者很简单,但也非常重要。

|

你可以把机器学习算法分为两大类:监督式学习(supervised Learning)和非监督式学习(unsupervised Learning)。要区分两者很简单,但也非常重要。

|

||||||

|

|

||||||

## 监督式学习

|

### 监督式学习

|

||||||

|

|

||||||

你是卖方的,你公司很大,因此你雇了一批新员工来帮忙。

|

你是卖方的,你公司很大,因此你雇了一批新员工来帮忙。

|

||||||

|

|

||||||

@@ -50,7 +51,7 @@

|

|||||||

|

|

||||||

这就是监督学习,你有一个参照物可以帮你决策。

|

这就是监督学习,你有一个参照物可以帮你决策。

|

||||||

|

|

||||||

## 无监督学习

|

### 无监督学习

|

||||||

|

|

||||||

没有答案怎么办?

|

没有答案怎么办?

|

||||||

|

|

||||||

@@ -78,29 +79,27 @@

|

|||||||

|

|

||||||

但是「机器在少量样本数据的基础上找出一个公式来解决特定的问题」不是个好名字。所以最后我们用「机器学习」取而代之。而深度学习,则是机器在数据的基础上通过很深的网络(很多的公式)找一个及解决方案来解决问题。

|

但是「机器在少量样本数据的基础上找出一个公式来解决特定的问题」不是个好名字。所以最后我们用「机器学习」取而代之。而深度学习,则是机器在数据的基础上通过很深的网络(很多的公式)找一个及解决方案来解决问题。

|

||||||

|

|

||||||

# 看看 Code

|

## 看看 Code

|

||||||

|

|

||||||

如果你完全不懂机器学习知识,你可能会用一堆 if else 条件判断语句来判断比如说房价

|

如果你完全不懂机器学习知识,你可能会用一堆 if else 条件判断语句来判断比如说房价

|

||||||

|

|

||||||

```python

|

```python

|

||||||

def estimate_house_sales_price(num_of_bedrooms, sqft, neighborhood):

|

def estimate_house_sales_price(num_of_bedrooms, sqft, neighborhood):

|

||||||

price = 0 # In my area, the average house costs $200 per sqft

|

price = 0 # In my area, the average house costs $200 per sqft

|

||||||

price_per_sqft = 200

|

price_per_sqft = 200 i f neighborhood == "hipsterton":

|

||||||

if neighborhood == "hipsterton":

|

|

||||||

# but some areas cost a bit more

|

# but some areas cost a bit more

|

||||||

price_per_sqft = 400

|

price_per_sqft = 400 elif neighborhood == "skid row":

|

||||||

elif neighborhood == "skid row":

|

|

||||||

# and some areas cost less

|

# and some areas cost less

|

||||||

price_per_sqft = 100 # start with a base price estimate based on how big the place is

|

price_per_sqft = 100 # start with a base price estimate based on how big the place is

|

||||||

price = price_per_sqft * sqft # now adjust our estimate based on the number of bedrooms

|

price = price_per_sqft * sqft # now adjust our estimate based on the number of bedrooms

|

||||||

if num_of_bedrooms == 0:

|

if num_of_bedrooms == 0:

|

||||||

# Studio apartments are cheap

|

# Studio apartments are cheap

|

||||||

price = price - 20000

|

price = price — 20000

|

||||||

else:

|

else:

|

||||||

# places with more bedrooms are usually

|

# places with more bedrooms are usually

|

||||||

# more valuable

|

# more valuable

|

||||||

price = price + (num_of_bedrooms * 1000)

|

price = price + (num_of_bedrooms * 1000)

|

||||||

return price

|

return price

|

||||||

```

|

```

|

||||||

|

|

||||||

假如你像这样瞎忙几个小时,最后也许会得到一些像模像样的东西。但是永远感觉差点东西。

|

假如你像这样瞎忙几个小时,最后也许会得到一些像模像样的东西。但是永远感觉差点东西。

|

||||||

@@ -119,7 +118,7 @@ def estimate_house_sales_price(num_of_bedrooms, sqft, neighborhood):

|

|||||||

|

|

||||||

如果你可以找到这么一个公式:

|

如果你可以找到这么一个公式:

|

||||||

|

|

||||||

Y(房价)=W(参数)*X1(卧室数量)+W*X2(面积)+W*X3(地段)

|

Y(房价)=W(参数) \* X1(卧室数量) + W \*X2(面积) + W \* X3(地段)

|

||||||

|

|

||||||

你是不是会舒服很多,可以把他想象成,你要做菜,然后那些参数就是佐料的配比

|

你是不是会舒服很多,可以把他想象成,你要做菜,然后那些参数就是佐料的配比

|

||||||

|

|

||||||

@@ -151,7 +150,7 @@ def estimate_house_sales_price(num_of_bedrooms, sqft, neighborhood):

|

|||||||

|

|

||||||

第三步:

|

第三步:

|

||||||

|

|

||||||

通过尝试所有可能的权重值组合,不断重复第二步。哪一个权重组合的代价最接近于 0,你就使用哪个。当你找到了合适的权重值,你就解决了问题!

|

通过尝试所有可能的权重值组合,不断重复第二步。哪一个权重组合的代价最接近于 0,你就使用哪个。当你找到了合适的权重值,你就解决了问题!

|

||||||

|

|

||||||

兴奋的时刻到了!

|

兴奋的时刻到了!

|

||||||

|

|

||||||

@@ -176,7 +175,7 @@ def estimate_house_sales_price(num_of_bedrooms, sqft, neighborhood):

|

|||||||

|

|

||||||

|

|

||||||

|

|

||||||

<em>θ 表示当前的权重值。 J(θ) 表示「当前权重的代价」。</em>

|

<em>θ 表示当前的权重值。J(θ) 表示「当前权重的代价」。</em>

|

||||||

|

|

||||||

这个等式表示,在当前权重值下,我们估价程序的偏离程度。

|

这个等式表示,在当前权重值下,我们估价程序的偏离程度。

|

||||||

|

|

||||||

@@ -210,7 +209,7 @@ def estimate_house_sales_price(num_of_bedrooms, sqft, neighborhood):

|

|||||||

|

|

||||||

换言之,尽管基本概念非常简单,要通过机器学习得到有用的结果还是需要一些技巧和经验的。但是,这是每个开发者都能学会的技巧。

|

换言之,尽管基本概念非常简单,要通过机器学习得到有用的结果还是需要一些技巧和经验的。但是,这是每个开发者都能学会的技巧。

|

||||||

|

|

||||||

# 更为智能的预测

|

## 更为智能的预测

|

||||||

|

|

||||||

我们通过上一次的函数假设已经得到了一些值。

|

我们通过上一次的函数假设已经得到了一些值。

|

||||||

|

|

||||||

@@ -229,7 +228,7 @@ def estimate_house_sales_price(num_of_bedrooms, sqft, neighborhood):

|

|||||||

|

|

||||||

<em>箭头头表示了函数中的权重。</em>

|

<em>箭头头表示了函数中的权重。</em>

|

||||||

|

|

||||||

然而,这个算法仅仅能用于处理一些简单的问题,就是那些输入和输出有着线性关系的问题。但如果真实价格和决定因素的关系并不是如此简单,那我们该怎么办? 比如说,地段对于大户型和小户型的房屋有很大影响,然而对中等户型的房屋并没有太大影响。那我们该怎么在我们的模型中收集这种复杂的信息呢?

|

然而,这个算法仅仅能用于处理一些简单的问题,就是那些输入和输出有着线性关系的问题。但如果真实价格和决定因素的关系并不是如此简单,那我们该怎么办?比如说,地段对于大户型和小户型的房屋有很大影响,然而对中等户型的房屋并没有太大影响。那我们该怎么在我们的模型中收集这种复杂的信息呢?

|

||||||

|

|

||||||

所以为了更加的智能化,我们可以利用不同的权重来多次运行这个算法,收集各种不同情况下的估价。

|

所以为了更加的智能化,我们可以利用不同的权重来多次运行这个算法,收集各种不同情况下的估价。

|

||||||

|

|

||||||

@@ -241,7 +240,7 @@ def estimate_house_sales_price(num_of_bedrooms, sqft, neighborhood):

|

|||||||

|

|

||||||

这样我们相当于得到了更为准确的答案

|

这样我们相当于得到了更为准确的答案

|

||||||

|

|

||||||

# 神经网络是什么

|

## 神经网络是什么

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

@@ -272,7 +271,7 @@ class LinearModel(torch.nn.Module):

|

|||||||

y_pred=self.linear(x)

|

y_pred=self.linear(x)

|

||||||

return y_pred

|

return y_pred

|

||||||

'''

|

'''

|

||||||

线性模型所必须的前馈传播,即wx+b

|

线性模型所必须的前馈传播,即 wx+b

|

||||||

'''

|

'''

|

||||||

|

|

||||||

model=LinearModel()

|

model=LinearModel()

|

||||||

@@ -299,21 +298,23 @@ y_test=model(x_test)

|

|||||||

print('y_pred=',y_test.data)

|

print('y_pred=',y_test.data)

|

||||||

```

|

```

|

||||||

|

|

||||||

# 由浅入深(不会涉及代码)

|

## 由浅入深(不会涉及代码)

|

||||||

|

|

||||||

# 为什么不教我写代码?

|

::: warning 😇 为什么不教我写代码?

|

||||||

|

|

||||||

因为你可能看这些基础知识感觉很轻松毫无压力,但是倘若附上很多代码,会一瞬间拉高这里的难度,虽然仅仅只是调包。

|

因为你可能看这些基础知识感觉很轻松毫无压力,但是倘若附上很多代码,会一瞬间拉高这里的难度,虽然仅仅只是调包。

|

||||||

|

|

||||||

但是我还是会在上面贴上一点代码,但不会有很详细的讲解,因为很多都是调包,没什么好说的,如果你完全零基础,忽略这部分内容即可

|

但是我还是会在上面贴上一点代码,但不会有很详细的讲解,因为很多都是调包,没什么好说的,如果你完全零基础,忽略这部分内容即可

|

||||||

|

|

||||||

|

:::

|

||||||

|

|

||||||

我们尝试做一个神奇的工作,那就是用神经网络来识别一下手写数字,听上去非常不可思议,但是我要提前说的一点是,图像也不过是数据的组合,每一张图片有不同程度的像素值,如果我们把每一个像素值都当成神经网络的输入值,然后经过一个黑盒,让他识别出一个他认为可能的数字,然后进行纠正即可。

|

我们尝试做一个神奇的工作,那就是用神经网络来识别一下手写数字,听上去非常不可思议,但是我要提前说的一点是,图像也不过是数据的组合,每一张图片有不同程度的像素值,如果我们把每一个像素值都当成神经网络的输入值,然后经过一个黑盒,让他识别出一个他认为可能的数字,然后进行纠正即可。

|

||||||

|

|

||||||

机器学习只有在你拥有数据(最好是大量数据)的情况下,才能有效。所以,我们需要有大量的手写「8」来开始我们的尝试。幸运的是,恰好有研究人员建立了 [MNIST 手写数字数据库](https://link.zhihu.com/?target=http%3A//yann.lecun.com/exdb/mnist/),它能助我们一臂之力。MNIST 提供了 60,000 张手写数字的图片,每张图片分辨率为 18×18。即有这么多的数据。

|

机器学习只有在你拥有数据(最好是大量数据)的情况下,才能有效。所以,我们需要有大量的手写「8」来开始我们的尝试。幸运的是,恰好有研究人员建立了 [MNIST 手写数字数据库](https://link.zhihu.com/?target=http%3A//yann.lecun.com/exdb/mnist/),它能助我们一臂之力。MNIST 提供了 60,000 张手写数字的图片,每张图片分辨率为 18×18。即有这么多的数据。

|

||||||

|

|

||||||

```python

|

```python

|

||||||

(X_train, y_train), (X_test, y_test) = mnist.load_data()

|

(X_train, y_train), (X_test, y_test) = mnist.load_data()

|

||||||

#这段是导入minist的方法,但是你看不到,如果你想看到的话需要其他操作

|

#这段是导入 minist 的方法,但是你看不到,如果你想看到的话需要其他操作

|

||||||

```

|

```

|

||||||

|

|

||||||

我们试着只识别一个数字 8

|

我们试着只识别一个数字 8

|

||||||

@@ -345,7 +346,7 @@ model.add(Activation('relu'))# 激活函数,你可以理解为加上这个东

|

|||||||

|

|

||||||

现在唯一要做的就是用各种「8」和非「8」的图片来训练我们的神经网络了。当我们喂给神经网络一个「8」的时候,我们会告诉它是「8」的概率是 100% ,而不是「8」的概率是 0%,反之亦然。

|

现在唯一要做的就是用各种「8」和非「8」的图片来训练我们的神经网络了。当我们喂给神经网络一个「8」的时候,我们会告诉它是「8」的概率是 100% ,而不是「8」的概率是 0%,反之亦然。

|

||||||

|

|

||||||

# 仅此而已吗

|

## 仅此而已吗

|

||||||

|

|

||||||

当数字并不是正好在图片中央的时候,我们的识别器就完全不工作了。一点点的位移我们的识别器就掀桌子不干了

|

当数字并不是正好在图片中央的时候,我们的识别器就完全不工作了。一点点的位移我们的识别器就掀桌子不干了

|

||||||

|

|

||||||

@@ -355,7 +356,7 @@ model.add(Activation('relu'))# 激活函数,你可以理解为加上这个东

|

|||||||

|

|

||||||

在真实世界中,这种识别器好像并没什么卵用。真实世界的问题永远不会如此轻松简单。所以,我们需要知道,当「8」不在图片正中时,怎么才能让我们的神经网络识别它。

|

在真实世界中,这种识别器好像并没什么卵用。真实世界的问题永远不会如此轻松简单。所以,我们需要知道,当「8」不在图片正中时,怎么才能让我们的神经网络识别它。

|

||||||

|

|

||||||

## 暴力方法:更多的数据和更深的网络

|

### 暴力方法:更多的数据和更深的网络

|

||||||

|

|

||||||

他不能识别靠左靠右的数据?我们都给他!给他任何位置的图片!

|

他不能识别靠左靠右的数据?我们都给他!给他任何位置的图片!

|

||||||

|

|

||||||

@@ -371,7 +372,7 @@ model.add(Activation('relu'))# 激活函数,你可以理解为加上这个东

|

|||||||

|

|

||||||

一层一层堆叠起来,这种方法很早就出现了。

|

一层一层堆叠起来,这种方法很早就出现了。

|

||||||

|

|

||||||

## 更好的方法?

|

### 更好的方法?

|

||||||

|

|

||||||

你可以通过卷积神经网络进行进一步的处理

|

你可以通过卷积神经网络进行进一步的处理

|

||||||

|

|

||||||

@@ -389,7 +390,7 @@ model.add(Activation('relu'))# 激活函数,你可以理解为加上这个东

|

|||||||

|

|

||||||

|

|

||||||

|

|

||||||

## 卷积是如何工作的

|

### 卷积是如何工作的

|

||||||

|

|

||||||

之前我们提到过,我们可以把一整张图片当做一串数字输入到神经网络里面。不同的是,这次我们会利用<strong>平移不变性</strong>的概念来把这件事做得更智能。

|

之前我们提到过,我们可以把一整张图片当做一串数字输入到神经网络里面。不同的是,这次我们会利用<strong>平移不变性</strong>的概念来把这件事做得更智能。

|

||||||

|

|

||||||

@@ -405,7 +406,7 @@ model.add(Activation('relu'))# 激活函数,你可以理解为加上这个东

|

|||||||

|

|

||||||

换一句话来说,我们从一整张图片开始,最后得到一个稍小一点的数组,里面存储着我们图片中的哪一部分有异常。

|

换一句话来说,我们从一整张图片开始,最后得到一个稍小一点的数组,里面存储着我们图片中的哪一部分有异常。

|

||||||

|

|

||||||

## 池化层

|

### 池化层

|

||||||

|

|

||||||

图像可能特别大。比如说 1024*1024 再来个颜色 RGB

|

图像可能特别大。比如说 1024*1024 再来个颜色 RGB

|

||||||

|

|

||||||

@@ -429,7 +430,7 @@ model.add(Activation('relu'))# 激活函数,你可以理解为加上这个东

|

|||||||

|

|

||||||

我们也要感谢显卡,这项技术早就出现了但是一直算不了,有了显卡让这件事成为了可能。

|

我们也要感谢显卡,这项技术早就出现了但是一直算不了,有了显卡让这件事成为了可能。

|

||||||

|

|

||||||

## 作出预测

|

### 作出预测

|

||||||

|

|

||||||

到现在为止,我们已经把一个很大的图片缩减到了一个相对较小的数组。

|

到现在为止,我们已经把一个很大的图片缩减到了一个相对较小的数组。

|

||||||

|

|

||||||

@@ -445,10 +446,10 @@ model.add(Activation('relu'))# 激活函数,你可以理解为加上这个东

|

|||||||

|

|

||||||

比如说,第一个卷积的步骤可能就是尝试去识别尖锐的东西,而第二个卷积步骤则是通过找到的尖锐物体来找鸟类的喙,最后一步是通过鸟喙来识别整只鸟,以此类推。

|

比如说,第一个卷积的步骤可能就是尝试去识别尖锐的东西,而第二个卷积步骤则是通过找到的尖锐物体来找鸟类的喙,最后一步是通过鸟喙来识别整只鸟,以此类推。

|

||||||

|

|

||||||

# 结语

|

## 结语

|

||||||

|

|

||||||

这篇文章仅仅只是粗略的讲述了一些机器学习的一些基本操作,如果你要更深一步学习的话你可能还需要更多的探索。

|

这篇文章仅仅只是粗略的讲述了一些机器学习的一些基本操作,如果你要更深一步学习的话你可能还需要更多的探索。

|

||||||

|

|

||||||

# 参考资料

|

## 参考资料

|

||||||

|

|

||||||

[machine-learning-for-software-engineers/README-zh-CN.md at master · ZuzooVn/machine-learning-for-sof](https://github.com/ZuzooVn/machine-learning-for-software-engineers/blob/master/README-zh-CN.md#%E6%9C%BA%E5%99%A8%E5%AD%A6%E4%B9%A0%E6%A6%82%E8%AE%BA)

|

[machine-learning-for-software-engineers/README-zh-CN.md at master · ZuzooVn/machine-learning-for-sof](https://github.com/ZuzooVn/machine-learning-for-software-engineers/blob/master/README-zh-CN.md#%E6%9C%BA%E5%99%A8%E5%AD%A6%E4%B9%A0%E6%A6%82%E8%AE%BA)

|

||||||

|

|||||||

@@ -1,4 +1,5 @@

|

|||||||

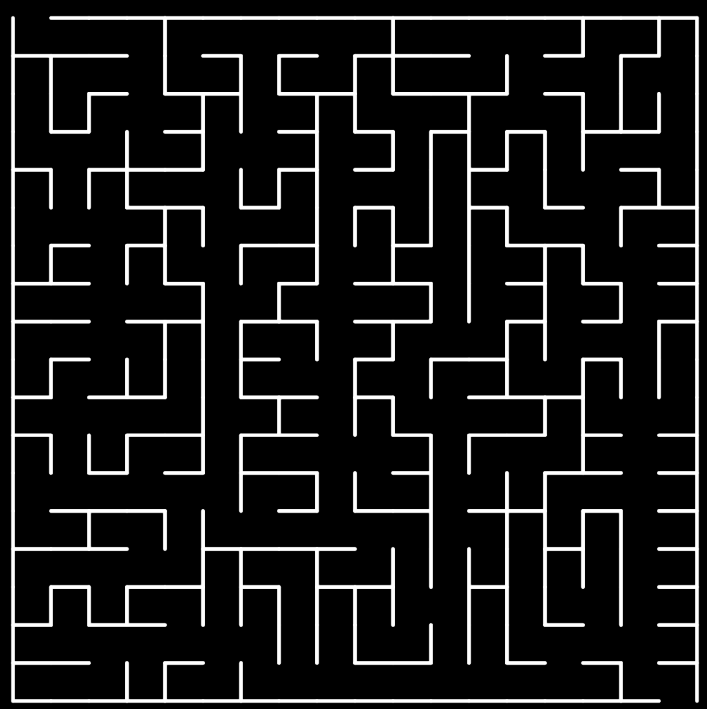

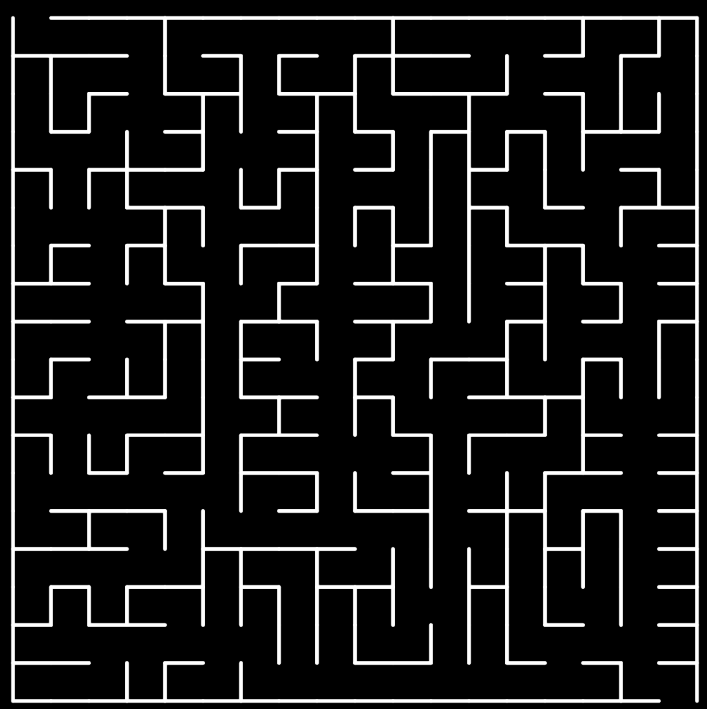

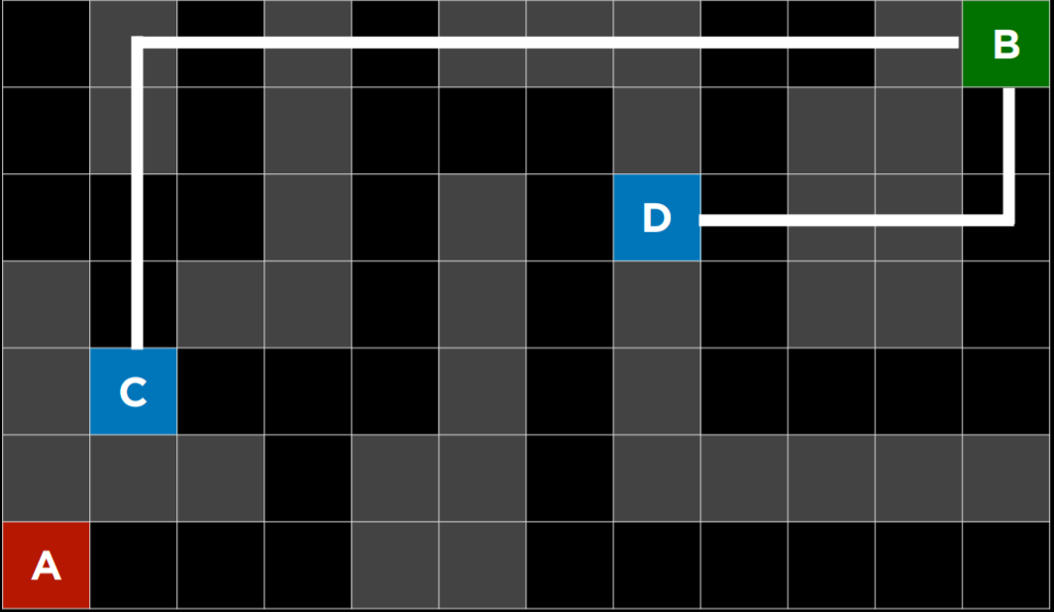

# 程序示例——maze 迷宫解搜索

|

# 程序示例——maze 迷宫解搜索

|

||||||

|

|

||||||

::: warning 😋

|

::: warning 😋

|

||||||

阅读程序中涉及搜索算法的部分,然后运行程序,享受机器自动帮你寻找路径的快乐!

|

阅读程序中涉及搜索算法的部分,然后运行程序,享受机器自动帮你寻找路径的快乐!

|

||||||

完成习题

|

完成习题

|

||||||

@@ -10,7 +11,7 @@

|

|||||||

|

|

||||||

/4.人工智能/code/MAZE.zip

|

/4.人工智能/code/MAZE.zip

|

||||||

|

|

||||||

# Node

|

## Node

|

||||||

|

|

||||||

```python

|

```python

|

||||||

# 节点类 Node

|

# 节点类 Node

|

||||||

@@ -21,7 +22,7 @@ class Node:

|

|||||||

self.action = action # 存储采取的行动

|

self.action = action # 存储采取的行动

|

||||||

```

|

```

|

||||||

|

|

||||||

## 节点复习:

|

## 节点复习

|

||||||

|

|

||||||

- 节点是一种包含以下数据的数据结构:

|

- 节点是一种包含以下数据的数据结构:

|

||||||

- 状态——state

|

- 状态——state

|

||||||

@@ -29,7 +30,7 @@ class Node:

|

|||||||

- 应用于父级状态以获取当前节点的操作——action

|

- 应用于父级状态以获取当前节点的操作——action

|

||||||

- 从初始状态到该节点的路径成本——path cost

|

- 从初始状态到该节点的路径成本——path cost

|

||||||

|

|

||||||

# 堆栈边域——DFS

|

## 堆栈边域——DFS

|

||||||

|

|

||||||

```python

|

```python

|

||||||

class StackFrontier: # 堆栈边域

|

class StackFrontier: # 堆栈边域

|

||||||

@@ -50,11 +51,11 @@ class StackFrontier: # 堆栈边域

|

|||||||

return node

|

return node

|

||||||

```

|

```

|

||||||

|

|

||||||

## 深度优先搜索复习:

|

## 深度优先搜索复习

|

||||||

|

|

||||||

- 深度优先搜索算法在尝试另一个方向之前耗尽每个方向。在这些情况下,边域作为堆栈数据结构进行管理。这里需要记住的流行语是“后进先出”。在将节点添加到边域后,第一个要删除和考虑的节点是最后一个要添加的节点。这导致了一种搜索算法,该算法在第一个方向上尽可能深入,直到尽头,同时将所有其他方向留到后面。“不撞南墙不回头”

|

- 深度优先搜索算法在尝试另一个方向之前耗尽每个方向。在这些情况下,边域作为堆栈数据结构进行管理。这里需要记住的流行语是“后进先出”。在将节点添加到边域后,第一个要删除和考虑的节点是最后一个要添加的节点。这导致了一种搜索算法,该算法在第一个方向上尽可能深入,直到尽头,同时将所有其他方向留到后面。“不撞南墙不回头”

|

||||||

|

|

||||||

# 队列边域——BFS

|

## 队列边域——BFS

|

||||||

|

|

||||||

```python

|

```python

|

||||||

class QueueFrontier(StackFrontier): # 队列边域

|

class QueueFrontier(StackFrontier): # 队列边域

|

||||||

@@ -67,11 +68,11 @@ class QueueFrontier(StackFrontier): # 队列边域

|

|||||||

return node

|

return node

|

||||||

```

|

```

|

||||||

|

|

||||||

## 广度优先搜索复习:

|

## 广度优先搜索复习

|

||||||

|

|

||||||

- 广度优先搜索算法将同时遵循多个方向,在每个可能的方向上迈出一步,然后在每个方向上迈出第二步。在这种情况下,边域作为队列数据结构进行管理。这里需要记住的流行语是“先进先出”。在这种情况下,所有新节点都会排成一行,并根据先添加的节点来考虑节点(先到先得!)。这导致搜索算法在任何一个方向上迈出第二步之前,在每个可能的方向上迈出一步。

|

- 广度优先搜索算法将同时遵循多个方向,在每个可能的方向上迈出一步,然后在每个方向上迈出第二步。在这种情况下,边域作为队列数据结构进行管理。这里需要记住的流行语是“先进先出”。在这种情况下,所有新节点都会排成一行,并根据先添加的节点来考虑节点(先到先得!)。这导致搜索算法在任何一个方向上迈出第二步之前,在每个可能的方向上迈出一步。

|

||||||

|

|

||||||

# 迷宫解——Maze_solution

|

## 迷宫解——Maze_solution

|

||||||

|

|

||||||

```python

|

```python

|

||||||

class Maze:

|

class Maze:

|

||||||

@@ -111,7 +112,7 @@ class Maze:

|

|||||||

# 打印结果

|

# 打印结果

|

||||||

def print(self):

|

def print(self):

|

||||||

...

|

...

|

||||||

# 寻找邻结点,返回元组(动作,坐标(x,y))

|

# 寻找邻结点,返回元组 (动作,坐标 (x,y))

|

||||||

def neighbors(self, state):

|

def neighbors(self, state):

|

||||||

row, col = state

|

row, col = state

|

||||||

candidates = [

|

candidates = [

|

||||||

@@ -130,8 +131,8 @@ class Maze:

|

|||||||

self.num_explored = 0 # 已搜索的路径长度

|

self.num_explored = 0 # 已搜索的路径长度

|

||||||

# 将边界初始化为起始位置

|

# 将边界初始化为起始位置

|

||||||

start = Node(state=self.start, parent=None, action=None)

|

start = Node(state=self.start, parent=None, action=None)

|

||||||

frontier = StackFrontier() # 采用DFS

|

frontier = StackFrontier() # 采用 DFS

|

||||||

# frontier = QueueFrontier() # 采用BFS

|

# frontier = QueueFrontier() # 采用 BFS

|

||||||

frontier.add(start)

|

frontier.add(start)

|

||||||

# 初始化一个空的探索集

|

# 初始化一个空的探索集

|

||||||

self.explored = set() # 存储已搜索的结点

|

self.explored = set() # 存储已搜索的结点

|

||||||

@@ -166,7 +167,7 @@ class Maze:

|

|||||||

...

|

...

|

||||||

```

|

```

|

||||||

|

|

||||||

# Quiz

|

## Quiz

|

||||||

|

|

||||||

1. 在深度优先搜索(DFS)和广度优先搜索(BFS)之间,哪一个会在迷宫中找到更短的路径?

|

1. 在深度优先搜索(DFS)和广度优先搜索(BFS)之间,哪一个会在迷宫中找到更短的路径?

|

||||||

1. DFS 将始终找到比 BFS 更短的路径

|

1. DFS 将始终找到比 BFS 更短的路径

|

||||||

@@ -190,11 +191,11 @@ class Maze:

|

|||||||

7. 可能是四种算法中的任何一种

|

7. 可能是四种算法中的任何一种

|

||||||

8. 不可能是四种算法中的任何一种

|

8. 不可能是四种算法中的任何一种

|

||||||

3. 为什么有深度限制的极大极小算法有时比没有深度限制的极大极小更可取?

|

3. 为什么有深度限制的极大极小算法有时比没有深度限制的极大极小更可取?

|

||||||

1. 深度受限的极大极小算法可以更快地做出决定,因为它探索的状态更少

|

1. 深度受限的极大极小算法可以更快地做出决定,因为它探索的状态更少

|

||||||

2. 深度受限的极大极小算法将在没有深度限制的情况下实现与极大极小算法相同的输出,但有时会使用较少的内存

|

2. 深度受限的极大极小算法将在没有深度限制的情况下实现与极大极小算法相同的输出,但有时会使用较少的内存

|

||||||

3. 深度受限的极大极小算法可以通过不探索已知的次优状态来做出更优化的决策

|

3. 深度受限的极大极小算法可以通过不探索已知的次优状态来做出更优化的决策

|

||||||

4. 深度限制的极小极大值永远不会比没有深度限制的极大极小值更可取

|

4. 深度限制的极小极大值永远不会比没有深度限制的极大极小值更可取

|

||||||

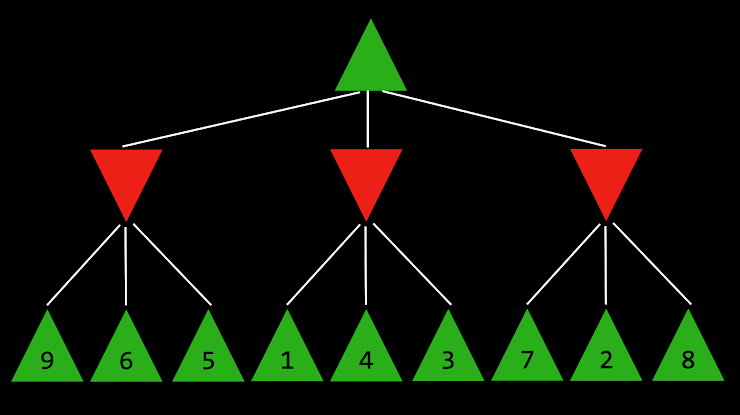

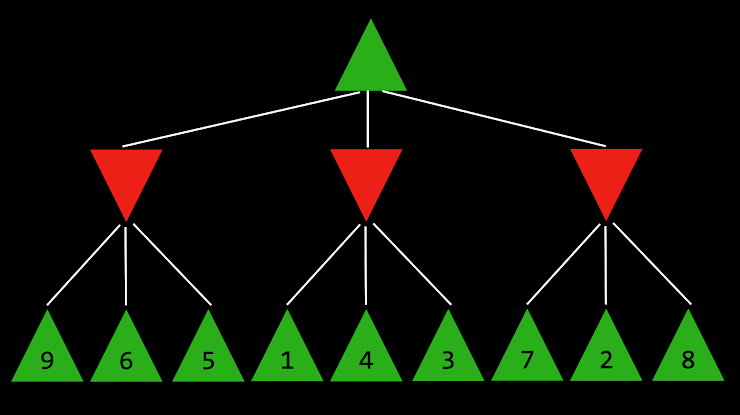

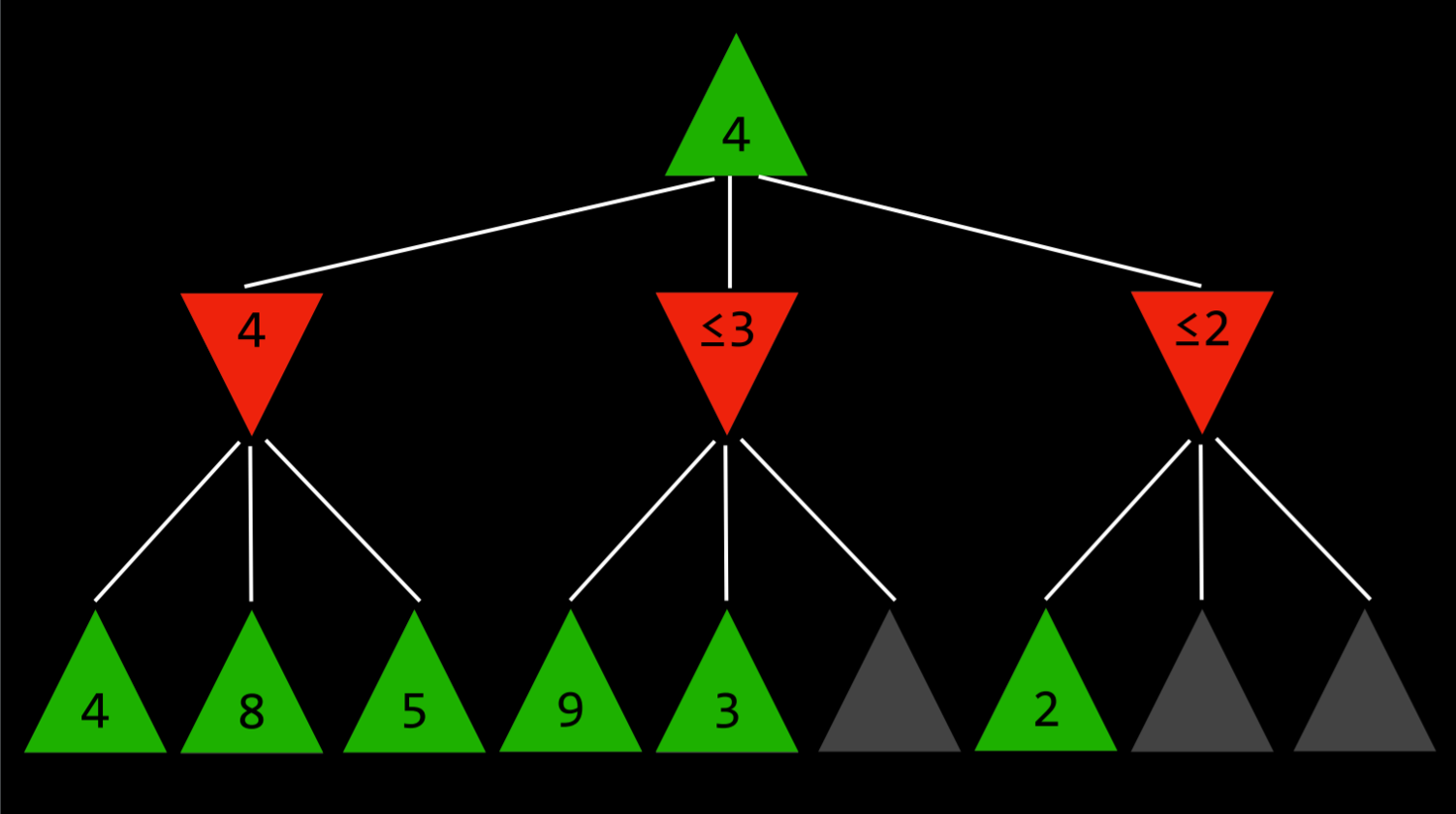

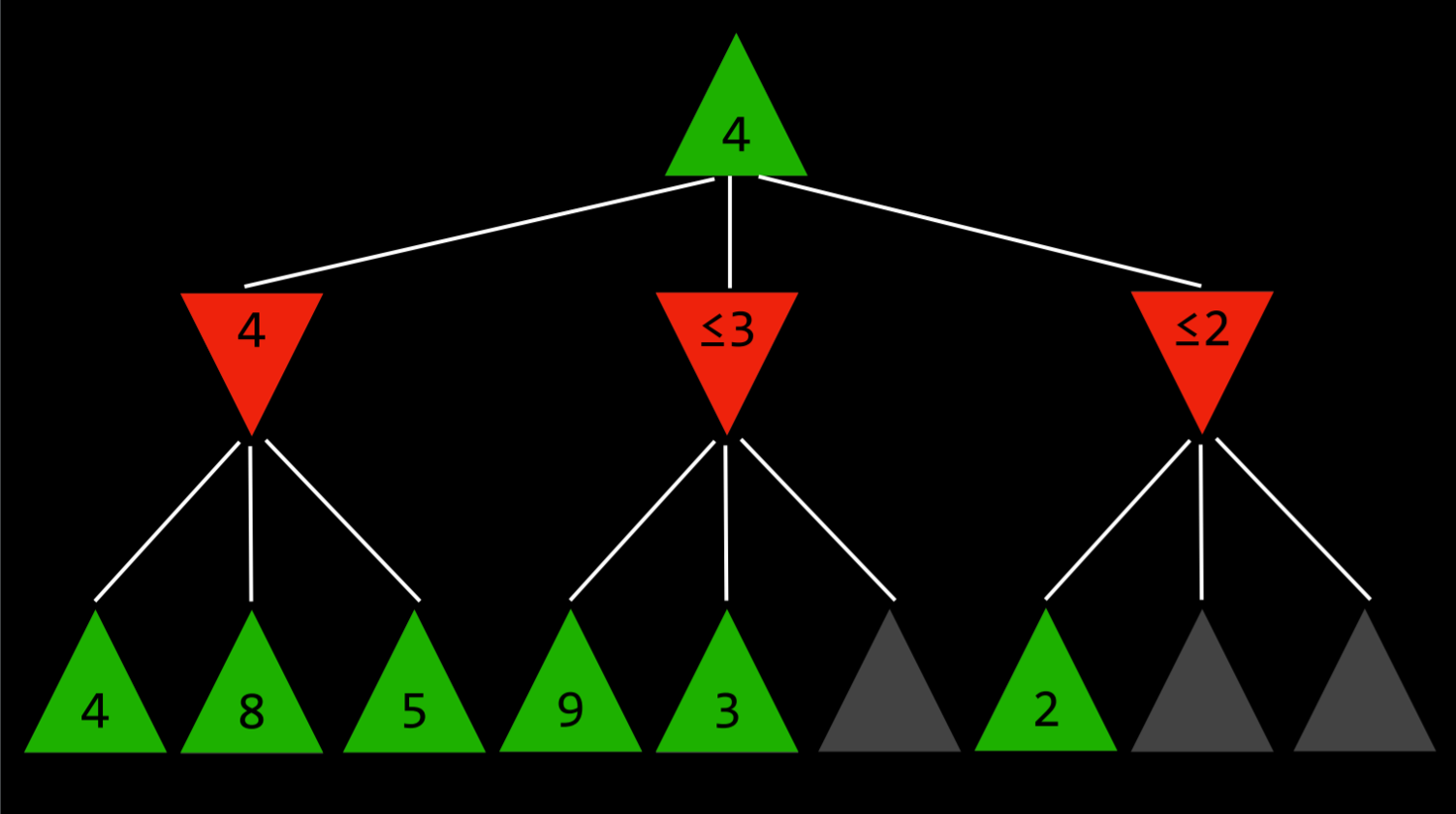

4. 下面的问题将询问您关于下面的 Minimax 树,其中绿色向上箭头表示 MAX 玩家,红色向下箭头表示 MIN 玩家。每个叶节点都标有其值。

|

4. 下面的问题将询问您关于下面的 Minimax 树,其中绿色向上箭头表示 MAX 玩家,红色向下箭头表示 MIN 玩家。每个叶节点都标有其值。

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

|||||||

@@ -1,8 +1,9 @@

|

|||||||

# 项目:Tic-Tac-Toe 井字棋

|

# 项目:Tic-Tac-Toe 井字棋

|

||||||

|

|

||||||

我们为你提供了一个简单有趣的项目,帮助你进行知识巩固,请认真阅读文档内容。

|

::: warning 😋 我们为你提供了一个简单有趣的项目,帮助你进行知识巩固,请认真阅读文档内容。

|

||||||

|

|

||||||

如果你卡住了,请记得回来阅读文档,或请求身边人的帮助。

|

如果你卡住了,请记得回来阅读文档,或请求身边人的帮助。

|

||||||

|

:::

|

||||||

|

|

||||||

::: tip 📥

|

::: tip 📥

|

||||||

本节附件下载 <Download url="https://cdn.xyxsw.site/code/1-Projects.zip"/>

|

本节附件下载 <Download url="https://cdn.xyxsw.site/code/1-Projects.zip"/>

|

||||||

@@ -10,13 +11,13 @@

|

|||||||

|

|

||||||

`pip3 install -r requirements.txt`

|

`pip3 install -r requirements.txt`

|

||||||

|

|

||||||

# 理解

|

## 理解

|

||||||

|

|

||||||

- 这个项目有两个主要文件:`runner.py` 和 `tictactoe.py`。`tictactoe.py` 包含了玩游戏和做出最佳动作的所有逻辑。`runner.py` 已经为你实现,它包含了运行游戏图形界面的所有代码。一旦你完成了 `tictactoe.py` 中所有必需的功能,你就可以运行 `python runner.py` 来对抗你的人工智能了!

|

- 这个项目有两个主要文件:`runner.py` 和 `tictactoe.py`。`tictactoe.py` 包含了玩游戏和做出最佳动作的所有逻辑。`runner.py` 已经为你实现,它包含了运行游戏图形界面的所有代码。一旦你完成了 `tictactoe.py` 中所有必需的功能,你就可以运行 `python runner.py` 来对抗你的人工智能了!

|

||||||

- 让我们打开 `tictactoe.py` 来了解所提供的内容。首先,我们定义了三个变量:X、O 和 EMPTY,以表示游戏的可能移动。

|

- 让我们打开 `tictactoe.py` 来了解所提供的内容。首先,我们定义了三个变量:X、O 和 EMPTY,以表示游戏的可能移动。

|

||||||

- 函数 `initial_state` 返回游戏的启动状态。对于这个问题,我们选择将游戏状态表示为三个列表的列表(表示棋盘的三行),其中每个内部列表包含三个值,即 X、O 或 EMPTY。以下是我们留给你实现的功能!

|

- 函数 `initial_state` 返回游戏的启动状态。对于这个问题,我们选择将游戏状态表示为三个列表的列表(表示棋盘的三行),其中每个内部列表包含三个值,即 X、O 或 EMPTY。以下是我们留给你实现的功能!

|

||||||

|

|

||||||

# 说明

|

## 说明

|

||||||

|

|

||||||

- 实现 `player`, `actions`, `result`, `winner`, `terminal`, `utility`, 以及 `minimax`.

|

- 实现 `player`, `actions`, `result`, `winner`, `terminal`, `utility`, 以及 `minimax`.

|

||||||

|

|

||||||

@@ -46,7 +47,7 @@

|

|||||||

- 否则,如果游戏仍在进行中,则函数应返回 `False`。

|

- 否则,如果游戏仍在进行中,则函数应返回 `False`。

|

||||||

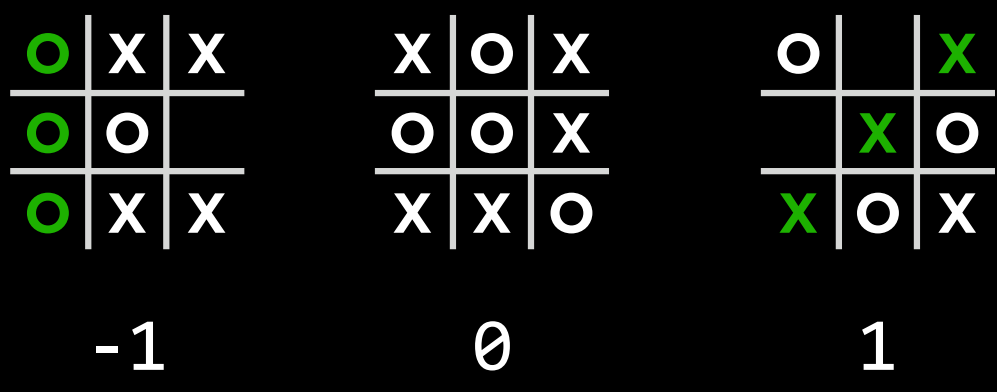

- `utility` 函数应接受结束棋盘状态作为输入,并输出该棋盘的分数。

|

- `utility` 函数应接受结束棋盘状态作为输入,并输出该棋盘的分数。

|

||||||

|

|

||||||

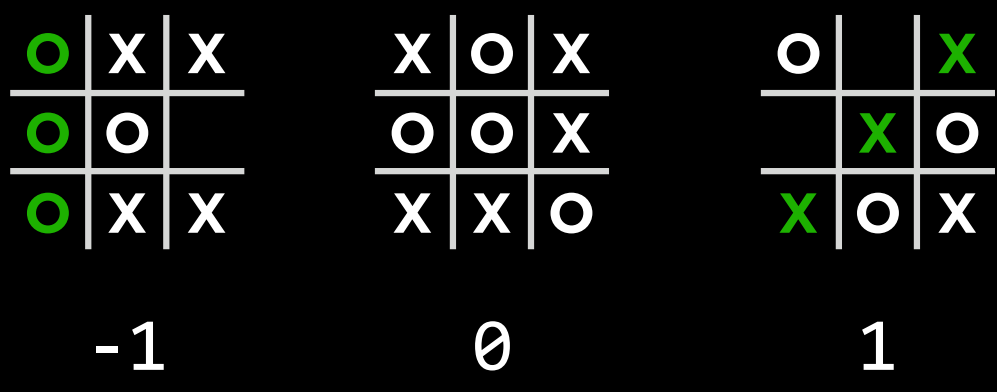

- 如果 X 赢得了比赛,则分数为 1。如果 O 赢得了比赛,则分数为-1。如果比赛以平局结束,则分数为 0。

|

- 如果 X 赢得了比赛,则分数为 1。如果 O 赢得了比赛,则分数为 -1。如果比赛以平局结束,则分数为 0。

|

||||||

- 你可以假设只有当 `terminal(board)` 为 True 时,才会在棋盘上调用 `utility`。

|

- 你可以假设只有当 `terminal(board)` 为 True 时,才会在棋盘上调用 `utility`。

|

||||||

- `minimax` 函数应该以一个棋盘作为输入,并返回玩家在该棋盘上移动的最佳移动。

|

- `minimax` 函数应该以一个棋盘作为输入,并返回玩家在该棋盘上移动的最佳移动。

|

||||||

|

|

||||||

@@ -55,7 +56,7 @@

|

|||||||

- 对于所有接受棋盘作为输入的函数,你可以假设它是一个有效的棋盘(即,它是包含三行的列表,每行都有三个值 X、O 或 EMPTY)。你不应该修改所提供的函数声明(每个函数的参数的顺序或数量)。、

|

- 对于所有接受棋盘作为输入的函数,你可以假设它是一个有效的棋盘(即,它是包含三行的列表,每行都有三个值 X、O 或 EMPTY)。你不应该修改所提供的函数声明(每个函数的参数的顺序或数量)。、

|

||||||

- 一旦所有功能都得到了正确的实现,你就应该能够运行 `python runner.py` 并与你的人工智能进行比赛。而且,由于井字棋是双方最佳比赛的平局,你永远不应该能够击败人工智能(尽管如果你打得不好,它可能会打败你!)

|

- 一旦所有功能都得到了正确的实现,你就应该能够运行 `python runner.py` 并与你的人工智能进行比赛。而且,由于井字棋是双方最佳比赛的平局,你永远不应该能够击败人工智能(尽管如果你打得不好,它可能会打败你!)

|

||||||

|

|

||||||

# 提示

|

## 提示

|

||||||

|

|

||||||

- 如果你想在不同的 Python 文件中测试你的函数,你可以用类似于 `from tictactoe import initial_state` 的代码来导入它们。

|

- 如果你想在不同的 Python 文件中测试你的函数,你可以用类似于 `from tictactoe import initial_state` 的代码来导入它们。

|

||||||

- 欢迎在 `tictactoe.py` 中添加其他辅助函数,前提是它们的名称不会与模块中已有的函数或变量名称冲突。

|

- 欢迎在 `tictactoe.py` 中添加其他辅助函数,前提是它们的名称不会与模块中已有的函数或变量名称冲突。

|

||||||

|

|||||||

@@ -1,16 +1,18 @@

|

|||||||

# 搜索

|

# 搜索

|

||||||

|

|

||||||

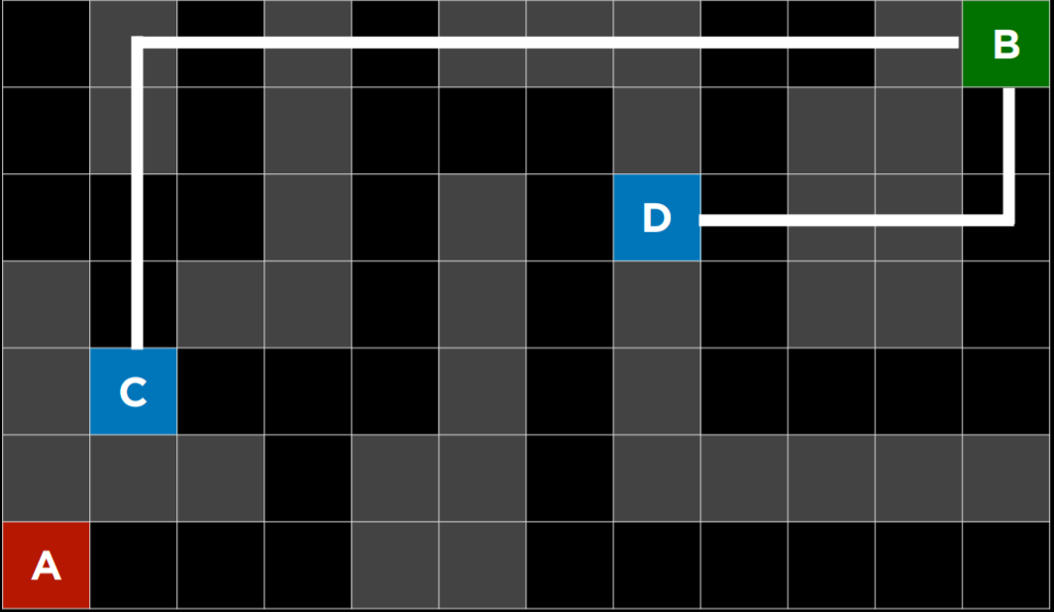

在我们日常生活中,其实有非常多的地方使用了所谓的 AI 算法,只是我们通常没有察觉。

|

::: warning 😅 在我们日常生活中,其实有非常多的地方使用了所谓的 AI 算法,只是我们通常没有察觉。

|

||||||

|

|

||||||

比如美团的外卖程序里面,可以看到外卖员到达你所在的位置的路线,它是如何规划出相关路线的呢?

|

比如美团的外卖程序里面,可以看到外卖员到达你所在的位置的路线,它是如何规划出相关路线的呢?

|

||||||

|

|

||||||

在我们和电脑下围棋下五子棋的时候,他是如何“思考”的呢?希望你在阅读完本章内容之后,可以有一个最基本的理解。并且,我们还会给你留下一个井字棋的小任务,可以让你的电脑和你下井字棋,是不是很 cool

|

在我们和电脑下围棋下五子棋的时候,他是如何“思考”的呢?希望你在阅读完本章内容之后,可以有一个最基本的理解。并且,我们还会给你留下一个井字棋的小任务,可以让你的电脑和你下井字棋,是不是很 cool

|

||||||

|

|

||||||

让我们现在开始吧!

|

让我们现在开始吧!

|

||||||

|

:::

|

||||||

|

|

||||||

# 基本定义

|

## 基本定义

|

||||||

|

|

||||||

也许第一次看会觉得云里雾里,没有必要全部记住所有的概念。可以先大致浏览一遍之后,再后续的代码中与概念进行结合,相信你会有更深入的理解

|

::: warning 🤔 也许第一次看会觉得云里雾里,没有必要全部记住所有的概念。可以先大致浏览一遍之后,再后续的代码中与概念进行结合,相信你会有更深入的理解

|

||||||

|

:::

|

||||||

|

|

||||||

> 即检索存储在某个[数据结构](https://zh.wikipedia.org/wiki/%E6%95%B0%E6%8D%AE%E7%BB%93%E6%9E%84)中的信息,或者在问题域的搜索空间中计算的信息。 --wiki

|

> 即检索存储在某个[数据结构](https://zh.wikipedia.org/wiki/%E6%95%B0%E6%8D%AE%E7%BB%93%E6%9E%84)中的信息,或者在问题域的搜索空间中计算的信息。 --wiki

|

||||||

|

|

||||||

@@ -26,15 +28,15 @@

|

|||||||

|

|

||||||

|

|

||||||

|

|

||||||

# 举个例子

|

## 举个例子

|

||||||

|

|

||||||

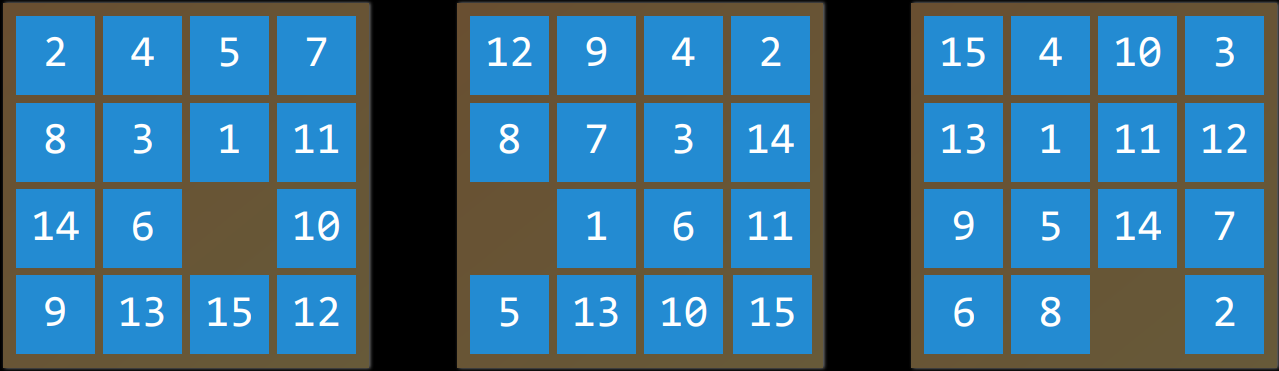

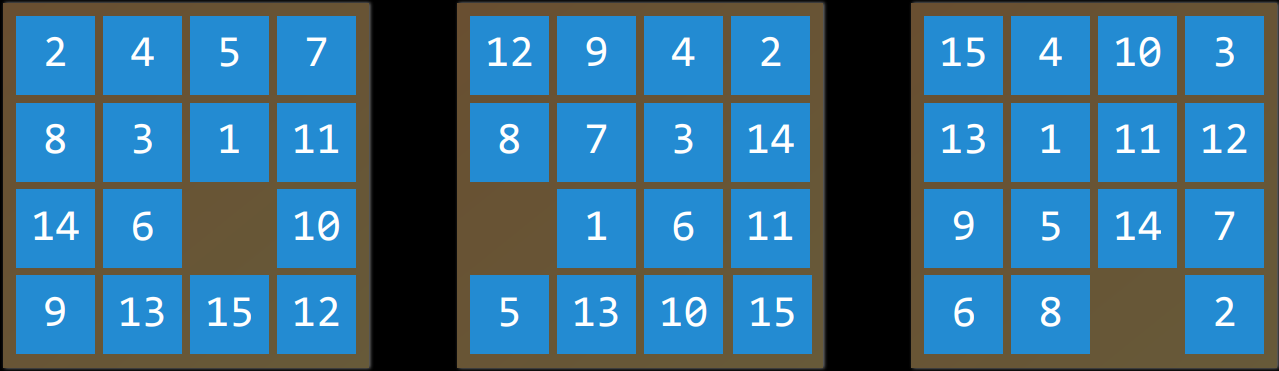

要找到一个数字华容道谜题的解决方案,需要使用搜索算法。

|

要找到一个数字华容道谜题的解决方案,需要使用搜索算法。

|

||||||

|

|

||||||

- 智能主体(Agent)

|

- 智能主体 (Agent)

|

||||||

|

|

||||||

- 感知其环境并对该环境采取行动的实体。

|

- 感知其环境并对该环境采取行动的实体。

|

||||||

- 例如,在导航应用程序中,智能主体将是一辆汽车的代表,它需要决定采取哪些行动才能到达目的地。

|

- 例如,在导航应用程序中,智能主体将是一辆汽车的代表,它需要决定采取哪些行动才能到达目的地。

|

||||||

- 状态(State)

|

- 状态 (State)

|

||||||

|

|

||||||

- 智能主体在其环境中的配置。

|

- 智能主体在其环境中的配置。

|

||||||

- 例如,在一个数字华容道谜题中,一个状态是所有数字排列在棋盘上的任何一种方式。

|

- 例如,在一个数字华容道谜题中,一个状态是所有数字排列在棋盘上的任何一种方式。

|

||||||

@@ -44,14 +46,14 @@

|

|||||||

|

|

||||||

|

|

||||||

|

|

||||||

- 动作(Action)

|

- 动作 (Action)

|

||||||

|

|

||||||

- 一个状态可以做出的选择。更确切地说,动作可以定义为一个函数。当接收到状态$s$作为输入时,$Actions(s)$将返回可在状态$s$ 中执行的一组操作作为输出。

|

- 一个状态可以做出的选择。更确切地说,动作可以定义为一个函数。当接收到状态$s$作为输入时,$Actions(s)$将返回可在状态$s$ 中执行的一组操作作为输出。

|

||||||

- 例如,在一个数字华容道中,给定状态的操作是您可以在当前配置中滑动方块的方式。

|

- 例如,在一个数字华容道中,给定状态的操作是您可以在当前配置中滑动方块的方式。

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

- 过渡模型(Transition Model)

|

- 过渡模型 (Transition Model)

|

||||||

|

|

||||||

- 对在任何状态下执行任何适用操作所产生的状态的描述。

|

- 对在任何状态下执行任何适用操作所产生的状态的描述。

|

||||||

- 更确切地说,过渡模型可以定义为一个函数。

|

- 更确切地说,过渡模型可以定义为一个函数。

|

||||||

@@ -60,29 +62,29 @@

|

|||||||

|

|

||||||

|

|

||||||

|

|

||||||

- 状态空间(State Space)

|

- 状态空间 (State Space)

|

||||||

|

|

||||||

- 通过一系列的操作目标从初始状态可达到的所有状态的集合。

|

- 通过一系列的操作目标从初始状态可达到的所有状态的集合。

|

||||||

- 例如,在一个数字华容道谜题中,状态空间由所有$\frac{16!}{2}$种配置,可以从任何初始状态达到。状态空间可以可视化为有向图,其中状态表示为节点,动作表示为节点之间的箭头。

|

- 例如,在一个数字华容道谜题中,状态空间由所有$\frac{16!}{2}$种配置,可以从任何初始状态达到。状态空间可以可视化为有向图,其中状态表示为节点,动作表示为节点之间的箭头。

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

- 目标测试(Goal Test)

|

- 目标测试 (Goal Test)

|

||||||

|

|

||||||

- 确定给定状态是否为目标状态的条件。例如,在导航应用程序中,目标测试将是智能主体的当前位置是否在目的地。如果是,问题解决了。如果不是,我们将继续搜索。

|

- 确定给定状态是否为目标状态的条件。例如,在导航应用程序中,目标测试将是智能主体的当前位置是否在目的地。如果是,问题解决了。如果不是,我们将继续搜索。

|

||||||

- 路径成本(Path Cost)

|

- 路径成本 (Path Cost)

|

||||||

|

|

||||||

- 完成给定路径相关的代价。例如,导航应用程序并不是简单地让你达到目标;它这样做的同时最大限度地减少了路径成本,为您找到了达到目标状态的最快方法。

|

- 完成给定路径相关的代价。例如,导航应用程序并不是简单地让你达到目标;它这样做的同时最大限度地减少了路径成本,为您找到了达到目标状态的最快方法。

|

||||||

|

|

||||||

# 解决搜索问题

|

## 解决搜索问题

|

||||||

|

|

||||||

- 解(solution)

|

- 解 (solution)

|

||||||

|

|

||||||

- 从初始状态到目标状态的一系列动作。

|

- 从初始状态到目标状态的一系列动作。

|

||||||

- 最优解(Optimal Solution)

|

- 最优解 (Optimal Solution)

|

||||||

|

|

||||||

- 在所有解决方案中路径成本最低的解决方案。

|

- 在所有解决方案中路径成本最低的解决方案。

|

||||||

- 在搜索过程中,数据通常存储在<strong>节点(Node)</strong> 中,节点是一种包含以下数据的数据结构:

|

- 在搜索过程中,数据通常存储在<strong>节点 (Node)</strong> 中,节点是一种包含以下数据的数据结构:

|

||||||

|

|

||||||

- 状态——state

|

- 状态——state

|

||||||

- 其父节点,通过该父节点生成当前节点——parent node

|

- 其父节点,通过该父节点生成当前节点——parent node

|

||||||

@@ -96,7 +98,7 @@

|

|||||||

|

|

||||||

一旦选择了节点,通过存储父节点和从父节点到当前节点的动作,就可以追溯从初始状态到该节点的每一步,而这一系列动作就是解决方案。

|

一旦选择了节点,通过存储父节点和从父节点到当前节点的动作,就可以追溯从初始状态到该节点的每一步,而这一系列动作就是解决方案。

|

||||||

|

|

||||||

- 然而,节点只是一个数据结构——它们不搜索,而是保存信息。为了实际搜索,我们使用了边域(frontier),即“管理”节点的机制。边域首先包含一个初始状态和一组空的已探索项目(探索集),然后重复以下操作,直到找到解决方案:

|

- 然而,节点只是一个数据结构——它们不搜索,而是保存信息。为了实际搜索,我们使用了边域 (frontier),即“管理”节点的机制。边域首先包含一个初始状态和一组空的已探索项目(探索集),然后重复以下操作,直到找到解决方案:

|

||||||

|

|

||||||

- 重复

|

- 重复

|

||||||

|

|

||||||

@@ -128,10 +130,10 @@ c. 到达目标节点,停止,返回解决方案

|

|||||||

|

|

||||||

会出现什么问题?节点 A-> 节点 B-> 节点 A->......-> 节点 A。我们需要一个探索集,记录已搜索的节点!

|

会出现什么问题?节点 A-> 节点 B-> 节点 A->......-> 节点 A。我们需要一个探索集,记录已搜索的节点!

|

||||||

|

|

||||||

## 不知情搜索(Uninformed Search)

|

### 不知情搜索 (Uninformed Search)

|

||||||

|

|

||||||

- 在之前对边域的描述中,有一件事没有被提及。在上面伪代码的第 1 阶段,应该删除哪个节点?这种选择对解决方案的质量和实现速度有影响。关于应该首先考虑哪些节点的问题,有多种方法,其中两种可以用堆栈(深度优先搜索)和队列(广度优先搜索)的数据结构来表示。

|

- 在之前对边域的描述中,有一件事没有被提及。在上面伪代码的第 1 阶段,应该删除哪个节点?这种选择对解决方案的质量和实现速度有影响。关于应该首先考虑哪些节点的问题,有多种方法,其中两种可以用堆栈(深度优先搜索)和队列(广度优先搜索)的数据结构来表示。

|

||||||

- 深度优先搜索(Depth-First Search)

|

- 深度优先搜索 (Depth-First Search)

|

||||||

|

|

||||||

- 深度优先搜索算法在尝试另一个方向之前耗尽每个方向。在这些情况下,边域作为堆栈数据结构进行管理。这里需要记住的流行语是“后进先出”。在将节点添加到边域后,第一个要删除和考虑的节点是最后一个要添加的节点。这导致了一种搜索算法,该算法在第一个方向上尽可能深入,直到尽头,同时将所有其他方向留到后面。“不撞南墙不回头”

|

- 深度优先搜索算法在尝试另一个方向之前耗尽每个方向。在这些情况下,边域作为堆栈数据结构进行管理。这里需要记住的流行语是“后进先出”。在将节点添加到边域后,第一个要删除和考虑的节点是最后一个要添加的节点。这导致了一种搜索算法,该算法在第一个方向上尽可能深入,直到尽头,同时将所有其他方向留到后面。“不撞南墙不回头”

|

||||||

- (一个例子:以你正在寻找钥匙的情况为例。在深度优先搜索方法中,如果你选择从裤子里搜索开始,你会先仔细检查每一个口袋,清空每个口袋,仔细检查里面的东西。只有当你完全筋疲力尽时,你才会停止在裤子里搜索,开始在其他地方搜索。)

|

- (一个例子:以你正在寻找钥匙的情况为例。在深度优先搜索方法中,如果你选择从裤子里搜索开始,你会先仔细检查每一个口袋,清空每个口袋,仔细检查里面的东西。只有当你完全筋疲力尽时,你才会停止在裤子里搜索,开始在其他地方搜索。)

|

||||||

@@ -151,7 +153,7 @@ c. 到达目标节点,停止,返回解决方案

|

|||||||

|

|

||||||

|

|

||||||

|

|

||||||

- 代码实现

|

- 代码实现

|

||||||

|

|

||||||

```python

|

```python

|

||||||

def remove(self):

|

def remove(self):

|

||||||

@@ -163,7 +165,7 @@ def remove(self):

|

|||||||

return node

|

return node

|

||||||

```

|

```

|

||||||

|

|

||||||

- 广度优先搜索(Breadth-First Search)

|

- 广度优先搜索 (Breadth-First Search)

|

||||||

|

|

||||||

- 广度优先搜索算法将同时遵循多个方向,在每个可能的方向上迈出一步,然后在每个方向上迈出第二步。在这种情况下,边域作为队列数据结构进行管理。这里需要记住的流行语是“先进先出”。在这种情况下,所有新节点都会排成一行,并根据先添加的节点来考虑节点(先到先得!)。这导致搜索算法在任何一个方向上迈出第二步之前,在每个可能的方向上迈出一步。

|

- 广度优先搜索算法将同时遵循多个方向,在每个可能的方向上迈出一步,然后在每个方向上迈出第二步。在这种情况下,边域作为队列数据结构进行管理。这里需要记住的流行语是“先进先出”。在这种情况下,所有新节点都会排成一行,并根据先添加的节点来考虑节点(先到先得!)。这导致搜索算法在任何一个方向上迈出第二步之前,在每个可能的方向上迈出一步。

|

||||||

- (一个例子:假设你正在寻找钥匙。在这种情况下,如果你从裤子开始,你会看你的右口袋。之后,你会在一个抽屉里看一眼,而不是看你的左口袋。然后在桌子上。以此类推,在你能想到的每个地方。只有在你用完所有位置后,你才会回到你的裤子上,在下一个口袋里找。)

|

- (一个例子:假设你正在寻找钥匙。在这种情况下,如果你从裤子开始,你会看你的右口袋。之后,你会在一个抽屉里看一眼,而不是看你的左口袋。然后在桌子上。以此类推,在你能想到的每个地方。只有在你用完所有位置后,你才会回到你的裤子上,在下一个口袋里找。)

|

||||||

@@ -183,7 +185,7 @@ def remove(self):

|

|||||||

|

|

||||||

|

|

||||||

|

|

||||||

- 代码实现

|

- 代码实现

|

||||||

|

|

||||||

```python

|

```python

|

||||||

def remove(self):

|

def remove(self):

|

||||||

@@ -195,13 +197,12 @@ def remove(self):

|

|||||||

return node

|

return node

|

||||||

```

|

```

|

||||||

|

|

||||||

## 知情搜索(Informed Search)

|

## 知情搜索 (Informed Search)

|

||||||

|

|

||||||

- 广度优先和深度优先都是不知情的搜索算法。也就是说,这些算法没有利用他们没有通过自己的探索获得的关于问题的任何知识。然而,大多数情况下,关于这个问题的一些知识实际上是可用的。例如,当人类进入一个路口时,人类可以看到哪条路沿着解决方案的大致方向前进,哪条路没有。人工智能也可以这样做。一种考虑额外知识以试图提高性能的算法被称为知情搜索算法。

|

- 广度优先和深度优先都是不知情的搜索算法。也就是说,这些算法没有利用他们没有通过自己的探索获得的关于问题的任何知识。然而,大多数情况下,关于这个问题的一些知识实际上是可用的。例如,当人类进入一个路口时,人类可以看到哪条路沿着解决方案的大致方向前进,哪条路没有。人工智能也可以这样做。一种考虑额外知识以试图提高性能的算法被称为知情搜索算法。

|

||||||

- 贪婪最佳优先搜索(Greedy Best-First Search)

|

- 贪婪最佳优先搜索 (Greedy Best-First Search)

|

||||||

|

|

||||||

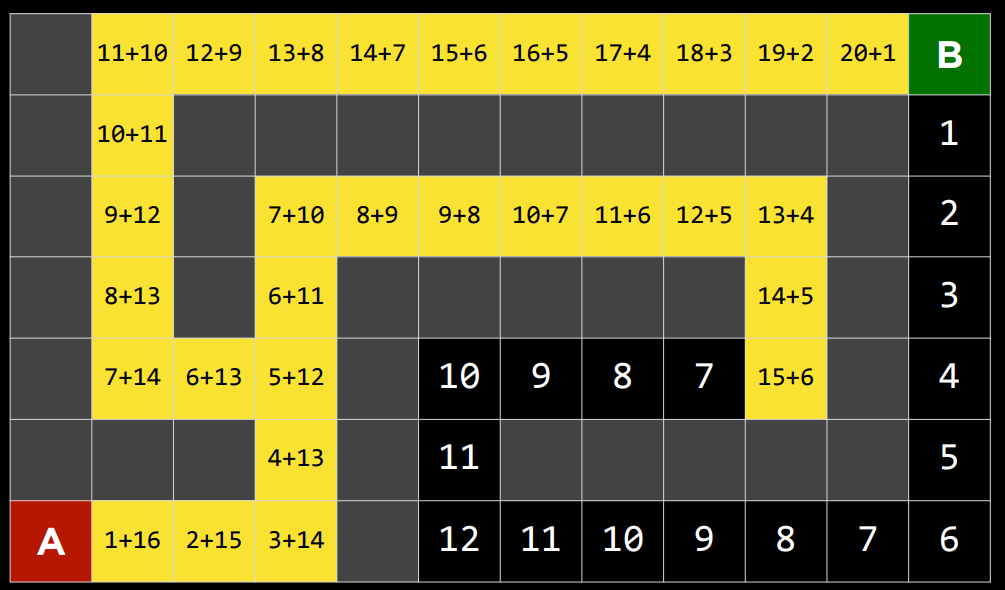

- 贪婪最佳优先搜索扩展最接近目标的节点,如启发式函数$h(n)$所确定的。顾名思义,该函数估计下一个节点离目标有多近,但可能会出错。贪婪最佳优先算法的效率取决于启发式函数的好坏。例如,在迷宫中,算法可以使用启发式函数,该函数依赖于可能节点和迷宫末端之间的曼哈顿距离。曼哈顿距离忽略了墙壁,并计算了从一个位置到目标位置需要向上、向下或向两侧走多少步。这是一个简单的估计,可以基于当前位置和目标位置的$(x,y)$坐标导出。

|

- 贪婪最佳优先搜索扩展最接近目标的节点,如启发式函数$h(n)$所确定的。顾名思义,该函数估计下一个节点离目标有多近,但可能会出错。贪婪最佳优先算法的效率取决于启发式函数的好坏。例如,在迷宫中,算法可以使用启发式函数,该函数依赖于可能节点和迷宫末端之间的曼哈顿距离。曼哈顿距离忽略了墙壁,并计算了从一个位置到目标位置需要向上、向下或向两侧走多少步。这是一个简单的估计,可以基于当前位置和目标位置的$(x,y)$坐标导出。

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

- 然而,重要的是要强调,与任何启发式算法一样,它可能会出错,并导致算法走上比其他情况下更慢的道路。不知情的搜索算法有可能更快地提供一个更好的解决方案,但它比知情算法更不可能这样。

|

- 然而,重要的是要强调,与任何启发式算法一样,它可能会出错,并导致算法走上比其他情况下更慢的道路。不知情的搜索算法有可能更快地提供一个更好的解决方案,但它比知情算法更不可能这样。

|

||||||

@@ -212,60 +213,57 @@ def remove(self):

|

|||||||

|

|

||||||

- $A^*$搜索

|

- $A^*$搜索

|

||||||

|

|

||||||

- 作为贪婪最佳优先算法的一种发展,$A^*$搜索不仅考虑了从当前位置到目标的估计成本$h(n)$,还考虑了直到当前位置为止累积的成本$g(n)$。通过组合这两个值,该算法可以更准确地确定解决方案的成本并在旅途中优化其选择。该算法跟踪(到目前为止的路径成本+到目标的估计成本,$g(n)+h(n)$),一旦它超过了之前某个选项的估计成本,该算法将放弃当前路径并返回到之前的选项,从而防止自己沿着$h(n)$错误地标记为最佳的却长而低效的路径前进。

|

- 作为贪婪最佳优先算法的一种发展,$A^*$搜索不仅考虑了从当前位置到目标的估计成本$h(n)$,还考虑了直到当前位置为止累积的成本$g(n)$。通过组合这两个值,该算法可以更准确地确定解决方案的成本并在旅途中优化其选择。该算法跟踪(到目前为止的路径成本 + 到目标的估计成本,$g(n)+h(n)$),一旦它超过了之前某个选项的估计成本,该算法将放弃当前路径并返回到之前的选项,从而防止自己沿着$h(n)$错误地标记为最佳的却长而低效的路径前进。

|

||||||

|

|

||||||

- 然而,由于这种算法也依赖于启发式,所以它依赖它所使用的启发式。在某些情况下,它可能比贪婪的最佳第一搜索甚至不知情的算法效率更低。对于最佳的$A^*$搜索,启发式函数$h(n)$应该:

|

- 然而,由于这种算法也依赖于启发式,所以它依赖它所使用的启发式。在某些情况下,它可能比贪婪的最佳第一搜索甚至不知情的算法效率更低。对于最佳的$A^*$搜索,启发式函数$h(n)$应该:

|

||||||

|

|

||||||

- 可接受,从未高估真实成本。

|

- 可接受,从未高估真实成本。

|

||||||

|

|

||||||

- 一致性,这意味着从新节点到目标的估计路径成本加上从先前节点转换到该新节点的成本应该大于或等于先前节点到目标的估计路径成本。用方程的形式表示,$h(n)$是一致的,如果对于每个节点n$和后续节点n'$,从n$到$n'$的步长为c$,满足$h(n)≤h(n')+c$。

|

- 一致性,这意味着从新节点到目标的估计路径成本加上从先前节点转换到该新节点的成本应该大于或等于先前节点到目标的估计路径成本。用方程的形式表示,$h(n)$是一致的,如果对于每个节点 n$和后续节点 n'$,从 n$到$n'$的步长为 c$,满足$h(n) ≤ h(n') + c$.

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

# 对抗性搜索

|

## 对抗性搜索

|

||||||

|

|

||||||

尽管之前我们讨论过需要找到问题答案的算法,但在对抗性搜索中,算法面对的是试图实现相反目标的对手。通常,在游戏中会遇到使用对抗性搜索的人工智能,比如井字游戏。

|

尽管之前我们讨论过需要找到问题答案的算法,但在对抗性搜索中,算法面对的是试图实现相反目标的对手。通常,在游戏中会遇到使用对抗性搜索的人工智能,比如井字游戏。

|

||||||

|

|

||||||

- 极大极小算法(Minimax)

|

- 极大极小算法 (Minimax)

|

||||||

|

|

||||||

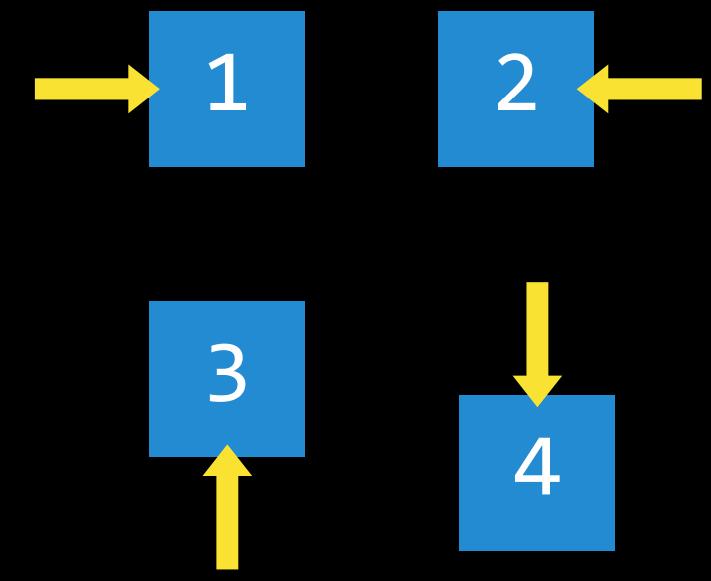

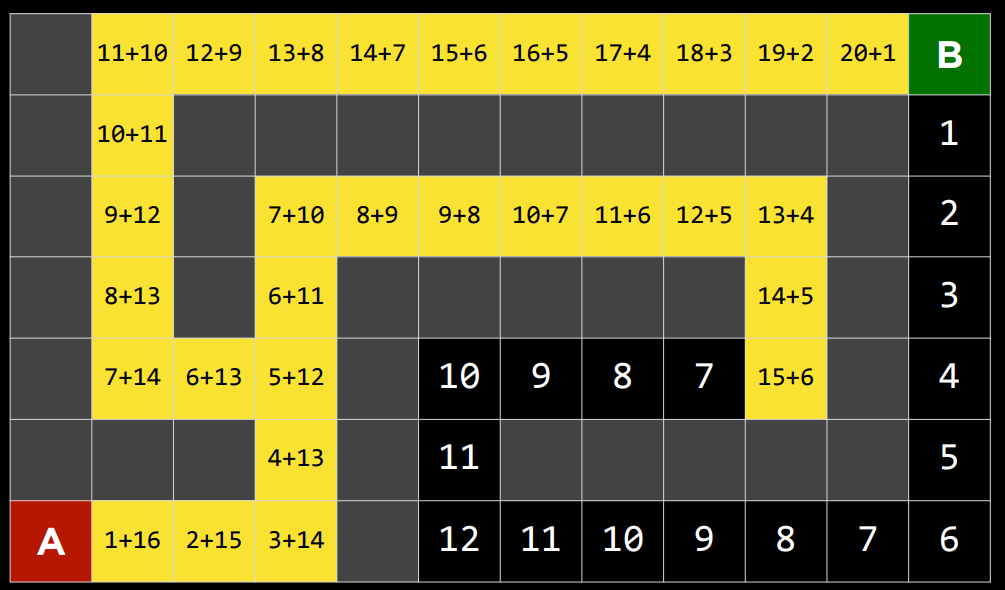

- 作为对抗性搜索中的一种算法,Minimax 将获胜条件表示为$(-1)$表示为一方,$(+1)$表示为另一方。进一步的行动将受到这些条件的驱动,最小化的一方试图获得最低分数,而最大化的一方则试图获得最高分数。

|

- 作为对抗性搜索中的一种算法,Minimax 将获胜条件表示为$(-1)$表示为一方,$(+1)$表示为另一方。进一步的行动将受到这些条件的驱动,最小化的一方试图获得最低分数,而最大化的一方则试图获得最高分数。

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

- 井字棋 AI 为例

|

- 井字棋 AI 为例

|

||||||

|

|

||||||

- $s_0$: 初始状态(在我们的情况下,是一个空的3X3棋盘)

|

- $s_0$: 初始状态(在我们的情况下,是一个空的 3X3 棋盘)

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

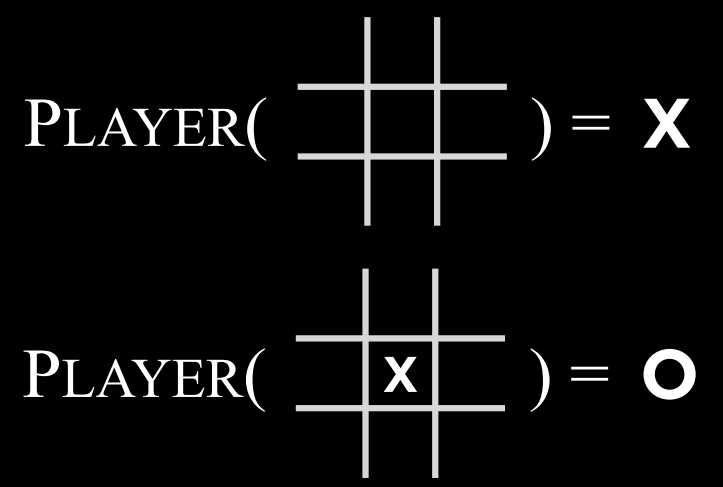

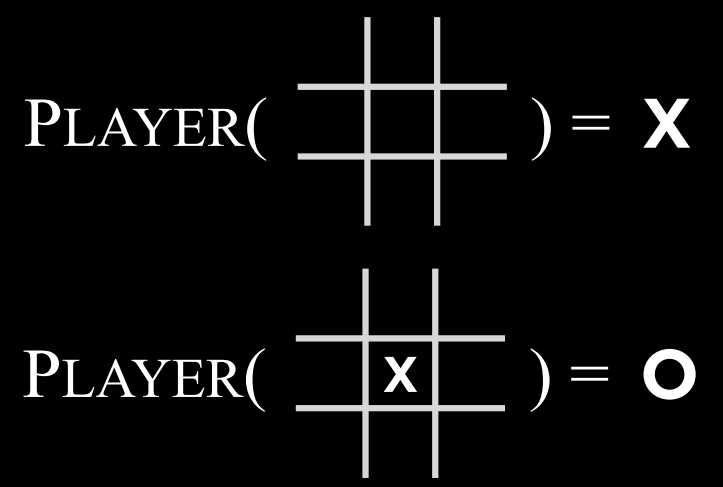

- $Players(s)$: 一个函数,在给定状态$$s$$的情况下,返回轮到哪个玩家(X或O)。

|

- $Players(s)$: 一个函数,在给定状态$$s$$的情况下,返回轮到哪个玩家(X 或 O)。

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

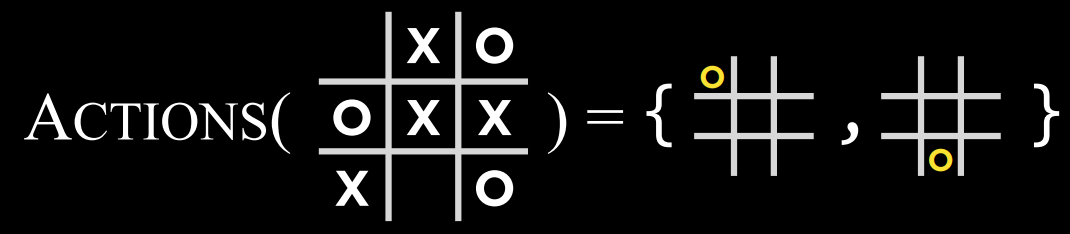

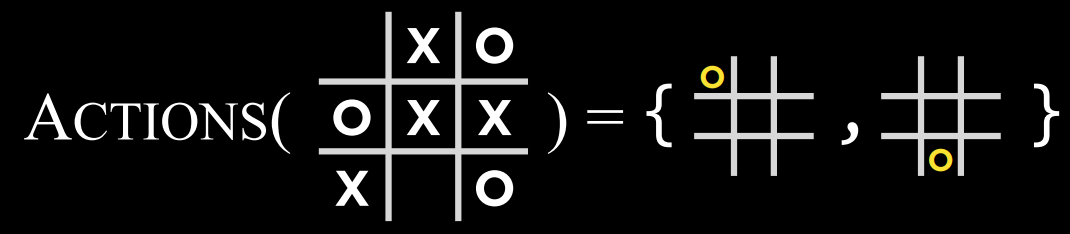

- $Actions(s)$: 一个函数,在给定状态$$s$$的情况下,返回该状态下的所有合法动作(棋盘上哪些位置是空的)。

|

- $Actions(s)$: 一个函数,在给定状态$$s$$的情况下,返回该状态下的所有合法动作(棋盘上哪些位置是空的)。

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

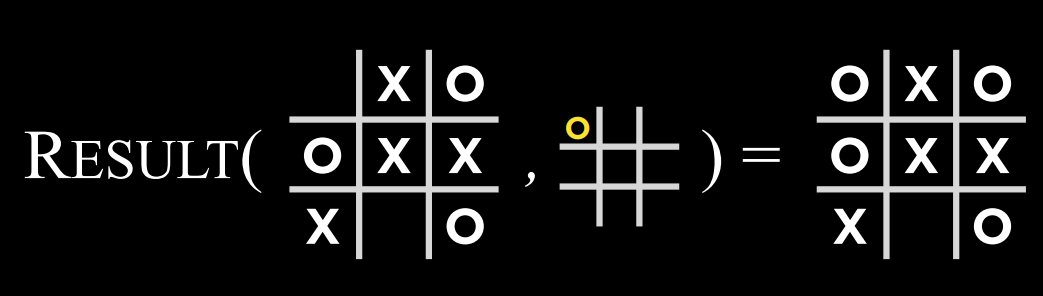

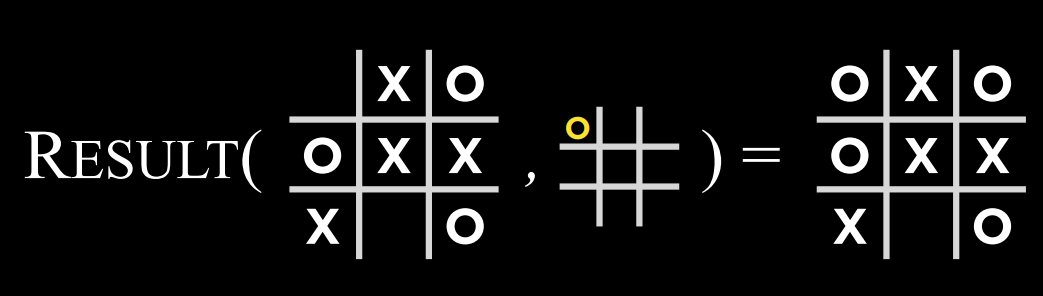

- $Result(s, a)$: 一个函数,在给定状态$$s$$和操作$$a$$的情况下,返回一个新状态。这是在状态$$s$$上执行动作$$a$$(在游戏中移动)所产生的棋盘。

|

- $Result(s, a)$: 一个函数,在给定状态$$s$$和操作$$a$$的情况下,返回一个新状态。这是在状态$$s$$上执行动作$$a$$(在游戏中移动)所产生的棋盘。

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

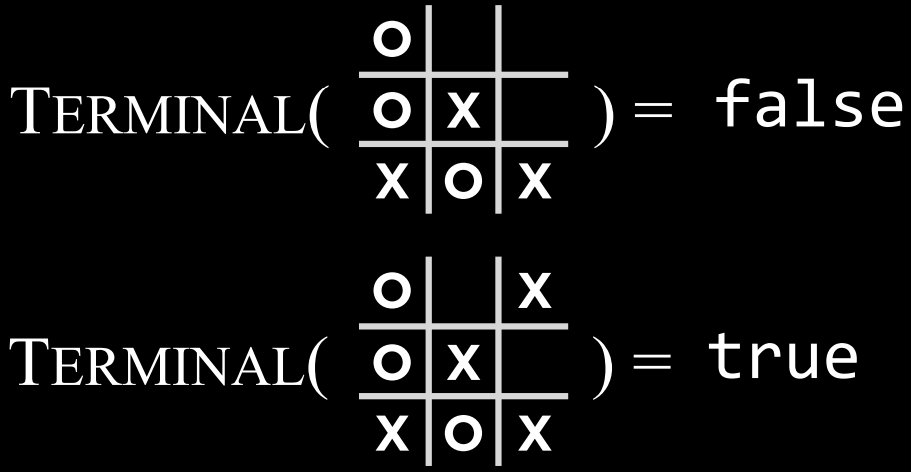

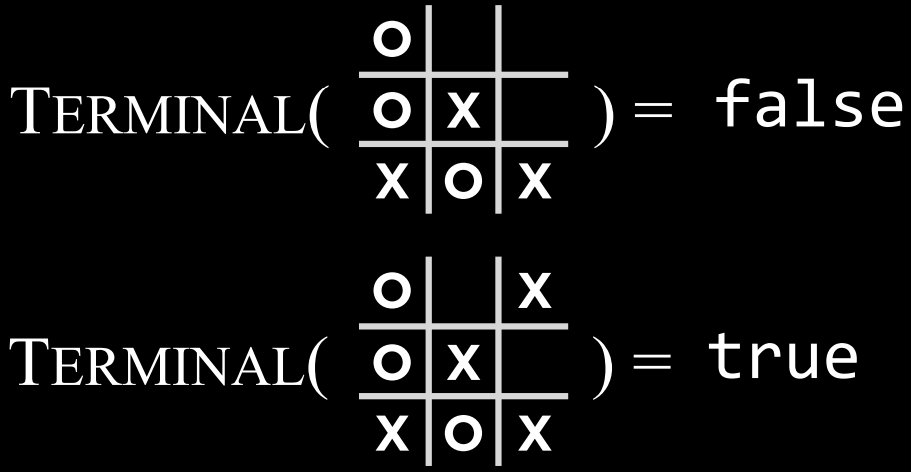

- $Terminal(s)$: 一个函数,在给定状态$$s$$的情况下,检查这是否是游戏的最后一步,即是否有人赢了或打成平手。如果游戏已结束,则返回True,否则返回False。

|

- $Terminal(s)$: 一个函数,在给定状态$$s$$的情况下,检查这是否是游戏的最后一步,即是否有人赢了或打成平手。如果游戏已结束,则返回 True,否则返回 False。

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

- $Utility(s)$: 一个函数,在给定终端状态s的情况下,返回状态的效用值:$$-1、0或1$$。

|

- $Utility(s)$: 一个函数,在给定终端状态 s 的情况下,返回状态的效用值:$$-1、0 或 1$$。

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

- 算法的工作原理:

|

- 算法的工作原理:

|

||||||

|

|

||||||

- 该算法递归地模拟从当前状态开始直到达到终端状态为止可能发生的所有游戏状态。每个终端状态的值为$(-1)$、$0$或$(+1)$。

|

- 该算法递归地模拟从当前状态开始直到达到终端状态为止可能发生的所有游戏状态。每个终端状态的值为$(-1)$、$0$或$(+1)$。

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

- 根据轮到谁的状态,算法可以知道当前玩家在最佳游戏时是否会选择导致状态值更低或更高的动作。

|

- 根据轮到谁的状态,算法可以知道当前玩家在最佳游戏时是否会选择导致状态值更低或更高的动作。

|

||||||

@@ -302,17 +300,17 @@ def remove(self):

|

|||||||

- $$v = Min(v, Max-Value(Result(state, action)))$$

|

- $$v = Min(v, Max-Value(Result(state, action)))$$

|

||||||

- return $v$

|

- return $v$

|

||||||

|

|

||||||

不会理解递归?也许你需要看看这个:[阶段二:递归操作](../3.%E7%BC%96%E7%A8%8B%E6%80%9D%E7%BB%B4%E4%BD%93%E7%B3%BB%E6%9E%84%E5%BB%BA/3.6.4.2%E9%98%B6%E6%AE%B5%E4%BA%8C%EF%BC%9A%E9%80%92%E5%BD%92%E6%93%8D%E4%BD%9C.md)

|

不会理解递归?也许你需要看看这个:[阶段二:递归操作](../3.%E7%BC%96%E7%A8%8B%E6%80%9D%E7%BB%B4%E4%BD%93%E7%B3%BB%E6%9E%84%E5%BB%BA/3.6.4.2%E9%98%B6%E6%AE%B5%E4%BA%8C%EF%BC%9A%E9%80%92%E5%BD%92%E6%93%8D%E4%BD%9C.md)

|

||||||

|

|

||||||

- $\alpha$-$\beta$剪枝(Alpha-Beta Pruning)

|

- $\alpha$-$\beta$剪枝 (Alpha-Beta Pruning)

|

||||||

|

|

||||||

- 作为一种优化Minimax的方法,Alpha-Beta剪枝跳过了一些明显不利的递归计算。在确定了一个动作的价值后,如果有初步证据表明接下来的动作可以让对手获得比已经确定的动作更好的分数,那么就没有必要进一步调查这个动作,因为它肯定比之前确定的动作不利。

|

- 作为一种优化 Minimax 的方法,Alpha-Beta 剪枝跳过了一些明显不利的递归计算。在确定了一个动作的价值后,如果有初步证据表明接下来的动作可以让对手获得比已经确定的动作更好的分数,那么就没有必要进一步调查这个动作,因为它肯定比之前确定的动作不利。

|

||||||

|

|

||||||

- 这一点最容易用一个例子来说明:最大化的玩家知道,在下一步,最小化的玩家将试图获得最低分数。假设最大化玩家有三个可能的动作,第一个动作的值为4。然后玩家开始为下一个动作生成值。要做到这一点,如果当前玩家做出这个动作,玩家会生成最小化者动作的值,并且知道最小化者会选择最低的一个。然而,在完成最小化器所有可能动作的计算之前,玩家会看到其中一个选项的值为3。这意味着没有理由继续探索最小化玩家的其他可能行动。尚未赋值的动作的值无关紧要,无论是10还是(-10)。如果该值为10,则最小化器将选择最低选项3,该选项已经比预先设定的4差。如果尚未估价的行动结果是(-10),那么最小化者将选择(-10)这一选项,这对最大化者来说更加不利。因此,在这一点上为最小化者计算额外的可能动作与最大化者无关,因为最大化玩家已经有了一个明确的更好的选择,其值为4。

|

- 这一点最容易用一个例子来说明:最大化的玩家知道,在下一步,最小化的玩家将试图获得最低分数。假设最大化玩家有三个可能的动作,第一个动作的值为 4。然后玩家开始为下一个动作生成值。要做到这一点,如果当前玩家做出这个动作,玩家会生成最小化者动作的值,并且知道最小化者会选择最低的一个。然而,在完成最小化器所有可能动作的计算之前,玩家会看到其中一个选项的值为 3。这意味着没有理由继续探索最小化玩家的其他可能行动。尚未赋值的动作的值无关紧要,无论是 10 还是(-10)。如果该值为 10,则最小化器将选择最低选项 3,该选项已经比预先设定的 4 差。如果尚未估价的行动结果是(-10),那么最小化者将选择(-10)这一选项,这对最大化者来说更加不利。因此,在这一点上为最小化者计算额外的可能动作与最大化者无关,因为最大化玩家已经有了一个明确的更好的选择,其值为 4。

|

||||||

|

|

||||||

|

|

||||||

|

|

||||||

- 深度限制的极大极小算法(Depth-Limited Minimax)

|

- 深度限制的极大极小算法 (Depth-Limited Minimax)

|

||||||

|

|

||||||

- 总共有$255168$个可能的井字棋游戏,以及有$10^{29000}$个可能的国际象棋中游戏。到目前为止,最小最大算法需要生成从某个点到<strong>终端条件</strong>的所有假设游戏状态。虽然计算所有的井字棋游戏状态对现代计算机来说并不是一个挑战,但目前用来计算国际象棋是不可能的。

|

- 总共有$255168$个可能的井字棋游戏,以及有$10^{29000}$个可能的国际象棋中游戏。到目前为止,最小最大算法需要生成从某个点到<strong>终端条件</strong>的所有假设游戏状态。虽然计算所有的井字棋游戏状态对现代计算机来说并不是一个挑战,但目前用来计算国际象棋是不可能的。

|

||||||

|

|

||||||

|

|||||||

@@ -1,4 +1,5 @@

|

|||||||

# 程序示例——命题逻辑与模型检测

|

# 程序示例——命题逻辑与模型检测

|

||||||

|

|

||||||

::: warning 😋

|

::: warning 😋

|

||||||

阅读程序中涉及命题逻辑的部分,然后“玩一玩”程序!

|

阅读程序中涉及命题逻辑的部分,然后“玩一玩”程序!

|

||||||

|

|

||||||

@@ -8,7 +9,8 @@

|

|||||||

::: tip 📥

|

::: tip 📥

|

||||||

本节附件下载 <Download url="https://cdn.xyxsw.site/code/2-Lecture.zip"/>

|

本节附件下载 <Download url="https://cdn.xyxsw.site/code/2-Lecture.zip"/>

|

||||||

:::

|

:::

|

||||||

# Sentence——父类

|

|

||||||

|

## Sentence——父类

|

||||||

|

|

||||||

```python

|

```python

|

||||||

class Sentence(): # 父类

|

class Sentence(): # 父类

|

||||||

@@ -21,12 +23,12 @@ class Sentence(): # 父类

|

|||||||

def symbols(self):

|

def symbols(self):

|

||||||

"""返回逻辑表达式中所有命题符号的集合。"""

|

"""返回逻辑表达式中所有命题符号的集合。"""

|

||||||

return set()

|

return set()

|

||||||

@classmethod # @classmethod装饰器 使得类方法可以在类上被调用 Sentence.validate(...)

|

@classmethod # @classmethod 装饰器 使得类方法可以在类上被调用 Sentence.validate(...)

|

||||||

def validate(cls, sentence):

|

def validate(cls, sentence):

|

||||||

"""验证操作数是否是Sentence或其子类"""

|

"""验证操作数是否是 Sentence 或其子类"""

|

||||||

if not isinstance(sentence, Sentence):

|

if not isinstance(sentence, Sentence):

|

||||||

raise TypeError("must be a logical sentence")

|

raise TypeError("must be a logical sentence")

|

||||||

@classmethod # @classmethod装饰器 使得类方法可以在类上被调用 Sentence.parenthesize(...)

|

@classmethod # @classmethod 装饰器 使得类方法可以在类上被调用 Sentence.parenthesize(...)

|

||||||

def parenthesize(cls, s):

|

def parenthesize(cls, s):

|

||||||

"""如果表达式尚未加圆括号,则加圆括号。"""

|

"""如果表达式尚未加圆括号,则加圆括号。"""

|

||||||

def balanced(s):

|

def balanced(s):

|

||||||

@@ -46,7 +48,7 @@ class Sentence(): # 父类

|

|||||||

return f"({s})"

|

return f"({s})"

|

||||||

```

|

```

|

||||||

|

|

||||||

# Symbol——命题符号类

|

## Symbol——命题符号类

|

||||||

|

|

||||||

```python

|

```python

|

||||||

class Symbol(Sentence):

|

class Symbol(Sentence):

|

||||||

@@ -71,12 +73,12 @@ class Symbol(Sentence):

|

|||||||

return {self.name}

|

return {self.name}

|

||||||

```

|

```

|

||||||

|

|

||||||

# Not——逻辑非类

|

## Not——逻辑非类

|

||||||

|

|

||||||

```python

|

```python

|

||||||

class Not(Sentence):

|

class Not(Sentence):

|

||||||

def __init__(self, operand):

|

def __init__(self, operand):

|

||||||

"""验证操作数是否是Sentence或其子类"""

|

"""验证操作数是否是 Sentence 或其子类"""

|

||||||

Sentence.validate(operand)

|

Sentence.validate(operand)

|

||||||

self.operand = operand

|

self.operand = operand

|

||||||

def __eq__(self, other):

|

def __eq__(self, other):

|

||||||

@@ -94,13 +96,13 @@ class Not(Sentence):

|

|||||||

return self.operand.symbols()

|

return self.operand.symbols()

|

||||||

```

|

```

|

||||||

|

|

||||||

# And——逻辑乘类

|

## And——逻辑乘类

|

||||||

|

|

||||||

```python

|

```python

|

||||||

class And(Sentence):

|

class And(Sentence):

|

||||||

def __init__(self, *conjuncts):

|

def __init__(self, *conjuncts):

|

||||||

for conjunct in conjuncts:

|

for conjunct in conjuncts:

|

||||||

"""验证操作数是否是Sentence或其子类"""

|

"""验证操作数是否是 Sentence 或其子类"""

|

||||||

Sentence.validate(conjunct)

|

Sentence.validate(conjunct)

|

||||||

self.conjuncts = list(conjuncts)

|

self.conjuncts = list(conjuncts)

|

||||||

def __eq__(self, other):

|

def __eq__(self, other):

|

||||||

@@ -124,13 +126,13 @@ class And(Sentence):

|

|||||||

return set.union(*[conjunct.symbols() for conjunct in self.conjuncts])

|

return set.union(*[conjunct.symbols() for conjunct in self.conjuncts])

|

||||||

```

|

```

|

||||||

|

|

||||||

# Or——逻辑和类

|

## Or——逻辑和类

|

||||||

|

|

||||||

```python

|

```python

|

||||||

class Or(Sentence):

|

class Or(Sentence):

|

||||||

def __init__(self, *disjuncts):

|

def __init__(self, *disjuncts):

|

||||||

for disjunct in disjuncts:

|

for disjunct in disjuncts:

|

||||||

"""验证操作数是否是Sentence或其子类"""

|

"""验证操作数是否是 Sentence 或其子类"""

|

||||||

Sentence.validate(disjunct)

|

Sentence.validate(disjunct)

|

||||||

self.disjuncts = list(disjuncts)

|

self.disjuncts = list(disjuncts)

|

||||||

def __eq__(self, other):

|

def __eq__(self, other):

|

||||||

@@ -151,12 +153,12 @@ class Or(Sentence):

|

|||||||

return set.union(*[disjunct.symbols() for disjunct in self.disjuncts])

|

return set.union(*[disjunct.symbols() for disjunct in self.disjuncts])

|

||||||

```

|

```

|

||||||

|

|

||||||

# Implication——逻辑蕴含类

|

## Implication——逻辑蕴含类

|

||||||

|

|

||||||

```python

|

```python

|

||||||

class Implication(Sentence):

|

class Implication(Sentence):

|

||||||

def __init__(self, antecedent, consequent):

|

def __init__(self, antecedent, consequent):

|

||||||

"""验证操作数是否是Sentence或其子类"""

|

"""验证操作数是否是 Sentence 或其子类"""

|

||||||

Sentence.validate(antecedent)

|

Sentence.validate(antecedent)

|

||||||

Sentence.validate(consequent)

|

Sentence.validate(consequent)

|

||||||

"""前件"""

|

"""前件"""

|

||||||

@@ -183,12 +185,12 @@ class Implication(Sentence):

|

|||||||

return set.union(self.antecedent.symbols(), self.consequent.symbols())

|

return set.union(self.antecedent.symbols(), self.consequent.symbols())

|

||||||

```

|

```

|

||||||

|

|

||||||

# Biconditional——逻辑等值类

|

## Biconditional——逻辑等值类

|

||||||

|

|

||||||

```python

|

```python

|

||||||

class Biconditional(Sentence):

|

class Biconditional(Sentence):

|

||||||

def __init__(self, left, right):

|

def __init__(self, left, right):

|

||||||

"""验证操作数是否是Sentence或其子类"""

|

"""验证操作数是否是 Sentence 或其子类"""

|

||||||

Sentence.validate(left)

|

Sentence.validate(left)

|

||||||

Sentence.validate(right)

|

Sentence.validate(right)

|

||||||

self.left = left

|

self.left = left

|

||||||

@@ -215,7 +217,7 @@ class Biconditional(Sentence):

|

|||||||

return set.union(self.left.symbols(), self.right.symbols())

|

return set.union(self.left.symbols(), self.right.symbols())

|

||||||

```

|

```

|

||||||

|

|

||||||

# Model_check()——模型检测算法

|

## Model_check()——模型检测算法

|

||||||

|

|

||||||

```python

|

```python

|

||||||

def model_check(knowledge, query):

|

def model_check(knowledge, query):

|

||||||

@@ -234,7 +236,7 @@ def model_check(knowledge, query):

|

|||||||

def check_all(knowledge, query, symbols, model):

|

def check_all(knowledge, query, symbols, model):

|

||||||

"""检查给定特定模型的知识库是否推理蕴含查询结论。"""

|

"""检查给定特定模型的知识库是否推理蕴含查询结论。"""

|

||||||

# 如果模型已经为所有的命题符号赋值

|

# 如果模型已经为所有的命题符号赋值

|

||||||

if not symbols: # symbols为空即所有 symbols都在模型中被赋值

|

if not symbols: # symbols 为空即所有 symbols 都在模型中被赋值

|

||||||

# 若模型中的知识库为真,则查询结论也必须为真

|

# 若模型中的知识库为真,则查询结论也必须为真

|

||||||

if knowledge.evaluate(model):

|

if knowledge.evaluate(model):

|

||||||

return query.evaluate(model)

|

return query.evaluate(model)

|

||||||

@@ -244,10 +246,10 @@ def model_check(knowledge, query):

|

|||||||

# 选择其余未使用的命题符号之一

|

# 选择其余未使用的命题符号之一

|

||||||

remaining = symbols.copy()

|

remaining = symbols.copy()

|

||||||

p = remaining.pop()

|

p = remaining.pop()

|

||||||

# 创建一个命题符号为true的模型

|

# 创建一个命题符号为 true 的模型

|

||||||

model_true = model.copy()

|

model_true = model.copy()

|

||||||

model_true[p] = True

|

model_true[p] = True

|

||||||

# 创建一个命题符号为false的模型

|

# 创建一个命题符号为 false 的模型

|

||||||

model_false = model.copy()

|

model_false = model.copy()

|

||||||

model_false[p] = False

|

model_false[p] = False

|

||||||

# 确保在两种模型中都进行蕴含推理

|

# 确保在两种模型中都进行蕴含推理

|

||||||

@@ -259,7 +261,7 @@ def model_check(knowledge, query):

|

|||||||

return check_all(knowledge, query, symbols, dict())

|

return check_all(knowledge, query, symbols, dict())

|

||||||

```

|

```

|

||||||

|

|

||||||

# 线索游戏

|

## 线索游戏

|

||||||

|

|

||||||

在游戏中,一个人在某个地点使用工具实施了谋杀。人、工具和地点用卡片表示。每个类别的一张卡片被随机挑选出来,放在一个信封里,由参与者来揭开真相。参与者通过揭开卡片并从这些线索中推断出信封里必须有什么来做到这一点。我们将使用之前的模型检查算法来揭开这个谜团。在我们的模型中,我们将已知与谋杀有关的项目标记为 True,否则标记为 False。

|

在游戏中,一个人在某个地点使用工具实施了谋杀。人、工具和地点用卡片表示。每个类别的一张卡片被随机挑选出来,放在一个信封里,由参与者来揭开真相。参与者通过揭开卡片并从这些线索中推断出信封里必须有什么来做到这一点。我们将使用之前的模型检查算法来揭开这个谜团。在我们的模型中,我们将已知与谋杀有关的项目标记为 True,否则标记为 False。

|

||||||

|

|

||||||

@@ -287,7 +289,7 @@ def check_knowledge(knowledge):

|

|||||||

if model_check(knowledge, symbol):

|

if model_check(knowledge, symbol):

|

||||||

termcolor.cprint(f"{symbol}: YES", "green")

|

termcolor.cprint(f"{symbol}: YES", "green")

|

||||||

elif not model_check(knowledge, Not(symbol)):

|

elif not model_check(knowledge, Not(symbol)):

|

||||||

# 模型检测无法确定知识库可以得出 Not(symbol) 即 symbol是可能的

|

# 模型检测无法确定知识库可以得出 Not(symbol) 即 symbol 是可能的

|

||||||

print(f"{symbol}: MAYBE")

|

print(f"{symbol}: MAYBE")

|

||||||

else:

|

else:

|

||||||

termcolor.cprint(f"{symbol}: No", "red")

|

termcolor.cprint(f"{symbol}: No", "red")

|

||||||

@@ -311,7 +313,7 @@ knowledge.add(Not(ballroom))

|

|||||||

check_knowledge(knowledge)

|

check_knowledge(knowledge)

|

||||||

```

|

```

|

||||||

|

|

||||||

# Mastermind 游戏

|

## Mastermind 游戏

|

||||||

|

|

||||||

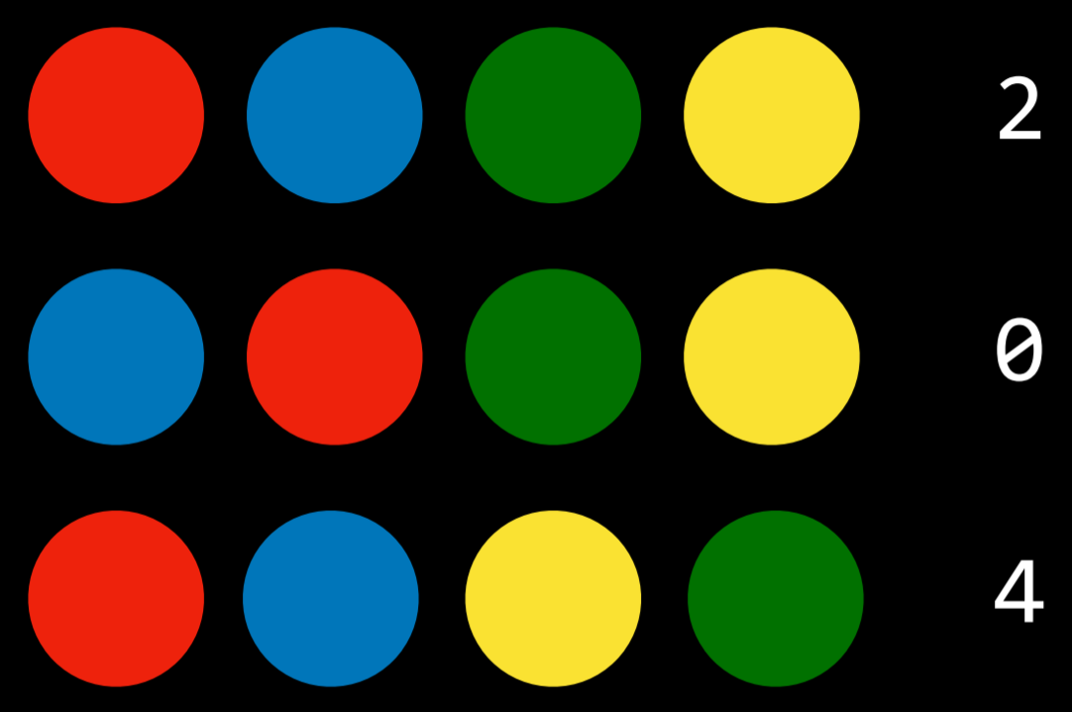

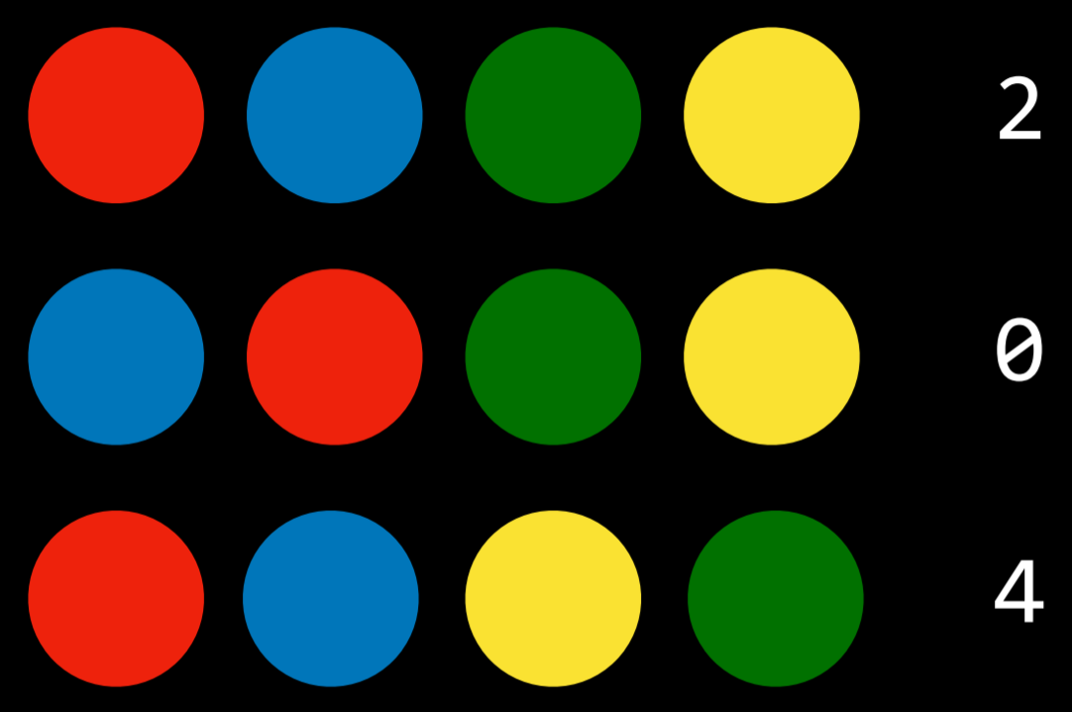

在这个游戏中,玩家一按照一定的顺序排列颜色,然后玩家二必须猜测这个顺序。每一轮,玩家二进行猜测,玩家一返回一个数字,指示玩家二正确选择了多少颜色。让我们用四种颜色模拟一个游戏。假设玩家二猜测以下顺序:

|

在这个游戏中,玩家一按照一定的顺序排列颜色,然后玩家二必须猜测这个顺序。每一轮,玩家二进行猜测,玩家一返回一个数字,指示玩家二正确选择了多少颜色。让我们用四种颜色模拟一个游戏。假设玩家二猜测以下顺序:

|

||||||

|

|

||||||

@@ -325,7 +327,7 @@ check_knowledge(knowledge)

|

|||||||

|

|

||||||

|

|

||||||

|

|

||||||

在命题逻辑中表示这一点需要我们有(颜色的数量)$^2$个原子命题。所以,在四种颜色的情况下,我们会有命题 red0,red1,red2,red3,blue0…代表颜色和位置。下一步是用命题逻辑表示游戏规则(每个位置只有一种颜色,没有颜色重复),并将它们添加到知识库中。最后一步是将我们所拥有的所有线索添加到知识库中。在我们的案例中,我们会补充说,在第一次猜测中,两个位置是错误的,两个是正确的,而在第二次猜测中没有一个是对的。利用这些知识,模型检查算法可以为我们提供难题的解决方案。

|

在命题逻辑中表示这一点需要我们有 (颜色的数量)$^2$个原子命题。所以,在四种颜色的情况下,我们会有命题 red0,red1,red2,red3,blue0…代表颜色和位置。下一步是用命题逻辑表示游戏规则(每个位置只有一种颜色,没有颜色重复),并将它们添加到知识库中。最后一步是将我们所拥有的所有线索添加到知识库中。在我们的案例中,我们会补充说,在第一次猜测中,两个位置是错误的,两个是正确的,而在第二次猜测中没有一个是对的。利用这些知识,模型检查算法可以为我们提供难题的解决方案。

|

||||||

|

|

||||||

```python

|

```python

|

||||||

from logic import *

|

from logic import *

|

||||||

@@ -379,9 +381,9 @@ for symbol in symbols:

|

|||||||

print(symbol)

|

print(symbol)

|

||||||

```

|

```

|

||||||

|

|

||||||

# Quiz

|

## Quiz

|

||||||

|

|

||||||

1. 下面的问题将问你关于以下逻辑句子的问题。 1.如果 Hermione 在图书馆,那么 Harry 在图书馆。 2.Hermione 在图书馆里。 3.Ron 在图书馆,Ron 不在图书馆。 4.Harry 在图书馆。 5.Harry 不在图书馆,或者 Hermione 在图书馆。 6.Rom 在图书馆,或者 Hermione 在图书馆。

|

1. 下面的问题将问你关于以下逻辑句子的问题。1.如果 Hermione 在图书馆,那么 Harry 在图书馆。2.Hermione 在图书馆里。3.Ron 在图书馆,Ron 不在图书馆。4.Harry 在图书馆。5.Harry 不在图书馆,或者 Hermione 在图书馆。6.Rom 在图书馆,或者 Hermione 在图书馆。

|

||||||

|

|

||||||

以下哪一个逻辑蕴含推理是正确的?

|

以下哪一个逻辑蕴含推理是正确的?

|

||||||

|

|

||||||

@@ -395,21 +397,21 @@ for symbol in symbols:

|

|||||||

2. 除了讲义上讨论的连接词之外,还有其他的逻辑连接词。其中最常见的是“异或”(用符号$\oplus$表示)。表达式$A\oplus B$表示句子“A 或 B,但不是两者都有。”以下哪一个在逻辑上等同于$A\oplus B$?

|

2. 除了讲义上讨论的连接词之外,还有其他的逻辑连接词。其中最常见的是“异或”(用符号$\oplus$表示)。表达式$A\oplus B$表示句子“A 或 B,但不是两者都有。”以下哪一个在逻辑上等同于$A\oplus B$?

|

||||||

1. $(A ∨ B) ∧ ¬ (A ∨ B)$

|

1. $(A ∨ B) ∧ ¬ (A ∨ B)$

|

||||||

2. $(A ∨ B) ∧ (A ∧ B)$

|

2. $(A ∨ B) ∧ (A ∧ B)$

|

||||||

3. $(A ∨ B) ∧ ¬ (A ∧ B)$

|

3. $(A ∨ B) ∧ ¬ (A ∧ B)$

|

||||||

4. $(A ∧ B) ∨ ¬ (A ∨ B)$

|

4. $(A ∧ B) ∨ ¬ (A ∨ B)$

|

||||||

|

|

||||||

3. 设命题变量$R$为“今天下雨”,变量$C$为“今天多云”,变量$S$ 为“今天晴”。下面哪一个是“如果今天下雨,那么今天多云但不是晴天”这句话的命题逻辑表示?

|

3. 设命题变量$R$为“今天下雨”,变量$C$为“今天多云”,变量$S$ 为“今天晴”。下面哪一个是“如果今天下雨,那么今天多云但不是晴天”这句话的命题逻辑表示?

|

||||||

|

|

||||||

1. $(R → C) ∧ ¬S$

|

1. $(R → C) ∧ ¬S$

|

||||||

2. $R → C → ¬S$

|

2. $R → C → ¬S$

|

||||||

3. $R ∧ C ∧ ¬S$

|

3. $R ∧ C ∧ ¬S$

|

||||||

4. $R → (C ∧ ¬S)$

|

4. $R → (C ∧ ¬S)$

|

||||||

5. $(C ∨ ¬S) → R$

|

5. $(C ∨ ¬S) → R$

|

||||||

|

|

||||||

4. 在一阶逻辑中,考虑以下谓词符号。$Student(x)$表示“x 是学生”的谓词。$Course(x)$代表“x 是课程”的谓词,$Enrolled(x,y)$表示“x 注册了 y”的谓词以下哪一项是“有一门课程是 Harry 和 Hermione 都注册的”这句话的一阶逻辑翻译?

|

4. 在一阶逻辑中,考虑以下谓词符号。$Student(x)$表示“x 是学生”的谓词。$Course(x)$代表“x 是课程”的谓词,$Enrolled(x,y)$表示“x 注册了 y”的谓词以下哪一项是“有一门课程是 Harry 和 Hermione 都注册的”这句话的一阶逻辑翻译?

|

||||||

1. $∀x(Course(x)∧Enrolled(Harry, x) ∧ Enrolled(Hermione, x))$

|

1. $∀x(Course(x)∧Enrolled(Harry, x) ∧ Enrolled(Hermione, x))$

|

||||||

2. $∀x(Enrolled(Harry, x) ∨ Enrolled(Hermione, x))$

|

2. $∀x(Enrolled(Harry, x) ∨ Enrolled(Hermione, x))$

|

||||||

3. $∀x(Enrolled(Harry, x) ∧ ∀y Enrolled(Hermione, y))$

|

3. $∀x(Enrolled(Harry, x) ∧ ∀y Enrolled(Hermione, y))$

|

||||||

4. $∃xEnrolled(Harry, x) ∧ ∃y Enrolled(Hermione, y)$

|

4. $∃xEnrolled(Harry, x) ∧ ∃y Enrolled(Hermione, y)$

|

||||||

5. $∃x(Course(x) ∧ Enrolled(Harry, x) ∧ Enrolled(Hermione, x))$

|

5. $∃x(Course(x) ∧ Enrolled(Harry, x) ∧ Enrolled(Hermione, x))$

|

||||||

6. $∃x(Enrolled(Harry, x) ∨ Enrolled(Hermione, x))$

|

6. $∃x(Enrolled(Harry, x) ∨ Enrolled(Hermione, x))$

|

||||||

|

|||||||

@@ -1,8 +1,9 @@

|

|||||||

# 项目:扫雷,骑士与流氓问题

|

# 项目:扫雷,骑士与流氓问题

|

||||||

|

|

||||||

我们为你提供了两个简单有趣的项目,帮助你进行知识巩固,请认真阅读文档内容。

|

::: warning 😋 我们为你提供了两个简单有趣的项目,帮助你进行知识巩固,请认真阅读文档内容。

|

||||||

|

|

||||||

如果你卡住了,请记得回来阅读文档,或请求身边人的帮助。

|

如果你卡住了,请记得回来阅读文档,或请求身边人的帮助。

|

||||||

|

:::

|

||||||

|

|

||||||

::: tip 📥

|

::: tip 📥

|

||||||

本节附件下载 <Download url="https://cdn.xyxsw.site/code/2-Projects.zip"/>

|

本节附件下载 <Download url="https://cdn.xyxsw.site/code/2-Projects.zip"/>

|

||||||

@@ -10,9 +11,9 @@

|

|||||||

|

|

||||||

`pip3 install -r requirements.txt`

|

`pip3 install -r requirements.txt`

|

||||||

|

|

||||||

# 骑士与流氓问题

|

## 骑士与流氓问题

|

||||||

|

|

||||||

## 背景

|

### 背景

|

||||||

|

|

||||||

- 在 1978 年,逻辑学家雷蒙德·斯穆里安(Raymond Smullyan)出版了《这本书叫什么名字?》,这是一本逻辑难题的书。在书中的谜题中,有一类谜题被斯穆里安称为“骑士与流氓”谜题。

|

- 在 1978 年,逻辑学家雷蒙德·斯穆里安(Raymond Smullyan)出版了《这本书叫什么名字?》,这是一本逻辑难题的书。在书中的谜题中,有一类谜题被斯穆里安称为“骑士与流氓”谜题。

|

||||||

- 在骑士与流氓谜题中,给出了以下信息:每个角色要么是骑士,要么是流氓。骑士总是会说实话:如果骑士陈述了一句话,那么这句话就是真的。相反,流氓总是说谎:如果流氓陈述了一个句子,那么这个句子就是假的。

|

- 在骑士与流氓谜题中,给出了以下信息:每个角色要么是骑士,要么是流氓。骑士总是会说实话:如果骑士陈述了一句话,那么这句话就是真的。相反,流氓总是说谎:如果流氓陈述了一个句子,那么这个句子就是假的。

|

||||||

@@ -21,15 +22,15 @@

|

|||||||

- 从逻辑上讲,我们可以推断,如果 A 是骑士,那么这句话一定是真的。但我们知道这句话不可能是真的,因为 A 不可能既是骑士又是流氓——我们知道每个角色要么是骑士,要么是流氓,不会出现是流氓的骑士或是骑士的流氓。所以,我们可以得出结论,A 一定是流氓。

|

- 从逻辑上讲,我们可以推断,如果 A 是骑士,那么这句话一定是真的。但我们知道这句话不可能是真的,因为 A 不可能既是骑士又是流氓——我们知道每个角色要么是骑士,要么是流氓,不会出现是流氓的骑士或是骑士的流氓。所以,我们可以得出结论,A 一定是流氓。

|

||||||

- 那个谜题比较简单。随着更多的字符和更多的句子,谜题可以变得更加棘手!你在这个问题中的任务是确定如何使用命题逻辑来表示这些谜题,这样一个运行模型检查算法的人工智能可以为我们解决这些谜题。

|

- 那个谜题比较简单。随着更多的字符和更多的句子,谜题可以变得更加棘手!你在这个问题中的任务是确定如何使用命题逻辑来表示这些谜题,这样一个运行模型检查算法的人工智能可以为我们解决这些谜题。

|

||||||

|

|

||||||

## 理解

|

### 理解

|

||||||

|

|

||||||

- 看一下 `logic.py`,你可能还记得讲义的内容。无需了解此文件中的所有内容,但请注意,此文件为不同类型的逻辑连接词定义了多个类。这些类可以相互组合,所以表达式 `And(Not(A), Or(B, C))` 代表逻辑语句:命题 A 是不正确的,同时,命题 B 或者命题 C 是正确的。(这里的“或”是同或,不是异或)

|

- 看一下 `logic.py`,你可能还记得讲义的内容。无需了解此文件中的所有内容,但请注意,此文件为不同类型的逻辑连接词定义了多个类。这些类可以相互组合,所以表达式 `And(Not(A), Or(B, C))` 代表逻辑语句:命题 A 是不正确的,同时,命题 B 或者命题 C 是正确的。(这里的“或”是同或,不是异或)

|

||||||

- 回想一下 `logic.py`,它还包含一个 函数 `model_check` 。`model_check` 输入知识库和查询结论。知识库是一个逻辑命题:如果知道多个逻辑语句,则可以将它们连接在一个表达式中。 递归考虑所有可能的模型,如果知识库推理蕴含查询结论,则返回 `True`,否则返回 `False`。

|

- 回想一下 `logic.py`,它还包含一个 函数 `model_check` 。`model_check` 输入知识库和查询结论。知识库是一个逻辑命题:如果知道多个逻辑语句,则可以将它们连接在一个表达式中。递归考虑所有可能的模型,如果知识库推理蕴含查询结论,则返回 `True`,否则返回 `False`。

|

||||||

- 现在,看看 `puzzle.py`,在顶部,我们定义了六个命题符号。例如,`AKnight` 表示“A 是骑士”的命题,`AKnave` 而表示“A 是流氓”的句子。我们也为字符 B 和 C 定义了类似的命题符号。

|

- 现在,看看 `puzzle.py`,在顶部,我们定义了六个命题符号。例如,`AKnight` 表示“A 是骑士”的命题,`AKnave` 而表示“A 是流氓”的句子。我们也为字符 B 和 C 定义了类似的命题符号。

|

||||||

- 接下来是四个不同的知识库 `knowledge0`, `knowledge1`, `knowledge2`, and `knowledge3`,它们将分别包含推断即将到来的谜题 0、1、2 和 3 的解决方案所需的知识。请注意,目前,这些知识库中的每一个都是空的。这就是你进来的地方!

|

- 接下来是四个不同的知识库 `knowledge0`, `knowledge1`, `knowledge2`, and `knowledge3`,它们将分别包含推断即将到来的谜题 0、1、2 和 3 的解决方案所需的知识。请注意,目前,这些知识库中的每一个都是空的。这就是你进来的地方!

|

||||||

- 这个 `puzzle.py` 的 `main` 函数在所有谜题上循环,并使用模型检查来计算,给定谜题的知识,无论每个角色是骑士还是无赖,打印出模型检查算法能够得出的任何结论。

|

- 这个 `puzzle.py` 的 `main` 函数在所有谜题上循环,并使用模型检查来计算,给定谜题的知识,无论每个角色是骑士还是无赖,打印出模型检查算法能够得出的任何结论。

|

||||||

|

|

||||||

## 明确

|

### 明确

|

||||||

|

|

||||||

- 将知识添加到知识库 `knowledge0`, `knowledge1`, `knowledge2`, 和 `knowledge3` 中,以解决以下难题。

|

- 将知识添加到知识库 `knowledge0`, `knowledge1`, `knowledge2`, 和 `knowledge3` 中,以解决以下难题。

|

||||||

|

|

||||||

@@ -62,7 +63,7 @@ C 说:“A 是骑士。”

|

|||||||

- 上述每个谜题中,每个角色要么是骑士,要么是流氓。骑士说的每一句话都是真的,流氓说的每一句话都是假的。

|

- 上述每个谜题中,每个角色要么是骑士,要么是流氓。骑士说的每一句话都是真的,流氓说的每一句话都是假的。

|

||||||

- 一旦你完成了一个问题的知识库,你应该能够运行 `python puzzle.py` 来查看谜题的解决方案。

|

- 一旦你完成了一个问题的知识库,你应该能够运行 `python puzzle.py` 来查看谜题的解决方案。

|

||||||

|

|

||||||

## 提示

|

### 提示

|

||||||

|

|

||||||