chore: turn cos to cdn

This commit is contained in:

@@ -219,13 +219,13 @@ ICL(In-Context Learning,上下文学习)和 COT(Chain of Thought,思

|

||||

|

||||

虽然学界对此没有太大的共识,但其原理无非在于给予 LLMs 更翔实的上下文,让输出与输入有着更紧密的关联与惯性。(从某种意义上来说,也可以将其认为是一种图灵机式的编程)

|

||||

|

||||

> ICL:<br/>

|

||||

> ICL:<br/>

|

||||

|

||||

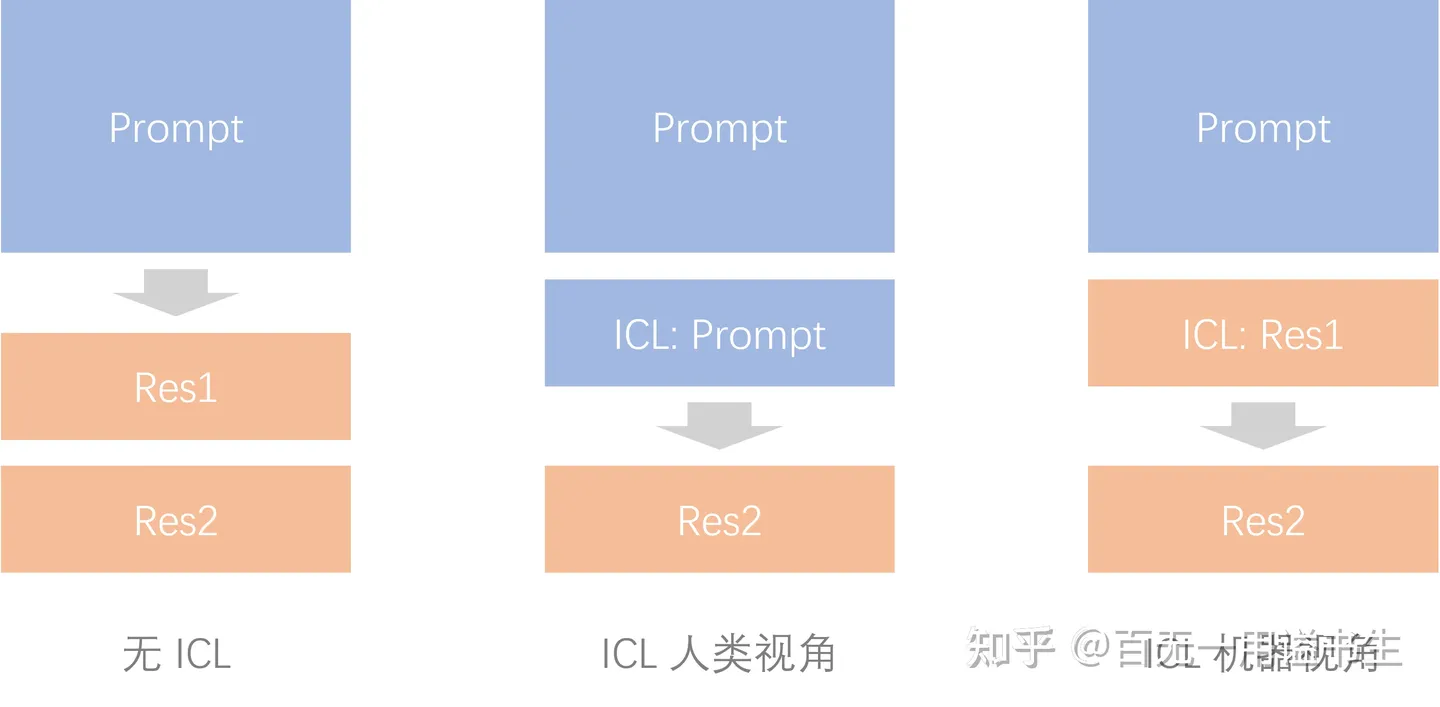

ICL 为输出增加惯性

|

||||

|

||||

> 可以简单认为,通过 ICL Prompt,能强化人类输入到机器输出的连贯性,借以提升输出的确定性。<br/>在经过“回答”的 finetune 之前,大模型的原始能力就是基于给定文本进行接龙,而 ICL 的引入则在“回答”这一前提条件下,降低了机器开始接龙这一步骤中的语义跨度,从而使得输出更加可控。<br/>

|

||||

|

||||

COT:<br/>

|

||||

COT:<br/>

|

||||

|

||||

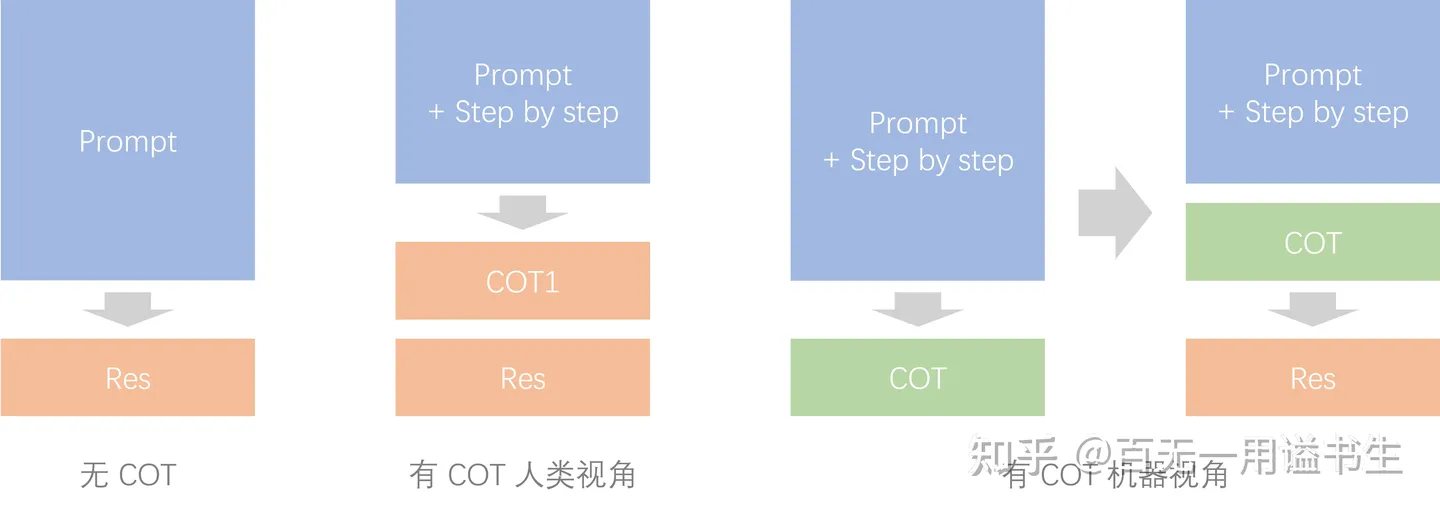

COT 为输出增加关联

|

||||

|

||||

@@ -240,7 +240,7 @@ COT 为输出增加关联

|

||||

|

||||

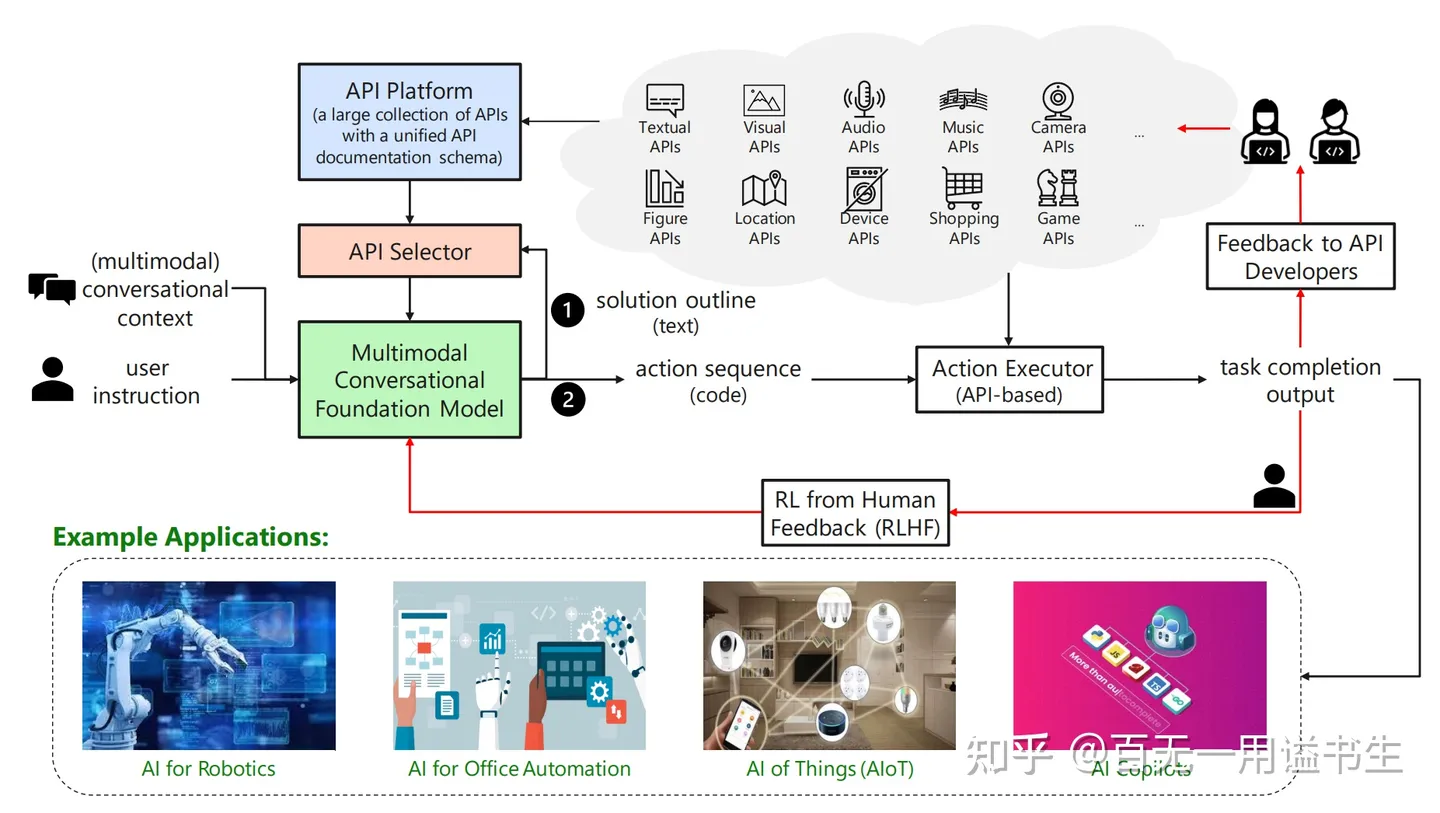

(需要注意的是,TaskMatrix.AI 更大程度上是一个愿景向的调研案例,尚未正式落地生态)

|

||||

|

||||

|

||||

|

||||

|

||||

TaskMatrix 的生态愿景

|

||||

|

||||

@@ -275,7 +275,7 @@ TaskMatrix 的生态愿景

|

||||

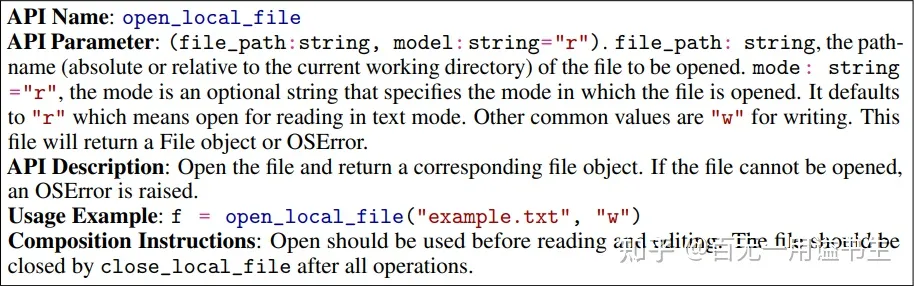

- Usage Example:API 的调用方法样例

|

||||

- Composition Instruction:API 的使用贴士,如应该与其它什么 API 组合使用,是否需要手动释放等

|

||||

|

||||

> 样例:打开文件 API<br/>

|

||||

> 样例:打开文件 API<br/>

|

||||

|

||||

基于此类文档内容和 ICL 的能力,LLMs 能从输入中习得调用 API 的方法,依此快速拓展了其横向能力

|

||||

|

||||

@@ -287,11 +287,11 @@ COT for TaskMatrix

|

||||

|

||||

在 TaskMatirx 中,通过该模式,让 MCFM 将任务转化为待办大纲,并最终围绕大纲检索并组合 API,完成整体工作

|

||||

|

||||

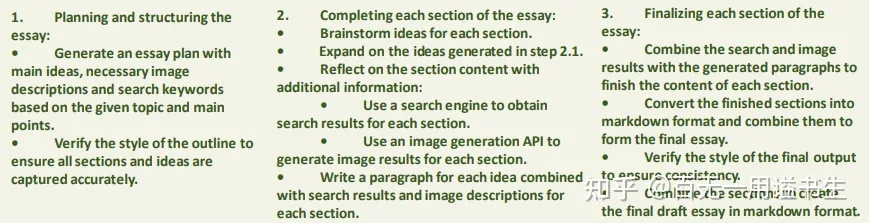

> 样例:写论文<br/>构建完成工作大纲<br/>

|

||||

> 样例:写论文<br/>构建完成工作大纲<br/>

|

||||

|

||||

TaskMatrix 自动围绕目标拆解任务

|

||||

|

||||

> 自动调用插件和组件<br/>

|

||||

> 自动调用插件和组件<br/>

|

||||

|

||||

TaskMatrix 自动为任务创建 API 调用链

|

||||

|

||||

@@ -313,7 +313,7 @@ TaskMatrix 自动为任务创建 API 调用链

|

||||

|

||||

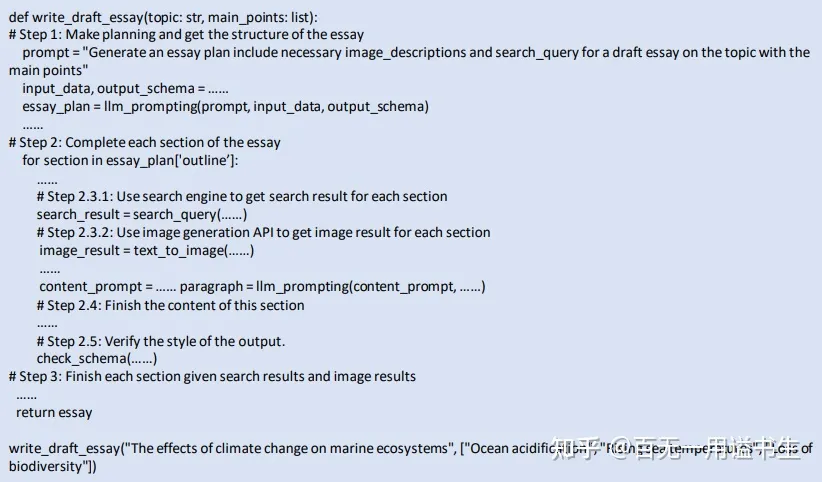

Decomp 的核心思想为将复杂问题通过 Prompt 技巧,将一个复杂的问题由 LLMs 自主划分为多个子任务。随后,我们通过 LLMs 完成多个任务,并将过程信息最终组合并输出理想的效果

|

||||

|

||||

|

||||

|

||||

|

||||

几种 Prompt 方法图示

|

||||

|

||||

@@ -321,7 +321,7 @@ Decomp 的核心思想为将复杂问题通过 Prompt 技巧,将一个复杂

|

||||

|

||||

而对于 Decomp 过程,则又是由一个原始的 Decomp Prompt 驱动

|

||||

|

||||

|

||||

|

||||

|

||||

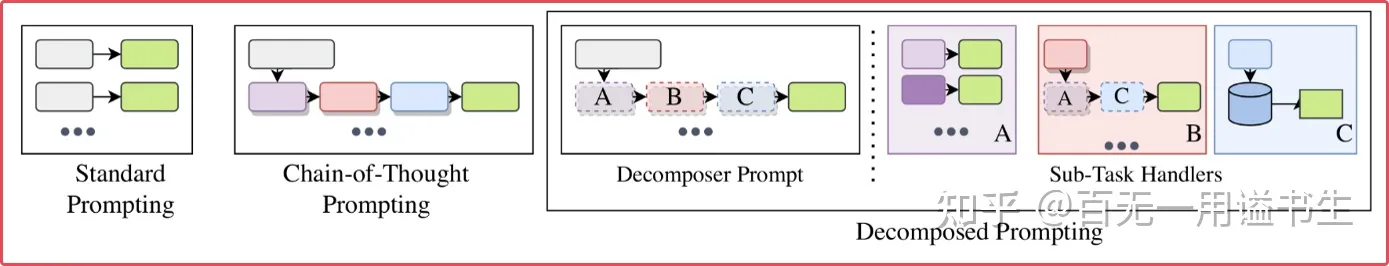

Decomp 方法执行样例

|

||||

|

||||

@@ -347,7 +347,7 @@ Decomp 的原始功能实际上并不值得太过关注,但我们急需考虑

|

||||

|

||||

通过问题的分解和通过“专用函数”的执行,我们可以轻易让 LLMs 实现自身无法做到的调用 API 工作,例如主动从外部检索获取回答问题所需要的知识。

|

||||

|

||||

|

||||

|

||||

|

||||

Decomp 方法调用外部接口样例

|

||||

|

||||

@@ -359,7 +359,7 @@ Decomp 方法调用外部接口样例

|

||||

|

||||

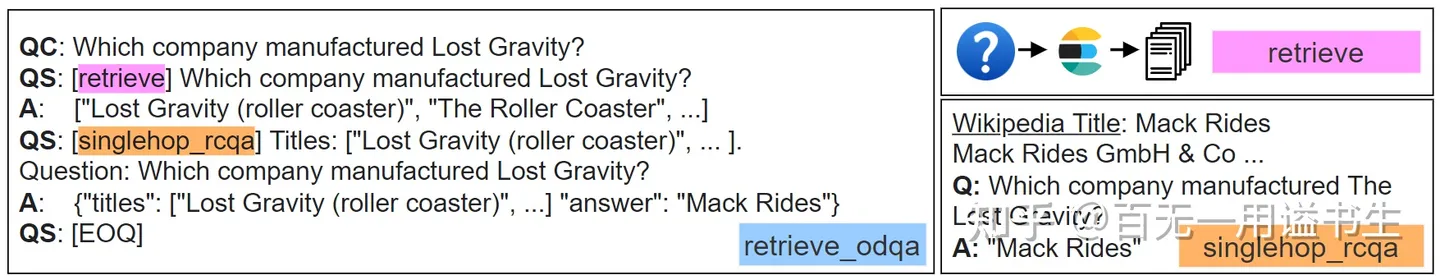

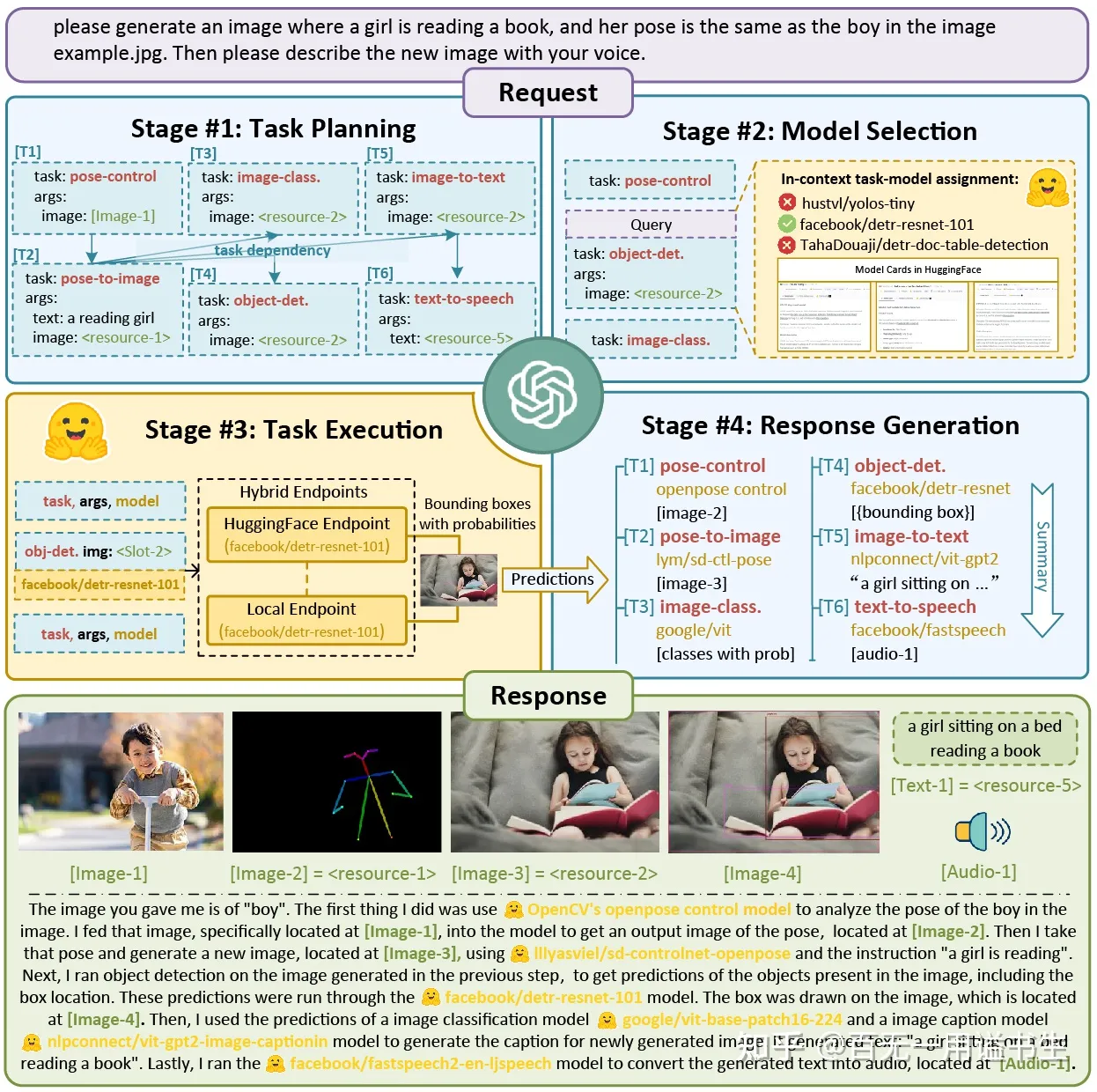

[HuggingGPT](https://arxiv.org/abs/2303.17580) 一文也许并未直接参考 Decomp 方法,而是用一些更规范的手法完成该任务,但其充分流水线化的 Prompt 工程无疑是 Decomp 方法在落地实践上的最佳注脚

|

||||

|

||||

|

||||

|

||||

|

||||

HuggingGPT

|

||||

|

||||

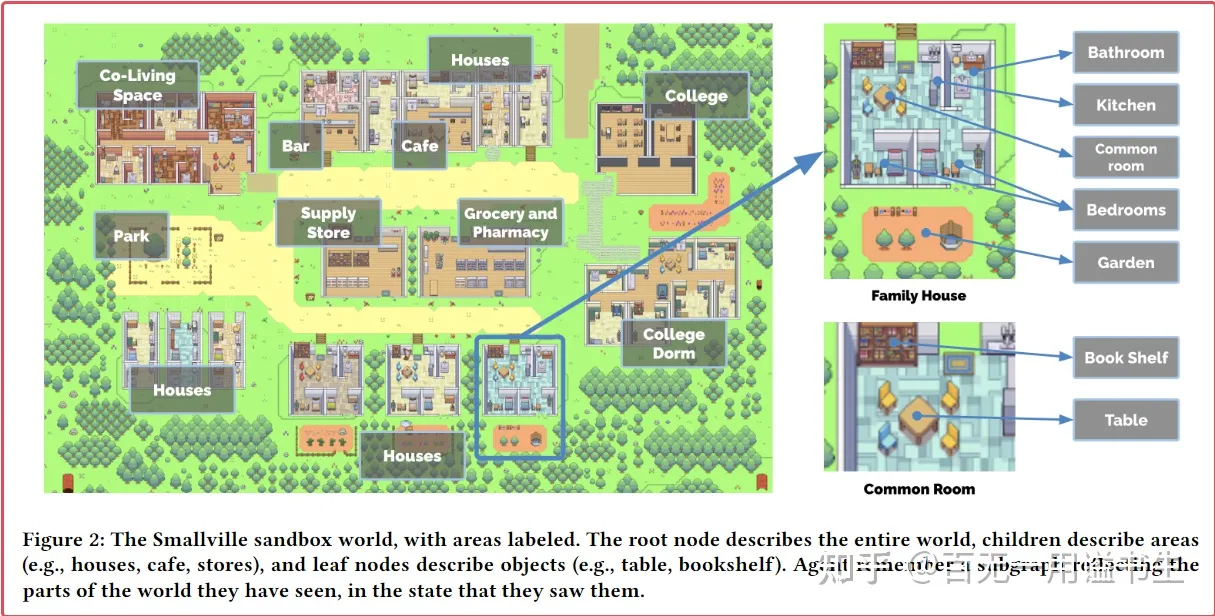

@@ -407,7 +407,7 @@ Generative Agents 构建了一套框架,让 NPC 可以感知被模块化的世

|

||||

|

||||

- 一方面,其包含场景中既有对象,包括建筑和摆件等的基础层级信息

|

||||

|

||||

|

||||

|

||||

|

||||

Generative Agents 的场景信息管理

|

||||

|

||||

@@ -635,7 +635,7 @@ AutoGPT 主要特性如下:

|

||||

|

||||

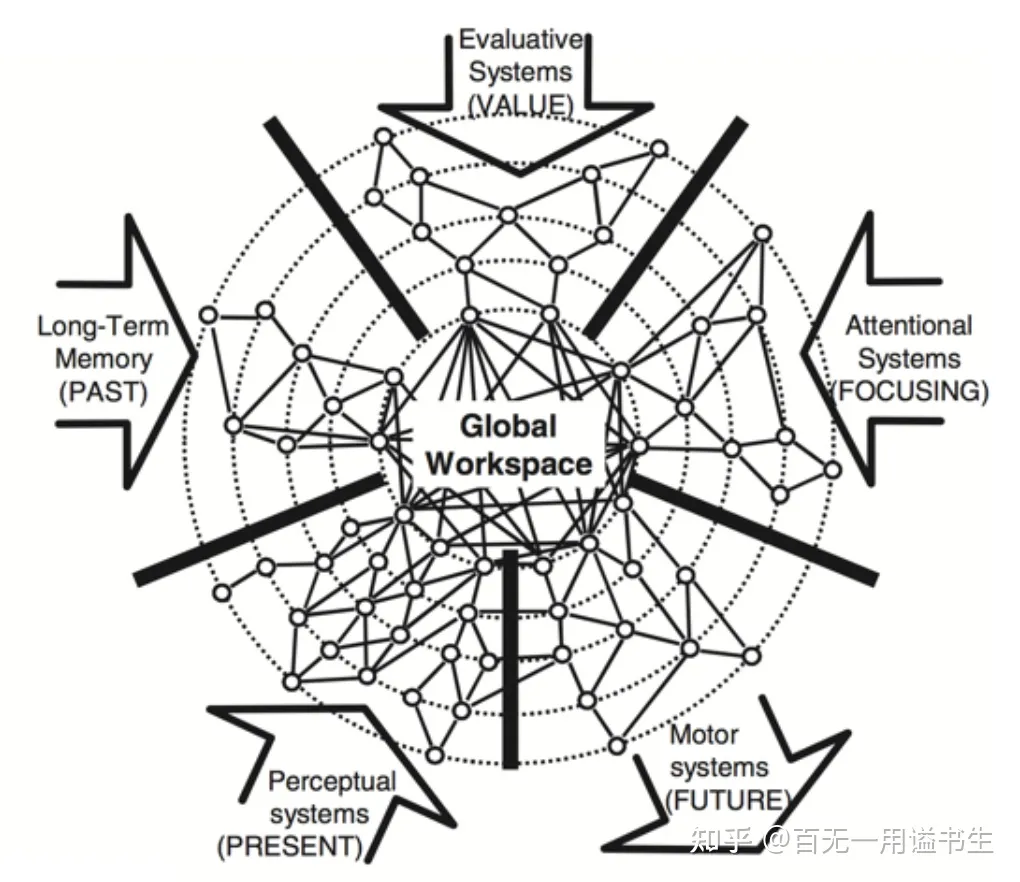

其提醒我们,就连我们的意识主体性,也只是陈述自我的一个表述器而已。我们是否应当反思对语言能力的过度迷信,从而相信我们能通过训练模型构建 All in One 的智能实体?

|

||||

|

||||

|

||||

|

||||

|

||||

全局工作空间理论

|

||||

|

||||

@@ -905,7 +905,7 @@ AutoGPT 的核心记忆设计依赖于预包装的 Prompt 本体,这一包装

|

||||

|

||||

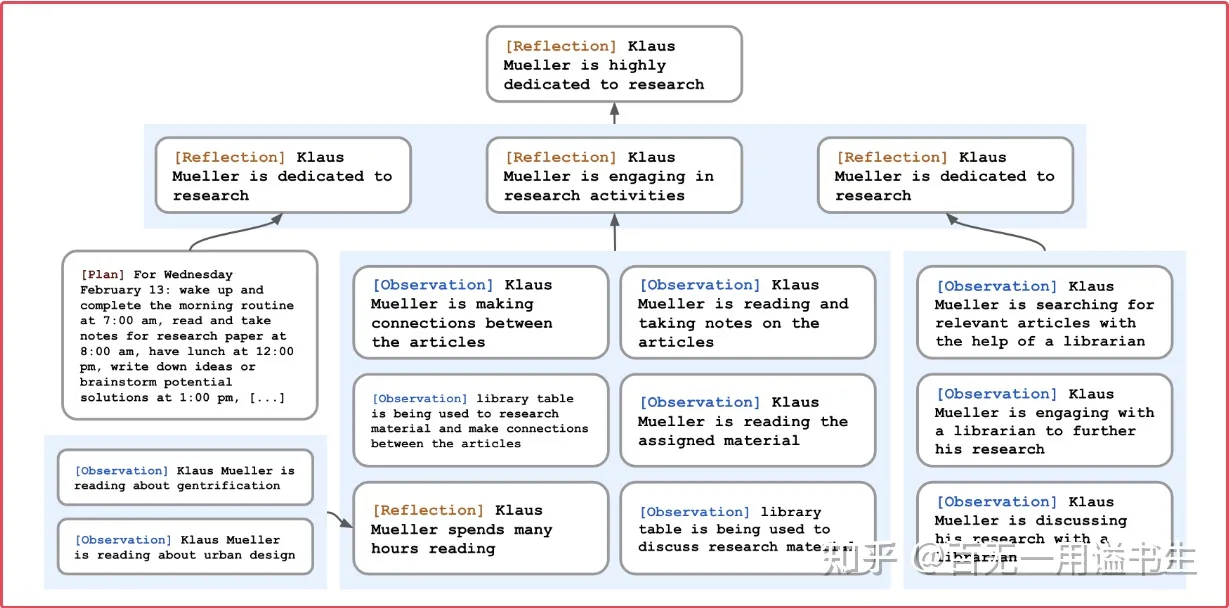

Generative Agent 通过自动化评估记忆的价值,并构建遗忘系统、关注系统等用于精准从自己繁杂的记忆中检索对于当前情景有用的信息。

|

||||

|

||||

|

||||

|

||||

|

||||

Generative Agents :基于 Reflection 构建记忆金字塔

|

||||

|

||||

|

||||

Reference in New Issue

Block a user